RDD的缓存

RDD的缓存/持久化

缓存解决的问题

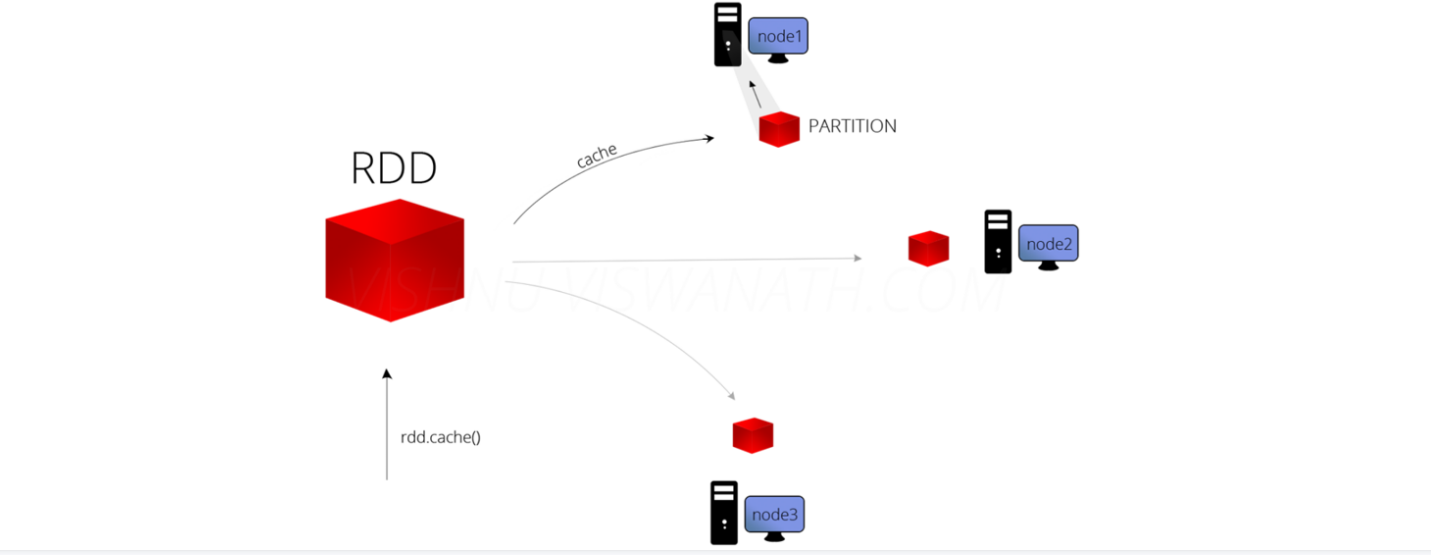

缓存解决什么问题?-解决的是热点数据频繁访问的效率问题

在Spark开发中某些RDD的计算或转换可能会比较耗费时间,

如果这些RDD后续还会频繁的被使用到,那么可以将这些RDD进行持久化/缓存,

这样下次再使用到的时候就不用再重新计算了,提高了程序运行的效率。

import org.apache.spark.rdd.RDD

import org.apache.spark.storage.StorageLevel

import org.apache.spark.{SparkConf, SparkContext}

object Demo16Cache {

def main(args: Array[String]): Unit = {

val conf: SparkConf = new SparkConf().setAppName("****").setMaster("local")

val sc: SparkContext = new SparkContext(conf)

val linesRDD: RDD[String] = sc.textFile("spark/data/words.txt")

//加入缓存的三种方式

//方式一

linesRDD.cache()//将常用的RDD放入缓存中,增加效率

//StorageLevel.MEMORY_ONLY 默认只放在缓存中

//方式二

//linesRDD.persist()

//def persist(): this.type = persist(StorageLevel.MEMORY_ONLY)

//指定缓存存储方式

linesRDD.persist(StorageLevel.MEMORY_AND_DISK)

/**

* 缓存的存储方式:推荐使用MEMORY_AND_DISK

* object StorageLevel {

* val NONE = new StorageLevel(false, false, false, false)

* val DISK_ONLY = new StorageLevel(true, false, false, false)

* val DISK_ONLY_2 = new StorageLevel(true, false, false, false, 2)

* val MEMORY_ONLY = new StorageLevel(false, true, false, true)

* val MEMORY_ONLY_2 = new StorageLevel(false, true, false, true, 2)

* val MEMORY_ONLY_SER = new StorageLevel(false, true, false, false)

* val MEMORY_ONLY_SER_2 = new StorageLevel(false, true, false, false, 2)

* val MEMORY_AND_DISK = new StorageLevel(true, true, false, true)

* val MEMORY_AND_DISK_2 = new StorageLevel(true, true, false, true, 2)

* val MEMORY_AND_DISK_SER = new StorageLevel(true, true, false, false)

* val MEMORY_AND_DISK_SER_2 = new StorageLevel(true, true, false, false, 2)

* val OFF_HEAP = new StorageLevel(true, true, true, false, 1)

*/

linesRDD.flatMap(word => word)

.groupBy(word => word)

.map(l => {

val word = l._1

val cnt = l._2.size

word + "," + cnt

}).foreach(println)

val wordRDD: Unit = linesRDD.map(word => word)

.foreach(println)

//释放缓存

linesRDD.unpersist()

}

}

RDD中的checkpoint

RDD数据可以持久化到内存中,虽然是快速的,但是不可靠

也可以把数据放在磁盘上,也并不是完全可靠的,

我们可以把缓存数据放到我的HDFS中,借助HDFS的高可靠,高可用以及高容错来保证数据安全

import org.apache.spark.{SparkConf, SparkContext}

import org.apache.spark.rdd.RDD

import org.apache.spark.storage.StorageLevel

object Demo17CheckPoint {

def main(args: Array[String]): Unit = {

val conf: SparkConf = new SparkConf().setAppName("spark").setMaster("local")

val sc: SparkContext = new SparkContext(conf)

val linesRDD: RDD[String] = sc.textFile("spark/data/words.txt")

/**

* RDD数据可以持久化到内存中,虽然是快速的,但是不可靠

* 也可以把数据放在磁盘上,也并不是完全可靠的

* 我们可以把缓存数据放到我的HDFS中,借助HDFS的高可靠,高可用以及高容错来保证数据安全

*

*/

//设置HDFS的目录

sc.setCheckpointDir("spark/data/checkPoint")

//对需要缓存的RDD进行checkPoint

linesRDD.checkpoint()

linesRDD.flatMap(word => word)

.groupBy(word => word)

.map(l => {

val word = l._1

val cnt = l._2.size

word + "," + cnt

}).foreach(println)

val wordRDD: Unit = linesRDD.map(word => word)

.foreach(println)

}

}

RDD的缓存的更多相关文章

- Spark RDD概念学习系列之RDD的缓存(八)

RDD的缓存 RDD的缓存和RDD的checkpoint的区别 缓存是在计算结束后,直接将计算结果通过用户定义的存储级别(存储级别定义了缓存存储的介质,现在支持内存.本地文件系统和Tachyon) ...

- sparkRDD:第4节 RDD的依赖关系;第5节 RDD的缓存机制;第6节 DAG的生成

4. RDD的依赖关系 6.1 RDD的依赖 RDD和它依赖的父RDD的关系有两种不同的类型,即窄依赖(narrow dependency)和宽依赖(wide dependency ...

- RDD(八)——缓存与检查点

RDD通过persist方法或cache方法可以将前面的计算结果缓存,默认情况下 persist() 会把数据以序列化的形式缓存在 JVM 的堆空间中. 但是并不是这两个方法被调用时立即缓存,而是触发 ...

- Spark核心RDD、什么是RDD、RDD的属性、创建RDD、RDD的依赖以及缓存、

1:什么是Spark的RDD??? RDD(Resilient Distributed Dataset)叫做弹性分布式数据集,是Spark中最基本的数据抽象,它代表一个不可变.可分区.里面的元素可并行 ...

- RDD缓存

RDD的缓存 Spark速度非常快的原因之一,就是在不同操作中可以在内存中持久化或缓存数据集.当持久化某个RDD后,每一个节点都将把计算的分片结果保存在内存中,并在对此RDD或衍生出的RDD进行的其他 ...

- Spark RDD详解 | RDD特性、lineage、缓存、checkpoint、依赖关系

RDD(Resilient Distributed Datasets)弹性的分布式数据集,又称Spark core,它代表一个只读的.不可变.可分区,里面的元素可分布式并行计算的数据集. RDD是一个 ...

- RDD:基于内存的集群计算容错抽象(转)

原文:http://shiyanjun.cn/archives/744.html 该论文来自Berkeley实验室,英文标题为:Resilient Distributed Datasets: A Fa ...

- Spark RDD Operations(2)

处理数据类型为Value型的Transformation算子可以根据RDD变换算子的输入分区与输出分区关系分为以下几种类型. 1)输入分区与输出分区一对一型. 2)输入分区与输出分区多对一型. 3)输 ...

- Spark RDD概念学习系列之RDD的checkpoint(九)

RDD的检查点 首先,要清楚.为什么spark要引入检查点机制?引入RDD的检查点? 答:如果缓存丢失了,则需要重新计算.如果计算特别复杂或者计算耗时特别多,那么缓存丢失对于整个Job的影响是不容 ...

随机推荐

- P4783-[模板]矩阵求逆

正题 题目链接:https://www.luogu.com.cn/problem/P4783 题目大意 给出一个矩阵,求它的逆矩阵. \(1\leq n\leq 400\) 解题思路 记给出矩阵\(P ...

- P6134-[JSOI2015]最小表示【bitset,拓扑排序】

正题 题目链接:https://www.luogu.com.cn/problem/P6134 题目大意 给出一张\(n\)个点\(m\)条边的\(DAG\).求联通情况不变的情况下最多删除几条边. \ ...

- mysql从零开始之MySQL 管理

MySQL 管理 启动及关闭 MySQL 服务器 Windows 系统下 在 Windows 系统下,打开命令窗口(cmd),进入 MySQL 安装目录的 bin 目录. 启动: cd c:/mysq ...

- asp.net core使用identity+jwt保护你的webapi(二)——获取jwt token

前言 上一篇已经介绍了identity在web api中的基本配置,本篇来完成用户的注册,登录,获取jwt token. 开始 开始之前先配置一下jwt相关服务. 配置JWT 首先NuGet安装包: ...

- 技术番外篇丨Github Action CI/CD

起源 看到.Net群里再聊CI/CD,我就这里分享一下我目前自己一些小东西的做法,我目前在Github有一个自己私有的组织,里面存放了我的部分商业化项目,早期我采用Jenkins用Webhooks进行 ...

- 如何在前端通过JavaScript创建修改CAD图形

背景 在之前的博文CAD图DWG解析WebGIS可视化技术分析总结.CAD_DWG图Web可视化一站式解决方案-唯杰地图-vjmap中讲解了如何把CAD的DWG格式的图纸Web可视化的方案,那在Web ...

- DPARAM

中M_电子科技大学_计算机组成原理 双端口RAM Dual Port Access RAM 存储器不断接受CPU访问,还要频繁地和I/O设备通信.如果只有一套MAR,ID,MDR和读写电路.任一时刻只 ...

- NOIP模拟80

学考+OJ改名祭 T1 邻面合并 解题思路 状压 DP ...(于是贪心竟然有 60pts 的高分?? code) 状态设计的就非常妙了,如果状态是 1 就表示是一个分割点也就是一个矩形的右边界. 那 ...

- Golang通脉之指针

指针的概念 指针是存储另一个变量的内存地址的变量. 变量是一种使用方便的占位符,用于引用计算机内存地址. 一个指针变量可以指向任何一个值的内存地址. 在上面的图中,变量b的值为156,存储在内存地址0 ...

- 天脉2(ACoreOS653)操作系统学习01

天脉2(ACoreOS653)操作系统学习01 由于我的毕业设计涉及相关嵌入式操作系统,故最近学了学天脉2操作系统. 一.ARINC653标准 1.ARINC653标准是什么? ARINC 653 : ...