python之Beautiful Soup库

1、简介

简单来说,Beautiful Soup是python的一个库,最主要的功能是从网页抓取数据。官方解释如下:

Beautiful Soup提供一些简单的、python式的函数用来处理导航、搜索、修改分析树等功能。它是一个工具箱,通过解析文档为用户提供需要抓取的数据,因为简单,所以不需要多少代码就可以写出一个完整的应用程序。

Beautiful Soup自动将输入文档转换为Unicode编码,输出文档转换为utf-8编码。你不需要考虑编码方式,除非文档没有指定一个编码方式,这时,Beautiful Soup就不能自动识别编码方式了。然后,你仅仅需要说明一下原始编码方式就可以了。

Beautiful Soup已成为和lxml、html6lib一样出色的python解释器,为用户灵活地提供不同的解析策略或强劲的速度。

2、环境安装

Beautiful Soup 3 目前已经停止开发,推荐在现在的项目中使用Beautiful Soup 4,不过它已经被移植到BS4了,也就是说导入时我们需要 from bs4 import BeautifulSoup 。所以这里我们用的版本是 Beautiful Soup 4.3.2 (简称BS4)。

1、快速安装

|

1

|

pip install beautifulsoup4 |

2、如果想安装最新的版本,请直接下载安装包来手动安装,也是十分方便的方法

1、Beautiful Soup3.2.1

https://pypi.python.org/pypi/BeautifulSoup/3.2.1

2、Beautiful Soup4.3.2

https://pypi.python.org/pypi/beautifulsoup4/

下载完成之后解压

运行下面的命令即可完成安装

python setup.py install

3、然后需要安装 lxml

pip install lxml

另一个可供选择的解析器是纯Python实现的 html5lib , html5lib的解析方式与浏览器相同,可以选择下列方法来安装html5lib:

pip install html5lib

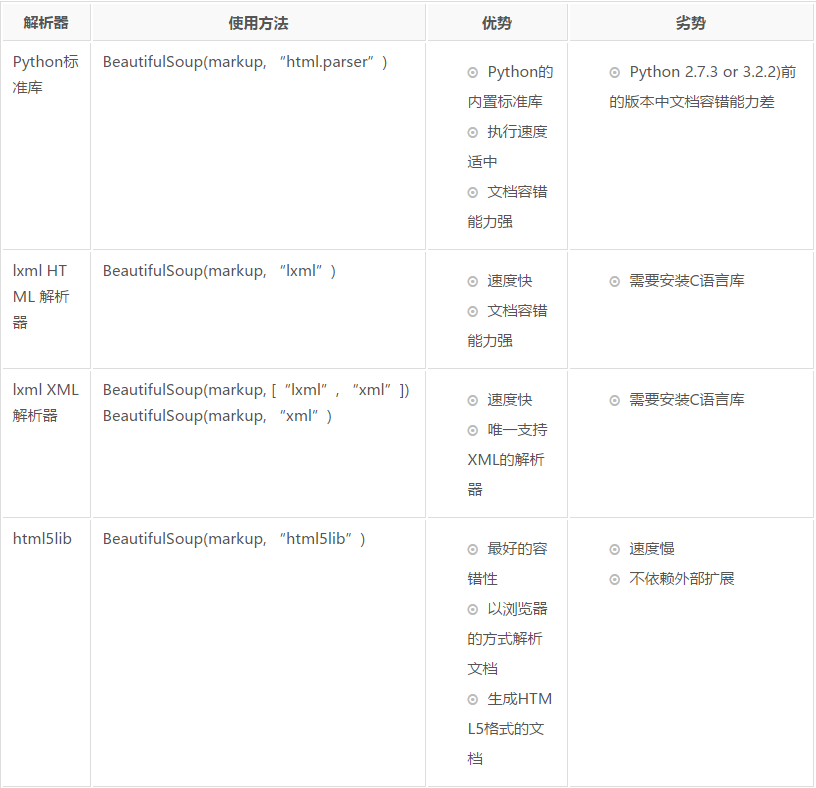

Beautiful Soup支持Python标准库中的HTML解析器,还支持一些第三方的解析器,如果我们不安装它,则 Python 会使用 Python默认的解析器,lxml 解析器更加强大,速度更快,推荐安装。

3. 使用方法

最佳方法参考官方文档:https://www.crummy.com/software/BeautifulSoup/bs4/doc.zh/

以下内容测试css和xpath分别提取文本和属性的区别,方便后续查看

from scrapy.selector import Selector

from scrapy.http import HtmlResponse

from bs4 import BeautifulSoup as bs body = '''<html>

<head>

<base href='http://example.com/' />

<title id="txt">Example website</title>

</head>

<body>

<div id='images'>

<a href='image1.html'>Name: My image <br /><img src='image1_thumb.jpg' /></a>

<a href='image2.html'>Name: My image <br /><img src='image2_thumb.jpg' /></a>

<a href='image3.html'>Name: My image <br /><img src='image3_thumb.jpg' /></a>

<a href='image4.html'>Name: My image <br /><img src='image4_thumb.jpg' /></a>

<a href='image5.html'>Name: My image <br /><img src='image5_thumb.jpg' /></a>"div text"</div>

<div>helloworld test</div>

</body>

</html>'''

soup = bs(body, "lxml")

print("css获取属性:",soup.select("div")[].attrs["id"])

print("xpath获取属性:",Selector(text=body).xpath("//div/@id").extract()[]) print("css获取文本:", soup.select("title[id='txt']")[].string)

print("xpath获取文本:",Selector(text=body).xpath("//title[@id='txt']/text()").extract()[])

python之Beautiful Soup库的更多相关文章

- Python Beautiful Soup库

Beautiful Soup库 Beautiful Soup库:https://www.crummy.com/software/BeautifulSoup/ 安装Beautiful Soup: 使用B ...

- Beautiful Soup库基础用法(爬虫)

初识Beautiful Soup 官方文档:https://www.crummy.com/software/BeautifulSoup/bs4/doc/# 中文文档:https://www.crumm ...

- 【转载】Beautiful Soup库(bs4)入门

转载自:Beautiful Soup库(bs4)入门 该库能够解析HTML和XML 使用Beautiful Soup库: from bs4 import BeautifulSoup impo ...

- Beautiful Soup库入门

1.安装:pip install beautifulsoup4 Beautiful Soup库是解析.遍历.维护“标签树”的功能库 2.引用:(1)from bs4 import BeautifulS ...

- python beautiful soup库的超详细用法

原文地址https://blog.csdn.net/love666666shen/article/details/77512353 参考文章https://cuiqingcai.com/1319.ht ...

- 【Python爬虫学习笔记(3)】Beautiful Soup库相关知识点总结

1. Beautiful Soup简介 Beautiful Soup是将数据从HTML和XML文件中解析出来的一个python库,它能够提供一种符合习惯的方法去遍历搜索和修改解析树,这将大大减 ...

- crawler碎碎念4 关于python requests、Beautiful Soup库、SQLlite的基本操作

Requests import requests from PIL import Image from io improt BytesTO import jason url = "..... ...

- Python之Beautiful Soup的用法

1. Beautiful Soup的简介 简单来说,Beautiful Soup是python的一个库,最主要的功能是从网页抓取数据.官方解释如下: Beautiful Soup提供一些简单的.pyt ...

- Python的Beautiful Soup简单使用

Beautiful Soup是python的一个库,最主要的功能是从网页抓取数据 Beautiful Soup提供一些简单的.python式的函数用来处理导航.搜索.修改分析树等功能 它是一个工具箱, ...

随机推荐

- sql中null 和 ‘’(空字符串)

sql 中 null 和 空字符串的区别方式 在Silverlight中 数据库 需要与实体类进行映射, 假如实体类不允许为null,则 select '' as 列名 from 表名字: ...

- Linux系统crontab定时调度Python脚本

Linux系统crontab定时调度Python脚本 一.Python脚本随Linux开机自动运行 #Python脚本:/home/edgar/auto.py #用root权限编辑以下文件:/etc/ ...

- Ubuntu系统Anaconda下载安装与切换源教程【转】

本文转载自:https://blog.csdn.net/qq_36268036/article/details/81517893 1. 下载安装: 这里选用国内清华大学的Tuna开源软件镜像站作为演示 ...

- SpringBoot 通用Error设计

在项目中需要设计统一的错误消息,通常使用枚举类定义"错误码"与"错误消息": 并且也可以做错误消息自定义. 定义通过错误接口类:CommonError publ ...

- 智能DNS

DNS查找下一个服务的地址 一.智能DNS APP通过域名访问DNS服务器,DNS根据域名对应一组IP中随机选择一个,发给APP.从这个意义说智能DNS,智能DNS相当一个七层的负载均衡. 二.H ...

- mysql分库分表(一)

mysql分库分表 参考: https://blog.csdn.net/xlgen157387/article/details/53976153 https://blog.csdn.net/cleve ...

- 并发-HashMap和HashTable源码分析

HashMap和HashTable源码分析 参考: https://blog.csdn.net/luanlouis/article/details/41576373 http://www.cnblog ...

- IE10下阿里旺旺无法快速登录解决办法

一直都是用Chrome浏览器的,如果已经登录了旺旺,打开淘宝登录的时候都是会有快速登录的,免得手工输入用户名密码了.不经意间用IE10打开淘宝,登录时发现无法使用快速登录,一番研究后发现,IE做了保护 ...

- Android中获取并设置屏幕亮度

最近在做一个Demo的时候用到了调节屏幕亮度的功能,于是上网搜索了一下,并且写了一个小Demo测试了一下,发现代码还是比较简单的.Android中的亮度调节,主要有三个方向,一个是针对于系统的亮度调节 ...

- Linux 查看进程基本命令

https://www.cnblogs.com/zwgblog/p/5971455.html https://www.cnblogs.com/lcword/p/6046261.html https:/ ...