Hadoop学习历程(三、第一个程序)

根据之前的操作,我们已经可以正常的启动Hadoop了,关于真正的集群我会在之后进行说明。现在我们来看一下第一个程序吧

1. 在eclipse上建立一个java项目

2. 将 /usr/hadoop/share/hadoop/common/hadoop-common-2.2.0.jar 文件导入到项目中

3. 将 /usr/hadoop/share/hadoop/common/lib/commons-logging-1.1.1.jar 文件导入到项目中

4. 编写代码如下

import java.io.IOException; import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FSDataOutputStream;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path; public class DFSOperator { /**

* @param args

*/

public static void main(String[] args) {

Configuration conf = new Configuration();

try {

FileSystem fs = FileSystem.get(conf);

Path f = new Path("hdfs:///dfs_operator.txt");

FSDataOutputStream s = fs.create(f, true);

int i = 0;

for (i = 0; i < 100000; ++i)

s.writeChars("test");

s.close();

} catch (IOException e) {

e.printStackTrace();

}

}

}

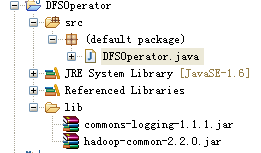

5. 项目抓图

6. 将项目导出成为Jar包 dfsOperator.jar ,可以在如下地址下载

http://pan.baidu.com/share/link?shareid=3076182544&uk=2517512140

7. 将Jar包传输到Linux系统中,然后使用如下方法执行

7.1 查看是否存在dfs_operator.txt文件,如果存在需要先删除掉

hadoop fs -ls /

注明:如果要删除文件可以用如下命令 hadoop fs -rm /dfs_operator.txt

7.2 运行命令生成dfs_operator.txt文件

hadoop jar dfsOperator.jar DFSOperator

7.3 运行7.1的命令查看运行效果,如果增加了dfs_operator.txt文件,证明运行成功

Hadoop学习历程(三、第一个程序)的更多相关文章

- [Hadoop] Hadoop学习历程 [持续更新中…]

1. Hadoop FS Shell Hadoop之所以可以实现分布式计算,主要的原因之一是因为其背后的分布式文件系统(HDFS).所以,对于Hadoop的文件操作需要有一套全新的shell指令来完成 ...

- OpenGL学习笔记1——第一个程序

学习的参考书基本是按照GL编程指南,如果有消息机制概念,对于GLUT的理解是很自然的.下面就按照自己写的第一个程序详细解释一下GL,还是比较容易上手的. 程序实现的功能是,根据当前随即种子摇出来的结果 ...

- hadoop学习第三天-MapReduce介绍&&WordCount示例&&倒排索引示例

一.MapReduce介绍 (最好以下面的两个示例来理解原理) 1. MapReduce的基本思想 Map-reduce的思想就是“分而治之” Map Mapper负责“分”,即把复杂的任务分解为若干 ...

- 汇编学习(三)——汇编语言程序入门

一.寻址方式 1.概念: 一条指令由操作码和操作数构成,操作码是系统定义好的符号,执行指定的操作,操作数即是指令的对象,而寻址方式就是操作数的指定方式 操作码 目的操作数,源操作数 2.寻址方式的三种 ...

- Hadoop学习之第一个MapReduce程序

期望 通过这个mapreduce程序了解mapreduce程序执行的流程,着重从程序解执行的打印信息中提炼出有用信息. 执行前 程序代码 程序代码基本上是<hadoop权威指南>上原封不动 ...

- DirectX11 学习笔记1 - 第一个程序

为了加快学习速度,和使程序更加easy理解. 我把sampler tutorial里面的一个样例 的固定代码和常常修改的代码经过简单的类的封装了一下. 以后学习的时候就能够仅仅在还有一个文件写ren ...

- Hadoop学习笔记2 - 第一和第二个Map Reduce程序

转载请标注原链接http://www.cnblogs.com/xczyd/p/8608906.html 在Hdfs学习笔记1 - 使用Java API访问远程hdfs集群中,我们已经可以完成了访问hd ...

- Hadoop学习历程(四、运行一个真正的MapReduce程序)

上次的程序只是操作文件系统,本次运行一个真正的MapReduce程序. 运行的是官方提供的例子程序wordcount,这个例子类似其他程序的hello world. 1. 首先确认启动的正常:运行 s ...

- (转载)OC学习篇之---第一个程序HelloWorld

之前的一片文章简单的介绍了OC的相关概述,从这篇开始我们就开始学习OC的相关知识了,在学习之前,个人感觉需要了解的其他的两门语言:一个是C/C++,一个是面向对象的语言(当然C++就是面向对象,不过这 ...

随机推荐

- SwitchySharp怎样设置 ( proxy switch!的设置与使用方法)

规则列表URL https://autoproxy-G{过}F{滤}Wlist.googlecode.com/svn/trunk/G{过}F{滤}Wlist.txt 注:不同的代{过}{滤}理 相 ...

- C51汇编语言完整源码

单片机最小系统,两位LED数码管由串口输出接两个164驱动,Lout,Rout为左右声道输出,SET, ALT0, ALT1为三个按键,也可自己在开始的I/O定义改成你想用的I/O口:12M晶振,若 ...

- Qt on Android

Qt on Android Episode 7(翻译) http://blog.csdn.net/foruok/article/details/46323129 Android基础整理之四大组件Act ...

- Android 解决listview中checkBox错位选择

假如ListView,分成2页(或者设置数据可以纵向拉,可隐藏),每页3条数据,每个Listview的Item 里面有个checkBox,现在,当我选择第一页的前两天数据,翻到第二页,竟然第二页后两条 ...

- jquery easyui tree绑定静态数据的方法

若是动态,返回的是json格式,这个比较常见,就不列举说明了,如果要绑定的数据为静态,很简单,只需将ajax的url改为data 如 //鼠标单击树事件 $("#tree").tr ...

- 黑马程序员_Java集合Map

Map Map概述: 接口Map<k,v> 类型参数: k-此映射所维护的键的类型 v-映射值的类型 Map集合:该集合存储键值对.一对一对往理存.而且要保证键的唯一性. 嵌套类摘要: s ...

- QML设计登陆界面

QML设计登陆界面 本文博客链接:http://blog.csdn.net/jdh99,作者:jdh,转载请注明. 环境: 主机:WIN7 开发环境:Qt5.2 说明: 用QML设计一个应用的登陆界面 ...

- Android学习之多点触摸并不神秘

最近研究了一下多点触摸,写了个利用多点触摸来控制图片大小和单点触摸控制图片移动的程序,和大家分享分享. Android中监听触摸事件是onTouchEvent方法,它的参数为MotionEvent,下 ...

- Java JDBC连接SQL Server2005错误:通过port 1433 连接到主机 localhost 的 TCP/IP 连接失败

错误原因例如以下: Exception in thread "main" org.hibernate.exception.JDBCConnectionException: Cann ...

- Netmon: A light-weight network monitor for Windows

Netmon is a light-weight network monitor that works on Windows operating systems. It provides differ ...