通过java api统计hive库下的所有表的文件个数、文件大小

更新hadoop fs 命令实现:

[ss@db csv]$ hadoop fs -count /my_rc/my_hive_db/*

18/01/14 15:40:19 INFO hdfs.PeerCache: SocketCache disabled.

3 2 0 /my_rc/my_hive_db/.hive-staging_hive_2017-08-19_16-52-39_153_7217997288202811839-170149

2 0 0 /my_rc/my_hive_db/.hive-staging_hive_2018-01-03_15-23-10_240_5147839610865108930-52517

1 0 0 /my_rc/my_hive_db/BusinessGtUser

4 1 321008 /my_rc/my_hive_db/ZJ2_SenseSta

1 1 143 /my_rc/my_hive_db/anthgain

1 1 27228 /my_rc/my_hive_db/anthgainpoint

1 1 70 /my_rc/my_hive_db/antvgain

1 1 27429 /my_rc/my_hive_db/antvgainpoint

通过hadoop fs -du 或者 hadoop fs -count只能统计指定的某个hdfs路径(hive表目录)的总文件个数及文件的大小,但是通过hadoop命令没有办法实现批量处理hive中多个表一次进行统计,如果一次性统计多个hive表目录的文件个数、文件总大小只能通过java程序使用hadoop api实现。

package com.my.hdfsopt; import java.io.FileNotFoundException;

import java.io.IOException; import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileStatus;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path; public class HdfsPathMonitor {

// submit shell

/*

* main类的路径不需要指定,否则会被认为是参数传递进入。

* yarn jar /app/m_user1/service/Hangzhou_HdfsFileMananger.jar /hive_tenant_account/hivedbname/

*/

public static void main(String[] args) throws Exception {

System.out.println("the args is " + String.join(",", args));

String dirPath = args[0]; Configuration conf = new Configuration();

/*

* <property> <name>fs.defaultFS</name> <value>hdfs://mycluster</value>

* </property>

*/

conf.set("fs.defaultFS", "hdfs://mycluster"); FileSystem fileSystem = FileSystem.get(conf);

Path path = new Path(dirPath); // 获取文件列表

FileStatus[] files = fileSystem.listStatus(path);

if (files == null || files.length == 0) {

throw new FileNotFoundException("Cannot access " + dirPath + ": No such file or directory.");

} System.out.println("dirpath \t total file size \t total file count");

for (int i = 0; i < files.length; i++) {

String pathStr = files[i].getPath().toString(); FileSystem fs = files[i].getPath().getFileSystem(conf);

long totalSize = fs.getContentSummary(files[i].getPath()).getLength();

long totalFileCount = listAll(conf, files[i].getPath());

fs.close(); System.out.println(("".equals(pathStr) ? "." : pathStr) + "\t" + totalSize + "\t" + totalFileCount);

}

} /**

* @Title: listAll @Description: 列出目录下所有文件 @return void 返回类型 @throws

*/

public static Long listAll(Configuration conf, Path path) throws IOException {

long totalFileCount = 0;

FileSystem fs = FileSystem.get(conf); if (fs.exists(path)) {

FileStatus[] stats = fs.listStatus(path);

for (int i = 0; i < stats.length; ++i) {

if (!stats[i].isDir()) {

// regular file

// System.out.println(stats[i].getPath().toString());

totalFileCount++;

} else {

// dir

// System.out.println(stats[i].getPath().toString());

totalFileCount += listAll(conf, stats[i].getPath());

}

}

}

fs.close(); return totalFileCount;

} }

执行命令:

yarn jar /app/m_user1/tommyduan_service/Hangzhou_HdfsFileMananger.jar /hive_tenant_account/hivedbname/

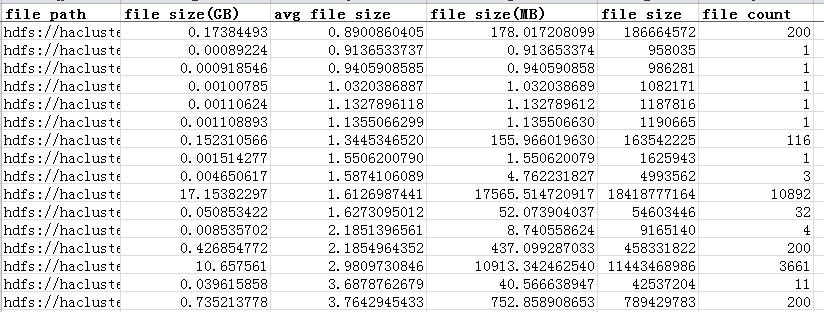

执行结果:

通过java api统计hive库下的所有表的文件个数、文件大小的更多相关文章

- mysql下批量清空某个库下的所有表(库不要删除,保留空库)

总所周知,mysql下要想删除某个库下的某张表,只需要切换到该库下,执行语句"drop table tablename"即可删除!但若是该库下有成百上千张表,要是再这样一次次执行d ...

- mysql5.7 mysql库下面的user表没有password字段无法修改密码

如题所述,mysql5.7 mysql库下面的user表没有password字段无法修改密码, 5.7版本已经不再使用password来作为密码的字段了 而改成了authentication_st ...

- Java API操作HA方式下的Hadoop

通过java api连接Hadoop集群时,如果集群支持HA方式,那么可以通过如下方式设置来自动切换到活动的master节点上.其中,ClusterName 是可以任意指定的,跟集群配置无关,dfs. ...

- MySQL数据库中统计一个库中的所有表的行数?

今天公司两个远端的数据库主从同步有点问题,查看下wordpress库下所有表的表的条目? mysql> use information_schema;Database changedmysql& ...

- Centos下查看当前目录大小及文件个数

查看目录及其包含的文件的大小 du -ch directory 查看当前目录下文件的个数 ls -l | grep "^-" | wc -l 查看当前目录下以.jpg为后缀文件的个 ...

- 统计hive库表在具体下所有分区大小

1 查询具体表分区大小,以字节展示 hadoop fs -du /user/hive/warehouse/treasury.db/dm_user_excercise > dm_user_exce ...

- 使用hive客户端java api读写hive集群上的信息

上文介绍了hdfs集群信息的读取方式,本文说hive 1.先解决依赖 <properties> <hive.version>1.2.1</hive.version> ...

- Spark:java api读取hdfs目录下多个文件

需求: 由于一个大文件,在spark中加载性能比较差.于是把一个大文件拆分为多个小文件后上传到hdfs,然而在spark2.2下如何加载某个目录下多个文件呢? public class SparkJo ...

- windows上使用metastore client java api链接hive metastore问题

https://github.com/sdravida/hadoop2.6_Win_x64 下载winutils.exe 添加到path中

随机推荐

- 金三银四跳槽季,BAT美团滴滴java面试大纲(带答案版)之一:Java基础篇

Java基础篇: 题记:本系列文章,会尽量模拟面试现场对话情景, 用口语而非书面语 ,采用问答形式来展现.另外每一个问题都附上“延伸”,这部分内容是帮助小伙伴们更深的理解一些底层细节的补充,在面试中可 ...

- Java 容器 接口

Java 中容器框架的内容可以分为三层: 接口(模型), 模板和具体实现. 在开发中使用容器正常的流程是,首先根据需求确定使用何种容器模型,然后选择一个符合性能要求的容器实现类或者自己实现一个容器类. ...

- iOS App 启动性能优化

1. App启动过程 解析Info.plist 加载相关信息,例如如闪屏 沙箱建立.权限检查 Mach-O加载 如果是胖二进制文件,寻找合适当前CPU类别的部分 加载所有依赖的Mach-O文件(递归调 ...

- php中require、require_once、include、include_once类库重复引入效率问题详解

首先我详细说下这四个引入函数 include() 与require() 的功能相同 唯一不同:require()不管是否被执行,只要存在,php在执行前都会预引入,include()则是执行到该语句时 ...

- C语言第一次博客作业—输入输出

一.PTA实验作业 题目1:7-3 温度转换 本题要求编写程序,计算华氏温度150°F对应的摄氏温度.计算公式:C=5×(F−32)/9,式中:C表示摄氏温度,F表示华氏温度,输出数据要求为整型. 1 ...

- 20155303 2016-2017-2 《Java程序设计》第二周学习总结

20155303 2016-2017-2 <Java程序设计>第二周学习总结 教材学习内容总结 『注意』 "//"为单行批注符: "/*"与&quo ...

- JAVA面向对象的多态性

什么是多态?简而言之就是相同的行为,不同的实现. 而多态也分为静态多态(重载).动态多态(重写)和动态绑定. 静态动态,实际就是指的重载的概念,是系统在编译时,就能知晓该具体调用哪个方法.动态多态指在 ...

- iOS中CocoaPods的安装及错误详解

什么是CocoaPods CocoaPods是OS X和iOS下的一个第三类库管理工具,通过CocoaPods工具我们可以为项目添加被称为"Pods"的依赖库(这些类库必须是Coc ...

- 【iOS】Swift GCD-上

尽管Grand Central Dispatch(GCD)已经存在一段时间了,但并非每个人都知道怎么使用它.这是情有可原的,因为并发很棘手,而且GCD本身基于C的API在Swift世界中很刺眼. 在这 ...

- JAVA中if多分支和switch的优劣性。

Switch多分支语句switch语句是多分支选择语句.常用来根据表达式的值选择要执行的语句.例如,在某程序中,要求将输入的或是获取的用0-6代表的星期,转换为用中文表示的星期.该需求通过伪代码描述的 ...