Spark SQL1.2测试

Spark SQL 1.2

运行原理

case class方式

json文件方式

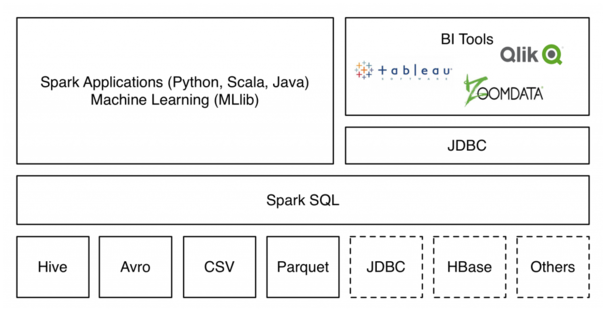

背景:了解到HDP也能够支持Spark SQL,但官方文档是版本1.2,希望支持传统数据库、hadoop平台、文本格式的整合处理

虚线表示还未实现。支持从现有Apache Hive表以及流行的Parquet列式存储格式中读取数据,数据源API通过Spark SQL提供了访问结构化数据的可插拔机制(接口需要自己实现,后面附有)。数据源 API可以作为Spark平台的统一数据接入。数据源API的另外一个优点就是不管数据的来源如何,用户都能够通过Spark支持的所有语言来操作这些数据,很容易的使用单一接口访问不同数据源的数据。访问Spark Packages 来获取最新的可用库列表。

以下从Spark SQL1.1初始版本来理解其运行原理。

SparkSQL引入了一种新的RDD——SchemaRDD,SchemaRDD由行对象(row)以及描述行对象中每列数据类型的schema组成;SchemaRDD很象传统数据库中的表。SchemaRDD可以通过RDD、Parquet文件、JSON文件、或者通过使用hiveql查询hive数据来建立。SchemaRDD除了可以和RDD一样操作外,还可以通过registerTempTable注册成临时表,然后通过SQL语句进行操作。

- Spark1.1在hiveContext中,hql()将被弃用,sql()将代替hql()来提交查询语句,统一了接口。

- 使用registerTempTable注册表是一个临时表,生命周期只在所定义的sqlContext或hiveContext实例之中。换而言之,在一个sqlontext(或hiveContext)中registerTempTable的表不能在另一个sqlContext(或hiveContext)中使用。

- spark1.1提供了两种语法解析器:sql语法解析器和hiveql语法解析器。

- hiveContext现在支持sql语法解析器和hivesql语法解析器,默认为hivesql语法解析器,用户可以通过配置切换成sql语法解析器,来运行hiveql不支持的语法,如select 1。

- sqlContext基础应用

- RDD

- parquet文件

- json文件

- hiveContext基础应用

- 混合使用

- 缓存之使用

- DSL之使用

下面介绍几种导入的方式:

创建RDD的形式,测试txt文本

spark://master:7077

路径为hdfs上的相对路径。

./bin/spark-shell

scala> val sqlContext = new org.apache.spark.sql.SQLContext(sc)

sqlContext: org.apache.spark.sql.SQLContext = org.apache.spark.sql.SQLContext@2013f094 scala> import sqlContext.createSchemaRDD

import sqlContext.createSchemaRDD scala> case class Person(name: String, age: Int)

defined class Person scala> val people = sc.textFile("/user/p.txt").map(_.split(",")).map(p => Person(p(0), p(1).trim.toInt))

15/05/05 06:30:35 INFO storage.MemoryStore: ensureFreeSpace(190122) called with curMem=0, maxMem=278302556

15/05/05 06:30:35 INFO storage.MemoryStore: Block broadcast_0 stored as values in memory (estimated size 185.7 KB, free 265.2 MB)

15/05/05 06:30:35 INFO storage.MemoryStore: ensureFreeSpace(29581) called with curMem=190122, maxMem=278302556

15/05/05 06:30:35 INFO storage.MemoryStore: Block broadcast_0_piece0 stored as bytes in memory (estimated size 28.9 KB, free 265.2 MB)

15/05/05 06:30:35 INFO storage.BlockManagerInfo: Added broadcast_0_piece0 in memory on localhost:59627 (size: 28.9 KB, free: 265.4 MB)

15/05/05 06:30:35 INFO storage.BlockManagerMaster: Updated info of block broadcast_0_piece0

15/05/05 06:30:35 INFO spark.DefaultExecutionContext: Created broadcast 0 from textFile at <console>:17

people: org.apache.spark.rdd.RDD[Person] = MappedRDD[3] at map at <console>:17 scala> people.registerTempTable("people") scala> val teenagers = sqlContext.sql("SELECT name FROM people WHERE age >= 3 AN

D age <= 19")

teenagers: org.apache.spark.sql.SchemaRDD =

SchemaRDD[6] at RDD at SchemaRDD.scala:108

== Query Plan ==

== Physical Plan ==

Project [name#0]

Filter ((age#1 >= 3) && (age#1 <= 19))

PhysicalRDD [name#0,age#1], MapPartitionsRDD[4] at mapPartitions at ExistingRDD.scala:36 scala> teenagers.map(t => "Name: " + t(0)).collect().foreach(println)

15/05/05 06:31:18 WARN shortcircuit.DomainSocketFactory: The short-circuit local reads feature cannot be used because libhadoop cannot be loaded.

15/05/05 06:31:18 INFO mapred.FileInputFormat: Total input paths to process : 1

15/05/05 06:31:18 INFO spark.DefaultExecutionContext: Starting job: collect at <console>:18

15/05/05 06:31:18 INFO scheduler.DAGScheduler: Got job 0 (collect at <console>:18) with 2 output partitions (allowLocal=false)

15/05/05 06:31:18 INFO scheduler.DAGScheduler: Final stage: Stage 0(collect at <console>:18)

15/05/05 06:31:18 INFO scheduler.DAGScheduler: Parents of final stage: List()

15/05/05 06:31:18 INFO scheduler.DAGScheduler: Missing parents: List()

15/05/05 06:31:18 INFO scheduler.DAGScheduler: Submitting Stage 0 (MappedRDD[7] at map at <console>:18), which has no missing parents

15/05/05 06:31:18 INFO storage.MemoryStore: ensureFreeSpace(6400) called with curMem=219703, maxMem=278302556

15/05/05 06:31:18 INFO storage.MemoryStore: Block broadcast_1 stored as values in memory (estimated size 6.3 KB, free 265.2 MB)

15/05/05 06:31:18 INFO storage.MemoryStore: ensureFreeSpace(4278) called with curMem=226103, maxMem=278302556

15/05/05 06:31:18 INFO storage.MemoryStore: Block broadcast_1_piece0 stored as bytes in memory (estimated size 4.2 KB, free 265.2 MB)

15/05/05 06:31:18 INFO storage.BlockManagerInfo: Added broadcast_1_piece0 in memory on localhost:59627 (size: 4.2 KB, free: 265.4 MB)

15/05/05 06:31:18 INFO storage.BlockManagerMaster: Updated info of block broadcast_1_piece0

15/05/05 06:31:18 INFO spark.DefaultExecutionContext: Created broadcast 1 from broadcast at DAGScheduler.scala:838

15/05/05 06:31:18 INFO scheduler.DAGScheduler: Submitting 2 missing tasks from Stage 0 (MappedRDD[7] at map at <console>:18)

15/05/05 06:31:18 INFO scheduler.TaskSchedulerImpl: Adding task set 0.0 with 2 tasks

15/05/05 06:31:18 INFO scheduler.TaskSetManager: Starting task 0.0 in stage 0.0 (TID 0, localhost, ANY, 1293 bytes)

15/05/05 06:31:18 INFO scheduler.TaskSetManager: Starting task 1.0 in stage 0.0 (TID 1, localhost, ANY, 1293 bytes)

15/05/05 06:31:18 INFO executor.Executor: Running task 1.0 in stage 0.0 (TID 1)

15/05/05 06:31:18 INFO executor.Executor: Running task 0.0 in stage 0.0 (TID 0)

15/05/05 06:31:18 INFO rdd.HadoopRDD: Input split: hdfs://master:8020/user/p.txt:15+15

15/05/05 06:31:18 INFO rdd.HadoopRDD: Input split: hdfs://master:8020/user/p.txt:0+15

15/05/05 06:31:19 INFO executor.Executor: Finished task 0.0 in stage 0.0 (TID 0). 1755 bytes result sent to driver

15/05/05 06:31:19 INFO executor.Executor: Finished task 1.0 in stage 0.0 (TID 1). 1733 bytes result sent to driver

15/05/05 06:31:19 INFO scheduler.TaskSetManager: Finished task 1.0 in stage 0.0 (TID 1) in 750 ms on localhost (1/2)

15/05/05 06:31:19 INFO scheduler.DAGScheduler: Stage 0 (collect at <console>:18) finished in 0.782 s

15/05/05 06:31:19 INFO scheduler.TaskSetManager: Finished task 0.0 in stage 0.0 (TID 0) in 772 ms on localhost (2/2)

15/05/05 06:31:19 INFO scheduler.TaskSchedulerImpl: Removed TaskSet 0.0, whose tasks have all completed, from pool

15/05/05 06:31:19 INFO scheduler.DAGScheduler: Job 0 finished: collect at <console>:18, took 0.860763 s

Name: kang

Name: wu

Name: liu

Name: zhang

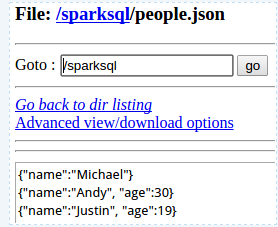

2. json文件方式

sqlContext可以从jsonFile或jsonRDD获取schema信息,来构建SchemaRDD,注册成表后就可以使用。这里又更详细的例子

官网上文档

val sc: SparkContext // An existing SparkContext.

val sqlContext = new org.apache.spark.sql.SQLContext(sc)

val df = sqlContext.jsonFile("examples/src/main/resources/people.json")

// Displays the content of the DataFrame to stdout

df.show()

val sc: SparkContext // An existing SparkContext.

val sqlContext = new org.apache.spark.sql.SQLContext(sc) // Create the DataFrame

val df = sqlContext.jsonFile("examples/src/main/resources/people.json") // Show the content of the DataFrame

df.show()

// age name

// null Michael

// 30 Andy

// 19 Justin // Print the schema in a tree format

df.printSchema()

// root

// |-- age: long (nullable = true)

// |-- name: string (nullable = true) // Select only the "name" column

df.select("name").show()

// name

// Michael

// Andy

// Justin // Select everybody, but increment the age by 1

df.select("name", df("age") + 1).show()

// name (age + 1)

// Michael null

// Andy 31

// Justin 20 // Select people older than 21

df.filter(df("name") > 21).show()

// age name

// 30 Andy // Count people by age

df.groupBy("age").count().show()

// age count

// null 1

// 19 1

// 30 1

测试:

./spark-shell

scala>val sqlContext = new org.apache.spark.sql.SQLContext(sc)

scala>val df = sqlContext.jsonFile("/user/j.json")

scala>df.show()

scala>df.printSchema()

root

|-- age: long (nullable = true)

|-- name: string (nullable = true)

scala>df.filter(df("name") > 21).show()

scala>df.groupBy("age").count().show()

age count

null 1

19 1

30 1

---------------------------------------------华丽分割线--------------------------------------------------------------------------------------------------

继续调研测试Spark SQL对关系型数据库的支持

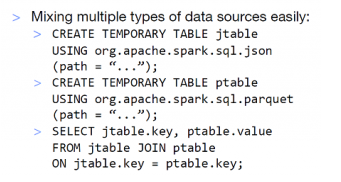

数据源API通过Spark SQL提供了访问结构化数据的可插拔机制。数据源不仅仅有了简便的途径去进行数据转换并加入到Spark 平台。

使用数据源和通过SQL访问他们一样简单(或者你喜爱的Spark语言)

CREATE TEMPORARY TABLE episodes

USING com.databricks.spark.avro

OPTIONS (path "episodes.avro")

数据源API的另外一个优点就是不管数据的来源如何,用户都能够通过Spark支持的所有语言来操作这些数据 。例如,那些用Scala实现的数据源,pySpark用户不需要其他的库开发者做任何额外的工作就可以使用。此外,Spark SQL可以很容易的使用单一接口访问不同数据源的数据。

json格式与parquet

经过调研,Spark只支持文本格式导入,如果要实现与jdbc/odbc连接关系型数据库,需要自己实现

参考:Spark SQL External Data Sources JDBC简易实现 该Github源码:https://github.com/luogankun/spark-jdbc

实现了对MySQL/Oracle/DB2的查询 支持类型string&int&long×tamp&date 还需要测试hive和hbase即可

这样可以实现基本功能,利用自己实现的连接和临时表共同查询的方式,但自己实现相对比较简单不完善。

所以还是接着看能不能HDP2.2融合Spark1.3 实在不行单独安装Spark1.3

Spark SQL1.2测试的更多相关文章

- Spark SQL1.2与HDP2.2结合

1.hbase相同的rowkey里存在多条记录问题的调研解决方案 VERSIONS => 3,Hbase version 最多插入三条记录 将一个集群hbase中表 "Vertical ...

- Spark集群测试

1. Spark Shell测试 Spark Shell是一个特别适合快速开发Spark原型程序的工具,可以帮助我们熟悉Scala语言.即使你对Scala不熟悉,仍然可以使用这一工具.Spark Sh ...

- Spark JDBC入门测试

spark jdbc分支源码下载地址 https://github.com/apache/spark/tree/branch-1.0-jdbc 编译spark jdbc ./make-distrib ...

- CDH spark 命令行测试

一. 参考 https://www.cnblogs.com/bovenson/p/5801536.html [root@node- test]# chown hdfs:hdfs /root/test/ ...

- Java生成-zipf分布的数据集(自定义倾斜度,用作spark data skew测试)

1.代码 import java.io.Serializable; import java.util.NavigableMap; import java.util.Random; import jav ...

- 大数据技术之_19_Spark学习_03_Spark SQL 应用解析 + Spark SQL 概述、解析 、数据源、实战 + 执行 Spark SQL 查询 + JDBC/ODBC 服务器

第1章 Spark SQL 概述1.1 什么是 Spark SQL1.2 RDD vs DataFrames vs DataSet1.2.1 RDD1.2.2 DataFrame1.2.3 DataS ...

- 《大数据Spark企业级实战 》

基本信息 作者: Spark亚太研究院 王家林 丛书名:决胜大数据时代Spark全系列书籍 出版社:电子工业出版社 ISBN:9787121247446 上架时间:2015-1-6 出版日期:20 ...

- Spark:Master High Availability(HA)高可用配置的2种实现

Spark Standalone集群是Master-Slaves架构的集群模式,和大部分的Master-Slaves结构集群一样,存在着Master单点故障的问题.如何解决这个单点故障的问题,Spar ...

- Spark On YARN内存分配

本文转自:http://blog.javachen.com/2015/06/09/memory-in-spark-on-yarn.html?utm_source=tuicool 此文解决了Spark ...

随机推荐

- 汉诺塔python3函数编写和过程分析

!/usr/bin/env python3 -- coding: utf-8 -- 利用递归函数计算阶乘 N! = 1 * 2 * 3 * ... * N def fact(n): if n == 1 ...

- tomcat部署最佳实践(一)

Tomcat部署最佳实践 标签: linux 笔者Q:972581034 交流群:605799367.有任何疑问可与笔者或加群交流 tomcat是玩web软件必会技能之一,今天我给大家介绍一下tomc ...

- Hyperledger Fabric Endorsement policies——背书策略

背书策略 背书策略用于指导peer如何确定交易是否得到了的认可.当一个peer接收到一个事务时,它会调用与事务的Chaincode相关联的VSCC(验证系统链代码),作为事务验证流程的一部分,以确定交 ...

- java的优势解读

1. java确定每种基本类型所占存储空间的大小.它们的大小不会像大多数语言那样随机器硬件架构的变化而变化.这种所占存储空间大小的不变性是java程序比用其他大多数语言编写的程序更具有可移植性的原因之 ...

- PHP操作Memcached的方法汇总

memcached非关系型数据库安装.php中的memcache的扩展安装.以及php中的memcached的扩展安装可以参考: http://www.cnblogs.com/phpstudy2015 ...

- css变量的用法——(--cssName)

CSS变量,又称——CSS自定义属性,现在很多CSS预处理/后处理程序已作了相关快捷的编译处理, 基本用法有哪些呢,我们先看一个简单的栗子:——要求,创建一个五个块元素居中的分栏样式,奇数和偶数同高不 ...

- Spring MVC执行的流程

1.Spring MVC应用的开发步骤 a.在web.xml文件中定义前端控制器DispatcherServlet来拦截用户请求.由于Web应用是基于请求/响应架构的应用,所以 不管哪个MVC Web ...

- ASP.NET MVC 5 ABP DataTables (一)

1)ABP DataTables 应用(一) 2) ABP DataTables 应用(二) JS DataTables 这个组件绑定数据必须要有自己的返回数据格式.但是ABP返回的格式直接绑定是错 ...

- WebStorm11

1.下载补丁 1.下载地址:http://pan.baidu.com/s/1gdnrdWv 2.拷贝下载的文件 JetbrainsCrack.jar 到 /bin目录下(是指你的软件安装根目录) 2. ...

- POJ置换群入门[3/3]

POJ 3270 Cow Sorting 题意: 一个序列变为升序,操作为交换两个元素,代价为两元素之和,求最小代价 题解: 看了黑书... 首先循环因子分解 一个循环完成的最小代价要么是循环中最小元 ...