Python爬取某网站文档数据完整教程(附源码)

基本开发环境 (https://jq.qq.com/?_wv=1027&k=NofUEYzs)

- Python 3.6

- Pycharm

相关模块的使用 (https://jq.qq.com/?_wv=1027&k=NofUEYzs)

import os

import requests

import time

import re

import json

from docx import Document

from docx.shared import Cm

安装Python并添加到环境变量,pip安装需要的相关模块即可。

目标网页分析 (https://jq.qq.com/?_wv=1027&k=NofUEYzs)

网站的文档内容,都是以图片形式存在的。它有自己的数据接口

接口链接:

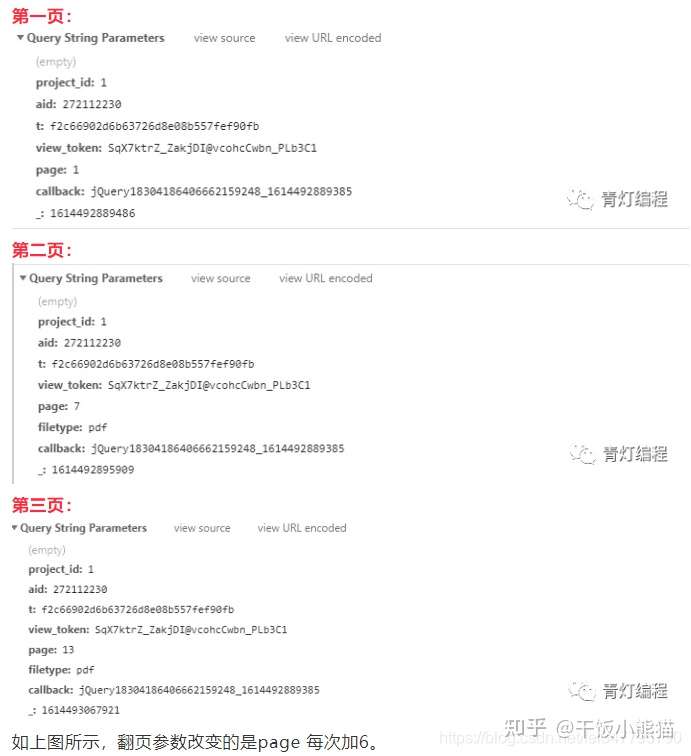

https://openapi.book118.com/getPreview.html?&project_id=1&aid=272112230&t=f2c66902d6b63726d8e08b557fef90fb&view_token=SqX7ktrZ_ZakjDI@vcohcCwbn_PLb3C1&page=1&callback=jQuery18304186406662159248_1614492889385&_=1614492889486接口的请求参数

整体思路 (https://jq.qq.com/?_wv=1027&k=NofUEYzs)

- 请求网页返回response数据(字符串)

- 通过re模块匹配提取中间的数据(列表)索引取0(字符串)

- 通过json模块是把提取出来的数据转换成json模块

- 通过遍历获取每张图片的url地址

- 保存图片到本地文件夹

- 把图片保存到word文档

- 爬虫代码实现

爬虫代码实现 (https://jq.qq.com/?_wv=1027&k=NofUEYzs)

def download():

content = 0

for page in range(1, 96, 6):

# 给定 2秒延时

time.sleep(2)

# 获取时间戳

now_time = int(time.time() * 1000)

url = 'https://openapi.book118.com/getPreview.html'

# 请求参数

params = {

'project_id': '1',

'aid': '272112230',

't': 'f2c66902d6b63726d8e08b557fef90fb',

'view_token': 'SqX7ktrZ_ZakjDI@vcohcCwbn_PLb3C1',

'page': f'{page}',

'_': now_time,

}

# 请求头

headers = {

'Host': 'openapi.book118.com',

'Referer': 'Python程序设计试题库(95页)-原创力文档',

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/81.0.4044.138 Safari/537.36'

}

response = requests.get(url=url, params=params, headers=headers)

# 使用正则表达式提取内容

result = re.findall('jsonpReturn\((.*?)\)', response.text)[0]

# 字符串转json数据

json_data = json.loads(result)['data']

# 字典值的遍历

for value in json_data.values():

content += 1

# 拼接图片url

img_url = 'http:' + value

print(img_url)

headers_1 = {

'Host': '403 Forbidden',

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/81.0.4044.138 Safari/537.36'

}

# 请求图片url地址 获取content二进制数据

img_content = requests.get(url=img_url, headers=headers_1).content

# 文件名

img_name = str(content) + '.jpg'

# 保存路径

filename = 'img\\'

# 以二进制方式保存 (图片、音频、视频等文件都是以二进制的方式保存)

with open(filename + img_name, mode='wb') as f:

f.write(img_content)注意点:

1、一定要给延时,不然后面接口数据会请求不到。

2、请求图片url的时候headers参数需要写完整,否则保存图片是无法打开的

3、命名最好是给定数字,1.jpg、2.jpg 这样,方便后续保存到word

爬虫部分的代码还是比较简单的,没有什么特别的难度。

爬取这些文档,都是需要打印或者查询所以要把这些单张的图片都保存到word文档里面。

写入文档 (https://jq.qq.com/?_wv=1027&k=NofUEYzs)

def save_picture():

document = Document()

path = './img/'

lis = os.listdir(path)

c = []

for li in lis:

index = li.replace('.jpg', '')

c.append(index)

c_1 = sorted(list(map(int, c)))

print(c_1)

new_files = [(str(i) + '.jpg') for i in c_1]

for num in new_files:

img_path = path + num

document.add_picture(img_path, width=Cm(17), height=Cm(24))

document.save('tu.doc') # 保存文档

os.remove(img_path) # 删除保存在本地的图片Python爬取某网站文档数据完整教程(附源码)的更多相关文章

- Java爬虫系列之实战:爬取酷狗音乐网 TOP500 的歌曲(附源码)

在前面分享的两篇随笔中分别介绍了HttpClient和Jsoup以及简单的代码案例: Java爬虫系列二:使用HttpClient抓取页面HTML Java爬虫系列三:使用Jsoup解析HTML 今天 ...

- python3爬取墨迹天气并发送给微信好友,附源码

需求: 1. 爬取墨迹天气的信息,包括温湿度.风速.紫外线.限号情况,生活tips等信息 2. 输入需要查询的城市,自动爬取相应信息 3. 链接微信,发送给指定好友 思路比较清晰,主要分两块,一是爬虫 ...

- python爬取某个网站的图片并保存到本地

python爬取某个网站的图片并保存到本地 #coding:utf- import urllib import re import sys reload(sys) sys.setdefaultenco ...

- python 爬取天猫美的评论数据

笔者最近迷上了数据挖掘和机器学习,要做数据分析首先得有数据才行.对于我等平民来说,最廉价的获取数据的方法,应该是用爬虫在网络上爬取数据了.本文记录一下笔者爬取天猫某商品的全过程,淘宝上面的店铺也是类似 ...

- 用Python爬取斗鱼网站的一个小案例

思路解析: 1.我们需要明确爬取数据的目的:为了按热度查看主播的在线观看人数 2.浏览网页源代码,查看我们需要的数据的定位标签 3.在代码中发送一个http请求,获取到网页返回的html(需要注意的是 ...

- Python爬取招聘网站数据,给学习、求职一点参考

1.项目背景 随着科技的飞速发展,数据呈现爆发式的增长,任何人都摆脱不了与数据打交道,社会对于“数据”方面的人才需求也在不断增大.因此了解当下企业究竟需要招聘什么样的人才?需要什么样的技能?不管是对于 ...

- python爬取招聘网站数据

# -*- coding: utf-8 -*- # 爬虫分析 from bs4 import BeautifulSoup from lxml import etree from selenium im ...

- 利用Python爬取电影网站

#!/usr/bin/env python #coding = utf-8 ''' 本爬虫是用来爬取6V电影网站上的电影资源的一个小脚本程序,爬取到的电影链接会通过网页的形式显示出来 ''' impo ...

- Python爬取6271家死亡公司数据,一眼看尽十年创业公司消亡史!

小五利用python将其中的死亡公司数据爬取下来,借此来观察最近十年创业公司消亡史. 获取数据 F12,Network查看异步请求XHR,翻页. 成功找到返回json格式数据的url, 很多人 ...

随机推荐

- 2021.07.20 P3951 小凯的疑惑(最大公因数,未证)

2021.07.20 P3951 小凯的疑惑(最大公因数,未证) 重点: 1.最大公因数 题意: 求ax+by最大的表示不了的数(a,b给定 x,y非负). 分析: 不会.--2021.07.20 代 ...

- Vue3 setup详解

setup执行的时机 在beforeCreate之前执行(一次),此时组件对象还没创建: this是undefined,不能通过this来访问data/computed/methods/props: ...

- XCTF练习题---MISC---stegano

XCTF练习题---MISC---stegano flag:flag{1nv151bl3m3554g3} 解题步骤: 1.观察题目,下载附件 2.打开发现是一张PDF图片,尝试转换word无果后,想到 ...

- stm32F103RCT6使用FFT运算分析波形详解(非常新手)

最近学校电赛院队招新,出的招新题就是低频示波器的.之前一直没有弄懂FFT,借着这次机会实现了一下. FFT原理详解 FFT,就是快速傅里叶变换,这个操作能够将时域信号转化成频域信号,然后对信号进行分析 ...

- 团队Arpha3

队名:观光队 组长博客 作业博客 组员实践情况 王耀鑫 **过去两天完成了哪些任务 ** 文字/口头描述 完成服务器连接数据库部分代码 展示GitHub当日代码/文档签入记录 接下来的计划 服务器网络 ...

- jQuery前端第三方框架

计时器 <!DOCTYPE html> <html lang="en"> <head> <meta charset="UTF-8 ...

- Springcloud及Git线上配置详解

SpringCloud 这个阶段该如何学? 三层架构 + MVC 框架: Spring IOC AOP SpringBoot,新一代的JavaEE开发标准,自动装配 模块化~ all in one,代 ...

- 随笔总结:8086CPU的栈顶超界问题

我们学习编程都知道栈的超界限问题是非常严重的问题,他可能会覆盖掉其他数据,并且我们不知道这个数据是我们自己保存的用于其他用途的数据还是系统的数据,这样常常容易引发一连串的问题. 在学习汇编的时候,我们 ...

- .net 获取IP地址的几种方式

1.获取服务器IP地址: 1) Local_Addr var Local_Addr = Request.ServerVariables.Get("Local_Addr").ToSt ...

- [USACO16JAN]Angry Cows G 解题报告

一图流 参考代码: #include<bits/stdc++.h> #define ll long long #define db double #define filein(a) fre ...