kubernetes-1.18.2集群安装-02

一、基础配置

修改主机名

# 在 172.17.32.23 上:

hostnamectl set-hostname k8s-master01

bash

# 在 172.17.32.38 上:

hostnamectl set-hostname k8s-master02

bash

# 在 172.17.32.43 上:

hostnamectl set-hostname k8s-master03

bash

# 在 172.17.32.32 上:

hostnamectl set-hostname k8s-node01

bash

配置hosts解析

各个节点操作

cat <<EOF >>/etc/hosts

172.17.32.23 k8s-master01

172.17.32.38 k8s-master02

172.17.32.43 k8s-master03

172.17.32.32 k8s-node01

EOF

echo "127.0.0.1 $(hostname)" >> /etc/hosts

二、安装docker

创建文件存放目录

mkdir /application

cat /application/install-docker.sh

#!/bin/bash

# 在 master 节点和 worker 节点都要执行

# 安装 docker

# 参考文档如下

# https://docs.docker.com/install/linux/docker-ce/centos/

# https://docs.docker.com/install/linux/linux-postinstall/

# 卸载旧版本

yum remove -y docker \

docker-client \

docker-client-latest \

docker-ce-cli \

docker-common \

docker-latest \

docker-latest-logrotate \

docker-logrotate \

docker-selinux \

docker-engine-selinux \

docker-engine

# 设置 yum repository

yum install -y yum-utils \

device-mapper-persistent-data \

lvm2

yum-config-manager --add-repo http://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo

# 安装并启动 docker

yum install -y docker-ce-19.03.11 docker-ce-cli-19.03.11 containerd.io-1.2.13

mkdir /etc/docker || true

cat > /etc/docker/daemon.json <<EOF

{

"registry-mirrors": ["https://registry.cn-hangzhou.aliyuncs.com"],

"exec-opts": ["native.cgroupdriver=systemd"],

"log-driver": "json-file",

"log-opts": {

"max-size": "100m"

},

"storage-driver": "overlay2",

"storage-opts": [

"overlay2.override_kernel_check=true"

]

}

EOF

mkdir -p /etc/systemd/system/docker.service.d

# Restart Docker

systemctl daemon-reload

systemctl enable docker

systemctl restart docker

# 安装 nfs-utils

# 必须先安装 nfs-utils 才能挂载 nfs 网络存储

yum install -y nfs-utils

yum install -y wget

# 关闭 防火墙

systemctl stop firewalld

systemctl disable firewalld

# 关闭 SeLinux

setenforce 0

sed -i "s/SELINUX=enforcing/SELINUX=disabled/g" /etc/selinux/config

# 关闭 swap

swapoff -a

yes | cp /etc/fstab /etc/fstab_bak

cat /etc/fstab_bak |grep -v swap > /etc/fstab

# 修改 /etc/sysctl.conf

# 如果有配置,则修改

sed -i "s#^net.ipv4.ip_forward.*#net.ipv4.ip_forward=1#g" /etc/sysctl.conf

sed -i "s#^net.bridge.bridge-nf-call-ip6tables.*#net.bridge.bridge-nf-call-ip6tables=1#g" /etc/sysctl.conf

sed -i "s#^net.bridge.bridge-nf-call-iptables.*#net.bridge.bridge-nf-call-iptables=1#g" /etc/sysctl.conf

sed -i "s#^net.ipv6.conf.all.disable_ipv6.*#net.ipv6.conf.all.disable_ipv6=1#g" /etc/sysctl.conf

sed -i "s#^net.ipv6.conf.default.disable_ipv6.*#net.ipv6.conf.default.disable_ipv6=1#g" /etc/sysctl.conf

sed -i "s#^net.ipv6.conf.lo.disable_ipv6.*#net.ipv6.conf.lo.disable_ipv6=1#g" /etc/sysctl.conf

sed -i "s#^net.ipv6.conf.all.forwarding.*#net.ipv6.conf.all.forwarding=1#g" /etc/sysctl.conf

# 可能没有,追加

echo "net.ipv4.ip_forward = 1" >> /etc/sysctl.conf

echo "net.bridge.bridge-nf-call-ip6tables = 1" >> /etc/sysctl.conf

echo "net.bridge.bridge-nf-call-iptables = 1" >> /etc/sysctl.conf

echo "net.ipv6.conf.all.disable_ipv6 = 1" >> /etc/sysctl.conf

echo "net.ipv6.conf.default.disable_ipv6 = 1" >> /etc/sysctl.conf

echo "net.ipv6.conf.lo.disable_ipv6 = 1" >> /etc/sysctl.conf

echo "net.ipv6.conf.all.forwarding = 1" >> /etc/sysctl.conf

# 执行命令以应用

sysctl -p

# 配置K8S的yum源

cat <<EOF > /etc/yum.repos.d/kubernetes.repo

[kubernetes]

name=Kubernetes

baseurl=http://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64

enabled=1

gpgcheck=0

repo_gpgcheck=0

gpgkey=http://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg

http://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpg

EOF

# 卸载旧版本

yum remove -y kubelet kubeadm kubectl

# 安装kubelet、kubeadm、kubectl

# 将 ${1} 替换为 kubernetes 版本号,例如 1.19.0

# yum install -y kubelet-${1} kubeadm-${1} kubectl-${1}

# 重启 docker,并启动 kubelet

systemctl daemon-reload

systemctl restart docker

# systemctl enable kubelet && systemctl start kubelet

docker version

执行安装docker

sh /application/install-docker.sh

三、安装 kubenetes 1.18.2

在 master01 master02 master03 node01 上安装kubeadm 和 kubelet

yum install kubeadm-1.18.2 kubelet-1.18.2 -y

systemctl enable kubelet

systemctl restart kubelet

安装各个组件

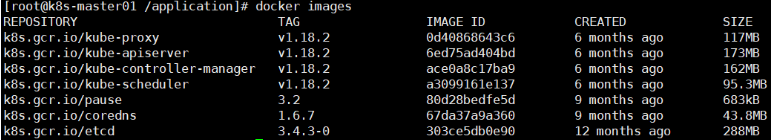

pause版本是3.2,用到的镜像是k8s.gcr.io/pause:3.2

etcd版本是3.4.3,用到的镜像是k8s.gcr.io/etcd:3.4.3-0

cordns版本是1.6.7,用到的镜像是k8s.gcr.io/coredns:1.6.7

apiserver、scheduler、controller-manager、kube-proxy版本是1.18.2,用到的镜像分别是 :

k8s.gcr.io/kube-apiserver:v1.18.2

k8s.gcr.io/kube-controller-manager:v1.18.2

k8s.gcr.io/kube-scheduler:v1.18.2

k8s.gcr.io/kube-proxy:v1.18.2

【说明:每一个master节点上都需要安装】

安装包百度盘:链接:https://pan.baidu.com/s/1WI-6pFzSWL5gCNxMXL6ykQ 提取码:bwen 解压

docker load -i <image_name>.tar.gz

# 全部解压

在这里所有master节点的镜像信息为以下:

初始化ApiServer

初始化ApiServer的Load Balance(私网)

监听端口:6443/TCP

后端资源组:k8s-master01,k8s-master02,k8s-master03

后端端口:6443

开启 按源地址保持会话

Load Balance 可以的选择有

nginx

haproxy

keepalived

云厂商提供的负载均衡产品

【注意:在这里我们使用的是云主机,我们使用腾讯云的CLB负载均衡产品】

购买内网云负载均衡

进行配置

初始化第一个master节点

# 只在第一个master上执行

# 替换apiserver.demo 为你想要的dnsName,也可以直接使用apiserver.demo

export APISERVER_NAME=apiserver.demo

# Kubernetes 容器组所在的网段,该网段安装完成后,由 kubernetes 创建,事先并不存在于您的物理网络中

export POD_SUBNET=10.244.0.1/16

echo "127.0.0.1 ${APISERVER_NAME}" >> /etc/hosts

# 配置 kubeadm 文件

cat <<EOF > /application/kubeadm-config.yaml

apiVersion: kubeadm.k8s.io/v1beta2

kind: ClusterConfiguration

kubernetesVersion: v1.18.2

imageRepository: registry.cn-hangzhou.aliyuncs.com/google_containers

controlPlaneEndpoint: "apiserver.demo:6443"

networking:

serviceSubnet: "10.96.0.0/16"

podSubnet: "10.244.0.0/16"

dnsDomain: "cluster.local"

EOF

# 初始化 k8s 集群

cd /application

kubeadm init --config kubeadm-config.yaml

# 出现 Your Kubernetes control-plane has initialized successfully! 成功

授权操作k8s资源

# 在master01上执行

mkdir -p $HOME/.kube

sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

sudo chown $(id -u):$(id -g) $HOME/.kube/config

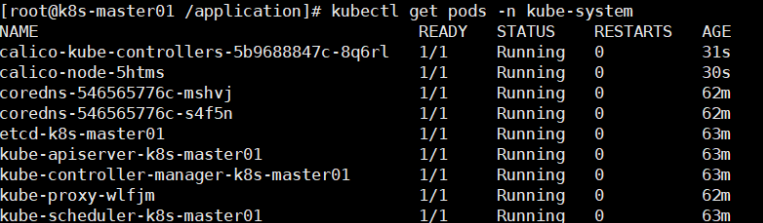

安装calico网络插件

安装calico需要的镜像有:

quay.io/calico/cni:v3.9.2 quay.io/calico/kube-controllers:v3.9.2 quay.io/calico/pod2daemon-flexvol:v3.9.2 quay.io/calico/node:v3.5.3

还有需要的calico-3.9.2.yaml文件也在网盘

百度网盘:链接:https://pan.baidu.com/s/1yZ4OiJEf_Mi4USW3pjmc2g 提取码:bwen

cd /application/

# 将calico-3.9.2.yaml文件传入

sed -i "s#192\.168\.0\.0/16#${POD_SUBNET}#" calico-3.9.2.yaml

kubectl apply -f /application/calico-3.9.2.yaml

拷贝证书

将 master01 上面的文件拷贝到 master02 和 master03 上

# 在 master02 和 master 03 上执行

cd /root && mkdir -p /etc/kubernetes/pki/etcd &&mkdir -p ~/.kube/

# 把 master01 上面的证书复制到 master02 和 master03 上

scp /etc/kubernetes/pki/ca.crt k8s-master02:/etc/kubernetes/pki/

scp /etc/kubernetes/pki/ca.key k8s-master02:/etc/kubernetes/pki/

scp /etc/kubernetes/pki/sa.key k8s-master02:/etc/kubernetes/pki/

scp /etc/kubernetes/pki/sa.pub k8s-master02:/etc/kubernetes/pki/

scp /etc/kubernetes/pki/front-proxy-ca.crt k8s-master02:/etc/kubernetes/pki/

scp /etc/kubernetes/pki/front-proxy-ca.key k8s-master02:/etc/kubernetes/pki/

scp /etc/kubernetes/pki/etcd/ca.crt k8s-master02:/etc/kubernetes/pki/etcd/

scp /etc/kubernetes/pki/etcd/ca.key k8s-master02:/etc/kubernetes/pki/etcd/

scp /etc/kubernetes/pki/ca.crt k8s-master03:/etc/kubernetes/pki/

scp /etc/kubernetes/pki/ca.key k8s-master03:/etc/kubernetes/pki/

scp /etc/kubernetes/pki/sa.key k8s-master03:/etc/kubernetes/pki/

scp /etc/kubernetes/pki/sa.pub k8s-master03:/etc/kubernetes/pki/

scp /etc/kubernetes/pki/front-proxy-ca.crt k8s-master03:/etc/kubernetes/pki/

scp /etc/kubernetes/pki/front-proxy-ca.key k8s-master03:/etc/kubernetes/pki/

scp /etc/kubernetes/pki/etcd/ca.crt k8s-master03:/etc/kubernetes/pki/etcd/

scp /etc/kubernetes/pki/etcd/ca.key k8s-master03:/etc/kubernetes/pki/etcd/

初始化其他master节点

# 在 master01 上执行

kubeadm init phase upload-certs --upload-certs

# 获得以下内容:

# [upload-certs] Using certificate key:

# baac735689ed0d0fcae1dc4cddcafcaba63bf33787307017e4719e4999abe84f

# 在 master01 上执行

kubeadm token create --print-join-command

# 获得以下内容

# kubeadm join apiserver.demo:6443 --token 80cvwb.aiu7v5svs411ilc6 --discovery-token-ca-cert-hash sha256:2283acdd1b0bd3a3d92fcff7675860518eefa96434329382f3d49ea2a717ff53

# 【刚刚获得了 key 和 join 命令】

# ===============初始化第二,三个master节点================

# 替换172.17.64.13为你的 apiserver loadbalance地址ip

export APISERVER_IP=172.17.64.13

# 替换 apiserver.demo 为 前面已经使用的 dnsName

export APISERVER_NAME=apiserver.demo

echo "${APISERVER_IP} ${APISERVER_NAME}" >> /etc/hosts

# master02 和 master01 加入

kubeadm join apiserver.demo:6443 --token 80cvwb.aiu7v5svs411ilc6 --discovery-token-ca-cert-hash sha256:2283acdd1b0bd3a3d92fcff7675860518eefa96434329382f3d49ea2a717ff53 --control-plane --certificate-key baac735689ed0d0fcae1dc4cddcafcaba63bf33787307017e4719e4999abe84f

# 在 master02 和 master03 上执行

mkdir -p $HOME/.kube

sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

sudo chown $(id -u):$(id -g) $HOME/.kube/config

检查apiserver.demo:6443

curl -ik https://apiserver.demo:6443/version

# 返回 200

初始化node节点

# 只在 worker 节点执行

# 替换 x.x.x.x 为 ApiServer LoadBalancer 的 IP 地址

export MASTER_IP=172.17.64.13

# 替换 apiserver.demo 为初始化 master 节点时所使用的 APISERVER_NAME

export APISERVER_NAME=apiserver.demo

echo "${MASTER_IP} ${APISERVER_NAME}" >> /etc/hosts

# 加入 work 节点

kubeadm join apiserver.demo:6443 --token 80cvwb.aiu7v5svs411ilc6 --discovery-token-ca-cert-hash sha256:2283acdd1b0bd3a3d92fcff7675860518eefa96434329382f3d49ea2a717ff53

解决node节点无法使用kubectl命令

# master01节点上执行

scp /etc/kubernetes/admin.conf k8s-node01:/etc/kubernetes/

# node节点上执行

mkdir -p $HOME/.kube

sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

sudo chown $(id -u):$(id -g) $HOME/.kube/config

最终结果

kubernetes-1.18.2集群安装-02的更多相关文章

- kubeadm安装kubernetes V1.11.1 集群

之前测试了离线环境下使用二进制方法安装配置Kubernetes集群的方法,安装的过程中听说 kubeadm 安装配置集群更加方便,因此试着折腾了一下.安装过程中,也有一些坑,相对来说操作上要比二进制方 ...

- K8s集群安装--最新版 Kubernetes 1.14.1

K8s集群安装--最新版 Kubernetes 1.14.1 前言 网上有很多关于k8s安装的文章,但是我参照一些文章安装时碰到了不少坑.今天终于安装好了,故将一些关键点写下来与大家共享. 我安装是基 ...

- Hadoop集群搭建-02安装配置Zookeeper

Hadoop集群搭建-05安装配置YARN Hadoop集群搭建-04安装配置HDFS Hadoop集群搭建-03编译安装hadoop Hadoop集群搭建-02安装配置Zookeeper Hado ...

- [转帖]K8s集群安装--最新版 Kubernetes 1.14.1

K8s集群安装--最新版 Kubernetes 1.14.1 http://www.cnblogs.com/jieky/p/10679998.html 原作者写的比较简单 大略流程和跳转的多一些 改天 ...

- Kubernetes 深入学习(一) —— 入门和集群安装部署

一.简介 1.Kubernetes 是什么 Kubernetes 是一个全新的基于容器技术的分布式架构解决方案,是 Google 开源的一个容器集群管理系统,Kubernetes 简称 K8S. Ku ...

- 02.Flink的单机wordcount、集群安装

一.单机安装 1.准备安装包 将源码编译出的安装包拷贝出来(编译请参照上一篇01.Flink笔记-编译.部署)或者在Flink官网下载bin包 2.配置 前置:jdk1.8+ 修改配置文件flink- ...

- 使用Kubeadm搭建Kubernetes(1.12.2)集群

Kubeadm是Kubernetes官方提供的用于快速安装Kubernetes集群的工具,伴随Kubernetes每个版本的发布都会同步更新,在2018年将进入GA状态,说明离生产环境中使用的距离越来 ...

- 利用ansible来做kubernetes 1.10.3集群高可用的一键部署

请读者务必保持环境一致 安装过程中需要下载所需系统包,请务必使所有节点连上互联网. 本次安装的集群节点信息 实验环境:VMware的虚拟机 IP地址 主机名 CPU 内存 192.168.77.133 ...

- Kubernetes实战 高可用集群搭建,配置,运维与应用

1-1 K8S导学 1-2 搭建K8S集群步骤和要点介绍 1-3 搭建三节点Ubuntu环境 1-4 安装容器引擎 1-5 下载Kubeadm.node组件和命令行工具 1-6 向集群中加入worke ...

随机推荐

- 笔记本键盘按U键却变成了4

解答 笔记本键盘U盘变成了4,是因为你开启了小键盘功能.出现该问题,只要关闭小键盘功能即可,操作如下: 按住键盘下方的Fn,同时按住键盘顶部的F键中标有Numlk的键. 电脑屏幕出现解锁标志,小键盘功 ...

- org.apache.ibatis.ognl.OgnlException: source is null for getProperty(null, "enterpCd")-Mybatis报错

一.问题由来 下午快要下班时,登录测试服务器查看日志信息,看看有没有新的异常信息,如果有的话好及时修改.结果一看果然有新的异常信息. 主要的异常信息如下: 2020-10-13 14:51:03,03 ...

- 多测师_肖sir _python 练习题(一)100以内奇数,偶数,质数胡计算

(1)求1~100的和方法: 方法一:print(sum(range(1,101))) 方法二: sum1 = 0 i = 1 while True: sum1 = sum1 + i if i == ...

- 用cgroup限制内存以防止Linux因内存用尽卡死

Linux在内存用尽的情况下,整个界面,包括tty和ctrl-alt-F1都会卡住难以响应.虽然Linux内核有OOM Killer机制杀掉吃内存的进程,但经常内存用尽时连OOM Killer都无法动 ...

- idea创建servlet工程初体验

servlet工程创建 前提:创建项目之前需要配置java环境变量 和tomcat配置,配置完成后进入如下操作. tomcat 安装和配置参考 https://www.cnblogs.com/xush ...

- 安装虚拟机V15.5及LinuxCentOS6简易步骤

1.下载虚拟机和Linux系统: (1)虚拟机下载地址(失效请自行百度):http://www.downza.cn/soft/74728.html (2)Linux系统下载地址(失效请自行百度):ht ...

- 【Azure Redis 缓存 Azure Cache For Redis】在创建高级层Redis(P1)集成虚拟网络(VNET)后,如何测试VNET中资源如何成功访问及配置白名单的效果

当使用Azure Redis高级版时候,为了能更好的保护Redis的安全,启用了虚拟网路,把Redis集成在Azure中的虚拟网络,只能通过虚拟网络VENT中的资源进行访问,而公网是不可以访问的.但是 ...

- 因果推理综述——《A Survey on Causal Inference》一文的总结和梳理

因果推理 本文档是对<A Survey on Causal Inference>一文的总结和梳理. 论文地址 简介 关联与因果 先有的鸡,还是先有的蛋?这里研究的是因果关系,因果关系与普通 ...

- Linux文件系统和管理-1文件系统目录

文件系统目录结构 Linux常见目录及用途 bin binary 放的是二进制程序 /usr/bin 和这是同一回事 bin -> usr/bin /bin是 /usr/bin的快捷方式 boo ...

- CPU:Central Processing Unit

CPU执行计算任务时都需要遵从一定的规范,程序在被执行前都需要先翻译为CPU可以理解的语言.这种规范或语言就是指令集(ISA,Instruction Set Architecture). CPU 架构 ...