python批量爬取猫咪图片

不多说直接上代码

首先需要安装需要的库,安装命令如下

pip install BeautifulSoup

pip install requests

pip install urllib

pip install lxmlfrom bs4 import BeautifulSoup # 贵族名宠网页爬虫

import requests

import urllib.request

# 网址

url = 'http://www.hengdadog.com/sale-1.html'

def allpage(): # 获得所有网页

all_url = []

for i in range(1, 8): #循环翻页次数

each_url = url.replace(url[-6], str(i)) # 替换

all_url.append(each_url)

return (all_url) # 返回地址列表 if __name__ == '__main__':

img_url = allpage() # 调用函数

for url in img_url:

# 获得网页源代码

print(url)

requ = requests.get(url)

req = requ.text.encode(requ.encoding).decode()

html = BeautifulSoup(req, 'lxml')

t = 0

# 选择目标url

img_urls = html.find_all('img')

for k in img_urls:

img = k.get('src') # 图片

print(img)

name = str(k.get('alt')) # 名字,这里的强制类型转换很重要

type(name)

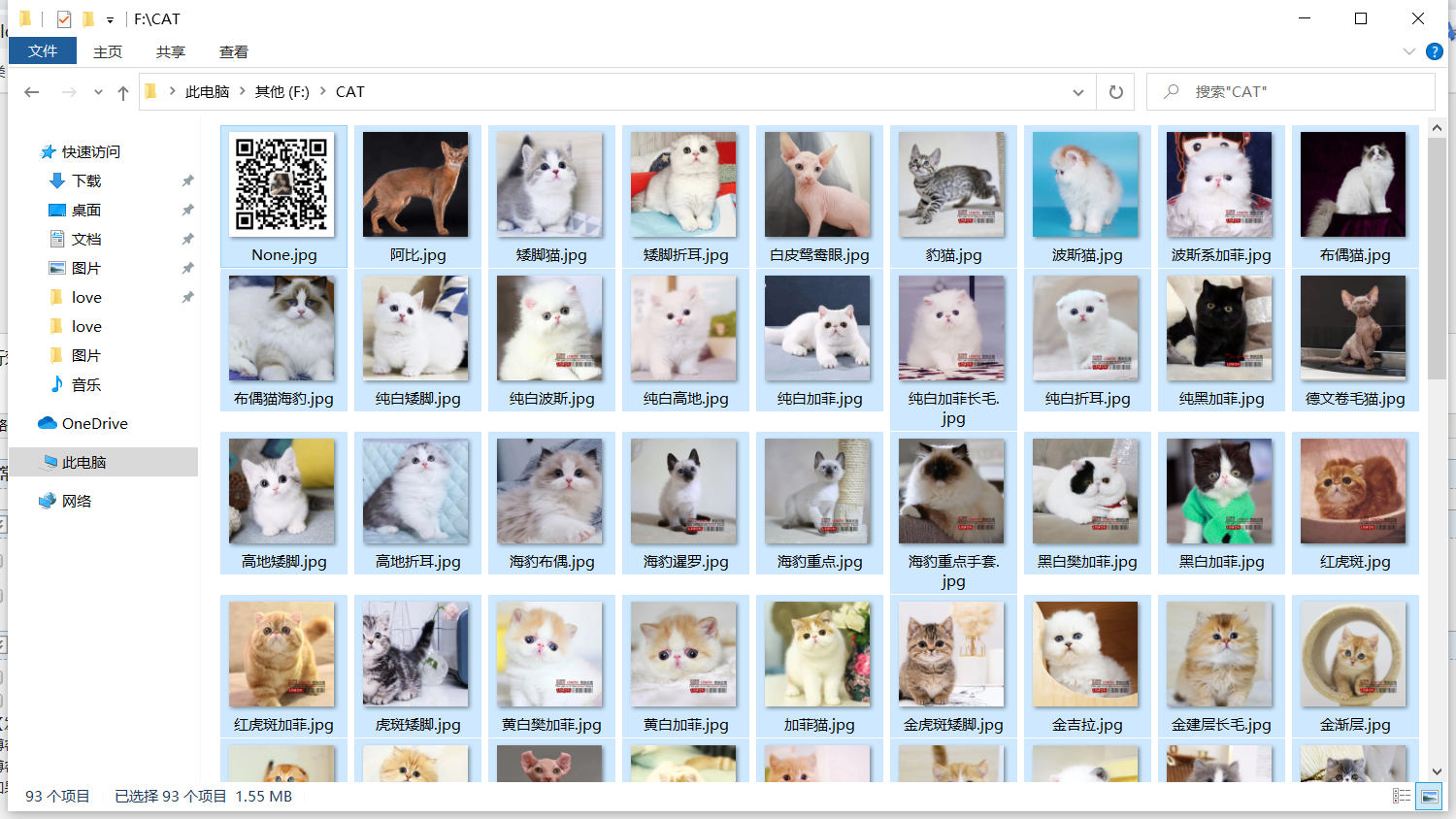

# 先本地新建一下文件夹,保存图片并且命名

path = 'F:\\CAT\\' # 路径

file_name = path + name + '.jpg'

imgs = requests.get(img) # 存储入文件

try:

urllib.request.urlretrieve(img, file_name) # 打开图片地址,下载图片保存在本

except:

print("error")

运行效果:

上面代码有不少缺陷,比如需要手动创建目录以及判断目录是否存在,下载没有提示,于是做了些优化:

from bs4 import BeautifulSoup # 贵族名宠网页爬虫

import requests

import urllib.request

import os

# 网址

url = 'http://www.hengdadog.com/sale-1.html'

if os.path.exists('F:\\CAT'):#判断目录是否存在,存在则跳过,不存在则创建

pass

else:

os.mkdir('F:\\CAT')

def allpage(): # 获得所有网页

all_url = []

for i in range(1, 10): #循环翻页次数

each_url = url.replace(url[-6], str(i)) # 替换

all_url.append(each_url)

return (all_url) # 返回地址列表 if __name__ == '__main__':

img_url = allpage() # 调用函数

for url in img_url:

# 获得网页源代码

print(url)

requ = requests.get(url)

req = requ.text.encode(requ.encoding).decode()

html = BeautifulSoup(req, 'lxml')

t = 0

# 选择目标url

img_urls = html.find_all('img')

for k in img_urls:

img = k.get('src') # 图片

print(img)

name = str(k.get('alt')) # 名字,这里的强制类型转换很重要

type(name)

# 保存图片并且命名

path = 'F:\\CAT\\' # 路径

file_name = path + name + '.jpg'

imgs = requests.get(img) # 存储入文件

try:

urllib.request.urlretrieve(img, file_name) # 打开图片地址,下载图片保存在本地,

print('正在下载图片到F:\CAT目录······')

except:

print("error")

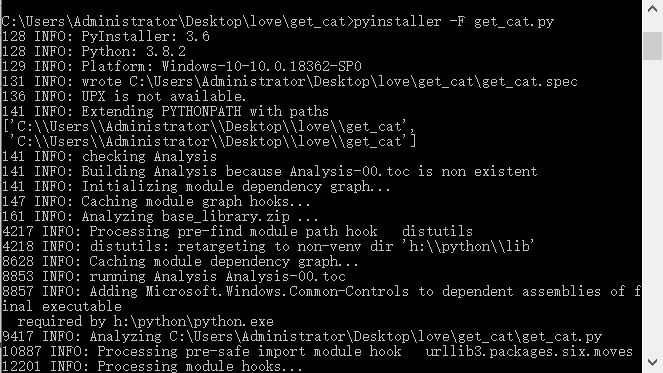

打包成EXE文件:

进入文件目录输入如下命令

pyinstaller -F get_cat.py

python批量爬取猫咪图片的更多相关文章

- 使用Python爬虫爬取网络美女图片

代码地址如下:http://www.demodashi.com/demo/13500.html 准备工作 安装python3.6 略 安装requests库(用于请求静态页面) pip install ...

- 从0实现python批量爬取p站插画

一.本文编写缘由 很久没有写过爬虫,已经忘得差不多了.以爬取p站图片为着手点,进行爬虫复习与实践. 欢迎学习Python的小伙伴可以加我扣群86七06七945,大家一起学习讨论 二.获取网页源码 爬取 ...

- python爬虫——爬取NUS-WIDE数据库图片

实验室需要NUS-WIDE数据库中的原图,数据集的地址为http://lms.comp.nus.edu.sg/research/NUS-WIDE.htm 由于这个数据只给了每个图片的URL,所以需 ...

- python 批量爬取四级成绩单

使用本文爬取成绩大致有几个步骤:1.提取表格(或其他格式文件——含有姓名,身份证等信息)中的数据,为进行准考证爬取做准备.2.下载准考证文件并提取出准考证和姓名信息.3.根据得到信息进行数据分析和存储 ...

- 用Python批量爬取优质ip代理

前言 有时候爬的次数太多时ip容易被禁,所以需要ip代理的帮助.今天爬的思路是:到云代理获取大量ip代理,逐个检测,将超时不可用的代理排除,留下优质的ip代理. 一.爬虫分析 首先看看今天要爬取的网址 ...

- python批量爬取动漫免费看!!

实现效果 运行环境 IDE VS2019 Python3.7 Chrome.ChromeDriver Chrome和ChromeDriver的版本需要相互对应 先上代码,代码非常简短,包含空行也才50 ...

- Python批量爬取谷歌原图,2021年最新可用版

文章目录 前言 一.环境配置 1.安装selenium 2.使用正确的谷歌浏览器驱动 二.使用步骤 1.加载chromedriver.exe 2.设置是否开启可视化界面 3.输入关键词.下载图片数.图 ...

- python 批量爬取代理ip

import urllib.request import re import time import random def getResponse(url): req = urllib.request ...

- java爬取猫咪上的图片

首先是对知识点归纳 1.用到获取网页源代码,分析图片地址,发现图片的地址都是按编号排列的,所以想到用循环获取 2.保存图片要用到流操作和文件操作,对两部分知识进行了复习巩固 3.保存后的图片有一部分是 ...

随机推荐

- dubbo,hessian过滤器filter使用

Dubbo的Filter在使用的过程中是我们扩展最频繁的内容,而且Dubbo的很多特性实现也都离不开Filter的工作,今天一起来看一下Filter的具体实现. Filter(过滤器)在很多框架中都有 ...

- nginx负载均衡常见问题配置信息

nginx为后端web服务器(apache,nginx,tomcat,weblogic)等做反向代理 几台后端web服务器需要考虑文件共享,数据库共享,session共享问题.文件共享可以使用nfs, ...

- Spring Boot学习笔记(一)——Eclipse安装STS插件

一.简介 Spring Boot是由Pivotal团队提供的全新框架,其设计目的是用来简化新Spring应用的初始搭建以及开发过程.该框架使用了特定的方式进行配置,从而使开发人员不再需要定义样板化的配 ...

- Win32编程之控制线程

0x01. 如何让线程停下来 让自己停下来: Sleep() 函数 当程序执行到某段代码的时候可以使用sleep() 函数进行暂停 使用sleep()函数挂起的时候会自动恢复过来的 让别人停下来: S ...

- java数据结构-07栈

一.什么是栈 栈是一种线性结构,栈的特点就是先进后出(FILO):就像弹夹装子弹一样,最先压进去的在最底下,最后才被射出. 二.相关接口设计 三.栈的实现 栈可以用之前的数组.链表等设计,这里我使 ...

- 自动化运维Ansible-01-安装及简单的使用

实验环境:Centos 7.x Ansible版本:ansible 2.9.13 服务端的操作 1.系统默认的yum仓库中没有找到ansible,这里我们先安装epel源(需要用到CentOS-Bas ...

- Linux 网络编程的5种IO模型:多路复用(select/poll/epoll)

Linux 网络编程的5种IO模型:多路复用(select/poll/epoll) 背景 我们在上一讲 Linux 网络编程的5种IO模型:阻塞IO与非阻塞IO中,对于其中的 阻塞/非阻塞IO 进行了 ...

- malloc,calloc,realloc三者的区别

malloc,calloc,realloc三者都可以运用与动态分配数组. malloc:用malloc必须要自己初始化,可以用memset(arr,0,cnt*sizeof(int)) calloc: ...

- 浅谈js for循环输出i为同一值的问题

问题再现 最近开发中遇到一个问题,为什么每次输出都是5,而不是点击每个p,就alert出对应的1,2,3,4,5. <html> <head> <meta http- ...

- HTTPDNS开源 Android SDK,赋能更多开发者参与共建

为赋能更多开发者参与共建,阿里云HTTPDNS开源 Android SDK,iOS SDK也在做开源准备,不久也将开放给开发者.HTTPDNS是阿里云移动研发平台面向多端应用(移动端APP,PC客户端 ...