Scrapy 项目:腾讯招聘

目的:

通过爬取腾讯招聘网站(https://careers.tencent.com/search.html)练习Scrapy框架的使用

步骤:

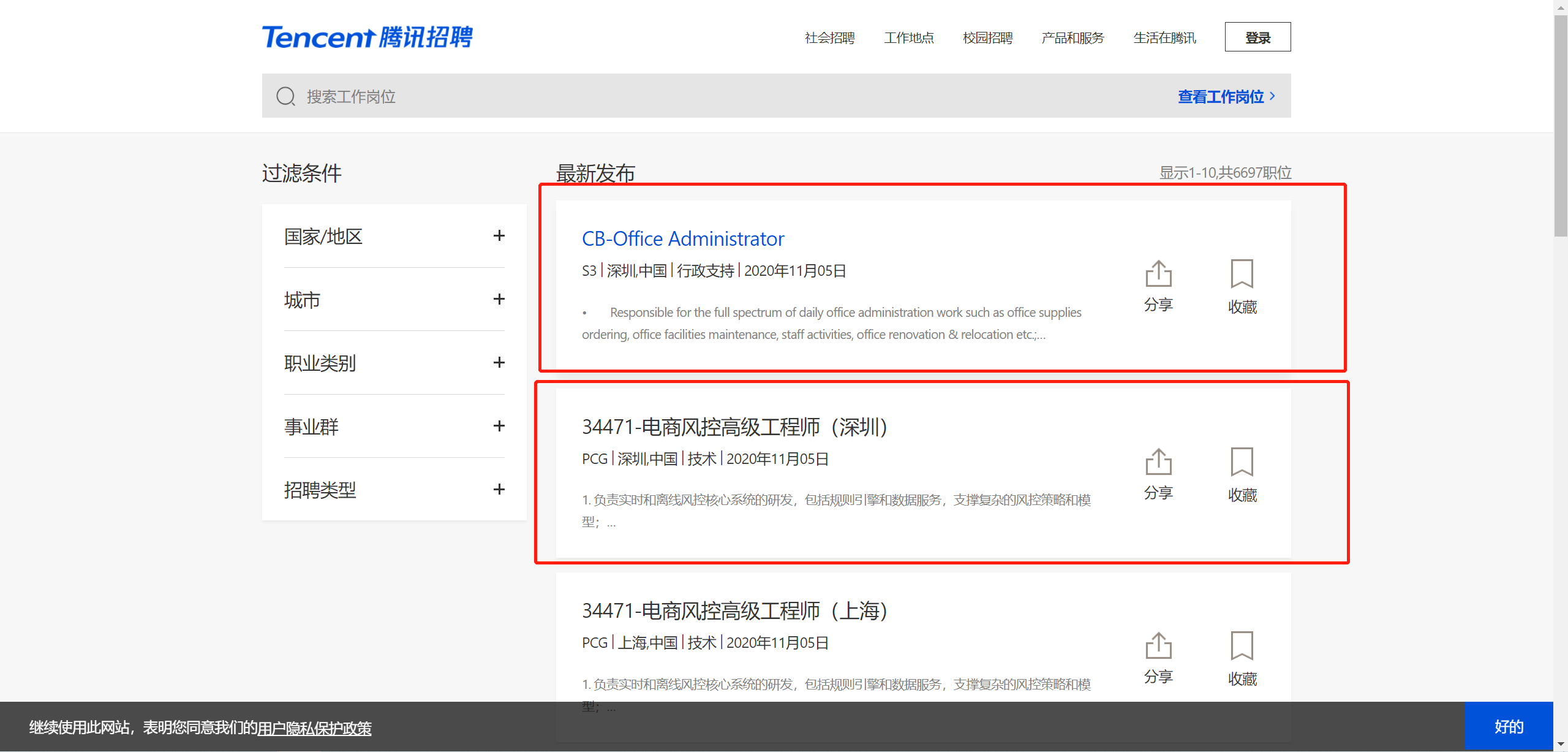

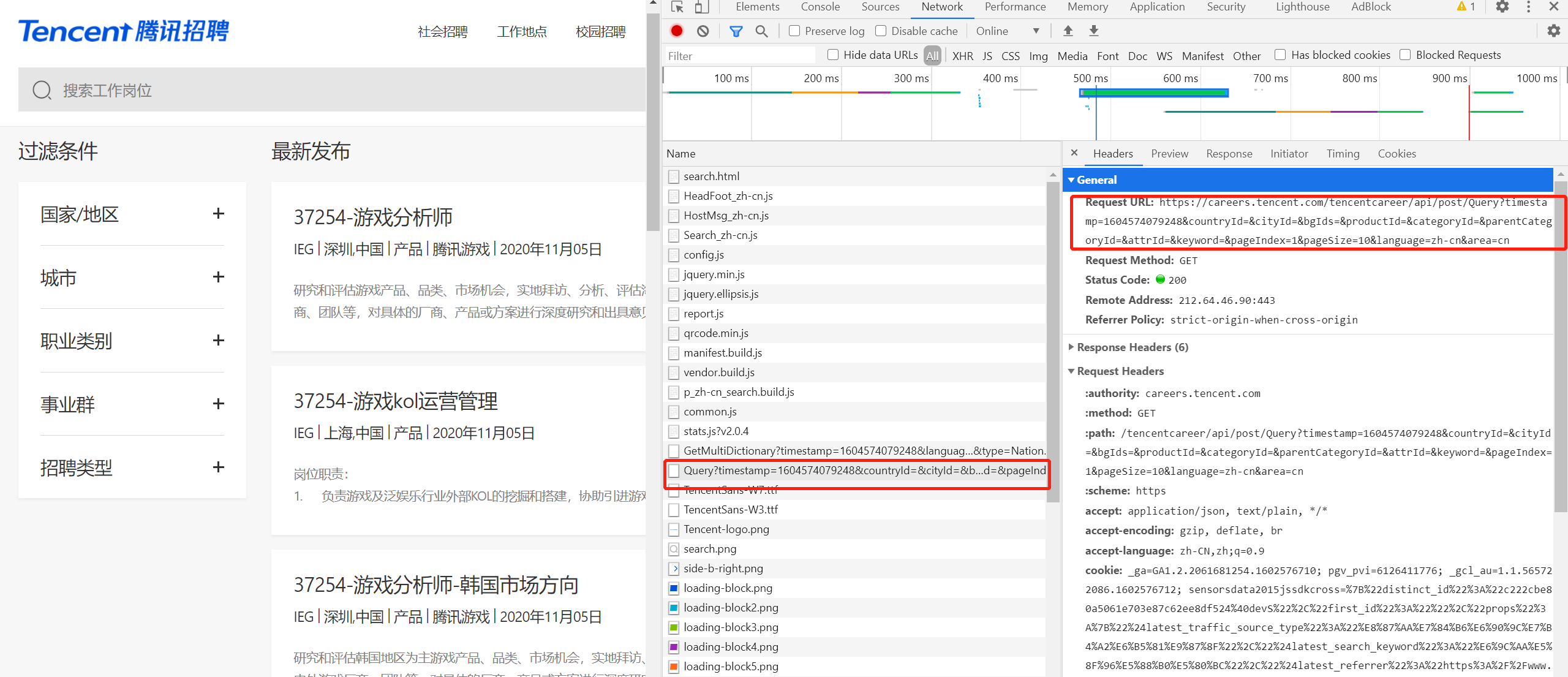

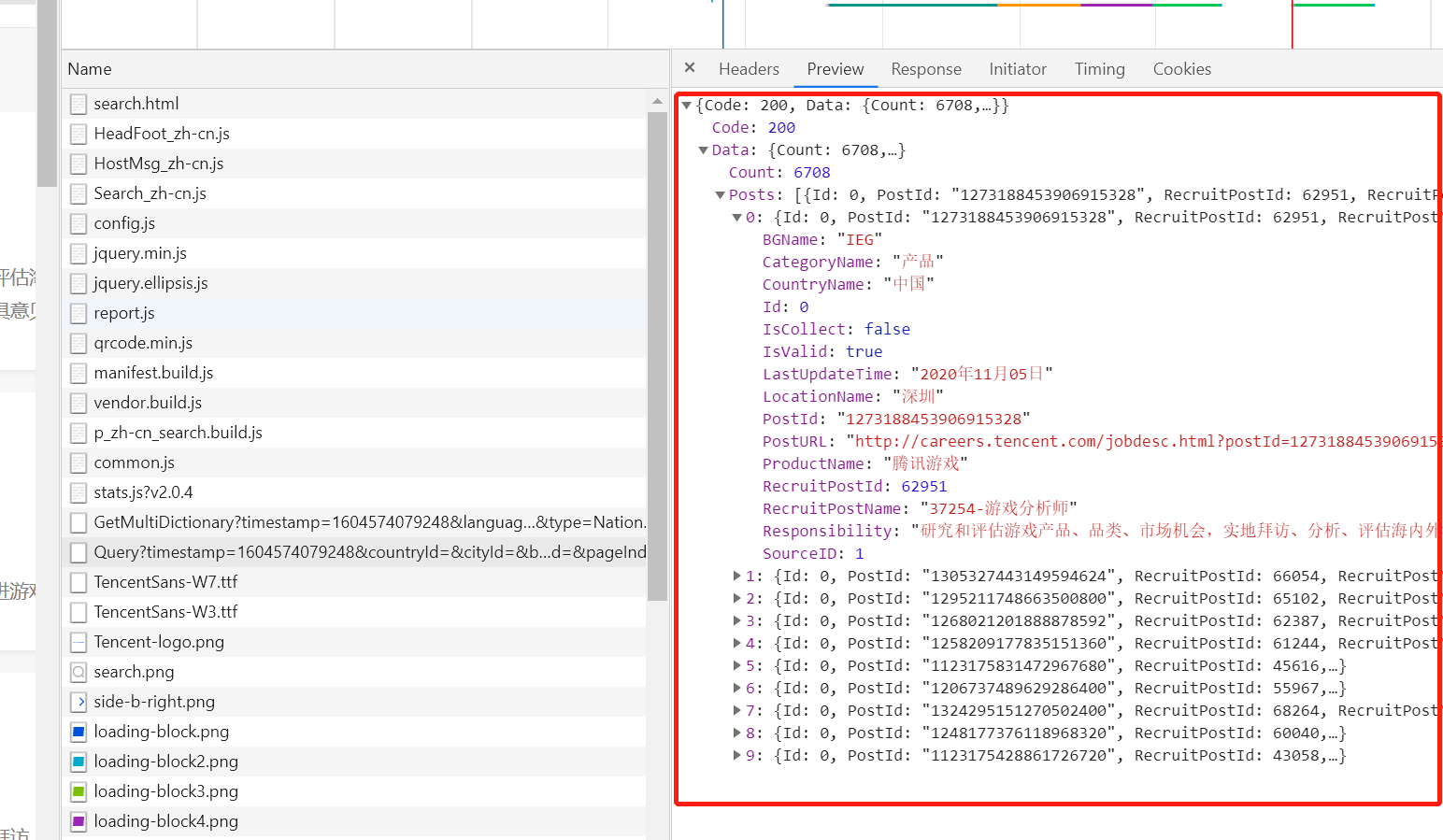

1、通过抓包确认要抓取的内容是否在当前url地址中,测试发现内容不在当前url中并且数据格式为json字符串

2、请求url地址过长,考虑去除某些部分,经测试得到

'https://careers.tencent.com/tencentcareer/api/post/Query?keyword=&pageIndex=1&pageSize=10&language=zh-cn&area=cn'

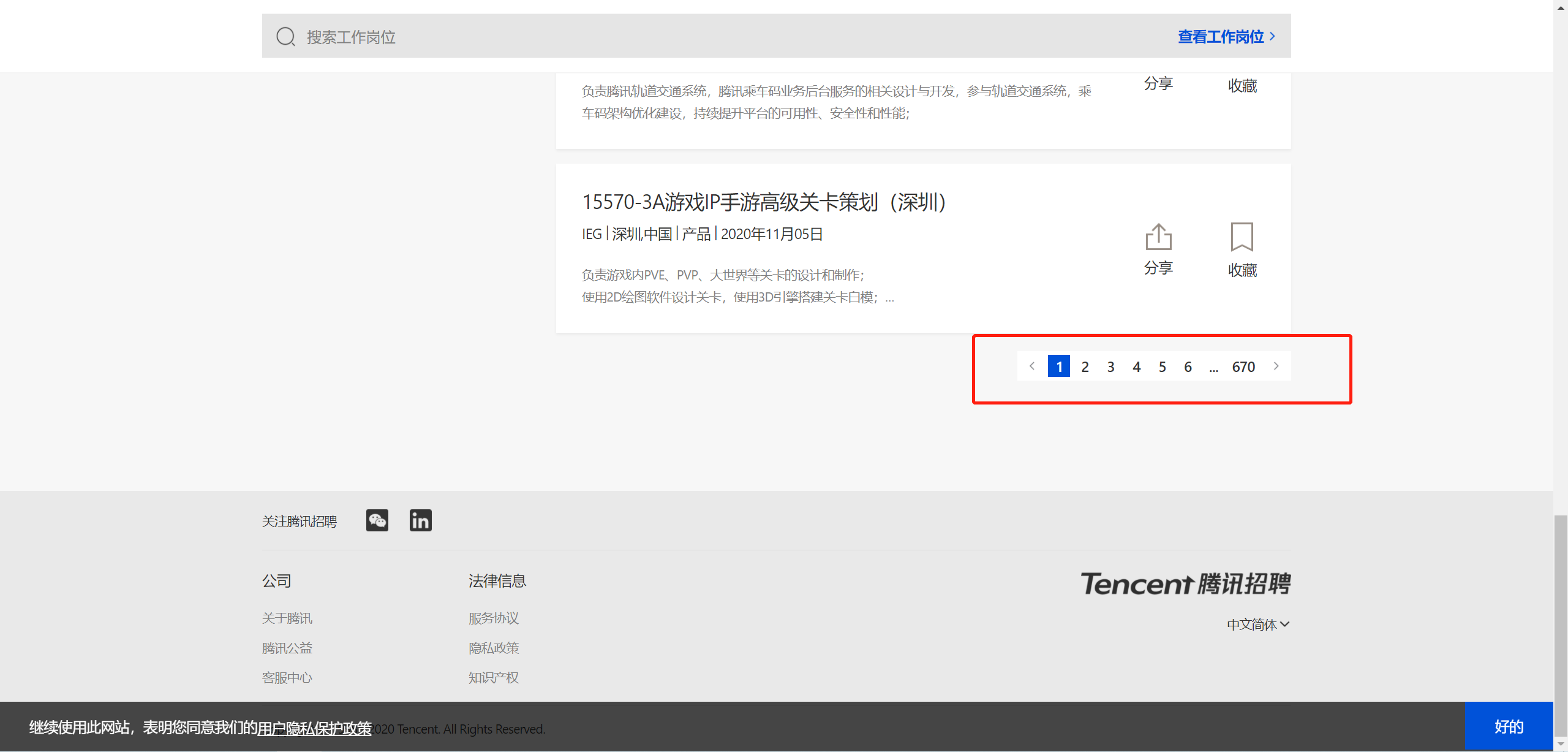

3、寻找url地址,pageIndex=页码,可构造爬虫循环的URL列表

4、书写爬虫代码

- scrapy startproject tencent tencent.com

- cd tencent.com

- scrapy genspider hr tencent.com

5、保存为CSV文件

1 import scrapy

2 import json

3

4

5 class HrSpider(scrapy.Spider):

6 name = 'hr'

7 allowed_domains = ['tencent.com']

8 start_urls = ['https://careers.tencent.com/tencentcareer/api/post/Query?keyword=&pageIndex=1&pageSize=10&language'

9 '=zh-cn&area=cn']

10 url = 'https://careers.tencent.com/tencentcareer/api/post/Query?keyword=&pageIndex={' \

11 '}&pageSize=10&language=zh-cn&area=cn '

12 pageIndex = 1

13

14 def parse(self, response):

15 json_str = json.loads(response.body)

16 for content in json_str["Data"]["Posts"]:

17 content_dic = {"title": content["RecruitPostName"], "location": content["LocationName"],

18 "date": content["LastUpdateTime"]}

19 print(content_dict)20

yield content_dic

21

23 if self.pageIndex < 10:

24 self.pageIndex += 1

25 next_url = self.url.format(self.pageIndex)

26 yield scrapy.Request(url=next_url, callback=self.parse)

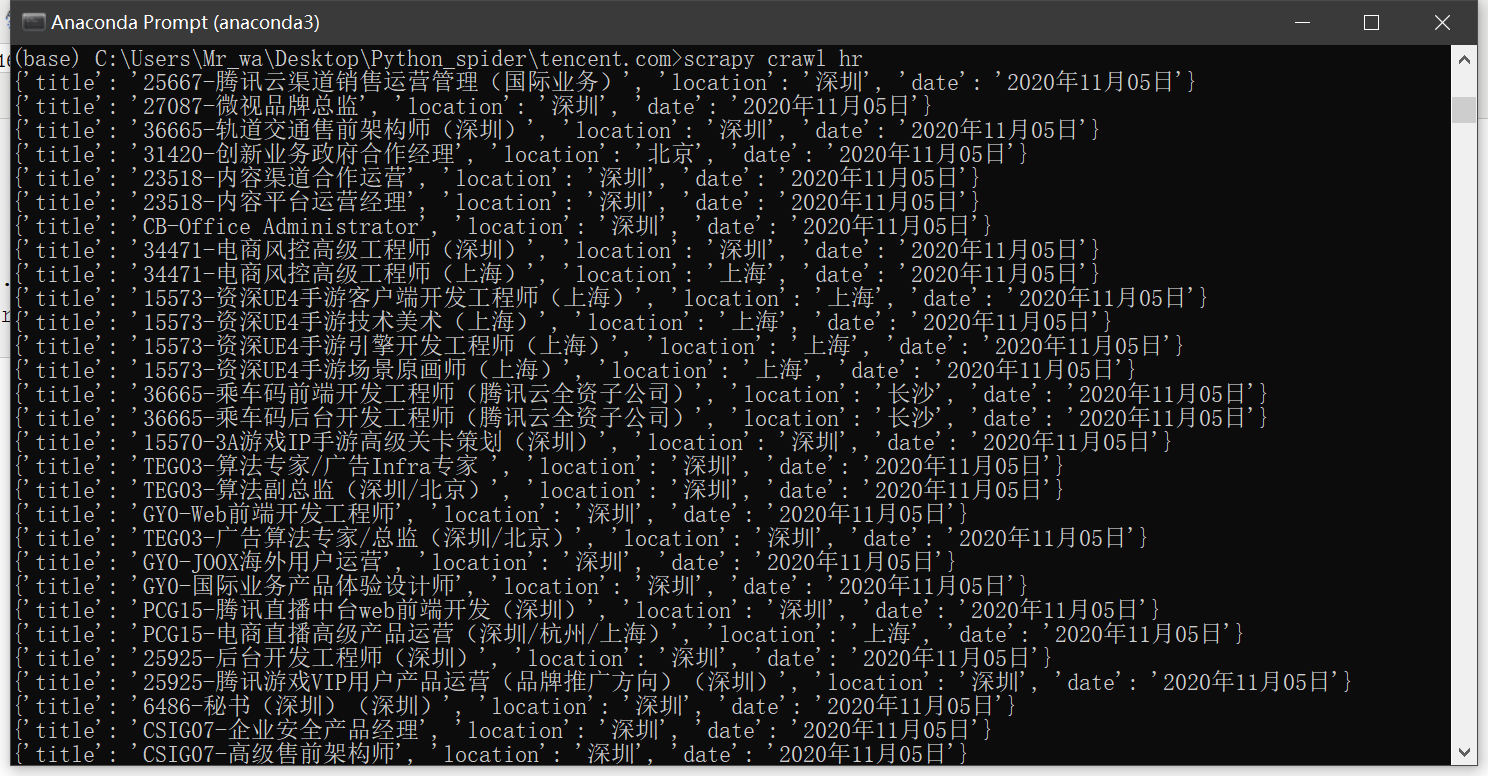

运行爬虫

- scrapy crawl hr

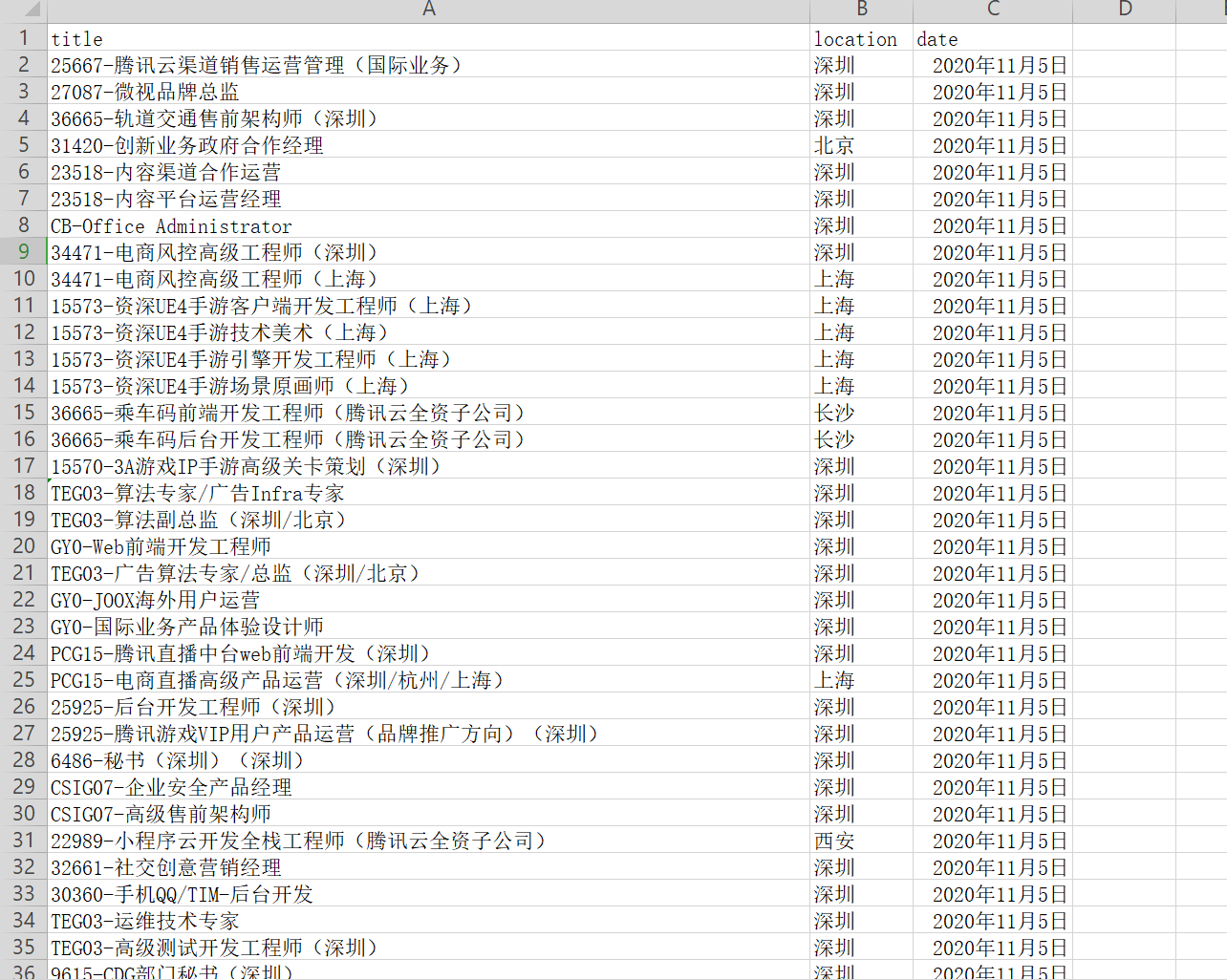

保存命令

- scrapy crawl hr -o tencent.csv

Scrapy 项目:腾讯招聘的更多相关文章

- Scrapy实现腾讯招聘网信息爬取【Python】

一.腾讯招聘网 二.代码实现 1.spider爬虫 # -*- coding: utf-8 -*- import scrapy from Tencent.items import TencentIte ...

- Scrapy:腾讯招聘整站数据爬取

项目地址:https://hr.tencent.com/ 步骤一.分析网站结构和待爬取内容 以下省略一万字 步骤二.上代码(不能略了) 1.配置items.py import scrapy class ...

- Scrapy案例02-腾讯招聘信息爬取

目录 1. 目标 2. 网站结构分析 3. 编写爬虫程序 3.1. 配置需要爬取的目标变量 3.2. 写爬虫文件scrapy 3.3. 编写yield需要的管道文件 3.4. setting中配置请求 ...

- Scrapy项目 - 实现腾讯网站社会招聘信息爬取的爬虫设计

通过使Scrapy框架,进行数据挖掘和对web站点页面提取结构化数据,掌握如何使用Twisted异步网络框架来处理网络通讯的问题,可以加快我们的下载速度,也可深入接触各种中间件接口,灵活的完成各种需求 ...

- Scrapy项目 - 数据简析 - 实现腾讯网站社会招聘信息爬取的爬虫设计

一.数据分析截图 本例实验,使用Weka 3.7对腾讯招聘官网中网页上所罗列的招聘信息,如:其中的职位名称.链接.职位类别.人数.地点和发布时间等信息进行数据分析,详见如下图: 图1-1 Weka ...

- 简单的scrapy实战:爬取腾讯招聘北京地区的相关招聘信息

简单的scrapy实战:爬取腾讯招聘北京地区的相关招聘信息 简单的scrapy实战:爬取腾讯招聘北京地区的相关招聘信息 系统环境:Fedora22(昨天已安装scrapy环境) 爬取的开始URL:ht ...

- python爬虫scrapy项目详解(关注、持续更新)

python爬虫scrapy项目(一) 爬取目标:腾讯招聘网站(起始url:https://hr.tencent.com/position.php?keywords=&tid=0&st ...

- pymongodb的使用和一个腾讯招聘爬取的案例

一.在python3中操作mongodb 1.连接条件 安装好pymongo库 启动mongodb的服务端(如果是前台启动后就不关闭窗口,窗口关闭后服务端也会跟着关闭) 3.使用 import pym ...

- 亲测——pycharm下运行第一个scrapy项目 ©seven_clear

最近在学习scrapy,就想着用pycharm调试,但不知道怎么弄,从网上搜了很多方法,这里总结一个我试成功了的. 首先当然是安装scrapy,安装教程什么的网上一大堆,这里推荐一个详细的:http: ...

随机推荐

- JavaWeb——JSP,JSP指令,注释

什么是JSP JSP原理 JSP页面中的java代码服务器是如何执行的 Web服务器在调用jsp时会给jsp提供一些什么java对象 JSP执行过程 JSP页面的元素包括 JSP模版元素 JSP脚本片 ...

- Mysql 5.5升级5.8

前言,因为升级跳板机,需要将mariadb 升级到10.2,也就是对应MySQL的5.8,废话不多说下面开始进行mariadb 5.5 的升级 Welcome to the MariaDB monit ...

- mapreduce编程练习(一)简单的练习 WordCount

入门训练:WordCount 问题描述:对一个或多个输入文件中的单词进行计数统计,比如一个文件的输入文件如下 输出格式: 运行代码实例: package hadoopLearn; import jav ...

- OSPF路由汇总

转载自红茶三杯博客:http://blog.sina.com.cn/s/blog_5ec353710102vtfy.html 1. 关于路由汇总 路由汇总,又被称为路由聚合(Route Aggrega ...

- php之魔术方法 __set(),__get(),__isset(),__unset()

__set()与__get() 当一个类里面,属性被设置为私有属性时,这个属性是不能在外部被访问的.那么当我们又想在外部访问时该怎么办呢,我们可以用方法来实现.举例如下: 1 class Test 2 ...

- 使用FOR XML PATH实现多行数据合并成一列

有时为避免循环操作数据库.列表展示等一些原因需要将数据及关联数据批量加载进行集中处理,一种解决办法可以使用FOR XML PATH将多行数据合并成一列,达到字段拼接的效果.例如有两个表, 部门表T_D ...

- AtCoder Beginner Contest 173

比赛链接:https://atcoder.jp/contests/abc173/tasks A - Payment 题意 计算只用 $1000$ 元支付某个价格 $n$ 的找零是多少. 代码 #inc ...

- poj1180 Batch Scheduling

Time Limit: 1000MS Memory Limit: 10000K Total Submissions: 3590 Accepted: 1654 Description There ...

- Python3.9.1中如何使用match方法?

接触编程的朋友都听过正则表达式,在python中叫re模块,属于文字处理服务里面的一个模块.re里面有一个方法叫match,接下来的文章我来详细讲解一下match. 作为新手,我建议多使用帮助文档,也 ...

- 设计模式(二十一)——解释器模式(Spring 框架中SpelExpressionParser源码分析)

1 四则运算问题 通过解释器模式来实现四则运算,如计算 a+b-c 的值,具体要求 1) 先输入表达式的形式,比如 a+b+c-d+e, 要求表达式的字母不能重复 2) 在分别输入 a ,b, c, ...