第六篇 xpath的用法

使用pycharm debug调试效率会比较慢,因为每次调试都需要向url发送请求,等返回信息,scrapy提供一种方便调试的功能,如下:

>>>(third_project) bigni@bigni:pachong$ scrapy shell http://blog.jobbole.com/112239/

>>> title = response.xpath('//*[@id="post-112239"]/div[1]/h1')

>>> title

[<Selector xpath='//*[@id="post-112239"]/div[1]/h1' data='<h1>谷歌用两年时间研究了 180 个团队,发现高效团队有这五个特征</h1>'>]

>>> title.extract()

['<h1>谷歌用两年时间研究了 180 个团队,发现高效团队有这五个特征</h1>']

>>> title = response.xpath('//*[@id="post-112239"]/div[1]/h1/text()')

>>> title

[<Selector xpath='//*[@id="post-112239"]/div[1]/h1/text()' data='谷歌用两年时间研究了 180 个团队,发现高效团队有这五个特征'>]

extract()方法可以取到select list里的date,text()方法可以取到内容。

In []: title2 = response.xpath("//*[@id='post-112239']/div[1]/h1").extract()

In []: title2

Out[]: ['<h1>谷歌用两年时间研究了 180 个团队,发现高效团队有这五个特征</h1>']

In []: title2 = response.xpath("//*[@id='post-112239']/div[1]/h1")

In []: title2

Out[]: [<Selector xpath="//*[@id='post-112239']/div[1]/h1" data='<h1>谷歌用两年时间研究了 180 个团队,发现高效团队有这五个特征</h1>'>]

In []: title2 = response.xpath("//*[@id='post-112239']/div[1]/h1/text()").extr

...: act()

In []: title2

Out[]: ['谷歌用两年时间研究了 180 个团队,发现高效团队有这五个特征']

In []:

PS:在chrome里,按F12看到的代码是加载完所有插件后的,比如JS,如果通过通过根路径来定位要找的内容是容易出错的,因为xpath搜索的不会把js等生成的元素计算在内,这个可以通过鼠标右键查看源码来判断哪些是js生成的,然后过滤掉。

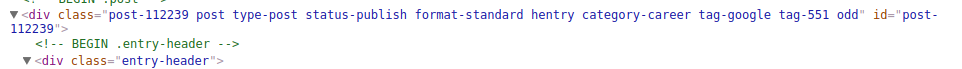

对于属性里有多个值的情况,比如class 里有多个值:

可以使用scrapy内置的contains方法:

In []: ret = response.xpath("//div[contains(@class,'post-112239')]")

In []: ret

Out[]: [<Selector xpath="//div[contains(@class,'post-112239')]" data='<div class="post-112239 post type-post s'>]

如果要爬取下面这个内容,可以这么操作:

In []: rest = response.xpath('//*[@id="post-112239"]/div[3]/div[4]/span[2]/tex

...: t()').extract()[0]

In []: rest

Out[]: ' 8 收藏'

接着再用正则去掉别的信息,由于在scrapy shell中直接调用re模块会报错,那可以用ipython调试

In []: ret = re.match(r".*(\d+).*",' 8 收藏') In []: ret.group()

Out[]: ''

第六篇 xpath的用法的更多相关文章

- [老老实实学WCF] 第六篇 元数据交换

老老实实学WCF 第六篇 元数据交换 通过前两篇的学习,我们了解了WCF通信的一些基本原理,我们知道,WCF服务端和客户端通过共享元数据(包括服务协定.服务器终结点信息)在两个 终结点上建立通道从而进 ...

- Python爬虫利器六之PyQuery的用法

前言 你是否觉得 XPath 的用法多少有点晦涩难记呢? 你是否觉得 BeautifulSoup 的语法多少有些悭吝难懂呢? 你是否甚至还在苦苦研究正则表达式却因为少些了一个点而抓狂呢? 你是否已经有 ...

- (数据科学学习手札61)xpath进阶用法

一.简介 xpath作为对网页.对xml文件进行定位的工具,速度快,语法简洁明了,在网络爬虫解析内容的过程中起到很大的作用,除了xpath的基础用法之外(可参考我之前写的(数据科学学习手札50)基于P ...

- 解剖SQLSERVER 第十六篇 OrcaMDF RawDatabase --MDF文件的瑞士军刀(译)

解剖SQLSERVER 第十六篇 OrcaMDF RawDatabase --MDF文件的瑞士军刀(译) http://improve.dk/orcamdf-rawdatabase-a-swiss-a ...

- 解剖SQLSERVER 第六篇 对OrcaMDF的系统测试里避免regressions(译)

解剖SQLSERVER 第六篇 对OrcaMDF的系统测试里避免regressions (译) http://improve.dk/avoiding-regressions-in-orcamdf-b ...

- Python之路【第十六篇】:Django【基础篇】

Python之路[第十六篇]:Django[基础篇] Python的WEB框架有Django.Tornado.Flask 等多种,Django相较与其他WEB框架其优势为:大而全,框架本身集成了O ...

- 第六篇 :微信公众平台开发实战Java版之如何自定义微信公众号菜单

我们来了解一下 自定义菜单创建接口: http请求方式:POST(请使用https协议) https://api.weixin.qq.com/cgi-bin/menu/create?access_to ...

- RabbitMQ学习总结 第六篇:Topic类型的exchange

目录 RabbitMQ学习总结 第一篇:理论篇 RabbitMQ学习总结 第二篇:快速入门HelloWorld RabbitMQ学习总结 第三篇:工作队列Work Queue RabbitMQ学习总结 ...

- 第六篇 Replication:合并复制-发布

本篇文章是SQL Server Replication系列的第六篇,详细内容请参考原文. 合并复制,类似于事务复制,包括一个发布服务器,一个分发服务器和一个或多个订阅服务器.每一个发布服务器上可以定义 ...

随机推荐

- Spring Boot控制上传文件大小

spring: http: multipart: max-file-size: 5MB max-request-size: 20MB

- Laravel4 最佳学习代码以及资料推荐(转)

https://github.com/andrew13/Laravel-4-Bootstrap-Starter-Site 充分展现了Laravel的强大之处 Laravel虽然上手难度会比其他框架大很 ...

- jumpserver3.0页面配置

一.jumpserver的启动 1 2 Jumpserver的启动和重启 [root@test-vm001 install]# /opt/jumpserver/service.sh start/res ...

- HTMl中Meta标签和meta property=og标签含义

meta是head区的一个辅助性标签.其主要作用有:搜索引擎优化(SEO),定义页面使用语言,自动刷新并指向新的页面,实现网页转换时的动态效果,控制页面缓冲,网页定级评价,控制网页显示的窗口等! me ...

- H5 IOS 虚拟键盘不回落的问题

在 H5 页面中,会发现在高版本的 IOS 系统中(ios12以上)和微信版本6.7.x以上,都会发现 input 等输入框,输入内容之后发现虚拟键盘消失,但是页面出现大面积白框. 解决办法(最后加上 ...

- 案例:forEach和some区别

<!DOCTYPE html> <html lang="en"> <head> <meta charset="UTF-8&quo ...

- 理解EntityFramework两个核心类型的职责 DbSet和D'bContext

DbSet与DbContext是多对一的关系DbSet是实体对象的集合,提供了实现CRUD的相应方法DbContext封装与数据库和数据模型相关的功能,依据数据实体状态创建SQL命令,将数据更改保存到 ...

- 解决码云未配置公钥问题——fatal: Could not read from remote repository.

使用码云,键入“git push -u origin master” ,遇到如下问题: fatal: Could not read from remote repository.(致命:不能读远端仓库 ...

- AtCoder Grand Contest 001F Wide Swap

解法参考这位大佬的:https://www.cnblogs.com/BearChild/p/7895719.html 因为原来的数组不好做于是我们想反过来数组,根据交换条件:值相邻且位置差大于等于k, ...

- vuex之module的使用

一.module的作用 由于使用单一状态树,应用的所有状态会集中到一个比较大的对象.当应用变得非常复杂时,store 对象就有可能变得相当臃肿. 为了解决以上问题,Vuex 允许我们将 store 分 ...