Hive知识

HIVEQL

CREATE DATABASE financials(创建数据库)

SHOW DATABASES(显示数据库)

SHOW TABLES IN 数据库(列出数据库的所有表)

SHOW DATABASES LIKE 'h.*';(显示类似h以后任意多个字符)

LOCATION '/MY/preferred/directory';(指定数据库存放的路径)

COMMENT '**';(添加一个说明表)

DESCRIBE DATABASE financials(显示finacials数据库的一些信息))

DESCRIBE EXTENDEN table(列出表table的详细属性))

WITH DBPROPERTIES(‘*’,‘*’,)(添加注释说明的信息)

USE financials(切换到某个数据库下)

DROP DATABASE financials;(删除数据库)

ALTER DATABASE financials (修改数据库)

外部表:

CREATE EXTERNAL TABLE stocks(创建外部表)

ROW FORMAT DELIMITED FIELDS TERMINATED BY ','

LOCATION '/data/stocks';

分区表:

CREATE TABLE employees()

PARTITIONED BY(country STRING,state STRING);

一种有效减少io量的手段

//显示分区为us的所有字分区

SHOW PARTITIONS employees PARTITION(country='US')

load data语句

LOAD DATA LOCAL INPATH '${env:HOME}/california-employees'

OVERWRITE INTO TABLE employees

PARTITION (country='us',state='CA');

Insert overwrite语句//把一个没有分区的表变成分区的表方式

INSERT OVERWRITE TABLE employees

PARTITION (country=‘us’,state=‘or’)

SELECT * FROM STAGED_employees se

WHERE se.cnty='us' AND se.st='or';

Dynamic Partition inserts动态分区表

INSERT OVERWRITE TABLE employees

PARTITION (country,state)

SELECT ...., se.cty, se.st

FROM staged_employees se

WHERE se.cnty='us';

Create table ...as select...

CREATE TABLE CA_employees

AS SELECT name,salary,address

FROM emplyees

WHERE se.state='CA' ;

导出数据:

INSERT OVERWRITE LOCAL DIRECTORY'/tmp/data'

SELECT name,salary,address

FROM employees

WHERE se.state='CA'

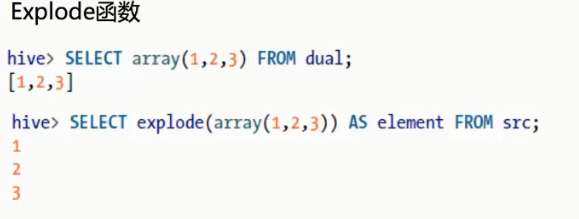

查询语句select

连接操作:

Hiveql支持大部分常见的关系代数连接方式(各种内连接,外连接,半连接)

连接是缓慢的操作

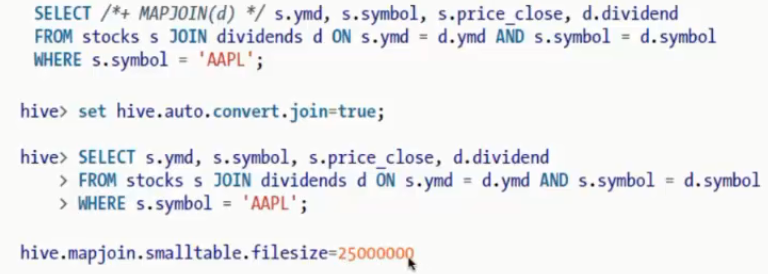

使用map-side joins来优化连接

25000000=25m;

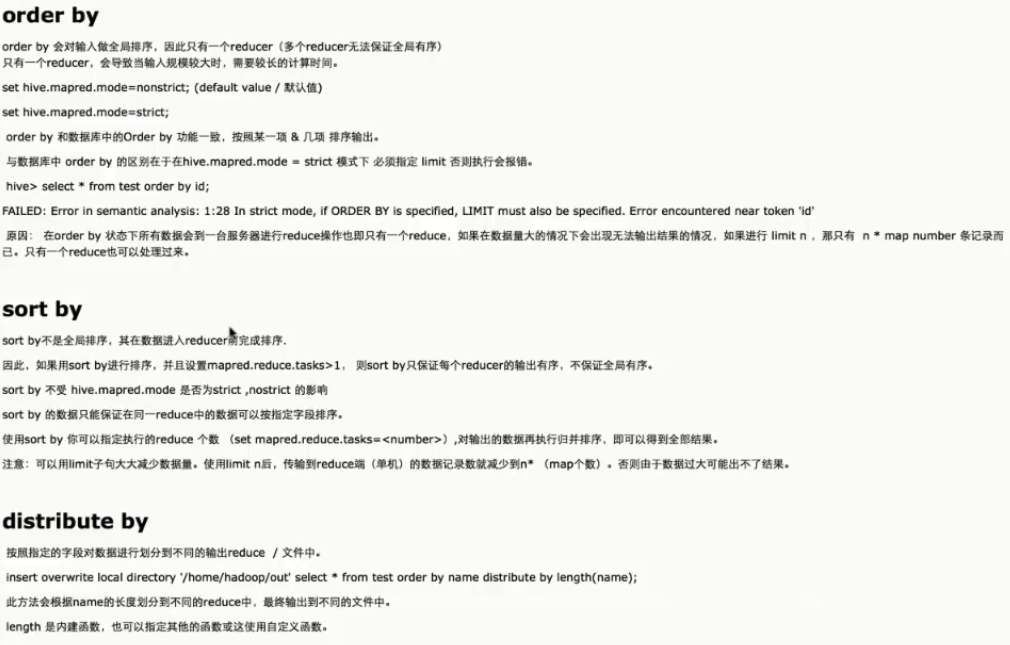

排序:

Hive知识的更多相关文章

- Hive知识汇总

两种Hive表 hive存储:数据+元数据 托管表(内部表) 创建表: hive> create table test2(id int,name String,tel String) > ...

- Hive 体系学习

Hive简介 Hive是一个基于Hadoop的数据仓库工具,可以将结构化的数据文件映射为一张数据库表,并使用HQL作为查询接口.HDFS作为存储底层.MapReduce作为执行层,将HQL语句转换成M ...

- Trino总结

文章目录 1.Trino与Spark SQL的区别分析 2.Trino与Spark SQL解析过程对比 3.Trino基本概念 4.Trino架构 5.Trino SQL执行流程 6.Trino Ta ...

- Hive(一):架构及知识体系

Hive是一个基于Hadoop的数据仓库,最初由Facebook提供,使用HQL作为查询接口.HDFS作为存储底层.mapReduce作为执行层,设计目的是让SQL技能良好,但Java技能较弱的分析师 ...

- 《Programming Hive》读书笔记(两)Hive基础知识

<Programming Hive>读书笔记(两)Hive基础知识 :第一遍读是浏览.建立知识索引,由于有些知识不一定能用到,知道就好.感兴趣的部分能够多研究. 以后用的时候再具体看.并结 ...

- Hive 这些基础知识,你忘记了吗?

Hive 其实是一个客户端,类似于navcat.plsql 这种,不同的是Hive 是读取 HDFS 上的数据,作为离线查询使用,离线就意味着速度很慢,有可能跑一个任务需要几个小时甚至更长时间都有可能 ...

- Hive的基本知识与操作

Hive的基本知识与操作 目录 Hive的基本知识与操作 Hive的基本概念 为什么使用Hive? Hive的特点: Hive的优缺点: Hive应用场景 Hive架构 Client Metastor ...

- Hive基础知识梳理

Hive简介 Hive是什么 Hive是构建在Hadoop之上的数据仓库平台. Hive是一个SQL解析引擎,将SQL转译成MapReduce程序并在Hadoop上运行. Hive是HDFS的一个文件 ...

- Hive基础知识

一.产生背景 1.MapReudce编程繁琐,需要编写大量的代码 2.HDFS中存放的都是文件,在HDFS中没有Scheme的概念,无法用SQL进行快速的查询. 二.Hive的概念 Hive是基于Ha ...

随机推荐

- 【bzoj1787】[Ahoi2008]Meet 紧急集合 倍增LCA

题目描述 输入 输出 样例输入 6 4 1 2 2 3 2 4 4 5 5 6 4 5 6 6 3 1 2 4 4 6 6 6 样例输出 5 2 2 5 4 1 6 0 题解 倍增LCA 首先有集合点 ...

- [UOJ #52]【UR #4】元旦激光炮

题目大意:交互题,给你三个有序数组,长度分别为$n\_a,n\_b,n\_c$,都不超过$10^5$.三个函数$get\_a(i),get\_b(i),get\_c(i)$,分别返回$a_i,b_i, ...

- ARC074 E RGB Sequence DP

---题面--- 题解: 首先,有一个不太直观的状态,f[i][j][k][l]表示DP到i位,三种颜色最后出现的位置分别是j, k, l的方案数.因为知道了三种颜色最后出现的位置,因此也可以得知以当 ...

- Java操作Redis存储对象类型数据

背景描述 关于JAVA去操作Redis时,如何存储一个对象的数据,大家是非常关心的问题,虽然官方提供了存储String,List,Set等等类型,但并不满足我们现在实际应用.存储一个对象是是 ...

- 安徽师大附中%你赛day7 T2 乘积 解题报告

乘积 题目背景 \(\mathrm{Smart}\) 最近在潜心研究数学, 他发现了一类很有趣的数字, 叫做无平方因子数. 也就是这一类数字不能够被任意一个质数的平方整除, 比如\(6\).\(7\) ...

- 【2017.12.22.A】

A 题面: 给一个n个点m条边的无向图,你可以选择一个点作为起点,然后沿着图中的边开始走,走的过程中,同一条边不能经过两次(相反的方向也不行). ...

- JavaScript词法作用域与调用对象

关于 Javascript 的函数作用域.调用对象和闭包之间的关系很微妙,关于它们的文章已经有很多,但不知道为什么很多新手都难以理解.我就尝试用比较通俗的语言来表达我自己的理解吧. 作用域 Scope ...

- [hdu 6069]素数筛+区间质因数分解

给[L,R]区间的每一个数都质因数分解的复杂度可以达到(R-L)logR,真的涨姿势…… 另外,质因数分解有很重要的一点,就是只需要打sqrt(R)以内的素数表就够了……因为超过sqrt(R)的至多只 ...

- Tumblr:150亿月浏览量背后的架构挑战

Tumblr:150亿月浏览量背后的架构挑战 2013/04/08 · IT技术, 开发 · 9.9K 阅读 · HBase, Tumblr, 架构 英文原文:High Scalability,编译: ...

- c++ fstream用法

今天介绍一个复制 粘贴的函数,用fstream实现 #include "stdafx.h" #include<iostream> #include<fstream ...