Layer Normalization和Batch Normalization

Layer Normalization

总览

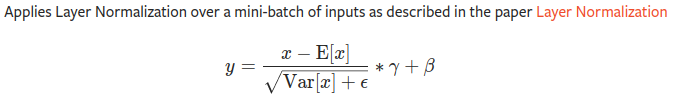

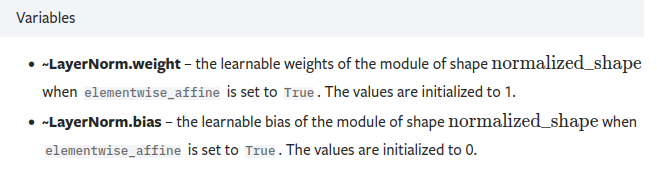

- 针对同一通道数的图片的H*W进行层正则化,后面的γ和β是可以学习的参数,其中这两个的维度和最后一个的维度相同

- 例如特征图矩阵维度为[3, 577, 768], 那么γ和β的维度均为Tensor(768,)

step1:代码示例1

import torch

import torch.nn as nn

input = torch.tensor(

[

[

[

[2., 2.],

[3., 3.]

],

[

[3., 3.],

[2., 2.]

]

],

[

[

[2., 2.],

[3., 3.]

],

[

[3., 3.],

[2., 2.]

]

]

]

)

print(input)

print(input.shape) # torch.Size([2, 2, 2, 2])

layer_norm = nn.LayerNorm([2, 2, 2, 2], elementwise_affine=True)

output = layer_norm(input)

print(output)

"""

tensor([[[[-1.0000, -1.0000],

[ 1.0000, 1.0000]],

[[ 1.0000, 1.0000],

[-1.0000, -1.0000]]],

[[[-1.0000, -1.0000],

[ 1.0000, 1.0000]],

[[ 1.0000, 1.0000],

[-1.0000, -1.0000]]]], grad_fn=<NativeLayerNormBackward>)

"""

# 总结

"""

根据公式

E(x) = ((2+2+3+3)*4)/16 = 2.5

Var(x) = {(2-2.5)**2 * 8 + (3-2.5)**2 * 8} / 16 = 0.5**2

带入公式可以得到:

y = (x - E(x)) / (var(x)**0.5)

可以得到output

"""

step2更改输入观察输出

import torch

import torch.nn as nn

input = torch.tensor(

[

[

[

[3., 2.], # 这里将2 变成 3进行观察输出

[3., 3.]

],

[

[3., 3.],

[2., 2.]

]

],

[

[

[2., 2.],

[3., 3.]

],

[

[3., 3.],

[2., 2.]

]

]

]

)

print(input)

print(input.shape) # torch.Size([2, 2, 2, 2])

layer_norm = nn.LayerNorm([2, 2, 2, 2], elementwise_affine=True)

output = layer_norm(input)

print(output)

"""

tensor([[[[ 0.8819, -1.1339],

[ 0.8819, 0.8819]],

[[ 0.8819, 0.8819],

[-1.1339, -1.1339]]],

[[[-1.1339, -1.1339],

[ 0.8819, 0.8819]],

[[ 0.8819, 0.8819],

[-1.1339, -1.1339]]]], grad_fn=<NativeLayerNormBackward>)

"""

# 总结

"""

由上述的公式可得,输入变化,整个输出都进行了改变

"""

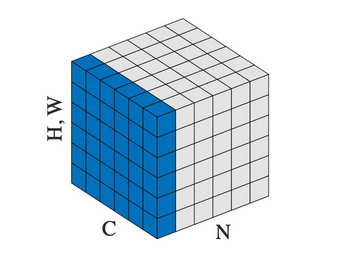

Batch Normalization

- 计算公式同上, 这里他的可学习参数与in_channel同

step1:代码示例1:

import torch

import torch.nn as nn

# With Learnable Parameters

m = nn.BatchNorm2d(2)

input = torch.tensor(

[

[

[

[2., 2.],

[3., 3.]

],

[

[3., 3.],

[2., 2.]

]

],

[

[

[2., 2.],

[3., 3.]

],

[

[3., 3.],

[2., 2.]

]

]

]

)

print(input)

print(input.shape) # torch.Size([2, 2, 2, 2])

output = m(input)

print(output)

"""

tensor([[[[-1.0000, -1.0000],

[ 1.0000, 1.0000]],

[[ 1.0000, 1.0000],

[-1.0000, -1.0000]]],

[[[-1.0000, -1.0000],

[ 1.0000, 1.0000]],

[[ 1.0000, 1.0000],

[-1.0000, -1.0000]]]], grad_fn=<NativeBatchNormBackward>)

"""

# 总结:

"""

计算的是某个批次的正则

根据公式 以第一个批次为例:

E(x) = {2+2+3+3+2+2+3+3}/8 = 2.5

Var(x) = {(2-2.5)**2 * 4 + (3-2.5)**2 * 4}/8 = 0.5**2

带入公式可以得到:

y = (x - E(x)) / (var(x)**0.5)

可以得到output

"""

进行微小更改观察变化

import torch

import torch.nn as nn

# With Learnable Parameters

m = nn.BatchNorm2d(2)

input = torch.tensor(

[

[

[

[3., 2.], # 这里2变成3来观察变化

[3., 3.]

],

[

[3., 3.],

[2., 2.]

]

],

[

[

[2., 2.],

[3., 3.]

],

[

[3., 3.],

[2., 2.]

]

]

]

)

print(input)

print(input.shape) # torch.Size([2, 2, 2, 2])

output = m(input)

print(output)

"""

tensor([[[[ 0.7746, -1.2910],

[ 0.7746, 0.7746]],

[[ 1.0000, 1.0000],

[-1.0000, -1.0000]]],

[[[-1.2910, -1.2910],

[ 0.7746, 0.7746]],

[[ 1.0000, 1.0000],

[-1.0000, -1.0000]]]], grad_fn=<NativeBatchNormBackward>)

"""

# 总结:

"""

进行微小更改观察到,发生变化的是他同一批次里面的

"""

参考

Layer Normalization和Batch Normalization的更多相关文章

- 深度学习之Batch Normalization

在机器学习领域中,有一个重要的假设:独立同分布假设,也就是假设训练数据和测试数据是满足相同分布的,否则在训练集上学习到的模型在测试集上的表现会比较差.而在深层神经网络的训练中,当中间神经层的前一层参数 ...

- tensorflow中使用Batch Normalization

在深度学习中为了提高训练速度,经常会使用一些正正则化方法,如L2.dropout,后来Sergey Ioffe 等人提出Batch Normalization方法,可以防止数据分布的变化,影响神经网络 ...

- 深度学习基础系列(七)| Batch Normalization

Batch Normalization(批量标准化,简称BN)是近些年来深度学习优化中一个重要的手段.BN能带来如下优点: 加速训练过程: 可以使用较大的学习率: 允许在深层网络中使用sigmoid这 ...

- Deep Learning 27:Batch normalization理解——读论文“Batch normalization: Accelerating deep network training by reducing internal covariate shift ”——ICML 2015

这篇经典论文,甚至可以说是2015年最牛的一篇论文,早就有很多人解读,不需要自己着摸,但是看了论文原文Batch normalization: Accelerating deep network tr ...

- 解开Batch Normalization的神秘面纱

停更博客好长一段时间了,其实并不是没写了,而是转而做笔记了,但是发现做笔记其实印象无法更深刻,因此决定继续以写博客来记录或者复习巩固所学的知识,与此同时跟大家分享下自己对深度学习或者机器学习相关的知识 ...

- 激活函数,Batch Normalization和Dropout

神经网络中还有一些激活函数,池化函数,正则化和归一化函数等.需要详细看看,啃一啃吧.. 1. 激活函数 1.1 激活函数作用 在生物的神经传导中,神经元接受多个神经的输入电位,当电位超过一定值时,该神 ...

- Batch Normalization、Layer Normalization、Instance Normalization、Group Normalization、Switchable Normalization比较

深度神经网络难训练一个重要的原因就是深度神经网络涉及很多层的叠加,每一层的参数变化都会导致下一层输入数据分布的变化,随着层数的增加,高层输入数据分布变化会非常剧烈,这就使得高层需要不断适应低层的参数更 ...

- Batch Normalization和Layer Normalization

Batch Normalization:对一个mini batch的样本,经过一个nueron(或filter)后生成的feature map中的所有point进行归一化.(纵向归一化) Layer ...

- 从Bayesian角度浅析Batch Normalization

前置阅读:http://blog.csdn.net/happynear/article/details/44238541——Batch Norm阅读笔记与实现 前置阅读:http://www.zhih ...

随机推荐

- 一个模仿微信群聊的H5页面

开始 上半年小米Max发布的时候,做了一个在朋友圈传播的模仿微信的群聊界面H5页面:一群公司的大咖在群里聊小米Max,用户可以向大咖们提问,以此了解产品. 页面的主体是群聊对话,同时在对话中包含了很多 ...

- 用CSS实现Tab页切换效果

用CSS实现Tab切换效果 最近切一个页面的时候涉及到了一个tab切换的部分,因为不想用js想着能不能用纯CSS的选择器来实现切换效果.搜了一下大致有下面三种写法. 利用:hover选择器 缺点:只有 ...

- Java中重载的应用

学习目标: 掌握Java方法的重载 学习内容: 1.重载定义 参数列表: 参数的类型 + 参数的个数 + 参数的顺序 方法签名: 方法名称 + 方法参数列表,在同一个类中,方法签名是唯一的,否则编译报 ...

- jQuery实现数字时钟

运行效果: 源代码: 1 <!DOCTYPE html> 2 <html lang="zh"> 3 <head> 4 <meta char ...

- 升级DLL plugin 到AutoDllPlugin

为了使打包构建速度加快使用的DLLPlugin,但是我们还是需要手动把dll文件引入文件, HTMLwebpackplugin 结合autoDLLplugin可以自动引入打包文件, 十份地方便

- Spring-级联赋值

一.级联赋值第一种方法 1.创建Emp类 package com.bean; public class Emp { private String EName; private String gende ...

- switch 用法

1.语法格式和规则 switch case 语句语法格式如下: switch(expression){ case value : //语句 break; //可选 case value : //语句 ...

- windows安装rabbitmq踩坑实录

最近学习springcloud消息总线需要用到rabbitmq,然后安装的时候踩了一些坑,记录如下: 首先安装rabbitmq之前需要先安装erlang,因为rabbitmq服务端使用erlang写的 ...

- js实时监听dom尺寸变化

开发过程中总会遇到dom节点尺寸变化,去做一些相应的逻辑,第一想到的应该是用$(window).resize()去做,但是这个是监听浏览器窗口的所以这个时候要用 ResizeObserver Resi ...

- 开源框架YiShaAdmin如何使用任务计划

1.在Startup添加 new JobCenter().Start();(红色字体,下同) // This method gets called by the runtime. Use this m ...