Hive 基本语法操练(三):分区操作和桶操作

(一)分区操作

Hive 的分区通过在创建表时启动 PARTITION BY 实现,用来分区的维度并不是实际数据的某一列,具体分区的标志是由插入内容时给定的。当要查询某一分区的内容时可以采用 WHERE 语句, 例如使用 “WHERE tablename.partition_key>a” 创建含分区的表。创建分区语法如下。

CREATE TABLE table_name(

...

)

PARTITION BY (dt STRING,country STRING)

1、 创建分区

Hive 中创建分区表没有什么复杂的分区类型(范围分区、列表分区、hash 分区,混合分区等)。分区列也不是表中的一个实际的字段,而是一个或者多个伪列。意思是说,在表的数据文件中实际并不保存分区列的信息与数据。

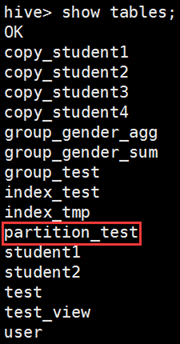

创建一个简单的分区表。

hive> create table partition_test(member_id string,name string) partitioned by (stat_date string,province string) row format delimited fields terminated by ',';

这个例子中创建了 stat_date 和 province 两个字段作为分区列。通常情况下需要预先创建好分区,然后才能使用该分区。例如:

hive> alter table partition_test add partition (stat_date='2015-01-18',province='beijing');

这样就创建了一个分区。这时会看到 Hive 在HDFS 存储中创建了一个相应的文件夹。

$ hadoop fs -ls /user/hive/warehouse/partition_test/stat_date=2018-05-18 18/05/18 18:18:26 WARN util.NativeCodeLoader: Unable to load native-hadoop library for your platform... using builtin-java classes where applicable Found 1 items drwxr-xr-x - hadoop supergroup 0 2018-05-18 18:10

/user/hive/warehouse/partition_test/stat_date=2018-05-18/province=beijing----显示刚刚创建的分区

每一个分区都会有一个独立的文件夹,在上面例子中,stat_date 是主层次,province 是 副层次。

2、 插入数据

使用一个辅助的非分区表 partition_test_input 准备向 partition_test 中插入数据,实现步骤如下。

1) 查看 partition_test_input 表的结构,命令如下。

hive> desc partition_test_input;

2) 查看 partition_test_input 的数据,命令如下。

hive> select * from partition_test_input;

OK

member_id string

name string

stat_date string

province string

# Partition Information

# col_name data_type comment

stat_date string

province string

Time taken: 0.142 seconds, Fetched: 10 row(s)

3) 向 partition_test 的分区中插入数据,命令如下。

insert overwrite table partition_test partition(stat_date='2015-01-18',province='jiangsu') select member_id,name from partition_test_input where stat_date='2015-01-18' and province='jiangsu';

Query ID = hadoop_20180518182626_53ea7084-acb5-421f-ae66-4f3e2898cc2a

Total jobs = 3

Launching Job 1 out of 3

Number of reduce tasks is set to 0 since there's no reduce operator

Starting Job = job_1526636465246_0001, Tracking URL = http://master:8088/proxy/application_1526636465246_0001/

Kill Command = /opt/modules/hadoop-2.6.0/bin/hadoop job -kill job_1526636465246_0001

Hadoop job information for Stage-1: number of mappers: 1; number of reducers: 0

2018-05-18 18:26:23,547 Stage-1 map = 0%, reduce = 0%

2018-05-18 18:26:33,030 Stage-1 map = 100%, reduce = 0%, Cumulative CPU 1.98 sec

MapReduce Total cumulative CPU time: 1 seconds 980 msec

Ended Job = job_1526636465246_0001

Stage-4 is selected by condition resolver.

Stage-3 is filtered out by condition resolver.

Stage-5 is filtered out by condition resolver.

Moving data to: hdfs://ns/tmp/hive/hadoop/ed837b62-1bd7-4569-96ea-637844deb0cb/hive_2018-05-18_18-26-08_605_2975853227273346012-1/-ext-10000

Loading data to table default.partition_test partition (stat_date=2018-05-21, province=sichuan)

Partition default.partition_test{stat_date=2018-05-21, province=sichuan} stats: [numFiles=1, numRows=0, totalSize=0, rawDataSize=0]

MapReduce Jobs Launched:

Stage-Stage-1: Map: 1 Cumulative CPU: 1.98 sec HDFS Read: 290 HDFS Write: 86 SUCCESS

Total MapReduce CPU Time Spent: 1 seconds 980 msec

OK

Time taken: 26.543 seconds

向多个分区插入数据,命令如下。

hive> from partition_test_input

insert overwrite table partition_test partition(stat_date='2015-01-18',province='jiangsu') select member_id,name from partition_test_input where stat_date='2015-01-18' and province='jiangsu'

insert overwrite table partition_test partition(stat_date='2015-01-28',province='sichuan') select member_id,name from partition_test_input where stat_date='2015-01-28' and province='sichuan'

insert overwrite table partition_test partition(stat_date='2015-01-28',province='beijing') select member_id,name from partition_test_input where stat_date='2015-01-28' and province='beijing';

3、 动态分区

按照上面的方法向分区表中插入数据,如果数据源很大,针对一个分区就要写一个 insert ,非常麻烦。使用动态分区可以很好地解决上述问题。动态分区可以根据查询得到的数据自动匹配到相应的分区中去。

动态分区可以通过下面的设置来打开:

set hive.exec.dynamic.partition=true;

set hive.exec.dynamic.partition.mode=nonstrict;

动态分区的使用方法很简单,假设向 stat_date='2015-01-18' 这个分区下插入数据,至于 province 插到哪个子分区下让数据库自己来判断。stat_date 叫做静态分区列,province 叫做动态分区列。

hive> insert overwrite table partition_test partition(stat_date='2015-01-18',province)

select member_id,name province from partition_test_input where stat_date='2015-01-18';

hive.exec.max.dynamic.partitions.pernode:每一个 MapReduce Job 允许创建的分区的最大数量,如果超过这个数量就会报错(默认值100)。

hive.exec.max.dynamic.partitions:一个 dml 语句允许创建的所有分区的最大数量(默认值100)。

hive.exec.max.created.files:所有 MapReduce Job 允许创建的文件的最大数量(默认值10000)。

尽量让分区列的值相同的数据在同一个 MapReduce 中,这样每一个 MapReduce 可以尽量少地产生新的文件夹,可以通过 DISTRIBUTE BY 将分区列值相同的数据放到一起,命令如下。

hive> insert overwrite table partition_test partition(stat_date,province)

select memeber_id,name,stat_date,province from partition_test_input distribute by stat_date,province;

(二)桶操作

Hive 中 table 可以拆分成 Partition table 和 桶(BUCKET),桶操作是通过 Partition 的 CLUSTERED BY 实现的,BUCKET 中的数据可以通过 SORT BY 排序。

BUCKET 主要作用如下。

1)数据 sampling;

2)提升某些查询操作效率,例如 Map-Side Join。

需要特别主要的是,CLUSTERED BY 和 SORT BY 不会影响数据的导入,这意味着,用户必须自己负责数据的导入,包括数据额分桶和排序。 'set hive.enforce.bucketing=true' 可以自动控制上一轮 Reduce 的数量从而适配 BUCKET 的个数,当然,用户也可以自主设置 mapred.reduce.tasks 去适配 BUCKET 个数,推荐使用:

hive> set hive.enforce.bucketing=true;

操作示例如下。

1) 创建临时表 student_tmp,并导入数据。

hive> desc student_tmp;

hive> select * from student_tmp;

2) 创建 student 表。

hive> create table student(id int,age int,name string)

partitioned by (stat_date string)

clustered by (id) sorted by(age) into bucket

row format delimited fields terminated by ',';

3) 设置环境变量。

hive> set hive.enforce.bucketing=true;

4) 插入数据。

hive> from student_tmp

insert overwrite table student partition(stat_date='2015-01-19')

select id,age,name where stat_date='2015-01-18' sort by age;

5) 查看文件目录。

$ hadoop fs -ls /usr/hive/warehouse/student/stat_date=--/

6) 查看 sampling 数据。

hive> select * from student tablesample(bucket out of on id);

tablesample 是抽样语句,语法如下。

tablesample(bucket x out of y)

y 必须是 table 中 BUCKET 总数的倍数或者因子。

以上就是博主为大家介绍的这一板块的主要内容,这都是博主自己的学习过程,希望能给大家带来一定的指导作用,有用的还望大家点个支持,如果对你没用也望包涵,有错误烦请指出。如有期待可关注博主以第一时间获取更新哦,谢谢!

版权声明:本文为博主原创文章,未经博主允许不得转载。

Hive 基本语法操练(三):分区操作和桶操作的更多相关文章

- Hive基本语法操练

建表规则如下: CREATE [EXTERNAL] TABLE [IF NOT EXISTS] table_name [(col_name data_type [COMMENT col_comment ...

- Hive 基本语法操练(五):Hive 的 JOIN 用法

Hive 的 JOIN 用法 hive只支持等连接,外连接,左半连接.hive不支持非相等的join条件(通过其他方式实现,如left outer join),因为它很难在map/reduce中实现这 ...

- Hive 基本语法操练(六):Hive 的权限控制

Hive 的权限控制 Hive从0.10可以通过元数据控制权限.但是Hive的权限控制并不是完全安全的.基本的授权方案的目的是防止用户不小心做了不合适的事情. 为了使用Hive的授权机制,有两个参数必 ...

- Hive 基本语法操练(四):Hive 复合类型

hive语法中主要提供了以下复合数据类型: 1)Structs: structs内部的数据可以通过DOT(.)来存取.例如,表中一列c的类型为STRUCT{a INT; b INT},我们可以通过c. ...

- Hive 基本语法操练(一):表操作

Hive 和 Mysql 的表操作语句类似,如果熟悉 Mysql,学习Hive 的表操作就非常容易了,下面对 Hive 的表操作进行深入讲解. **(1)先来创建一个表名为student的内部表** ...

- Hive 基本语法操练(二):视图和索引操作

1. 视图操作 ------- 1) 创建一个测试表. ``` hive> create table test(id int,name string); OK Time taken: 0.385 ...

- Hive SQL 语法学习与实践

Hive 介绍 Hive 是基于Hadoop 构建的一套数据仓库分析系统,它提供了丰富的SQL查询方式来分析存储在Hadoop 分布式文件系统中的数据,可以将结构化的数据文件映射为一张数据库表,并提供 ...

- Hive之分区(Partitions)和桶(Buckets)

转自:http://www.aahyhaa.com/archives/316 hive引入partition和bucket的概念,中文翻译分别为分区和桶(我觉的不是很合适,但是网上基本都是这么翻译,暂 ...

- 006-Hadoop Hive sql语法详解1-数据结构和Hive表建立

1.认识hive: Hive 是基于Hadoop 构建的一套数据仓库分析系统,它提供了丰富的SQL查询方式来分析存储在Hadoop 分布式文件系统中的数据,可以将结构化的数据文件映射为一张数据库表, ...

随机推荐

- jQuery做出手风琴效果

今天学到JQuery中的遍历-siblings,便手痒做了个手风琴的动态效果,有一点收获,分享给大家.mouseout的时候一定要记得opacity必须设置,不然li的opacity会保持mousem ...

- 2.Apache + Tomcat + mod_jk实现集群服务

转自:http://www.cnblogs.com/dennisit/p/3370220.html Tomcat中的集群原理是通过组播的方式进行节点的查找并使用TCP连接进行会话的复制. 实现效果:用 ...

- WSGI 简介(使用python描述)

WSGI 简介 背景 Python Web 开发中,服务端程序可以分为两个部分,一是服务器程序,二是应用程序.前者负责把客户端请求接收,整理,后者负责具体的逻辑处理.为了方便应用程序的开发,我们把常用 ...

- C#调用ODBC连接SQL Server数据库的存储过程

OdbcConnection con = new OdbcConnection("Driver={SQL Server};server=PC-200201070359;uid=sa;pwd= ...

- 关于C/C++中的“auto”关键字

C/C++ 98标准 C++03标准 早在C++98标准中就存在了auto关键字,那时的auto用于声明变量为自动变量,自动变量意为拥有自动的生命期.此用法是多余的,因为即使定义变量时不加" ...

- Git删除master branch中最近一次的提交

在做一个项目的过程中,需要删除master brach中最近一次的提交,需要在Git repository中删除 采用步骤如下: 1. 在Visual Studio中打开项目,进入到master br ...

- hdu1078

#include <stdio.h> #include <string.h> #include <algorithm> using namespace std; i ...

- 【mybatis 的foreach的用法】

foreach一共有三种类型,分别为List,[](array),Map三种. foreach属性 属性 描述 item 循环体中的具体对象.支持属性的点路径访问,如item.age,item.inf ...

- Software - 创建程序打包项目

通常的步骤 准备一个 Visual Studio Installer 的项目模板 利用该模板,在解决方案中新建一个 Visual Studio Installer 项目 设置项目属性,配置文件系统 生 ...

- PAT1089【归并排序】

这题略...恶心.. 他说归并排序依次是相邻有序两块合并,而一向打惯了递归??? #include <bits/stdc++.h> using namespace std; typedef ...