ELK5.X+logback搭建日志平台

一、背景

当生产环境web服务器做了负载集群后,查询每个tomcat下的日志无疑是一件麻烦的事,elk为我们提供了快速查看日志的方法。

二、环境

CentOS7、JDK8、这里使用了ELK5.0.0(即:Elasticsearch-5.0.0、Logstash-5.0.0、kibana-5.0.0),安装ElasticSearch6.2.0也是一样的步骤,已亲测。

三、注意

1. 安装ELK一定要JDK8或者以上版本。

2. 关闭防火墙:systemctl stop firewalld.service

3. 启动elasticsearch,一定不能用root用户,需要重新创建一个用户,因为elasticsearch会验证安全。

4.官网历史版本下载:https://www.elastic.co/downloads/past-releases

四、Elasticsearch安装

1. 用root登录centos,创建elk组,并且将elk用户添加到elk组中,然后创建elk用户的密码

[root@iZuf6a50pk1lwxxkn0qr6tZ ~]# groupadd elk

[root@iZuf6a50pk1lwxxkn0qr6tZ ~]# useradd -g elk elk

[root@iZuf6a50pk1lwxxkn0qr6tZ ~]# passwd elk

更改用户 elk 的密码 。

新的 密码:

重新输入新的 密码:

passwd:所有的身份验证令牌已经成功更新。

2.进入/usr/local目录,创建elk目录,并将该目录的使用权赋给elk用户。下载elasticsearch,可以从官网下载,也可以直接使用wget下载,这里使用wget下载

cd /usr/local

mkdir elk

chown -R elk:elk /usr/local/elk # 授权

cd elk

wget https://artifacts.elastic.co/downloads/elasticsearch/elasticsearch-5.0.0.tar.gz

解压elasticsearch:tar -zxvf elasticsearch-5.0.0.tar.gz

3.使用root用户,进入/usr/local/elk/elasticsearch-5.0.0/config目录,编辑 elasticsearch.yml ,修改以下参数:

cluster.name: nmtx-cluster # 在集群中的名字

node.name: node-1 # 节点的名字

path.data: /data/elk/elasticsearch-data # es数据保存的目录

path.logs: /data/elk/elasticsearch-logs # es日志保存的目录

network.host: 0.0.0.0

http.port: 9200 # 开放的端口

将data/elk目录的使用权限 赋予 elk用户:

chown -R elk:elk /data/elk

4.使用root用户,修改/etc/sysctl.conf 配置文件,在最后一行添加:vm.max_map_count=262144, 然后使其生效:sysctl -p /etc/sysctl.conf。如果不配置这一个的话,启动es会报如下错误:

max virtual memory areas vm.max_map_count [65530] is too low, increase to at least [262144]

5.使用root用户,修改/etc/security/limits.conf文件,添加或修改如下行:

* soft nproc 65536

* hard nproc 65536

* soft nofile 65536

* hard nofile 65536

如果不配置,会报如下错误:

max file descriptors [4096] for elasticsearch process is too low, increase to at least [65536]

6.切换到elk用户,启动es(直接后台启动了,加上 -d 即为后台启动,配置完4、5步骤基本不会出什么问题了),

/usr/local/elk/elasticsearch-5.0.0/bin/elasticsearch -d

7.验证是否启动成功,输入以下命令:

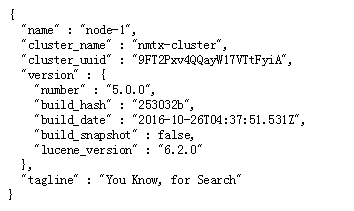

curl -XGET 'localhost:9200/?pretty'

当看到如下时,即为启动成功:

{

"name" : "node-1",

"cluster_name" : "nmtx-cluster",

"cluster_uuid" : "WdX1nqBPQJCPQniObzbUiQ",

"version" : {

"number" : "5.0.0",

"build_hash" : "253032b",

"build_date" : "2016-10-26T04:37:51.531Z",

"build_snapshot" : false,

"lucene_version" : "6.2.0"

},

"tagline" : "You Know, for Search"

}

或者使用浏览器访问:192.168.1.66:9200

但是6版本集成了x-pack插件,可能会出现如下:

[elk@localhost bin]$ curl -XGET 'localhost:9200/?pretty'

{

"error" : {

"root_cause" : [

{

"type" : "security_exception",

"reason" : "missing authentication token for REST request [/?pretty]",

"header" : {

"WWW-Authenticate" : "Basic realm=\"security\" charset=\"UTF-8\""

}

}

],

"type" : "security_exception",

"reason" : "missing authentication token for REST request [/?pretty]",

"header" : {

"WWW-Authenticate" : "Basic realm=\"security\" charset=\"UTF-8\""

}

},

"status" :

}

需要加上用户名密码,如下:

[elk@localhost bin]$ curl --user elastic:changeme -XGET 'localhost:9200/_cat/health?v&pretty'

epoch timestamp cluster status node.total node.data shards pri relo init unassign pending_tasks max_task_wait_time active_shards_percent

:: my-application green - 100.0%

五、Logstash安装

1.下载logstash5.0.0,也是使用 wget下载,解压logstash

cd /usr/local/elk

wget https://artifacts.elastic.co/downloads/logstash/logstash-5.0.0.tar.gz

tar -zxvf logstash-5.0.0.tar.gz

2.编辑 usr/local/elk/logstash-5.0.0/config/logstash.conf 文件,这是一个新创建的文件,在文件中添加如下内容:

input {

tcp {

port => 4567

mode => "server"

codec => json_lines

}

}

filter {

}

output {

elasticsearch {

hosts => ["192.168.1.66:9200"]

cluster => nmtx-cluster

index => "operation-%{+YYYY.MM.dd}"

}

stdout {

codec => rubydebug

}

}

logstash的配置文件须包含三个内容:

- input{}:此模块是负责收集日志,可以从文件读取、从redis读取 或者 开启端口让产生日志的业务系统直接写入到logstash,这里使用的是:开启端口让产生日志的业务系统直接写入到logstash

- filter{}:此模块是负责过滤收集到的日志,并根据过滤后对日志定义显示字段

- output{}:此模块是负责将过滤后的日志输出到elasticsearch或者文件、redis等,生产环境中可以将 stdout 移除掉,防止在控制台上打印日志。

3.启动logstash,先不以后台方式启动,为了看logstash是否可以启动成功

/usr/local/elk/logstash-5.0.0/bin/logstash -f /usr/local/elk/logstash-5.0.0/config/logstash.conf

当看到控制台上出现如下内容时,即为启动成功:

Sending Logstash logs to /elk/logstash-5.0.0/logs which is now configured via log4j2.properties.

[2018-03-11T12:12:14,588][INFO ][logstash.inputs.tcp ] Starting tcp input listener {:address=>"0.0.0.0:4567"}

[2018-03-11T12:12:14,892][INFO ][logstash.outputs.elasticsearch] Elasticsearch pool URLs updated {:changes=>{:removed=>[], :added=>["http://localhost:9200"]}}

[2018-03-11T12:12:14,894][INFO ][logstash.outputs.elasticsearch] Using mapping template from {:path=>nil}

[2018-03-11T12:12:15,425][INFO ][logstash.outputs.elasticsearch] Attempting to install template {:manage_template=>{"template"=>"logstash-*", "version"=>50001, "settings"=>{"index.refresh_interval"=>"5s"}, "mappings"=>{"_default_"=>{"_all"=>{"enabled"=>true, "norms"=>false}, "dynamic_templates"=>[{"message_field"=>{"path_match"=>"message", "match_mapping_type"=>"string", "mapping"=>{"type"=>"text", "norms"=>false}}}, {"string_fields"=>{"match"=>"*", "match_mapping_type"=>"string", "mapping"=>{"type"=>"text", "norms"=>false, "fields"=>{"keyword"=>{"type"=>"keyword"}}}}}], "properties"=>{"@timestamp"=>{"type"=>"date", "include_in_all"=>false}, "@version"=>{"type"=>"keyword", "include_in_all"=>false}, "geoip"=>{"dynamic"=>true, "properties"=>{"ip"=>{"type"=>"ip"}, "location"=>{"type"=>"geo_point"}, "latitude"=>{"type"=>"half_float"}, "longitude"=>{"type"=>"half_float"}}}}}}}}

[2018-03-11T12:12:15,445][INFO ][logstash.outputs.elasticsearch] Installing elasticsearch template to _template/logstash

[2018-03-11T12:12:15,729][INFO ][logstash.outputs.elasticsearch] New Elasticsearch output {:class=>"LogStash::Outputs::ElasticSearch", :hosts=>["localhost:9200"]}

[2018-03-11T12:12:15,732][INFO ][logstash.pipeline ] Starting pipeline {"id"=>"main", "pipeline.workers"=>4, "pipeline.batch.size"=>125, "pipeline.batch.delay"=>5, "pipeline.max_inflight"=>500}

[2018-03-11T12:12:15,735][INFO ][logstash.pipeline ] Pipeline main started

[2018-03-11T12:12:15,768][INFO ][logstash.agent ] Successfully started Logstash API endpoint {:port=>9600}

Ctrl+C,关闭logstash,然后 后台启动:

nohup /usr/local/elk/logstash-5.0.0/bin/logstash -f /usr/local/elk/logstash-5.0.0/config/logstash.conf > /data/elk/logstash-log.file 2>&1 &

六、Kibana安装

1.下载并解压Kibana,wget下载:

cd /usr/local/elk

wget https://artifacts.elastic.co/downloads/kibana/kibana-5.0.0-linux-x86_64.tar.gz

tar zxvf kibana-5.0.0-linux-x86_64.tar.gz

2.修改/usr/local/elk/kibana-5.0.0-linux-x86_64/config/kibana.yml文件,修改内容如下:

server.port: 5601

server.host: "192.168.1.66"

elasticsearch.url: "http://192.168.1.66:9200"

kibana.index: ".kibana"

3.启动Kibana,后台启动:

nohup /elk/kibana-5.0.0-linux-x86_64/bin/kibana > /data/elk/kibana-log.file 2>&1 &

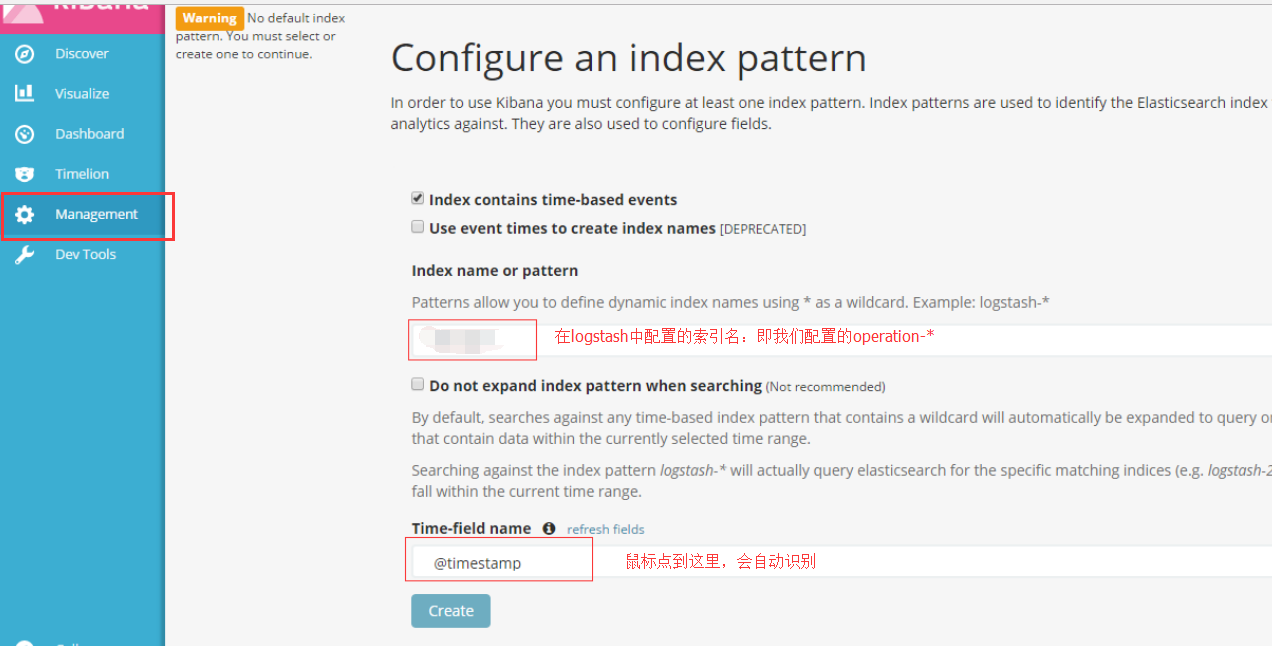

4.浏览器访问:x.x.x.x:5601,然后配置索引匹配,如下:

七、使用logback向logstash中写入日志

1.新建一个SpringBoot工程,引入 logstash需要的jar包依赖:

<!-- logstash -->

<dependency>

<groupId>net.logstash.logback</groupId>

<artifactId>logstash-logback-encoder</artifactId>

<version>4.11</version>

</dependency>

2.添加 logback.xml 文件,内容如下:

<!-- Logback configuration. See http://logback.qos.ch/manual/index.html -->

<configuration scan="true" scanPeriod="10 seconds">

<include resource="org/springframework/boot/logging/logback/base.xml" /> <appender name="INFO_FILE" class="ch.qos.logback.core.rolling.RollingFileAppender">

<File>${LOG_PATH}/info.log</File>

<rollingPolicy class="ch.qos.logback.core.rolling.TimeBasedRollingPolicy">

<fileNamePattern>${LOG_PATH}/info-%d{yyyyMMdd}.log.%i</fileNamePattern>

<timeBasedFileNamingAndTriggeringPolicy class="ch.qos.logback.core.rolling.SizeAndTimeBasedFNATP">

<maxFileSize>500MB</maxFileSize>

</timeBasedFileNamingAndTriggeringPolicy>

<maxHistory>2</maxHistory>

</rollingPolicy>

<layout class="ch.qos.logback.classic.PatternLayout">

<Pattern>%d{yyyy-MM-dd HH:mm:ss.SSS} [%thread] %-5level %logger{36} -%msg%n

</Pattern>

</layout>

</appender> <appender name="ERROR_FILE" class="ch.qos.logback.core.rolling.RollingFileAppender">

<filter class="ch.qos.logback.classic.filter.ThresholdFilter">

<level>ERROR</level>

</filter>

<File>${LOG_PATH}/error.log</File>

<rollingPolicy class="ch.qos.logback.core.rolling.TimeBasedRollingPolicy">

<fileNamePattern>${LOG_PATH}/error-%d{yyyyMMdd}.log.%i

</fileNamePattern>

<timeBasedFileNamingAndTriggeringPolicy class="ch.qos.logback.core.rolling.SizeAndTimeBasedFNATP">

<maxFileSize>500MB</maxFileSize>

</timeBasedFileNamingAndTriggeringPolicy>

<maxHistory>2</maxHistory>

</rollingPolicy>

<layout class="ch.qos.logback.classic.PatternLayout">

<Pattern>

%d{yyyy-MM-dd HH:mm:ss.SSS} [%thread] %-5level %logger{36} -%msg%n

</Pattern>

</layout>

</appender> <appender name="STDOUT" class="ch.qos.logback.core.ConsoleAppender">

<encoder>

<pattern>%d{HH:mm:ss.SSS} [%thread] %-5level %logger{36} - %msg%n</pattern>

</encoder>

</appender> <!-- 配置logstash的ip端口 -->

<appender name="LOGSTASH" class="net.logstash.logback.appender.LogstashTcpSocketAppender">

<destination>192.168.1.66:4567</destination>

<encoder charset="UTF-8" class="net.logstash.logback.encoder.LogstashEncoder" />

</appender> <root level="INFO">

<appender-ref ref="INFO_FILE" />

<appender-ref ref="ERROR_FILE" />

<appender-ref ref="STDOUT" />

<!-- 向logstash中写入日志 -->

<appender-ref ref="LOGSTASH" />

</root> <logger name="org.springframework.boot" level="INFO"/>

</configuration>

3.application.properties文件中配置使用 我们刚刚加入的logback.xml文件

#日志

logging.config=classpath:logback.xml

logging.path=/data/springboot-log

4.新建一个测试类,如下:

import org.junit.Test;

import org.junit.runner.RunWith;

import org.slf4j.Logger;

import org.slf4j.LoggerFactory;

import org.springframework.boot.test.context.SpringBootTest;

import org.springframework.test.context.junit4.SpringRunner; @RunWith(SpringRunner.class)

@SpringBootTest

public class LogTest { public static final Logger logger = LoggerFactory.getLogger(Main.class); @Test

public void testLog() {

logger.info("==66666=={}" , "我是info级别的日志");

logger.error("==66666=={}" , "我是error级别的日志");

} }

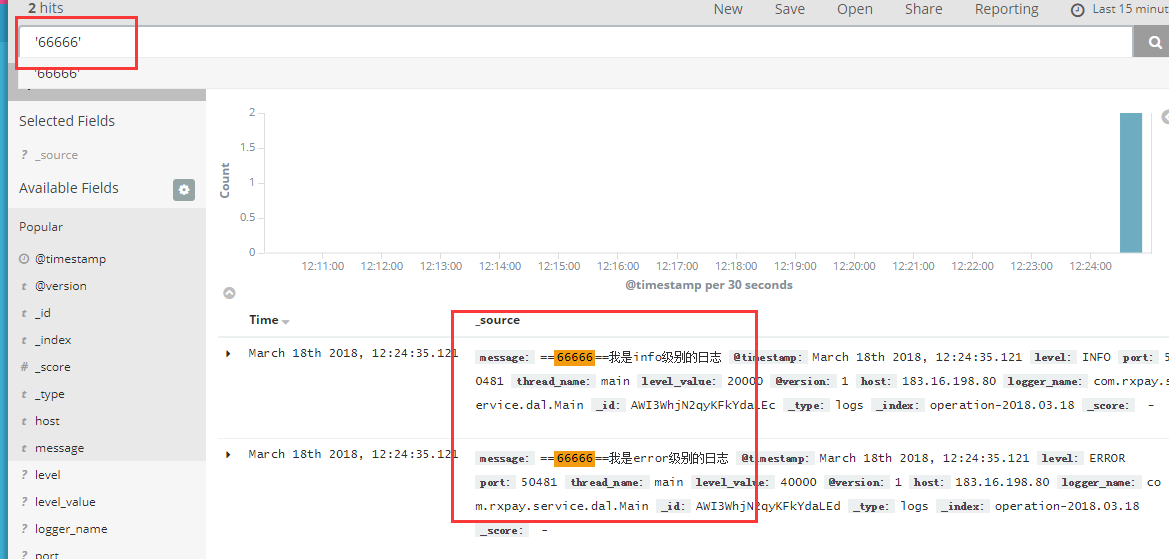

在浏览器中输入:192.168.1.66:5601,选中 左侧菜单中的Discover,然后在 下图框中输入'66666'(注意:单引号代表模糊查询,双引号代表精确查询),回车,看到下图中可以查询出刚刚LogTest中输入的日志,说明logback已经可以向logstash中写入日志了。

ELK5.X+logback搭建日志平台的更多相关文章

- logstash+elasticsearch+kibana快速搭建日志平台

使用logstash+elasticsearch+kibana快速搭建日志平台 日志的分析和监控在系统开发中占非常重要的地位,系统越复杂,日志的分析和监控就越重要,常见的需求有: 根据关键字查询日 ...

- spring mvc+ELK从头开始搭建日志平台

最近由于之前协助前公司做了点力所能及的事情,居然收到了一份贵重的端午礼物,是给我女儿的一个乐高积木,整个有7大包物件,我花了接近一天的时间一砖一瓦的组织起来,虽然很辛苦但是能够从过程中体验到乐趣.这次 ...

- ELK快速搭建日志平台

1. 抛砖引入 <Elasticsearch> <Logstash> <Filebeat> <Filebeat模块与配置> <Kibana> ...

- 使用logstash+elasticsearch+kibana快速搭建日志平台

日志的分析和监控在系统开发中占非常重要的地位,系统越复杂,日志的分析和监控就越重要,常见的需求有: * 根据关键字查询日志详情 * 监控系统的运行状况 * 统计分析,比如接口的调用次数.执行时间.成功 ...

- 【转载】使用logstash+elasticsearch+kibana快速搭建日志平台

原文链接:http://www.cnblogs.com/buzzlight/p/logstash_elasticsearch_kibana_log.html 日志的分析和监控在系统开发中占非常重要的地 ...

- Elasticsearch+Logstash+Kibana搭建日志平台

1 ELK简介 ELK是Elasticsearch+Logstash+Kibana的简称 ElasticSearch是一个基于Lucene的分布式全文搜索引擎,提供 RESTful API进行数据读写 ...

- 从头开始搭建分布式日志平台的docker环境

上篇(spring mvc+ELK从头开始搭建日志平台)分享了从头开始搭建基于spring mvc+redis+logback+logstash+elasticsearch+kibana的分布式日志平 ...

- 基于Kafka+ELK搭建海量日志平台

早在传统的单体应用时代,查看日志大都通过SSH客户端登服务器去看,使用较多的命令就是 less 或者 tail.如果服务部署了好几台,就要分别登录到这几台机器上看,等到了分布式和微服务架构流行时代,一 ...

- ELK_elk+redis 搭建日志分析平台

这个是最新的elk+redis搭建日志分析平台,今年时间是2015年9月11日. Elk分别为 elasticsearch,logstash, kibana 官网为:https://www.elast ...

随机推荐

- 解决 windows10和ubuntu16.04双系统下时间不对的问题

- 重启sphinx

connection to localhost:9312 failed 只能上传不能下载 /usr/sbin/setenforce 0 立刻关闭 SELINUX/usr/sbin/setenforce ...

- 一款由jquery实现的超炫的页面加载特效

今天为大家带来一款由jquery实现的超炫的页面加载特效.连续的几个页面分开特效.最后由三维的线条由远至近消失,然后由近至远出现.效果超级梦炫.一起看下效果图: 在线预览 源码下载 实现的代码. ...

- Intellij idea上传项目到github

操作前提 1.安装了 git for windows客户端 2.配置了rsa公钥 3.设置了邮箱和用户名 详情请看上一篇博客http://www.cnblogs.com/520playboy/p/66 ...

- usb 转 uart cp210x 驱动解析

USB 转 uart (cp210x.c) 驱动解析 * usb_serial_driver 结构体解析 include/linux/usb/serial.h /** 描述一个usb 串口设备驱动 * ...

- u-boot 2016.05 添加自己的board 以及config.h

拿到一个uboot 后,我都想添加一个属于自己的board文件以及include/configs/*.h 文件. 如何添加这个些文件,今天来记录一下. 复制一份你所参考的板级文件,比如说board/v ...

- [uboot]在uboot里面添加环境变量使用run来执行

转自:http://blog.csdn.net/yangzheng_yz/article/details/41038259 在移植uboot的时候,可以在uboot里面添加定义一些自己的环境变量,这些 ...

- linux访问ftp服务器命令

在linux访问时输入 用户名 anonymous 密码直接回车可以匿名登录 如果传输非文本,先输入bianry,然后再get就可以了 比如 ftp> get 5-4.tif 227 Enter ...

- RunnableException与CheckedException

Checked Exception 编译时异常 编译的时候检查你的代码可能在运行的时候抛出异常,这通常在编译的时候要去处理的. RunnableException 运行时异常,可以编译通过,但如果不处 ...

- ajax传值给php

test.php <script type="text/javascript"> function selectInput(oSelect) { var value= ...