DNN的BP算法Python简单实现

BP算法是神经网络的基础,也是最重要的部分。由于误差反向传播的过程中,可能会出现梯度消失或者爆炸,所以需要调整损失函数。在LSTM中,通过sigmoid来实现三个门来解决记忆问题,用tensorflow实现的过程中,需要进行梯度修剪操作,以防止梯度爆炸。RNN的BPTT算法同样存在着这样的问题,所以步数超过5步以后,记忆效果大大下降。LSTM的效果能够支持到30多步数,太长了也不行。如果要求更长的记忆,或者考虑更多的上下文,可以把多个句子的LSTM输出组合起来作为另一个LSTM的输入。下面上传用Python实现的普通DNN的BP算法,激活为sigmoid.

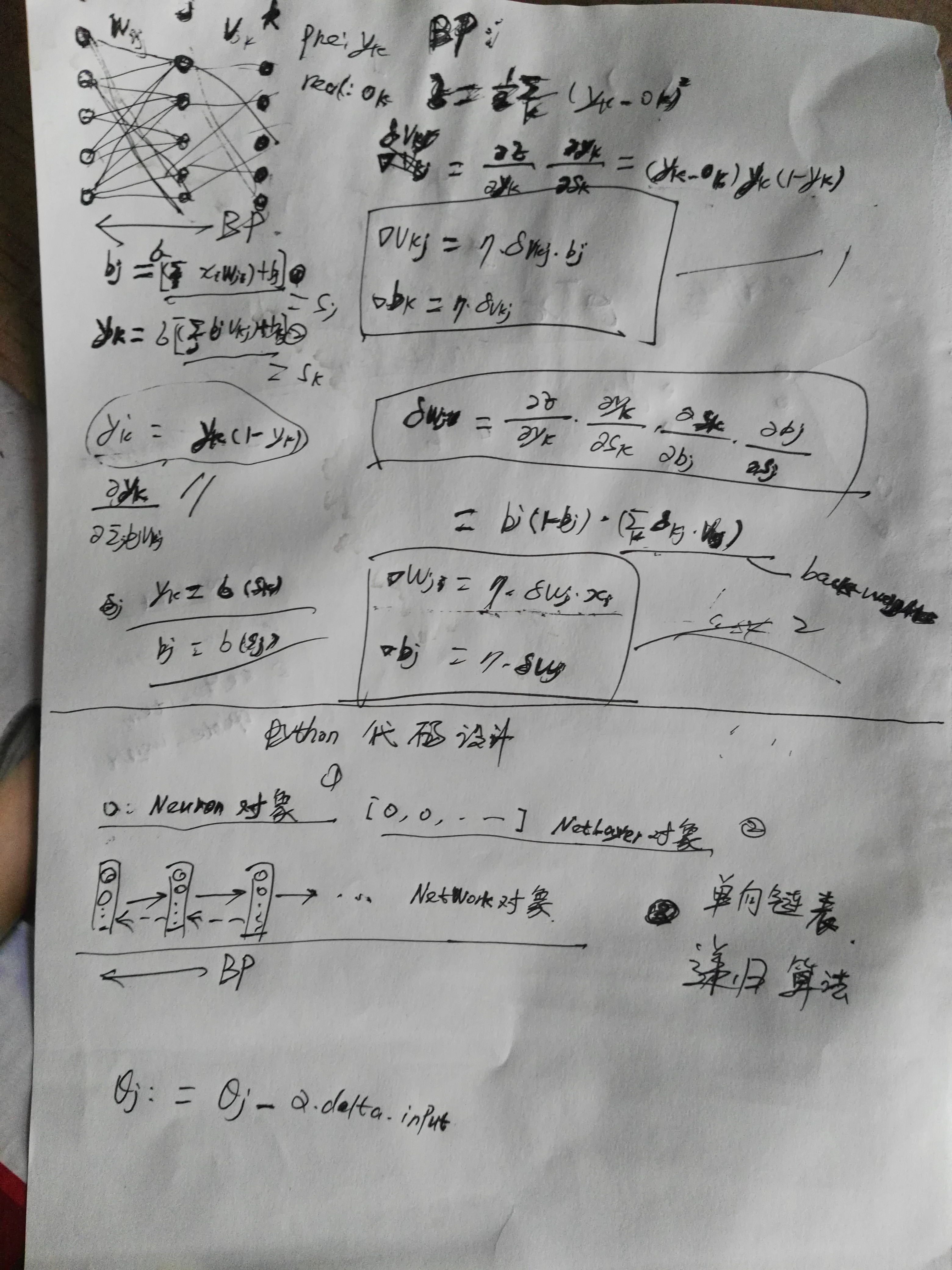

字迹有些潦草,凑合用吧,习惯了手动绘图,个人习惯。后面的代码实现思路是最重要的:每个层有多个节点,层与层之间单向链接(前馈网络),因此数据结构可以设计为单向链表。实现的过程属于典型的递归,递归调用到最后一层后把每一层的back_weights反馈给上一层,直到推导结束。上传代码(未经过优化的代码):

测试代码:

import numpy as np

import NeuralNetWork as nw if __name__ == '__main__':

print("test neural network") data = np.array([[1, 0, 0, 0, 0, 0, 0, 0],

[0, 1, 0, 0, 0, 0, 0, 0],

[0, 0, 1, 0, 0, 0, 0, 0],

[0, 0, 0, 1, 0, 0, 0, 0],

[0, 0, 0, 0, 1, 0, 0, 0],

[0, 0, 0, 0, 0, 1, 0, 0],

[0, 0, 0, 0, 0, 0, 1, 0],

[0, 0, 0, 0, 0, 0, 0, 1]]) np.set_printoptions(precision=3, suppress=True) for i in range(10):

network = nw.NeuralNetWork([8, 20, 8])

# 让输入数据与输出数据相等

network.fit(data, data, learning_rate=0.1, epochs=150) print("\n\n", i, "result")

for item in data:

print(item, network.predict(item))

#NeuralNetWork.py

# encoding: utf-8

#NeuralNetWork.py

import numpy as np; def logistic(inX):

return 1 / (1+np.exp(-inX)) def logistic_derivative(x):

return logistic(x) * (1 - logistic(x)) class Neuron:

'''

构建神经元单元,每个单元都有如下属性:1.input;2.output;3.back_weight;4.deltas_item;5.weights.

每个神经元单元更新自己的weights,多个神经元构成layer,形成weights矩阵

'''

def __init__(self,len_input):

#输入的初始参数,随机取很小的值(<0.1)

self.weights = np.random.random(len_input) * 0.1

#当前实例的输入

self.input = np.ones(len_input)

#对下一层的输出值

self.output = 1.0

#误差项

self.deltas_item = 0.0

# 上一次权重增加的量,记录起来方便后面扩展时可考虑增加冲量

self.last_weight_add = 0 def calculate_output(self,x):

#计算输出值

self.input = x;

self.output = logistic(np.dot(self.weights,self.input))

return self.output def get_back_weight(self):

#获取反馈差值

return self.weights * self.deltas_item def update_weight(self,target = 0,back_weight = 0,learning_rate=0.1,layer="OUTPUT"):

#更新权重

if layer == "OUTPUT":

self.deltas_item = (target - self.output) * logistic_derivative(self.input)

elif layer == "HIDDEN":

self.deltas_item = back_weight * logistic_derivative(self.input) delta_weight = self.input * self.deltas_item * learning_rate + 0.9 * self.last_weight_add #添加冲量

self.weights += delta_weight

self.last_weight_add = delta_weight class NetLayer:

'''

网络层封装,管理当前网络层的神经元列表

''' def __init__(self,len_node,in_count):

'''

:param len_node: 当前层的神经元数

:param in_count: 当前层的输入数

'''

# 当前层的神经元列表

self.neurons = [Neuron(in_count) for _ in range(len_node)];

# 记录下一层的引用,方便递归操作

self.next_layer = None def calculate_output(self,inX):

output = np.array([node.calculate_output(inX) for node in self.neurons])

if self.next_layer is not None:

return self.next_layer.calculate_output(output)

return output def get_back_weight(self):

return sum([node.get_back_weight() for node in self.neurons]) def update_weight(self,learning_rate,target):

layer = "OUTPUT"

back_weight = np.zeros(len(self.neurons))

if self.next_layer is not None:

back_weight = self.next_layer.update_weight(learning_rate,target)

layer = "HIDDEN"

for i,node in enumerate(self.neurons):

target_item = 0 if len(target) <= i else target[i]

node.update_weight(target = target_item,back_weight = back_weight[i],learning_rate=learning_rate,layer=layer)

return self.get_back_weight() class NeuralNetWork:

def __init__(self, layers):

self.layers = []

self.construct_network(layers)

pass def construct_network(self, layers):

last_layer = None

for i, layer in enumerate(layers):

if i == 0:

continue

cur_layer = NetLayer(layer, layers[i - 1])

self.layers.append(cur_layer)

if last_layer is not None:

last_layer.next_layer = cur_layer

last_layer = cur_layer def fit(self, x_train, y_train, learning_rate=0.1, epochs=100000, shuffle=False):

'''''

训练网络, 默认按顺序来训练

方法 1:按训练数据顺序来训练

方法 2: 随机选择测试

:param x_train: 输入数据

:param y_train: 输出数据

:param learning_rate: 学习率

:param epochs:权重更新次数

:param shuffle:随机取数据训练

'''

indices = np.arange(len(x_train))

for _ in range(epochs):

if shuffle:

np.random.shuffle(indices)

for i in indices:

self.layers[0].calculate_output(x_train[i])

self.layers[0].update_weight(learning_rate, y_train[i])

pass def predict(self, x):

return self.layers[0].calculate_output(x)

DNN的BP算法Python简单实现的更多相关文章

- 神经网络(BP)算法Python实现及简单应用

首先用Python实现简单地神经网络算法: import numpy as np # 定义tanh函数 def tanh(x): return np.tanh(x) # tanh函数的导数 def t ...

- 【深度学习】BP反向传播算法Python简单实现

转载:火烫火烫的 个人觉得BP反向传播是深度学习的一个基础,所以很有必要把反向传播算法好好学一下 得益于一步一步弄懂反向传播的例子这篇文章,给出一个例子来说明反向传播 不过是英文的,如果你感觉不好阅读 ...

- 决策树(Decision Tree)算法 python简单实现

"" """ import numpy as np from math import log import operator import json ...

- BP算法从原理到python实现

BP算法从原理到实践 反向传播算法Backpropagation的python实现 觉得有用的话,欢迎一起讨论相互学习~Follow Me 博主接触深度学习已经一段时间,近期在与别人进行讨论时,发现自 ...

- 关于BP算法在DNN中本质问题的几点随笔 [原创 by 白明] 微信号matthew-bai

随着deep learning的火爆,神经网络(NN)被大家广泛研究使用.但是大部分RD对BP在NN中本质不甚清楚,对于为什这么使用以及国外大牛们是什么原因会想到用dropout/sigmoid ...

- 神经网络BP算法C和python代码

上面只显示代码. 详BP原理和神经网络的相关知识,请参阅:神经网络和反向传播算法推导 首先是前向传播的计算: 输入: 首先为正整数 n.m.p.t,分别代表特征个数.训练样本个数.隐藏层神经元个数.输 ...

- 神经网络中 BP 算法的原理与 Python 实现源码解析

最近这段时间系统性的学习了 BP 算法后写下了这篇学习笔记,因为能力有限,若有明显错误,还请指正. 什么是梯度下降和链式求导法则 假设我们有一个函数 J(w),如下图所示. 梯度下降示意图 现在,我们 ...

- BP算法在minist数据集上的简单实现

BP算法在minist上的简单实现 数据:http://yann.lecun.com/exdb/mnist/ 参考:blog,blog2,blog3,tensorflow 推导:http://www. ...

- 基于BP神经网络的简单字符识别算法自小结(C语言版)

本文均属自己阅读源代码的点滴总结.转账请注明出处谢谢. 欢迎和大家交流.qq:1037701636 email:gzzaigcn2009@163.com 写在前面的闲话: 自我感觉自己应该不是一个非常 ...

随机推荐

- MVC中使用SignalR打造酷炫实用的即时通讯功能(轉載)

資料來源:http://www.fangsi.net/1144.html 前言,现在这世道写篇帖子没个前言真不好意思发出来.本贴的主要内容来自于本人在之前项目中所开发的一个小功能,用于OA中的即时通讯 ...

- Vue3.0结合bootstrap做多页面应用(2)基础配置

接下来就是多页面应用的配置啦,安装完vue 3.0可以发现目录比2.0的精简了很多, public相当于原来的static,里面的index.html是项目的入口 ,src同以前一样,cli3.0没有 ...

- MVC伪静态路由简单搭配

public static void RegisterRoutes(RouteCollection routes) { routes.IgnoreRoute ...

- RabbitMQ学习之RPC(6)

在第二个教程中,我们了解到如何在多个worker中使用Work Queues分发费时的任务. 但是,如果我们需要在远程运行一个函数并且等待结果该怎么办呢?这个时候,我们需要另外一个模式了.这种模式通常 ...

- 计数计量单位KMGTPEZY【计算机】【天文】

· Bit = Binary Digit · Bits = · s = Kilo · Kilo s = Mega · Mega s = Giga · Giga s = Tera · Tera s = ...

- python 面向对象编程、获取对象信息

面向对象与面向过程 参考链接:https://www.liaoxuefeng.com/wiki/0014316089557264a6b348958f449949df42a6d3a2e542c000/0 ...

- cmd脚本

管道命令 | |命令的作用,就是让前一命令的输出当做后一命令的输入. > >会清除掉原有文件中的内容后把新的内容写入原文件: echo @echo off > a.bat. > ...

- Node.js 连接 MongoDB数据库

安装指令:npm install mongodb var mongodb = require("mongodb");// console.log(mongodb); var Mon ...

- js学习之堆栈内存

**栈内存** >基本数据类型值是直接存放在栈内存中的 栈内存中的变量一般都是已知大小或者有范围上限的,算作一种简单存储.而堆内存存储的对象类型数据对于大小这方面,一般都是未知的.个人认为,这也 ...

- Spring中基于注解的IOC(二):案例与总结

2.Spring的IOC案例 创建maven项目 导入依赖 pom.xml xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance" ...