利用scrapy-client 发布爬虫到远程服务端

远程服务端Scrapyd先要开启

远程服务器必须装有scapyd,并开启。

这里远程服务开启的端口和ip:

192.166.12.80:6800

客户端配置和上传

先修爬虫项目文件scrapy.cfg:如下图

cd 到爬虫项目文件夹下,后执行:

scrapyd-deploy # 上传

scrapyd-deploy -l # 查看

打包项目

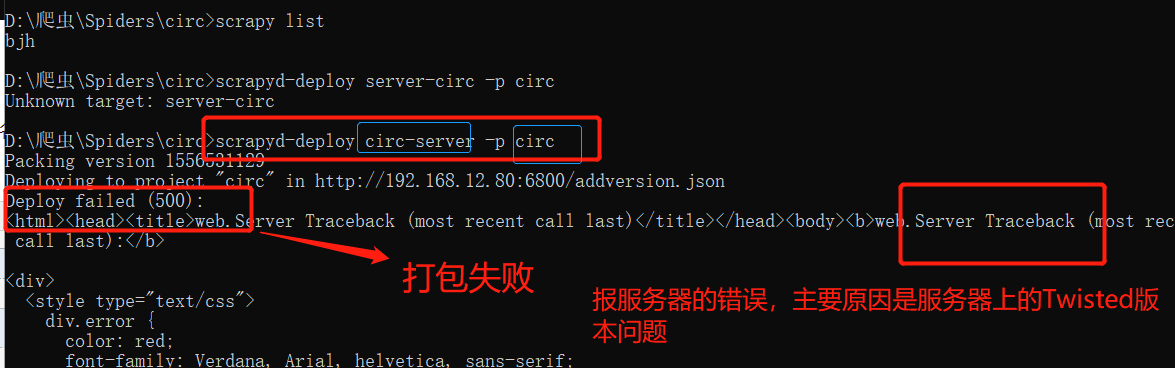

1、打包前先查看项目下的爬虫文件:

说明可以开始打包了

2.执行打包命令:

scrapyd-deploy 部署名称 -p 项目名称

上面表示打包成功。

以下是可能出现的问题,以及解决方案:

如果出现后端报错和scrapyd前端页面报错,解决方案:

scrapyd 前端报错:

修改远程服务器(192.168.12.80)上的Twisted的版本改为 18.9.0

pip3 install Twisted==18.9.0

重启 Scrapyd:

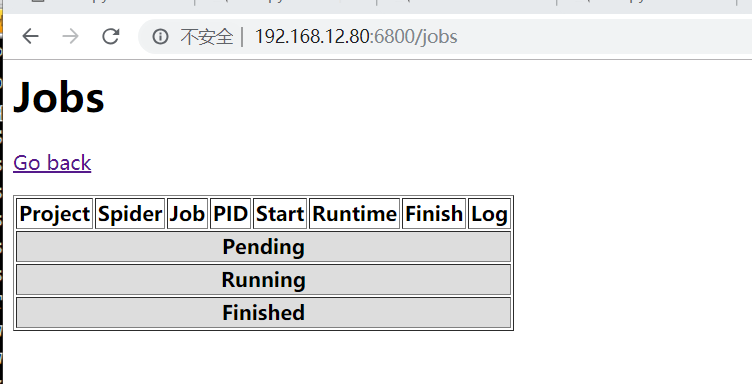

在访问192.168.12.80:6800/jobs,正常显示:

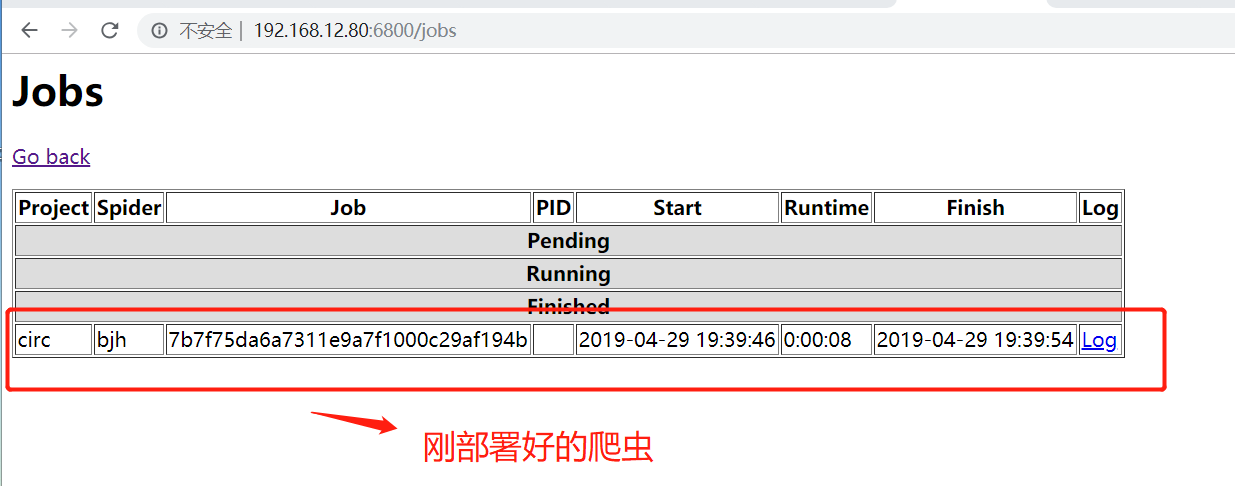

3.上传运行爬虫

curl http://远程ip:6800/schedule.json -d project=项目名称 -d spider=爬虫名称

如:

curl http://192.168.12.80:6800/schedule.json -d project=circ -d spider=bjh

说明部署成功:

scrapyd部署已经完成了。

管理

1、停止爬虫

curl http://localhost:6800/cancel.json -d project=scrapy项目名称 -d job=运行ID

2.删除scrapy项目

注意:一般删除scrapy项目,需要先执行命令停止项目下在远行的爬虫

curl http://localhost:6800/delproject.json -d project=scrapy项目名称

3.查看有多少个scrapy项目在api中

curl http://localhost:6800/listprojects.json

4.查看指定的scrapy项目中有多少个爬虫

curl http://localhost:6800/listspiders.json?project=scrapy项目名称

5总结几个请求url,通过在浏览器输入,也可以监控爬虫进程。

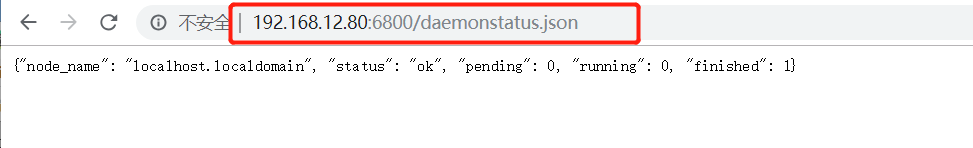

例子:地址栏访问 :http://192.168.12.80:6800/daemonstatus.json,获取到一下页面

1、获取状态

http://127.0.0.1:6800/daemonstatus.json

2、获取项目列表

http://127.0.0.1:6800/listprojects.json

3、获取项目下已发布的爬虫列表

http://127.0.0.1:6800/listspiders.json?project=myproject

4、获取项目下已发布的爬虫版本列表

http://127.0.0.1:6800/listversions.json?project=myproject

5、获取爬虫运行状态

http://127.0.0.1:6800/listjobs.json?project=myproject

6、启动服务器上某一爬虫(必须是已发布到服务器的爬虫)

http://127.0.0.1:6800/schedule.json (post方式,data={“project”:myproject,“spider”:myspider})

7、删除某一版本爬虫

http://127.0.0.1:6800/delversion.json

(post方式,data={“project”:myproject,“version”:myversion})

8、删除某一工程,包括该工程下的各版本爬虫

http://127.0.0.1:6800/delproject.json(post方式,data={“project”:myproject})

利用scrapy-client 发布爬虫到远程服务端的更多相关文章

- 利用scrapy框架进行爬虫

今天一个网友问爬虫知识,自己把许多小细节都忘了,很惭愧,所以这里写一下大概的步骤,主要是自己巩固一下知识,顺便复习一下.(scrapy框架有一个好处,就是可以爬取https的内容) [爬取的是杨子晚报 ...

- 利用scrapy和MongoDB来开发一个爬虫

今天我们利用scrapy框架来抓取Stack Overflow里面最新的问题(),并且将这些问题保存到MongoDb当中,直接提供给客户进行查询. 安装 在进行今天的任务之前我们需要安装二个框架,分别 ...

- 【爬虫】利用Scrapy抓取京东商品、豆瓣电影、技术问题

1.scrapy基本了解 Scrapy是一个为了爬取网站数据,提取结构性数据而编写的应用框架.可以应用在包括数据挖掘, 信息处理或存储历史数据等一系列的程序中.其最初是为了页面抓取(更确切来说,网络抓 ...

- 利用scrapy爬取腾讯的招聘信息

利用scrapy框架抓取腾讯的招聘信息,爬取地址为:https://hr.tencent.com/position.php 抓取字段包括:招聘岗位,人数,工作地点,发布时间,及具体的工作要求和工作任务 ...

- Scrapy - 第一个爬虫和我的博客

第一个爬虫 这里我用官方文档的第一个例子:爬取http://quotes.toscrape.com来作为我的首个scrapy爬虫,我没有找到scrapy 1.5的中文文档,后续内容有部分是我按照官方文 ...

- Scrapy 框架,爬虫文件相关

Spiders 介绍 由一系列定义了一个网址或一组网址类如何被爬取的类组成 具体包括如何执行爬取任务并且如何从页面中提取结构化的数据. 简单来说就是帮助你爬取数据的地方 内部行为 #1.生成初始的Re ...

- python3+scrapy 趣头条爬虫实例

项目简介 爬取趣头条新闻(http://home.qutoutiao.net/pages/home.html),具体内容: 1.列表页(json):标题,简介.封面图.来源.发布时间 2.详情页(ht ...

- Scrapyd发布爬虫的工具

Scrapyd Scrapyd是部署和运行Scrapy.spider的应用程序.它使您能够使用JSON API部署(上传)您的项目并控制其spider. Scrapyd-client Scrapyd- ...

- 发布Cocos2d-x的PC端程序

发布Cocos2d-x的PC端程序 一.创建一个Release的项目 1.利用根目录下的解决方案生成Release.win32文件夹 2.新建一个cocos2d项目(比如解决方案名称MySolutio ...

随机推荐

- iOS深浅拷贝

浅拷贝:你和你的影子,你改变,你的影子发生改变 深拷贝:你的克隆人,你改变,你的克隆人并不会发生变化 eg: NSString *string = @"我是一个小白鼠"; NSSt ...

- 2.第一个python 程序

第一个python程序 一..python程序的编写步骤 1.创建 xxx.py文件(文件名不要中文) 文件名要以py为扩展名,因为导入的时候其他扩展名会报错.如果不导入的情况可以不限制扩展名. 2 ...

- java多线程探究

本文主要是一些线程理论性的知识,随后将贴出研究的源码,包含线程池,锁,线程组等简单的demo,欢迎大家下载1.进程:每个进程都有独立的代码和数据空间(进程上下文),进程间的切换会有较大的开销,一个进程 ...

- Oracle 10g 使用REGEXP_SUBSTR 分拆字符串 (转)

SELECT l_count, REGEXP_SUBSTR('add, daddf, dsdf, asdfa, dsfasd, dsfad','[^,]+',1,l_count) AS NAME F ...

- jdk5升8问题记录-Spring2升4

Spring2.x升4.x Hibernate3.x升5.0 jdbcOperations.queryForInt 替换为 queryForObject(sql, parameters, Intege ...

- WTForms

一.简单介绍flask中的wtforms WTForms是一个支持多个web框架的form组件,主要用于对用户请求数据进行验证. 安装: pip3 install wtforms 用户登录简例: fr ...

- PHP的openssl加密

PHP的openssl扩展 openssl扩展使用openssl加密扩展包,封装了多个用于加密解密相关的PHP函数,极大地方便了对数据的加密解密. 常用的函数有: 对称加密相关: string ope ...

- css学习-》养成路线

雅虎工程师提供的CSS初始化示例代码 body,div,dl,dt,dd,ul,ol,li,h1,h2,h3,h4,h5,h6,pre,code,form,fieldset,legend,input, ...

- tomcat启动命令行中文乱码

1.找到${CATALINA_HOME}/conf/logging.properties 2.添加语句:java.util.logging.ConsoleHandler.encoding = GBK ...

- Java处理对象

1.打印对象和toString 方法 toString() 方法是Object 类的一个实例方法,所有的Java类都是Object类的子类,因此所有的Java对象都是具有toString()方 ...