python学习(十六)写爬虫爬取糗事百科段子

原文链接:爬取糗事百科段子

利用前面学到的文件、正则表达式、urllib的知识,综合运用,爬取糗事百科的段子

先用urllib库获取糗事百科热帖第一页的数据。并打开文件进行保存,正好可以熟悉一下之前学过的文件知识。

from urllib import request, parse

from urllib import error

page = 1

url = 'https://www.qiushibaike.com/hot/page/'+str(page)

user_agent = 'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/49.0.2623.221 Safari/537.36 SE 2.X MetaSr 1.0'

try:

req = request.Request(url)

req.add_header('User-Agent', user_agent)

response = request.urlopen(req)

#bytes变为字符串

content = response.read().decode('utf-8')

print(type(content))

#uf-8编码方式打开

file = open('file.txt', 'w',encoding='utf-8') file.write(content) except error.URLError as e:

if hasattr(e,'code'):

print (e.code)

if hasattr(e,'reason'):

print (e.reason)

finally:

file.close()

下面要用到学过的正则表达式的知识,过滤掉没有用的信息,只获取评论数,作者,正文,以及点赞的数量。打开文件可以看到如下内容:

div class=”article block untagged mb15 typs_long” id=’qiushi_tag_119848276’表示一个文章的开始,id为文章对应的id,

h2 之间的是发布者的姓名‘高老庄福帅猪刚鬣’,span与/span之间的是正文, i class=”number”与/i,635表示赞的个数,

同样也可以获取评论的个数。

import re

with open('file.txt','r', encoding='utf-8') as f:

data = f.read()

pattern = re.compile(r'<div.*?<h2>(.*?)</h2>.*?<span>(.*?)</span>.*?number">(.*?)</i>.*?'+

r'"number">(.*?)</i>', re.S )

result = re.search(pattern, data)

#print(result)

#print(result.group())

print(result.group(1))

print(result.group(2))

print(result.group(3))

print(result.group(4))

re.compile(),参数re.S表示将.的作用扩充为任意字符,因为前几篇文章讲述过.在一般情况下匹配除/n之外的所有字符。

正则表达式中.*?连起来匹配任意字符,且为非贪婪模式。因为.表示任意字符,*表示匹配前一个字符0个或多个,.*表示匹配任意多个字符,而加上?表示非贪婪模式。

re.search是搜索匹配正则表达式规则的条目,search讲述过可以从内容的任意位置查找。这样就可以找到一个符合这种规则

的段子。如果找到所有符合规则的段子可以用re.findall进行查找。

下面一气呵成,将网站上的段子按照正则表达式匹配,并将匹配后的段子写入文件,同时在终端显示。

from urllib import request, parse

from urllib import error

page = 1

url = 'https://www.qiushibaike.com/hot/page/'+str(page)

user_agent = 'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/49.0.2623.221 Safari/537.36 SE 2.X MetaSr 1.0'

try:

req = request.Request(url)

req.add_header('User-Agent', user_agent)

response = request.urlopen(req)

#bytes变为字符串

content = response.read().decode('utf-8')

pattern = re.compile(r'<div.*?<h2>(.*?)</h2>.*?<span>(.*?)</span>.*?number">(.*?)</i>.*?'+

r'"number">(.*?)</i>', re.S )

result = re.findall(pattern, content)

files = open('findfile.txt','w+', encoding='utf-8')

for item in result:

author = item[0]

contant = item[1]

vote = '赞:'+item[2]

commit = '评论数:'+item[3]

infos = vote +' '+commit+' '+'\n\n'

print(author)

print(contant)

print(infos)

files.write(author)

files.write(contant)

files.write(infos) except error.URLError as e:

if hasattr(e,'code'):

print (e.code)

if hasattr(e,'reason'):

print (e.reason)

finally:

files.close()

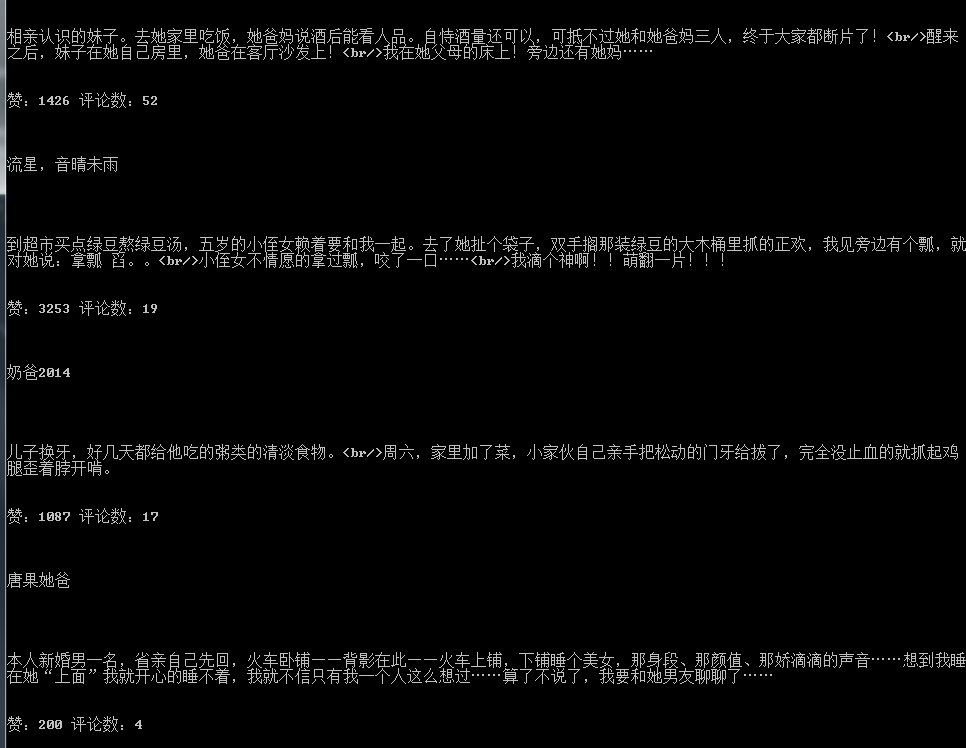

效果如下:

我的公众号:

python学习(十六)写爬虫爬取糗事百科段子的更多相关文章

- Python爬虫爬取糗事百科段子内容

参照网上的教程再做修改,抓取糗事百科段子(去除图片),详情见下面源码: #coding=utf-8#!/usr/bin/pythonimport urllibimport urllib2import ...

- Python爬虫-爬取糗事百科段子

闲来无事,学学python爬虫. 在正式学爬虫前,简单学习了下HTML和CSS,了解了网页的基本结构后,更加快速入门. 1.获取糗事百科url http://www.qiushibaike.com/h ...

- Python爬虫实战一之爬取糗事百科段子

大家好,前面入门已经说了那么多基础知识了,下面我们做几个实战项目来挑战一下吧.那么这次为大家带来,Python爬取糗事百科的小段子的例子. 首先,糗事百科大家都听说过吧?糗友们发的搞笑的段子一抓一大把 ...

- 转 Python爬虫实战一之爬取糗事百科段子

静觅 » Python爬虫实战一之爬取糗事百科段子 首先,糗事百科大家都听说过吧?糗友们发的搞笑的段子一抓一大把,这次我们尝试一下用爬虫把他们抓取下来. 友情提示 糗事百科在前一段时间进行了改版,导致 ...

- 8.Python爬虫实战一之爬取糗事百科段子

大家好,前面入门已经说了那么多基础知识了,下面我们做几个实战项目来挑战一下吧.那么这次为大家带来,Python爬取糗事百科的小段子的例子. 首先,糗事百科大家都听说过吧?糗友们发的搞笑的段子一抓一大把 ...

- [爬虫]用python的requests模块爬取糗事百科段子

虽然Python的标准库中 urllib2 模块已经包含了平常我们使用的大多数功能,但是它的 API 使用起来让人感觉不太好,而 Requests 自称 “HTTP for Humans”,说明使用更 ...

- python爬取糗事百科段子

初步爬取糗事百科第一页段子(发布人,发布内容,好笑数和评论数) #-*-coding:utf--*- import urllib import urllib2 import re page = url ...

- Python爬虫实战之爬取糗事百科段子【华为云技术分享】

首先,糗事百科大家都听说过吧?糗友们发的搞笑的段子一抓一大把,这次我们尝试一下用爬虫把他们抓取下来. 友情提示 糗事百科在前一段时间进行了改版,导致之前的代码没法用了,会导致无法输出和CPU占用过高的 ...

- 芝麻HTTP:Python爬虫实战之爬取糗事百科段子

首先,糗事百科大家都听说过吧?糗友们发的搞笑的段子一抓一大把,这次我们尝试一下用爬虫把他们抓取下来. 友情提示 糗事百科在前一段时间进行了改版,导致之前的代码没法用了,会导致无法输出和CPU占用过高的 ...

随机推荐

- 【python 2.7】python读取json数据存入MySQL

同上一篇,只是适配 CentOS+ python 2.7 #python 2.7 # -*- coding:utf-8 -*- __author__ = 'BH8ANK' import json im ...

- eBay:美国各州最受欢迎的产品品类

雨果网从美国媒体<商业内幕>8月26日的报道中获悉,电商巨头eBay近日发布了美国各州最受欢迎的产品品类.包括:加州人青睐女性高端配件,而新泽西 州的男人喜欢古龙香水.相比这些华丽配饰而言 ...

- 20162316刘诚昊 第八周实验报告:实验二 Java面向对象程序设计

实验内容 初步掌握单元测试和TDD 理解并掌握面向对象三要素:封装.继承.多态 初步掌握UML建模 熟悉S.O.L.I.D原则 了解设计模式 实验要求 1.没有Linux基础的同学建议先学习<L ...

- YQCB项目介绍

YQCB记账本软件 制作人:YQCB团队 团队简介:团队成立于2017年11月21日,由陈美琪,张晨阳,邢全阳,刘昭为四人组成. 陈美琪:团队灵魂人物,背负着巨大的压力带起整个团队. 张晨阳:团队领军 ...

- Opendarlight Carbon 安装

写在前面 目前最轻松的一次安装过程,感谢大翔哥的帮助. 安装过程 1.Zip包下载 找到Opendaylight官网,进入下载界面找到Carbon版本并下载. 2.Zip包解压 把这个zip压缩包解压 ...

- CodeForces Round #527 (Div3) C. Prefixes and Suffixes

http://codeforces.com/contest/1092/problem/C Ivan wants to play a game with you. He picked some stri ...

- Ubuntu 16.04 LTS安装sogou输入法详解

http://blog.csdn.net/qq_21792169/article/details/53152700 最近开始学习linux 在安装输入法中遇到的一些问题,最终成功安装,也得益于网络上的 ...

- 阿里中间件RocketMQ

阿里RocketMQ是怎样孵化成Apache顶级项目的? RocketMQ 迈入50万TPS消息俱乐部 Apache RocketMQ背后的设计思路与最佳实践 专访RocketMQ联合创始人:项目思路 ...

- wp开发(二)--获取用户篇

本文从个人开发者的角度来谈如何让wp应用获得尽可能多的用户.当然前提是你的app有一定的竞争性,如果不具备竞争力,那再多的用户下载也是白扯,所以最关键的还是要保证app的质量. 一. 程序图标 千万不 ...

- 【Java并发编程】之四:守护线程与线程阻塞的四种情况

守护线程 Java中有两类线程:User Thread(用户线程).Daemon Thread(守护线程) 用户线程即运行在前台的线程,而守护线程是运行在后台的线程. 守护线程作用是为其他前台线程 ...