TensorRT C# API 项目更新 (1):支持动态Bath输入模型推理

1. 项目介绍

NVIDIA TensorRT 是一款用于高性能深度学习推理的 SDK,包括深度学习推理优化器和运行时,可为推理应用程序提供低延迟和高吞吐量。基于 NVIDIA TensorRT 的应用程序在推理过程中的执行速度比纯 CPU 平台快 36 倍,使您能够优化在所有主要框架上训练的神经网络模型,以高精度校准低精度,并部署到超大规模数据中心、嵌入式平台或汽车产品平台。

TensorRT 基于 NVIDIA CUDA 并行编程模型构建,使您能够在 NVIDIA GPU 上使用量化、层和张量融合、内核调整等技术来优化推理。TensorRT 提供 INT8 使用量化感知训练和训练后量化和浮点 16 (FP16) 优化,用于部署深度学习推理应用程序,例如视频流、推荐、欺诈检测和自然语言处理。低精度推理可显著降低延迟,这是许多实时服务以及自主和嵌入式应用所必需的。TensorRT 与 PyTorch 和 TensorFlow 集成,因此只需一行代码即可实现 6 倍的推理速度。TensorRT 提供了一个 ONNX 解析器,因此您可以轻松地将 ONNX 模型从常用框架导入 TensorRT。它还与 ONNX 运行时集成,提供了一种以 ONNX 格式实现高性能推理的简单方法。

基于这些优势,TensorRT目前在深度模型部署应用越来越广泛。但是TensorRT目前只提供了C++与Python接口,对于跨语言使用十分不便。目前C#语言已经成为当前编程语言排行榜上前五的语言,也被广泛应用工业软件开发中。为了能够实现在C#中调用TensorRT部署深度学习模型,我们在之前的开发中开发了TensorRT C# API。虽然实现了该接口,但由于数据传输存在问题,当时开发的版本在应用时存在较大的问题。

基于此,我们开发了TensorRT C# API 2.0版本,该版本在开发时充分考虑了上一版本应用时出现的问题,并进行了改进。为了更加方便开发者使用,在本次更新中增加了对动态输入模型的支持,将在本技术文中详细介绍本次更新内容以及应用案例。

- TensorRT C# API 项目源码:

https://github.com/guojin-yan/TensorRT-CSharp-API.git

- TensorRT C# API 项目应用源码:

https://github.com/guojin-yan/TensorRT-CSharp-API-Samples.git

2. 更新回顾

由于该项目目前还没有完全开发完成,为了更好的方便大家使用,因此会在最新更新后提供给大家最新的资讯。如果大家在使用时有任何疑问,可以阅读之前发布的技术博客:

技术博客一:《最新发布!TensorRT C# API :基于C#与TensorRT部署深度学习模型》

分享了更新版的TensorRT C# API 相关信息,并对扩展接口进行改进,优化哦了模型推理数据加载方式,很大程度上压缩了数据处理时间;同时分型了最新版本的详细使用流程,以及提供了配套的使用案例,方便开发者们进行使用。

3. 动态输入模型支持

在上一版本中,支持了多Bath推理,单其实现方式是导出的推理模型是多Bath的,因此模型推理的Bath是不可更改的。但是目前TensorRT已经支持了动态模型输入,所以更新了对动态输入模型的支持。下面将对更新的API接口以及推理流程进行简单的介绍:

3.1 新增API

public static void OnnxToEngine(string modelPath, int memorySize, string nodeName, Dims minShapes, Dims optShapes, Dims maxShapes)

- 模型转换接口:可以调用封装的TensorRT中的ONNX 解释器,对ONNX模型进行转换,并根据本机设备信息,编译本地模型,将模型转换为TensorRT 支持的engine格式,该接口支持动态输入模型。

- string modelPath: 本地ONNX模型地址,只支持ONNX格式,且ONNX模型必须为确定的输入输出,暂不支持动态输入。

- int memorySize: 模型转换时分配的内存大小。

- string nodeName: 模型输入节点名称,该节点维度确定但是形状是动态的,一般为: [-1, 3 640, 640],某一维度或其中几个维度大小为“-1”。

- Dims minShapes: 动态尺寸的最小允许值

- Dims optShapes: 优化(内核选择)中使用的值、动态尺寸的最优值

- Dims maxShapes: 动态尺寸等的最大允许值

public Nvinfer(string modelPath, int maxBatahSize)

Nvinfer 初始化接口: 初始化Nvinfer类,主要初始化封装的推理引擎,该推理引擎中封装了比较重要的一些类和指针。

string modelPath: engine模型路径。

int maxBatahSize: 推理推理支持的最大的Bath。

public void SetBindingDimensions(int index, Dims dims)/SetBindingDimensions(string nodeName, Dims dims)

- 设置节点维度接口: 通过端口编号或者端口名称,获取绑定的端口的形状信息。

- int index: 绑定端口的编号。

- string nodeName: 绑定端口的名称。

- Dims dims: 需要设置绑定端口的维度。

3.2 推理流程

对于固定输入模型的推理流程,主要包括以下四个步骤:

- Nvinfer初始化

- 加载推理数据

- 模型推理

- 获取推理结果

而当我们使用动态输入模型时,其推理流程发生了变化,如下图所示:

当部署动态输入模型时,推理流程为:

- Nvinfer初始化

- 设置本次推理模型输入大小

- 加载推理数据

- 模型推理

- 获取推理结果

与常规的规定输入模型的推理流程相比,主要是增加了设置本次推理模型输入大小这一步,其他步骤并未发生较大的变化。此外,如果下一次推理输入数据形状大小发生了改变,就需要重新进行设置,如果输入形状大小并未对发生变化,则无需进行再次设置。

4. 接口应用

关于该项目的调用方式在上一篇文章中已经进行了详细介绍,具体使用可以参考《最新发布!TensorRT C# API :基于C#与TensorRT部署深度学习模型》,下面结合Yolov8-cls模型详细介绍一下更新的接口使用方法。

4.1 创建并配置C#项目

首先创建一个简单的C#项目,然后添加项目配置。

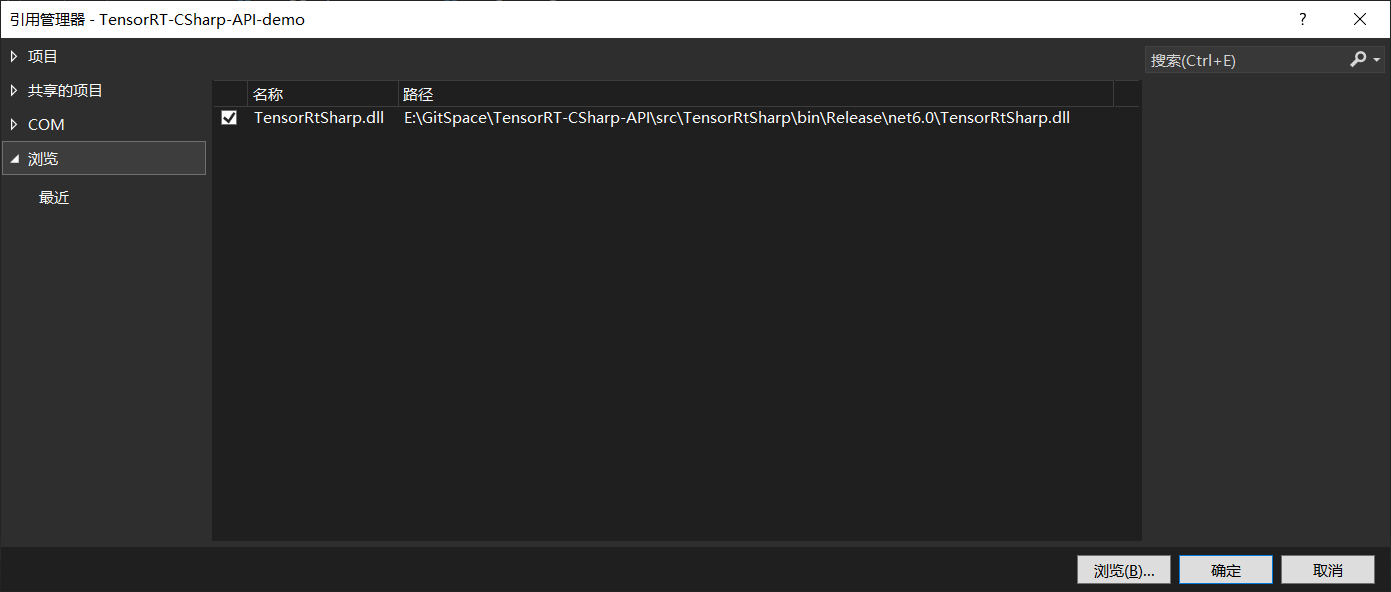

首先是添加TensorRT C# API 项目引用,如下图所示,添加上文中C#项目生成的dll文件即可。

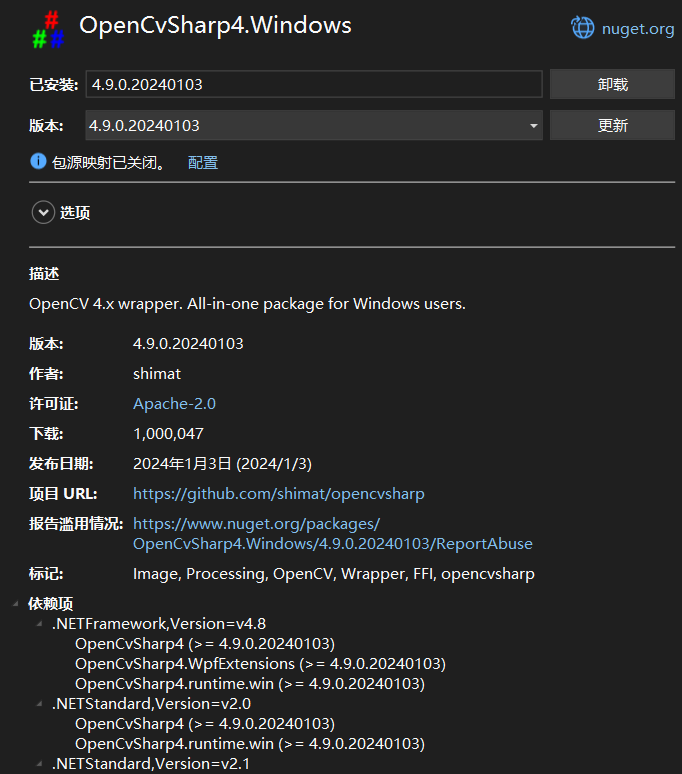

接下来添加OpenCvSharp,此处通过NuGet Package安装即可,此处主要安装以下两个程序包即可:

|

|

配置好项目后,项目的配置文件如下所示:

<Project Sdk="Microsoft.NET.Sdk">

<PropertyGroup>

<OutputType>Exe</OutputType>

<TargetFramework>net6.0</TargetFramework>

<RootNamespace>TensorRT_CSharp_API_demo</RootNamespace>

<ImplicitUsings>enable</ImplicitUsings>

<Nullable>enable</Nullable>

</PropertyGroup>

<ItemGroup>

<PackageReference Include="OpenCvSharp4.Extensions" Version="4.9.0.20240103" />

<PackageReference Include="OpenCvSharp4.Windows" Version="4.9.0.20240103" />

</ItemGroup>

<ItemGroup>

<Reference Include="TensorRtSharp">

<HintPath>E:\GitSpace\TensorRT-CSharp-API\src\TensorRtSharp\bin\Release\net6.0\TensorRtSharp.dll</HintPath>

</Reference>

</ItemGroup>

</Project>

4.2 添加推理代码

此处演示一个简单的图像分类项目,以Yolov8-cls项目为例:

(1) 转换engine模型

动态输入的模型在进行格式转换时,需要指定模型推理形状至此的范围,minShapes表示模型推理支持的最小形状,optShapes表示模型推理支持的最佳形状,maxShapes表示模型推理支持的最大形状,模型转换需要消耗较多时间,最终转换成功后会在模型同级目录下生成相同名字的.engine文件。

Dims minShapes = new Dims(1, 3, 224, 224);

Dims optShapes = new Dims(10, 3, 224, 224);

Dims maxShapes = new Dims(20, 3, 224, 224);

Nvinfer.OnnxToEngine(onnxPath, 20, "images", minShapes, optShapes, maxShapes);

(2) 定义模型预测方法

下面代码是定义的Yolov8-cls模型的预测方法,该方法支持动态Bath输入模型推理,可以根据用户输入图片数量,自动设置输入Bath,然后进行推理。

下面代码与上一篇文章中的代码差异主要是增加了predictor.SetBindingDimensions("images", new Dims(batchNum, 3, 224, 224));这一句代码。同时在初始化时,设置最大支持20Bath,这与上文模型转换时设置的一致。

public class Yolov8Cls

{

public Dims InputDims;

public int BatchNum;

private Nvinfer predictor;

public Yolov8Cls(string enginePath)

{

predictor = new Nvinfer(enginePath, 20);

InputDims = predictor.GetBindingDimensions("images");

}

public void Predict(List<Mat> images)

{

BatchNum = images.Count;

for (int begImgNo = 0; begImgNo < images.Count; begImgNo += BatchNum)

{

DateTime start = DateTime.Now;

int endImgNo = Math.Min(images.Count, begImgNo + BatchNum);

int batchNum = endImgNo - begImgNo;

List<Mat> normImgBatch = new List<Mat>();

int imageLen = 3 * 224 * 224;

float[] inputData = new float[BatchNum * imageLen];

for (int ino = begImgNo; ino < endImgNo; ino++)

{

Mat input_mat = CvDnn.BlobFromImage(images[ino], 1.0 / 255.0, new OpenCvSharp.Size(224, 224), 0, true, false);

float[] data = new float[imageLen];

Marshal.Copy(input_mat.Ptr(0), data, 0, imageLen);

Array.Copy(data, 0, inputData, ino * imageLen, imageLen);

}

predictor.SetBindingDimensions("images", new Dims(batchNum, 3, 224, 224));

predictor.LoadInferenceData("images", inputData);

DateTime end = DateTime.Now;

Console.WriteLine("[ INFO ] Input image data processing time: " + (end - start).TotalMilliseconds + " ms.");

predictor.infer();

start = DateTime.Now;

predictor.infer();

end = DateTime.Now;

Console.WriteLine("[ INFO ] Model inference time: " + (end - start).TotalMilliseconds + " ms.");

start = DateTime.Now;

float[] outputData = predictor.GetInferenceResult("output0");

for (int i = 0; i < batchNum; ++i)

{

Console.WriteLine(string.Format("[ INFO ] Classification Top {0} result : ", 2));

float[] data = new float[1000];

Array.Copy(outputData, i * 1000, data, 0, 1000);

List<int> sortResult = Argsort(new List<float>(data));

for (int j = 0; j < 2; ++j)

{

string msg = "";

msg += ("index: " + sortResult[j] + "\t");

msg += ("score: " + data[sortResult[j]] + "\t");

Console.WriteLine("[ INFO ] " + msg);

}

}

end = DateTime.Now;

Console.WriteLine("[ INFO ] Inference result processing time: " + (end - start).TotalMilliseconds + " ms.\n");

}

}

public static List<int> Argsort(List<float> array)

{

int arrayLen = array.Count;

List<float[]> newArray = new List<float[]> { };

for (int i = 0; i < arrayLen; i++)

{

newArray.Add(new float[] { array[i], i });

}

newArray.Sort((a, b) => b[0].CompareTo(a[0]));

List<int> arrayIndex = new List<int>();

foreach (float[] item in newArray)

{

arrayIndex.Add((int)item[1]);

}

return arrayIndex;

}

}

(3) 预测方法调用

下面是上述定义的预测方法,为了测试不同Bath性能,此处读取了多张图片,并分别预测不同张数图片,如下所示:

Yolov8Cls yolov8Cls = new Yolov8Cls("E:\\Model\\yolov8\\yolov8s-cls_b.engine");

Mat image1 = Cv2.ImRead("E:\\ModelData\\image\\demo_4.jpg");

Mat image2 = Cv2.ImRead("E:\\ModelData\\image\\demo_5.jpg");

Mat image3 = Cv2.ImRead("E:\\ModelData\\image\\demo_6.jpg");

Mat image4 = Cv2.ImRead("E:\\ModelData\\image\\demo_7.jpg");

Mat image5 = Cv2.ImRead("E:\\ModelData\\image\\demo_8.jpg");

yolov8Cls.Predict(new List<Mat> { image1, image2 });

yolov8Cls.Predict(new List<Mat> { image1, image2, image3 });

yolov8Cls.Predict(new List<Mat> { image1, image2, image3, image4 });

yolov8Cls.Predict(new List<Mat> { image1, image2, image3, image4, image5 });

4.3 项目演示

配置好项目并编写好代码后,运行该项目,项目输出如下所示:

[ INFO ] Input image data processing time: 5.5277 ms.

[ INFO ] Model inference time: 1.3685 ms.

[ INFO ] Classification Top 2 result :

[ INFO ] index: 386 score: 0.8754883

[ INFO ] index: 385 score: 0.08013916

[ INFO ] Classification Top 2 result :

[ INFO ] index: 293 score: 0.89160156

[ INFO ] index: 276 score: 0.05480957

[ INFO ] Inference result processing time: 3.0823 ms.

[ INFO ] Input image data processing time: 2.7356 ms.

[ INFO ] Model inference time: 1.4435 ms.

[ INFO ] Classification Top 2 result :

[ INFO ] index: 386 score: 0.8754883

[ INFO ] index: 385 score: 0.08013916

[ INFO ] Classification Top 2 result :

[ INFO ] index: 293 score: 0.89160156

[ INFO ] index: 276 score: 0.05480957

[ INFO ] Classification Top 2 result :

[ INFO ] index: 14 score: 0.99853516

[ INFO ] index: 88 score: 0.0006980896

[ INFO ] Inference result processing time: 1.5137 ms.

[ INFO ] Input image data processing time: 3.7277 ms.

[ INFO ] Model inference time: 1.5285 ms.

[ INFO ] Classification Top 2 result :

[ INFO ] index: 386 score: 0.8754883

[ INFO ] index: 385 score: 0.08013916

[ INFO ] Classification Top 2 result :

[ INFO ] index: 293 score: 0.89160156

[ INFO ] index: 276 score: 0.05480957

[ INFO ] Classification Top 2 result :

[ INFO ] index: 14 score: 0.99853516

[ INFO ] index: 88 score: 0.0006980896

[ INFO ] Classification Top 2 result :

[ INFO ] index: 294 score: 0.96533203

[ INFO ] index: 269 score: 0.0124435425

[ INFO ] Inference result processing time: 2.7328 ms.

[ INFO ] Input image data processing time: 4.063 ms.

[ INFO ] Model inference time: 1.6947 ms.

[ INFO ] Classification Top 2 result :

[ INFO ] index: 386 score: 0.8754883

[ INFO ] index: 385 score: 0.08013916

[ INFO ] Classification Top 2 result :

[ INFO ] index: 293 score: 0.89160156

[ INFO ] index: 276 score: 0.05480957

[ INFO ] Classification Top 2 result :

[ INFO ] index: 14 score: 0.99853516

[ INFO ] index: 88 score: 0.0006980896

[ INFO ] Classification Top 2 result :

[ INFO ] index: 294 score: 0.96533203

[ INFO ] index: 269 score: 0.0124435425

[ INFO ] Classification Top 2 result :

[ INFO ] index: 127 score: 0.9008789

[ INFO ] index: 128 score: 0.07745361

[ INFO ] Inference result processing time: 3.5664 ms.

通过上面输出可以看出,不同Bath模型推理时间在1.3685~1.6947ms,大大提升了模型的推理速度。

5. 总结

在本项目中,我们扩展了TensorRT C# API 接口,使其支持动态输入模型。并结合分类模型部署流程向大家展示了TensorRT C# API 的使用方式,方便大家快速上手使用。

为了方便各位开发者使用,此处开发了配套的演示项目,主要是基于Yolov8开发的目标检测、目标分割、人体关键点识别、图像分类以及旋转目标识别,并且支持动态输入模型,用户可以同时推理任意张图像。

- Yolov8 Det 目标检测项目源码:

https://github.com/guojin-yan/TensorRT-CSharp-API-Samples/blob/master/model_samples/yolov8_custom_dynamic/Yolov8Det.cs

- Yolov8 Seg 目标分割项目源码:

https://github.com/guojin-yan/TensorRT-CSharp-API-Samples/blob/master/model_samples/yolov8_custom_dynamic/Yolov8Seg.cs

- Yolov8 Pose 人体关键点识别项目源码:

https://github.com/guojin-yan/TensorRT-CSharp-API-Samples/blob/master/model_samples/yolov8_custom_dynamic/Yolov8Pose.cs

- Yolov8 Cls 图像分类项目源码:

https://github.com/guojin-yan/TensorRT-CSharp-API-Samples/blob/master/model_samples/yolov8_custom_dynamic/Yolov8Cls.cs

- Yolov8 Obb 旋转目标识别项目源码:

https://github.com/guojin-yan/TensorRT-CSharp-API-Samples/blob/master/model_samples/yolov8_custom_dynamic/Yolov8Obb.cs

同时对本项目开发的案例进行了时间测试,以下时间只是程序运行一次的时间,测试环境为:

CPU:i7-165G7

CUDA型号:12.2

Cudnn:8.9.3

TensorRT:8.6.1.6

| Model | Batch | 数据预处理 (ms) | 模型推理 (ms) | 结果后处理 (ms) |

|---|---|---|---|---|

| Yolov8s-Det | 1 | 16.6 | 4.6 | 13.1 |

| 4 | 38.0 | 12.4 | 32.4 | |

| 8 | 70.5 | 23.0 | 80.1 | |

| Yolov8s-Obb | 1 | 28.7 | 8.9 | 17.7 |

| 4 | 81.7 | 25.9 | 67.4 | |

| 8 | 148.4 | 44.6 | 153.0 | |

| Yolov8s-Seg | 1 | 15.4 | 5.4 | 67.4 |

| 4 | 37.3 | 15.5 | 220.6 | |

| 8 | 78.7 | 26.9 | 433.6 | |

| Yolov8s-Pose | 1 | 15.1 | 5.2 | 8.7 |

| 4 | 39.2 | 13.2 | 14.3 | |

| 8 | 67.8 | 23.1 | 27.7 | |

| Yolov8s-Cls | 1 | 9.9 | 1.3 | 1.9 |

| 4 | 14.7 | 1.5 | 2.3 | |

| 8 | 22.6 | 2.0 | 2.9 |

最后如果各位开发者在使用中有任何问题,欢迎大家与我联系。

TensorRT C# API 项目更新 (1):支持动态Bath输入模型推理的更多相关文章

- 快速创建Flask Restful API项目

前言 Python必学的两大web框架之一Flask,俗称微框架.它只需要一个文件,几行代码就可以完成一个简单的http请求服务. 但是我们需要用flask来提供中型甚至大型web restful a ...

- 【WEB API项目实战干货系列】- API访问客户端(WebApiClient适用于MVC/WebForms/WinForm)(四)

这几天没更新主要是因为没有一款合适的后端框架来支持我们的Web API项目Demo, 所以耽误了几天, 目前最新的代码已经通过Sqlite + NHibernate + Autofac满足了我们基本的 ...

- JAVA WEB快速入门之从编写一个基于SpringBoot+Mybatis快速创建的REST API项目了解SpringBoot、SpringMVC REST API、Mybatis等相关知识

JAVA WEB快速入门系列之前的相关文章如下:(文章全部本人[梦在旅途原创],文中内容可能部份图片.代码参照网上资源) 第一篇:JAVA WEB快速入门之环境搭建 第二篇:JAVA WEB快速入门之 ...

- 从壹开始前后端分离【 .NET Core2.0 +Vue2.0 】框架之七 || API项目整体搭建 6.2 轻量级ORM

更新 1.在使用的时候,特别是更新数据的时候,如果不知道哪里有问题,可以查看数据库 和 实体类 的字段,是否大小写一致,比如 name 和 Name 2.在使用Sqlsugar 的 CodeFirst ...

- 基于SpringBoot的WEB API项目的安全设计

SpringBoot的开箱即用功能,大大降低了上手一个WEB应用的门槛,友好的REST接口支持,在SpringCloud微服务体系中可编程性大大提高,本篇基于一个面向企业调用方用户的WEB API项目 ...

- Z从壹开始前后端分离【 .NET Core2.2/3.0 +Vue2.0 】框架之七 || API项目整体搭建 6.2 轻量级ORM

本文梯子 本文3.0版本文章 前言 零.今天完成的蓝色部分 0.创建实体模型与数据库 1.实体模型 2.创建数据库 一.在 IRepository 层设计接口 二.在 Repository 层实现相应 ...

- Web API项目中使用Area对业务进行分类管理

在之前开发的很多Web API项目中,为了方便以及快速开发,往往把整个Web API的控制器放在基目录的Controllers目录中,但随着业务越来越复杂,这样Controllers目录中的文件就增加 ...

- 在ASP.NET Web API项目中使用Hangfire实现后台任务处理

当前项目中有这样一个需求:由前端用户的一个操作,需要触发到不同设备的消息推送.由于推送这个具体功能,我们采用了第三方的服务.而这个服务调用有时候可能会有延时,为此,我们希望将消息推送与用户前端操作实现 ...

- 【WEB API项目实战干货系列】- 导航篇(十足干货分享)

在今天移动互联网的时代,作为攻城师的我们,谁不想着只写一套API就可以让我们的Web, Android APP, IOS APP, iPad APP, Hybired APP, H5 Web共用共同的 ...

- 【WEB API项目实战干货系列】- API登录与身份验证(三)

上一篇: [WEB API项目实战干货系列]- 接口文档与在线测试(二) 这篇我们主要来介绍我们如何在API项目中完成API的登录及身份认证. 所以这篇会分为两部分, 登录API, API身份验证. ...

随机推荐

- 【Azure 存储服务】存储在Azure Storage Table中的数据,如何按照条件进行删除呢?

问题描述 如何按条件删除 Storage Table 中的数据,如果Table中有大量的条记录需要删除,Java代码如何按条件删除 Table中的数据(Entity)? (通过Azure Storag ...

- 一文上手图数据备份恢复工具 NebulaGraph BR

作者:NebulaGraph 工程师 Kenshin NebulaGraph BR 开源已经有一段时间了,为了给社区用户提供一个更稳.更快.更易用的备份恢复工具,去年对其进行了比较大的重构.Nebul ...

- Hugo 建站经验之谈

前言 建站工具,早已不是一个新颖的话题,抛开可视化建站单论开发层面,各类语言都有推出广受欢迎的建站框架,比如 Python 开发的 Pelican,JavaScript 开发的 Hexo,以及市场份额 ...

- 为什么HashMap的键值可以为null,而ConcurrentHashMap不行?

写在开头 昨天在写<HashMap很美好,但线程不安全怎么办?ConcurrentHashMap告诉你答案!>这篇文章的时候,漏了一个知识点,知道晚上吃饭的时候才凸显想到,关于Concur ...

- 阿里巴巴/1688 api接口 获取商品详情 数据采集

iDataRiver平台 https://www.idatariver.com/zh-cn/ 提供开箱即用的阿里巴巴1688电商数据采集API,供用户按需调用. 接口使用详情请参考阿里巴巴1688接口 ...

- 解决windows11远程连接阿里云Centos7

本地连接CentOs7时报错 Permission denied (publickey,gssapi-keyex,gssapi-with-mic). 网上大部分说的是去修改 vim /etc/ss ...

- 【2302. 统计得分小于 K 的子数组数目】前缀和+二分

class Solution { public static void main(String[] args) { Solution solution = new Solution(); soluti ...

- 云VR:虚拟现实专业化的下一步

传统的VR通常需要功能强大的计算机和其他高性能设备来提供良好的用户体验.但是,如果有一种方法可以从任何设备和任何地方处理VR内容呢?这就是云VR对VR用户的承诺.随着5G和其他网络的到来,VR技术的未 ...

- 三维模型3DTile格式轻量化压缩集群处理方法分析

三维模型3DTile格式轻量化压缩集群处理方法分析 在地理信息系统中,由于三维模型的数据密度和文件体积较大,因此需要进行轻量化和压缩处理.这里我们将对使用集群处理方法来实现3D Tiles数据的轻量化 ...

- 记录--vue中动态引入图片为什么要是require, 你不知道的那些事

这里给大家分享我在网上总结出来的一些知识,希望对大家有所帮助 相信用过vue的小伙伴,肯定被面试官问过这样一个问题:在vue中动态的引入图片为什么要使用require 有些小伙伴,可能会轻蔑一笑:呵, ...