斯坦福机器学习视频笔记 Week1 Linear Regression and Gradient Descent

最近开始学习Coursera上的斯坦福机器学习视频,我是刚刚接触机器学习,对此比较感兴趣;准备将我的学习笔记写下来,

作为我每天学习的签到吧,也希望和各位朋友交流学习。

这一系列的博客,我会不定期的更新,希望大家多多批评指正。

Supervised Learning(监督学习)

在监督学习中,我们的数据集包括了算法的输出结果,比如具体的类别(分类问题)或数值(回归问题),输入和输出存在某种对应关系。

监督学习大致可分为回归(classification)和分类(regression)。

回归:对于连续型数值的预测;

分类:对于离散输出的预测,输出为某些具体的类别;

Unsupervised Learning(无监督学习)

在无监督学习中,我们对于输出的结果一无所知,根据数据的内在结构将数据聚类,我们无法得到预测结果的反馈。

总结:监督学习和无监督学习的重要区别,数据集的输出结果是否事先知道。

课程pdf:https://www.coursera.org/learn/machine-learning/supplement/d5Pt1/lecture-slides

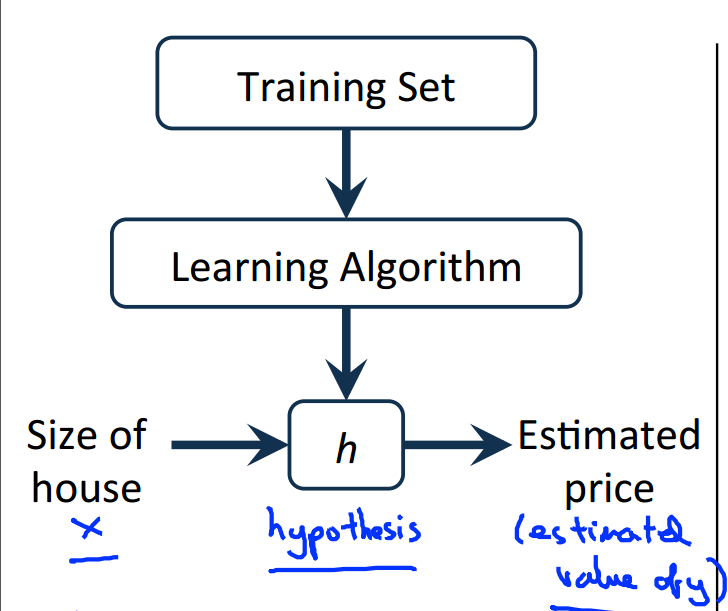

Model Representation(模型表示)

以上是监督学习问题的图示描述,我们的目标是,给定训练集,学习函数h:X→Y,使得h(x)是对于y有较好的预测值。

h(x)代表的是一个假设集合(Hypothesis ),我们要做的就是从这个假设集合中找出预测效果最好的那一个假设。

下面是后文将用到的符号表示,请务必明白其表示的意思,这个不难。

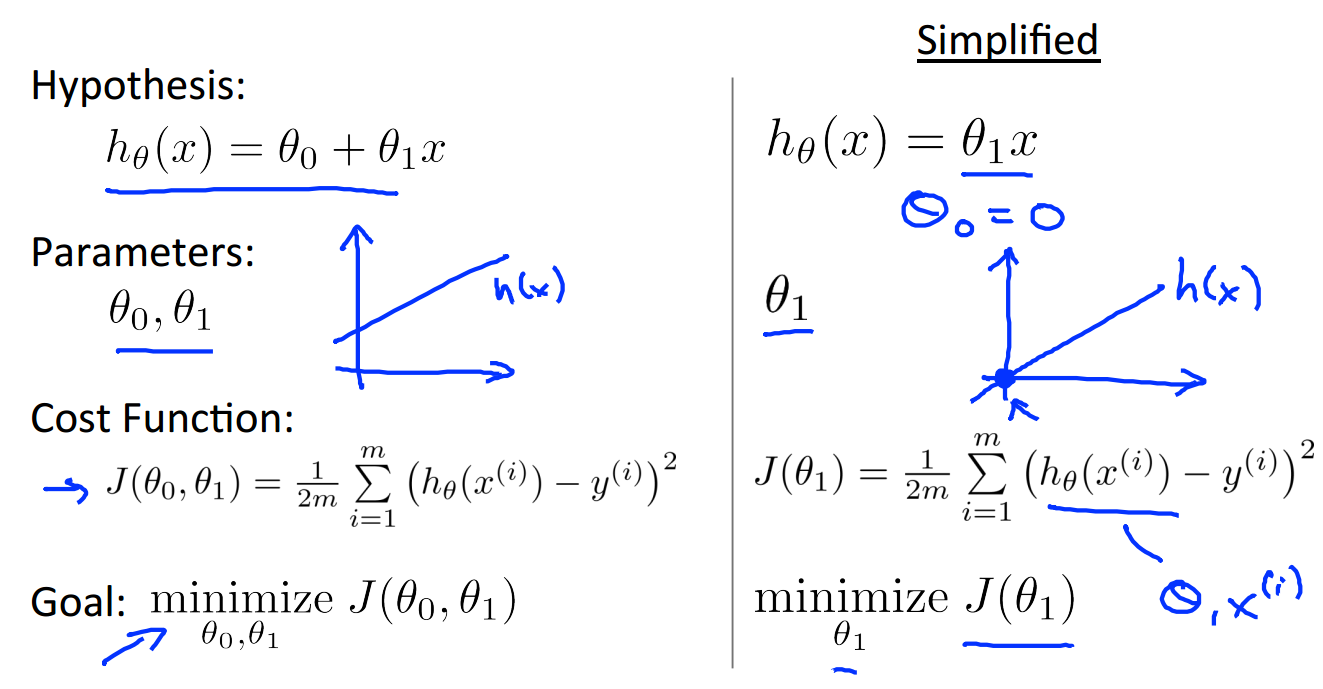

Cost Function(损失函数)

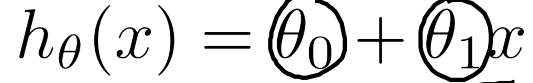

之前举的例子,关于房价的预测问题,是一个单变量的回归问题,输入数据只有x维度为1,

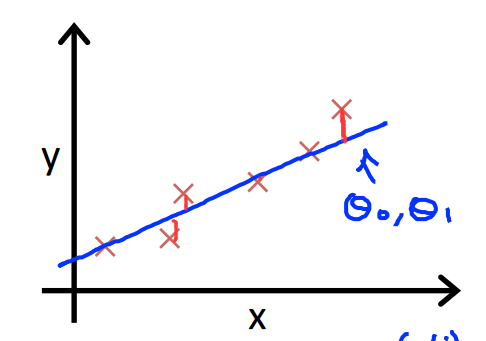

我们建立的模型是 ,我们的目标是让这个直线尽可能的拟合所有数据,

,我们的目标是让这个直线尽可能的拟合所有数据,

即从数据的中心穿过,让我们的每个预测值h(x)与我们的已知数值y尽可能的接近。

那么,我们应该怎么选择最好的模型呢?通过求解参数theta1和theta2.

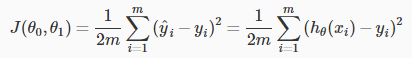

我们可以通过使用 cost function(损失函数)来测量我们的假设的准确性。 这需要使用来自x的输入

和实际输出y的假设的所有结果的平均差(实际上是平均值的更好的版本),如下。

说明:其实损失函数 J 计算的是h(x)与真实值y之间的垂直距离的平方和均值。

关于为什么多一个1/2的问题,是为了以后求导方便,不用太在意这个。

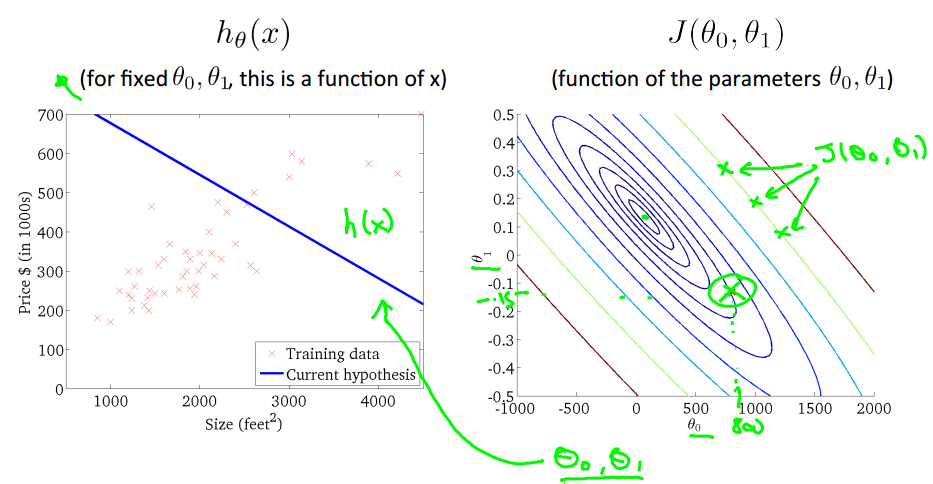

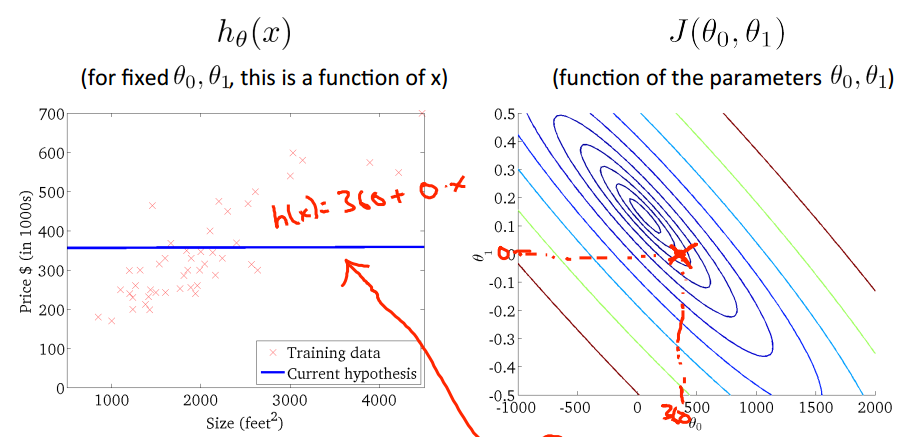

为了问题描述的方便,首先使用上图右边的简单模型,只有一个参数theta1.

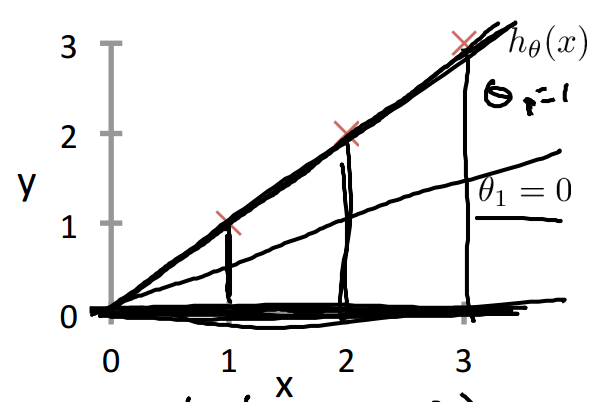

下图是对数据样本点”X“的拟合状态,

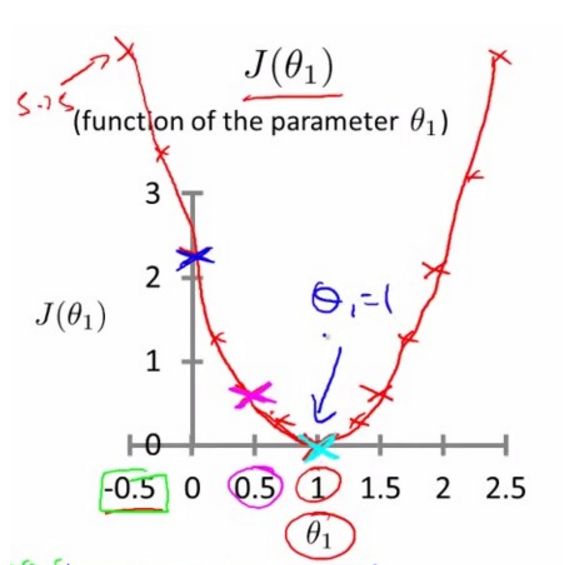

当在上图中我们随意旋转h(x),将会得到不同的 J 值,可以得到下面的关于theta1 损失函数 J 的图像:

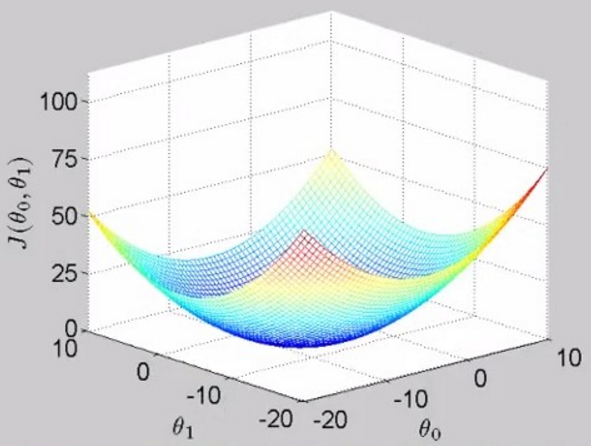

当同时考虑两个参数值 theta1和theta0时,损失函数的图像是这样的,被称为bowl-shape function,碗状的

下图的右边是上面三维图像的二维展示,那一圈一圈的椭圆被称为“等高线”(类似地理上的等高线),每一个椭圆上的不同点的 J 值都是相等的,

如图中绿色椭圆上的三个点,越靠近中心的椭圆 J 值越小。

上面左图对应的是右图中用绿色圆圈标注的点(theta1=800,theta0=-1.5),对应的模型h(x)的图像,右图中每一个不同的点,

都会在左图中对应一个不同的图像,如下:

当然,我们理想的情况是类似上图的情况,我们取的(theta1,theta0)出现图中的中心theta0=450,theta1=0.12,

在这个点可以是损失函数达到最小,趋近于0.这样我们就求得了模型参数theta0和theta1,进而得到最佳的假设h(x)。

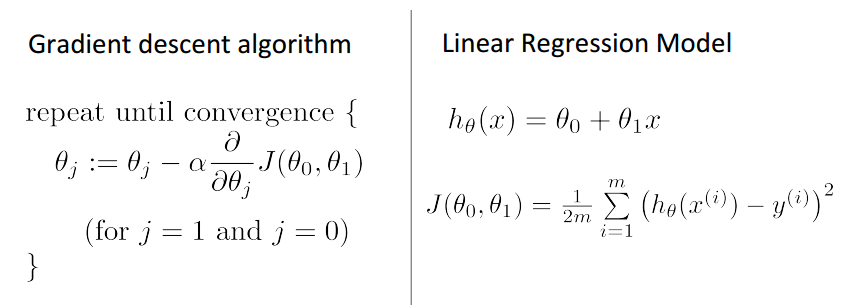

Gradient Descent(梯度下降)

我们有了假设模型h(x),和损失函数 J,现在来讨论如何求得theta1和theta0的方法,梯度下降。我们的问题描述如下:

需要不断迭代,求得使损失函数 J 达到最小的theta1和theta0.

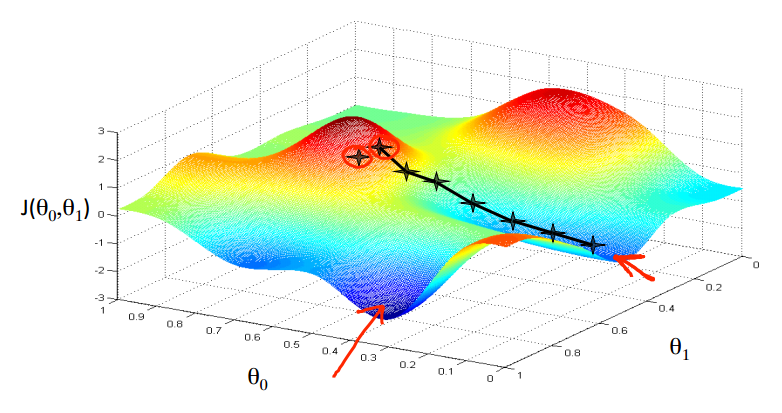

关于梯度下降的理解:

假设你现在站在两座山包上的其中一座,你需要以最快的速度下到山的最低处。每到达一个新的地方,

都选择在该点处梯度最大的方向下山即可。如图:

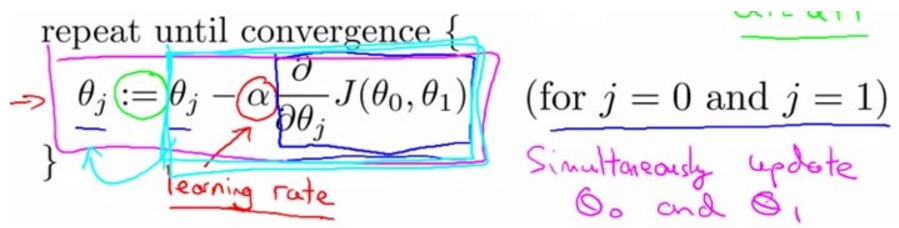

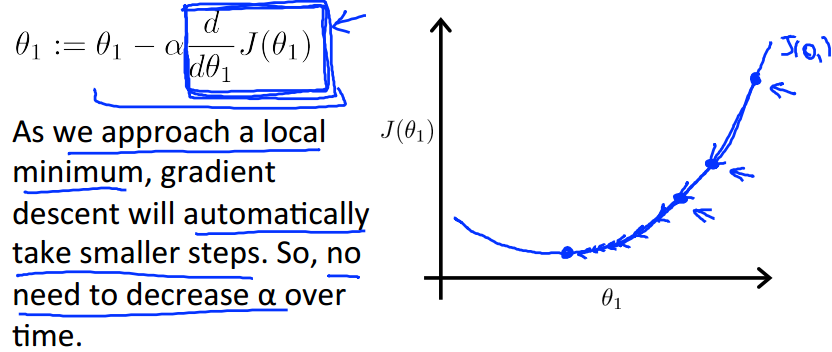

梯度下降算法表示如下:其中标出了梯度(蓝框内)和学习率(α > 0),梯度在这里通俗的说就是函数 J 的偏导数。

注意:梯度下降算法对局部最小值敏感,梯度下降可能收敛在局部最小,不能保证收敛到全局最小值。

说明:在计算机科学中,x:=x+y表示,先计算x+y的结果再赋值给变量x,类似先计算a=x+y,然后使x的值等于a。

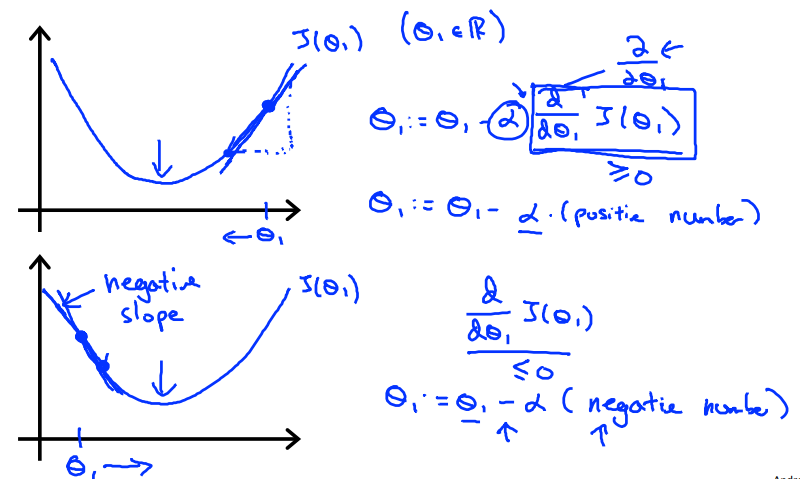

下图为梯度为正、负的情况,theta的更新是不一样的:

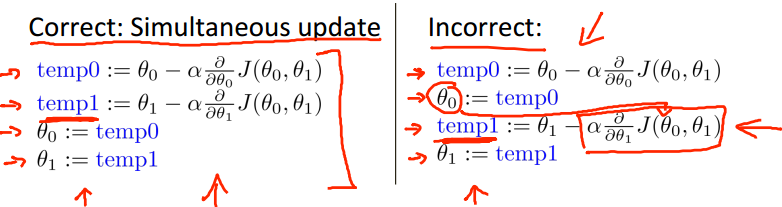

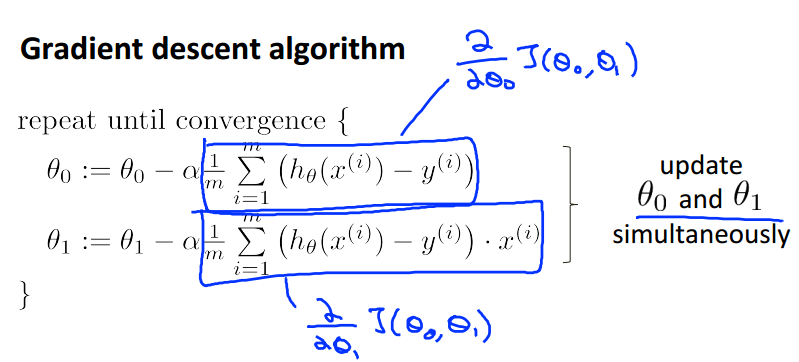

关于参数更新的问题,theta1和theta2必须同时更新,下图左边为正解,即不能使用更新过后的theta0来进一步更新theta1

(这将是后面要讲到了另一种算法)。

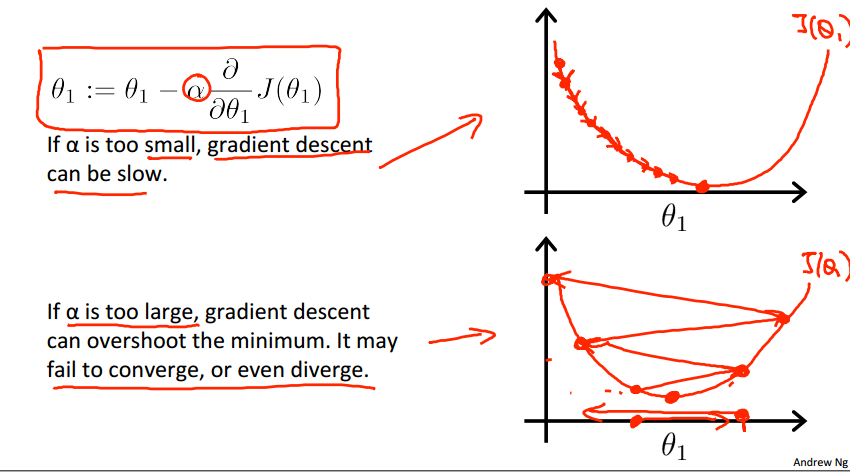

关于学习率α的问题:

当a过小的时候,迭代步长太小,梯度下降得太慢;

当a过大的时候,迭代步长过大,梯度无法收敛到最小值,而发生左右震荡的现象。

当固定a时,梯度下降法依然可以收敛到最小值(局部),

因为,当我们越靠近最小值时,我们的 梯度 越小,反应在上图就是越来越平缓,所以上面蓝色方框中的表达式会越来越小,

然后乘上a也越来越小,证明我们迭代的步长会逐步变小,即使我们使用的是固定不变的学习率a。

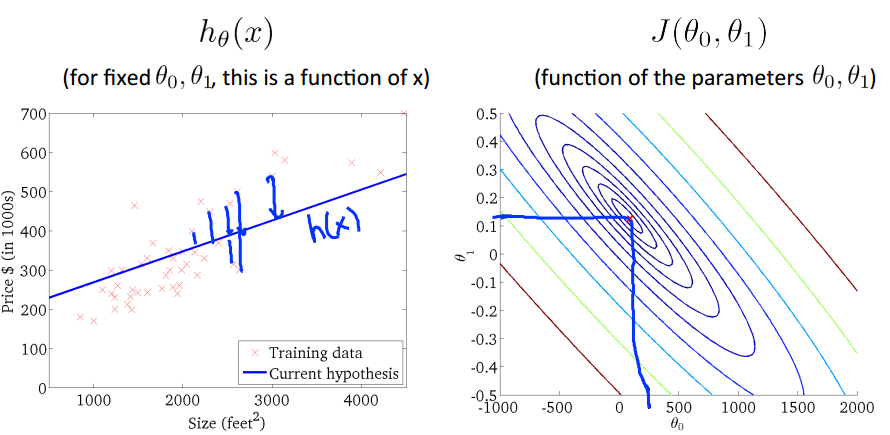

Gradient Descent For Linear Regression

(在线性回归中使用梯度下降)

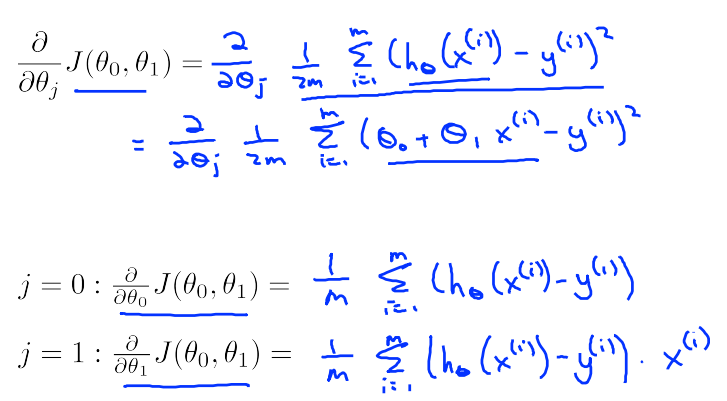

其推导过程如下,分别对 J 求 关于theta0和theta1的偏导数:

得到下面应用于线性回归的梯度下降算法:

通过对以上算法的不断迭代,我们求得了最好的假设h(x),其中红色“x”的轨迹,就是算法迭代的过程。

注:上面提到的梯度下降算法叫做“Batch” Gradient Descent,批梯度下降算法(翻译可能有所不同),其每一次迭代都需要使用整个数据集,

所以其效率不高,后面会学习到它的改进算法,随机梯度下降。

参考文献:http://blog.csdn.net/abcjennifer/article/details/7691571

斯坦福机器学习视频笔记 Week1 Linear Regression and Gradient Descent的更多相关文章

- 斯坦福机器学习视频笔记 Week1 线性回归和梯度下降 Linear Regression and Gradient Descent

最近开始学习Coursera上的斯坦福机器学习视频,我是刚刚接触机器学习,对此比较感兴趣:准备将我的学习笔记写下来, 作为我每天学习的签到吧,也希望和各位朋友交流学习. 这一系列的博客,我会不定期的更 ...

- Linear Regression Using Gradient Descent 代码实现

参考吴恩达<机器学习>, 进行 Octave, Python(Numpy), C++(Eigen) 的原理实现, 同时用 scikit-learn, TensorFlow, dlib 进行 ...

- 斯坦福机器学习视频笔记 Week2 多元线性回归 Linear Regression with Multiple Variables

相比于week1中讨论的单变量的线性回归,多元线性回归更具有一般性,应用范围也更大,更贴近实际. Multiple Features 上面就是接上次的例子,将房价预测问题进行扩充,添加多个特征(fea ...

- 斯坦福机器学习视频笔记 Week3 逻辑回归与正则化 Logistic Regression and Regularization

我们将讨论逻辑回归. 逻辑回归是一种将数据分类为离散结果的方法. 例如,我们可以使用逻辑回归将电子邮件分类为垃圾邮件或非垃圾邮件. 在本模块中,我们介绍分类的概念,逻辑回归的损失函数(cost fun ...

- Coursera台大机器学习课程笔记8 -- Linear Regression

之前一直在讲机器为什么能够学习,从这节课开始讲一些基本的机器学习算法,也就是机器如何学习. 这节课讲的是线性回归,从使Ein最小化出发来,介绍了 Hat Matrix,要理解其中的几何意义.最后对比了 ...

- 斯坦福机器学习视频笔记 Week8 无监督学习:聚类与数据降维 Clusting & Dimensionality Reduction

监督学习算法需要标记的样本(x,y),但是无监督学习算法只需要input(x). 您将了解聚类 - 用于市场分割,文本摘要,以及许多其他应用程序. Principal Components Analy ...

- 线性回归、梯度下降(Linear Regression、Gradient Descent)

转载请注明出自BYRans博客:http://www.cnblogs.com/BYRans/ 实例 首先举个例子,假设我们有一个二手房交易记录的数据集,已知房屋面积.卧室数量和房屋的交易价格,如下表: ...

- Linear Regression and Gradient Descent

随着所学算法的增多,加之使用次数的增多,不时对之前所学的算法有新的理解.这篇博文是在2018年4月17日再次编辑,将之前的3篇博文合并为一篇. 1.Problem and Loss Function ...

- Linear Regression and Gradient Descent (English version)

1.Problem and Loss Function Linear Regression is a Supervised Learning Algorithm with input matrix ...

随机推荐

- 最受欢迎web前端技术总结

Web前端技术发展非常快,主流技术的进步.想想刚毕业那会用asp技术.目前,该网站已经非常少见主流应用. 后来的后来J2EE框架.然后SpringMVC声望,然而,最近的各种js框架广泛传播,Html ...

- KNN算法的理解

一.算法 1.kNN算法又称为k近邻分类(k-nearest neighbor classification)算法. 最简单平庸的分类器或许是那种死记硬背式的分类器,记住全部的训练数据.对于新的数据则 ...

- Oracle中的Union、Union All、Intersect、Minus

Oracle中的Union.Union All.Intersect.Minus 众所周知的几个结果集集合操作命令,今天详细地测试了一下,发现一些问题,记录备考. 假设我们有一个表Student,包括 ...

- 64位平台支持大于2 GB大小的数组

64位平台支持大于2 GB大小的数组 64位平台.NET Framework数组限制不能超过2GB大小.这种限制对于需要使用到大型矩阵和向量计算的工作人员来说,是一个非常大问题. 无论RAM容量有多大 ...

- Google Dataflow

十分钟了解分布式计算:Google Dataflow 介绍 Google Cloud Dataflow是一种构建.管理和优化复杂数据处理流水线的方法,集成了许多内部技术,如用于数据高效并行化处理的Fl ...

- 数据类型和typeof操作符

虽然学习js有一段时间了,但是对js的基础语法却是有些生疏.最近在看jquery源码,决定随带总结一些基础的语法知识.今天总结一下数据类型和typeof,这在写js的时候,是不得不知道的知识. 数据类 ...

- EasyUi的快速开发框架

基于EasyUi的快速开发框架 先看图,下边这个简单的增.删.改.查,如果自己写代码实现,这两个页需要多少行代码? 如果再有类似的增.删.改.查,又需要多少行代码? 我最近搞的这个快速开发框架中, ...

- sql之T-SQL

sql之T-SQL 下面就T-SQL的几个方面来分别讲解一下. 1.变量 要动态的写sql语句,就不能没有变量. 声明变量并赋值: 1 declare @i as int;--定义一个 int 类 ...

- sprinfmvc学习--01

springmvc框架是一个基于请求驱动的web框架,使用了前端控制器模式来设计.根据请求映射规则分发给相应的页面控制器进行处理. 1. 首先用户发送请求-->DispatcherServle ...

- Vnix的Logo设计

又捣鼓了一下Logo,感觉Ascii Design碉堡了.下面贴出几款Logo以供观赏,欢迎投票. ## ## ## ## #### ## ## ## ## ### ## ## ## ## ## ## ...