[CDH] New project for ML pipeline

启动后台服务: [CDH] Cloudera's Distribution including Apache Hadoop

这里只介绍一些基本的流程,具体操作还是需要实践代码。

一、开发环境配置

JDK安装

Ref: Ubuntu安装jdk8的两种方式

(base) hadoop@unsw-ThinkPad-T490:jvm$ java -version

java version "1.8.0_231"

Java(TM) SE Runtime Environment (build 1.8.0_231-b11)

Java HotSpot(TM) -Bit Server VM (build 25.231-b11, mixed mode) (base) hadoop@unsw-ThinkPad-T490:jvm$ javac -version

javac 1.8.0_231

然后,Project Structure --> SDKs --> 配置为新jdk。

Scala插件安装

Setting --> Plugins

Maven更新

"Error:(5, 37) java: 程序包org.apache.ibatis.annotations不存在"

不要使用IDE内嵌的Maven,因为IDE内嵌的版本不一定一致,而版本不一致很容易导致构建行为的不一致。

项目Maven版本号在哪里体现?如何更新呢?

Goto: 修改Idea默认的maven版本

Spring-boot依赖

IDEA Cannot access alimaven (http://maven.aliyun.com/nexus/content/groups/public/)

可能有用,也可能没用。改为Settings --> maven --> Work offline

二、Maven和包依赖

Ref: Maven 教程

1. Maven POM

POM ( Project Object Model,项目对象模型 ) 是 Maven 工程的基本工作单元,是一个XML文件,包含了项目的基本信息,用于描述项目如何构建,声明项目依赖,等等。

执行任务或目标时,Maven 会在当前目录中查找 POM。它读取 POM,获取所需的配置信息,然后执行目标。

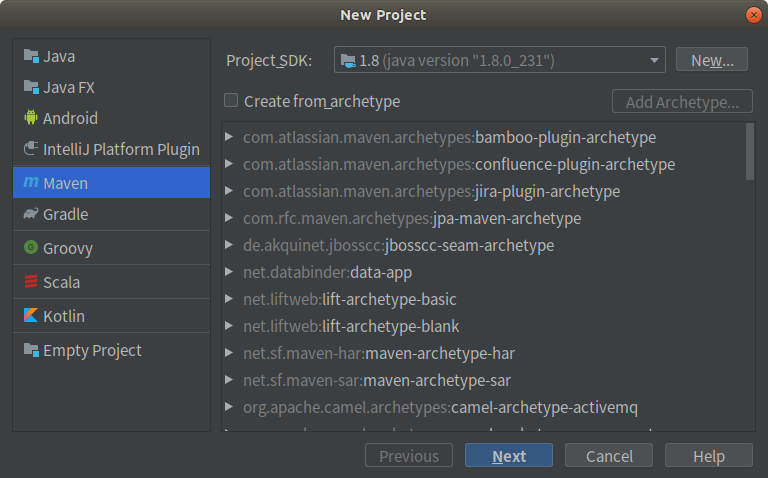

2. 新建项目以及模块

New Project --> maven

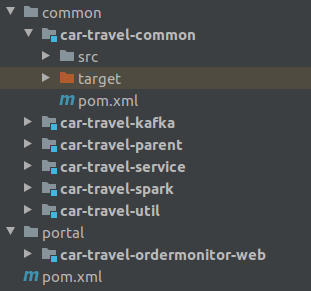

New Module --> maven // 若干模块可以拖拉到统一的文件夹内,相应的配置文件会自动编辑好。

然后根据如下模块图,依次添加模块。

建立模板代码,web作为“入口”。

3. 模块 "配置" 文件

Spark相关的配置: pom.xml --> https://www.runoob.com/maven/maven-pom.html

(1) 基本要素样例

<project xmlns = "http://maven.apache.org/POM/4.0.0"

xmlns:xsi = "http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation = "http://maven.apache.org/POM/4.0.0

http://maven.apache.org/xsd/maven-4.0.0.xsd"> <!-- 模型版本 -->

<modelVersion>4.0.0</modelVersion>

<!-- 公司或者组织的唯一标志,并且配置时生成的路径也是由此生成, 如com.companyname.project-group,maven会将该项目打成的jar包放本地路径:/com/companyname/project-group -->

<groupId>com.companyname.project-group</groupId> <!-- 项目的唯一ID,一个groupId下面可能多个项目,就是靠artifactId来区分的 -->

<artifactId>project</artifactId> <!-- 版本号 -->

<version>1.0</version>

</project>

(2) 子模块"目录"

<?xml version="1.0" encoding="UTF-8"?>

<project xmlns="http://maven.apache.org/POM/4.0.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<modelVersion>4.0.0</modelVersion> <groupId>car-travel</groupId>

<artifactId>car-travel</artifactId>

<packaging>pom</packaging>

<version>1.0-SNAPSHOT</version>

<modules>

<module>car-travel-common</module>

</modules> </project>

(3) 子模块"内容"

<?xml version="1.0" encoding="UTF-8"?>

<project xmlns="http://maven.apache.org/POM/4.0.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<parent>

<groupId>car-travel</groupId>

<artifactId>car-travel-parent</artifactId>

<version>1.0-SNAPSHOT</version>

<relativePath>../car-travel-parent/pom.xml</relativePath>

</parent>

<modelVersion>4.0.0</modelVersion> <artifactId>car-travel-spark</artifactId> <dependencies>

<!--spark 离线任务 核心依赖-->

<dependency>

<groupId>org.apache.spark</groupId>

<artifactId>spark-core_${scala.binary.version}</artifactId>

<version>${spark.version}</version>

</dependency> <!--spark 实时任务 核心依赖-->

<dependency>

<groupId>org.apache.spark</groupId>

<artifactId>spark-streaming_${scala.binary.version}</artifactId>

<version>2.1.0</version>

</dependency> <!--spark streaming 和 kafka集成 的依赖配置-->

<dependency>

<groupId>org.apache.spark</groupId>

<artifactId>spark-streaming-kafka-0-10_${scala.binary.version}</artifactId>

<version>${spark.version}</version>

</dependency> <!--依赖本项目中的module开始-->

<dependency>

<groupId>car-travel</groupId>

<artifactId>car-travel-util</artifactId>

<version>1.0-SNAPSHOT</version>

<exclusions>

<exclusion>

<artifactId>slf4j-api</artifactId>

<groupId>org.slf4j</groupId>

</exclusion>

</exclusions>

</dependency>

</dependencies> </project>

(4) 包依赖

Ref: Maven 引入外部依赖

Ref: Maven添加外部依赖【Maven无能为力,无法自动下载时】

Ref: maven可选依赖(Optional Dependencies)和依赖排除(Dependency Exclusions)

<dependency>

<groupId>org.apache.kafka</groupId>

<artifactId>kafka_2.11</artifactId>

<version>2.0.1</version>

<exclusions>

<exclusion>

<groupId>org.apache.zookeeper</groupId>

<artifactId>zookeeper</artifactId>

</exclusion>

<exclusion>

<groupId>org.xerial.snappy</groupId>

<artifactId>snappy-java</artifactId>

</exclusion>

</exclusions>

</dependency>

(5) Maven右边栏依赖检测

/* implement */

三、"测试" 子模块

这里若是 "测试spark模块" 的话,需要安装scala,使该模块支持Scala语言。

Spark环境配置的测试代码样例。

package spark.examples import org.apache.spark.rdd.RDD

import org.apache.spark.{SparkConf, SparkContext} class WordCount { } object WordCount {

def main(args: Array[String]): Unit = {

//1.创建spark的配置对象

val sparkConf = new SparkConf().setAppName("SparkWordCount").setMaster("local");

//2.创建spark context的上下文

val sc = new SparkContext(sparkConf); //3.使用spark上下文的api接口textFile读取文件形成spark数据处理模型RDD

val linesRDD: RDD[String] = sc.textFile("C:\\work_space\\car-travel\\common\\car-travel-spark\\src\\test\\scala\\words")

//4.对RDD每一行行进行分割(使用空格分割)

val wordArrayRdd = linesRDD.map(_.split(" "))

//5.分割完成之后,我们做一下扁平化,把多维集合转化为一维集合

val wordsRDD = wordArrayRdd.flatMap(x => x)

//6.单词计数,出现一次计数一个1

// val wordCount = wordsRDD.map((_,1))

val wordCount = wordsRDD.map(word => {

(word,1)

}) //7.最关键的一步就是对单词的所有计数进行汇总

()

val restCount = wordCount.reduceByKey(_ + _) restCount.foreach(println(_))

restCount.checkpoint()

restCount.persist()

sc.stop();

}

}

End.

[CDH] New project for ML pipeline的更多相关文章

- 使用spark ml pipeline进行机器学习

一.关于spark ml pipeline与机器学习 一个典型的机器学习构建包含若干个过程 1.源数据ETL 2.数据预处理 3.特征选取 4.模型训练与验证 以上四个步骤可以抽象为一个包括多个步骤的 ...

- spark ML pipeline 学习

一.pipeline 一个典型的机器学习过程从数据收集开始,要经历多个步骤,才能得到需要的输出.这非常类似于流水线式工作,即通常会包含源数据ETL(抽取.转化.加载),数据预处理,指标提取,模型训练与 ...

- Spark ML Pipeline简介

Spark ML Pipeline基于DataFrame构建了一套High-level API,我们可以使用MLPipeline构建机器学习应用,它能够将一个机器学习应用的多个处理过程组织起来,通过在 ...

- spark ml pipeline构建机器学习任务

一.关于spark ml pipeline与机器学习一个典型的机器学习构建包含若干个过程 1.源数据ETL 2.数据预处理 3.特征选取 4.模型训练与验证 以上四个步骤可以抽象为一个包括多个步骤的流 ...

- 使用 ML Pipeline 构建机器学习工作流

http://www.ibm.com/developerworks/cn/opensource/os-cn-spark-practice5/

- Spark.ML之PipeLine学习笔记

地址: http://spark.apache.org/docs/2.0.0/ml-pipeline.html Spark PipeLine 是基于DataFrames的高层的API,可以方便用户 ...

- ML Pipelines管道

ML Pipelines管道 In this section, we introduce the concept of ML Pipelines. ML Pipelines provide a uni ...

- Spark ML机器学习

Spark提供了常用机器学习算法的实现, 封装于spark.ml和spark.mllib中. spark.mllib是基于RDD的机器学习库, spark.ml是基于DataFrame的机器学习库. ...

- Spark的MLlib和ML库的区别

机器学习库(MLlib)指南 MLlib是Spark的机器学习(ML)库.其目标是使实际的机器学习可扩展和容易.在高层次上,它提供了如下工具: ML算法:通用学习算法,如分类,回归,聚类和协同过滤 特 ...

随机推荐

- troubshooting-sqoop 导出 TiDB表数据报com.mysql.jdbc.exceptions.jdbc4.CommunicationsException: Communications link failure

2019-11-22 17:15:27,705 FATAL [IPC Server handler 13 on 44844] org.apache.hadoop.mapred.TaskAttemptL ...

- 在线p图网址

在线P图网址 如果你是简易的P图,不用那么麻烦的去下载安装Photoshop,可以使用以下网址在线编辑 https://www.uupoop.com/ps/?hmsr=ps_menu

- jedis五种数据类型的方法解释

常用命令 1)连接操作命令 quit:关闭连接(connection) auth:简单密码认证 help cmd: 查看cmd帮助,例如:help quit 2)持久化 save:将数据同步保存到磁盘 ...

- Ubuntu在命令行安装显卡驱动

Ubuntu在命令行安装显卡驱动 1.进入电脑的BIOS,把Security Boot设置为Disabled. 2.进入终端,输入一以下命令(这里以安装NVIDIA-390进行演示) sudo add ...

- Shell 语法报错记录

sh: missing ] if 条件语句 “或”多个条件并行时 执行then命令 变量a等于aa且变量b等于bb 或者 变量c等于cc且变量d等于dd 这样的条件成立的话,输出success if ...

- PAT乙级1042

题目链接 https://pintia.cn/problem-sets/994805260223102976/problems/994805280817135616 题解 用数组count存储字母出现 ...

- PAT乙级1039

题目链接 https://pintia.cn/problem-sets/994805260223102976/problems/994805283241443328 题解 用两个字符串表示两个箱子,一 ...

- MyBatis-06-日志

6.日志 6.1.日志工厂 如果一个数据库操作,出现了异常,我们需要排错.日志就是最好的助手! 曾经:sout.debug 现在:日志工厂 SLF4J LOG4J[掌握] LOG4J2 JDK_LOG ...

- 浅析Json底层

在开始了解Json的原理之前,首先看一段代码,在这里以阿里的FastJson为例. public class JsonRun { public static void main(String[] ar ...

- HDU 6061 - RXD and functions | 2017 Multi-University Training Contest 3

每次NTT都忘记初始化,真的是写一个小时,Debug两个小时- - /* HDU 6061 - RXD and functions [ NTT ] | 2017 Multi-University Tr ...