浅谈 PCA与SVD

前言

在用数据对模型进行训练时,通常会遇到维度过高,也就是数据的特征太多的问题,有时特征之间还存在一定的相关性,这时如果还使用原数据训练模型,模型的精度会大大下降,因此要降低数据的维度,同时新数据的特征之间还要保持线性无关,这样的方法称为主成分分析(Principal component analysis,PCA),新数据的特征称为主成分,得到主成分的方法有两种:直接对协方差矩阵进行特征值分解和对数据矩阵进行奇异值分解(SVD)。

一、主成分分析基本思想

数据X由n个特征降维到k个特征,这k个特征保留最大信息(方差)。对原坐标系中的数据进行主成分分析等价于进行坐标系的旋转变化,将数据投影到新的坐标系下,新坐标系的第一坐标轴表示第一主成分,第二坐标轴表示第二主成分,以此类推。数据在每一轴上的坐标值的平方表示相应变量的方差,PCA的目标就是方差最大的变量,才能保留尽可能多的信息,因为方差越大,表示数据分散程度越大,所包含的信息也就越多。

二、PCA的基本步骤

- step1:对数据进行规范化(也称为标准化),因为涉及距离计算,因此要消除量纲的影响;

这里的数据标准化采用z-score:X = X - mean(X) / std(X) - step2:对数据X进行旋转变化(前言提到的两种方法)

三、数学推导

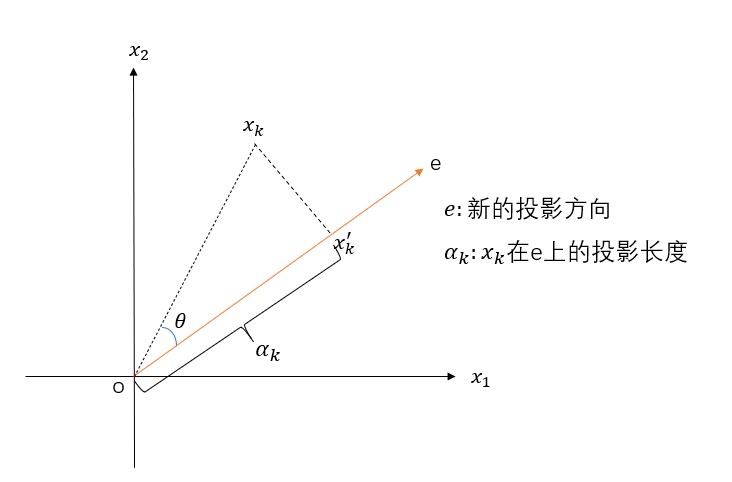

假设X是m*n的矩阵,\(x_k\)是投影前的数据(k=1,2,…,n),\(x_k^{'}\)是投影后的数据,e是新的坐标轴。投影长度\(α_k=e^tx_k\),可以将\(e^t\)看成是cosθ,新数据\(x_k^{'}\)在新坐标轴e下的坐标为\(α_k e\),表示从原点出发,沿着e方向走了\(α_k\)距离。根据方差最大的原则,即\(α_k\)要最大,由勾股定理\(\alpha_k^2+\left \| x_kx_k{'}\right \|^2=\left\|o x_k\right\|^2\)可知,当\(α_k\)最大时,\(\left\|x_kx_k^{'}\right\|^2\)要最小,因此转换成求\(\left\|x_kx_k^{'}\right\|^2\)最小,约束条件是\(\left\|e\right\|=1\),数学表达式为:

min J(e)=\sum_{i=1}^n\left\|x_k^{'}-x_k\right\|^2\\

s.t. \left\|e\right\|=1

\end{cases}

\]

1. 完整的数学推导(结合第一部分的图)

\(min J(e)\\

=\sum_{i=1}^n\left\|x_k^{'}-x_k\right\|^2\\

=\sum_{i=1}^n\left\|\alpha_ke-x_k\right\|^2\\

=\sum_{i=1}^n\alpha_k^2\left\|e\right\|^2 - 2\sum_{i=1}^n\alpha_ke^tx_k + \sum_{i=1}^n\left\|x_k\right\|^2\\

=\sum_{i=1}^n\alpha_k^2-2\sum_{i=1}^n\alpha_k^2+\sum_{i=1}^n\left\|x_k\right\|^2\\

=-\sum_{i=1}^n\alpha_k^2+\sum_{i=1}^n\left\|x_k\right\|^2\\

=-\sum_{i=1}^ne^tx_kx_k^te+\sum_{i=1}^n\left\|x_k\right\|^2\)

要使\(-\sum_{i=1}^ne^tx_kx_k^te+\sum_{i=1}^n\left\|x_k\right\|^2\)最小,由于\(\sum_{i=1}^n\left\|x_k\right\|^2\)不包含e,因为转换为求\(\sum_{i=1}^ne^tx_kx_k^te\)的最大值,同时记\(S=\sum_{i=1}^nx_kx_k^t\),实际上,S是协方差X的协方差矩阵,问题可转化为

max\quad e^tSe\\

s.t. \quad \left\|e\right\|=1

\end{cases}

\]

对于上述优化问题,可以用拉格朗日乘子法求解:\(u=e^tSe-\lambda(e^te-1),\frac{\partial u}{\partial e} = 2Se-2\lambda e=0\),解得:\(Se = \lambda e\)

可以看出,满足条件的投影方向e(k个)是协方差矩阵S的前k大特征值对应的特征向量,因此PCA转化为求数据X的协方差矩阵的特征值,将特征值降序排序,对应的特征向量构成的矩阵就是所求的旋转矩阵

2. 求旋转矩阵

- 基于特征值求解

- 基于奇异值分解SVD

2.1 基于特征值求解

就是一般的矩阵求特征值和特征向量的问题,此处不做详细介绍,需要注意的是,是对数据X的协方差矩阵\(X^TX\)求特征值和特征向量,前k个特征向量构成的矩阵P(此处默认P已经按照特征值的大小顺序进行排列,维度为n*k),那么新数据\(newX = X*P\),则newX由X的\(m*n\)变成\(m*k(k<n)\),此时数据已经降低维度了。

2.2 基于SVD求解PCA

三、奇异值分解SVD

3.1 什么是奇异值分解

对于任意的矩阵\(A\in\mathbb{R}^{m*n}\),都可以将A分解成三个矩阵:

\]

并且U和V是正交阵,\(\sum\)是对角阵,即

\]

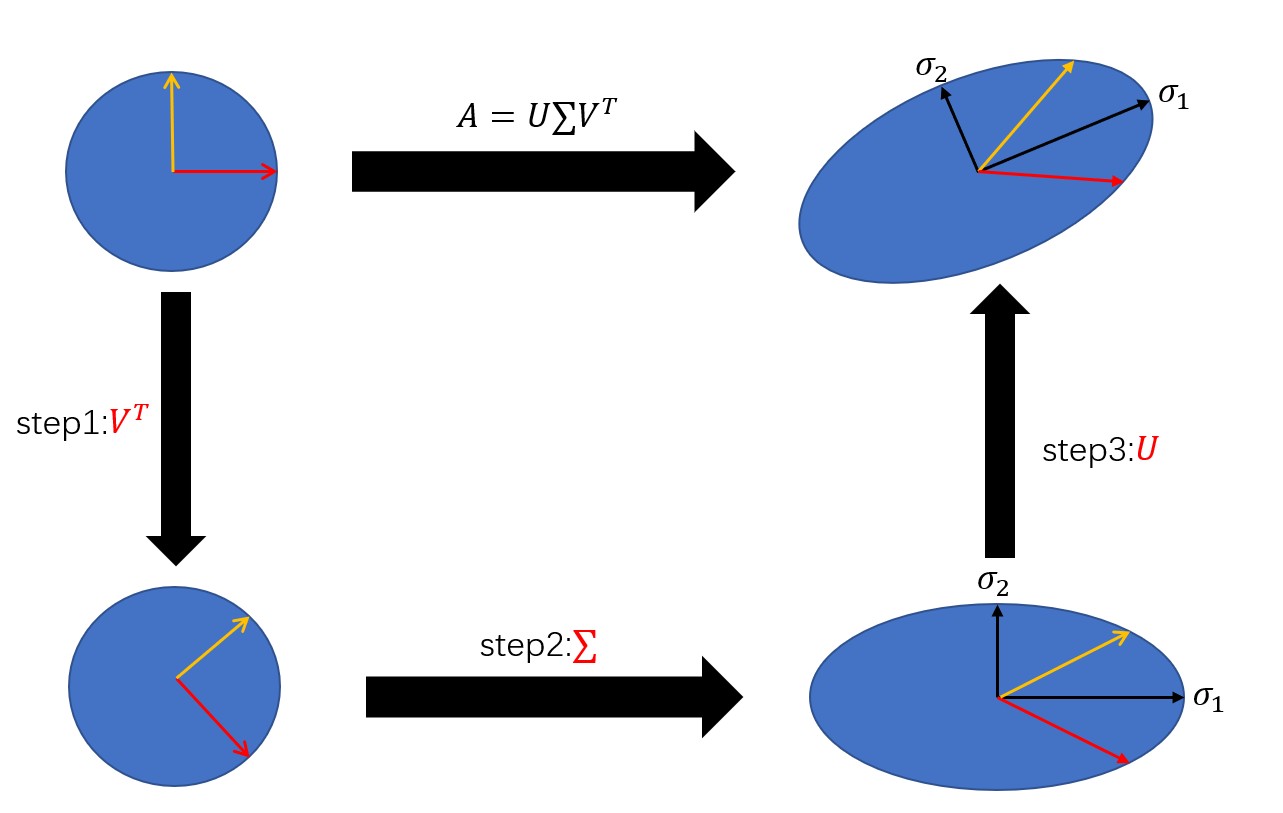

3.2 奇异值分解的几何解释

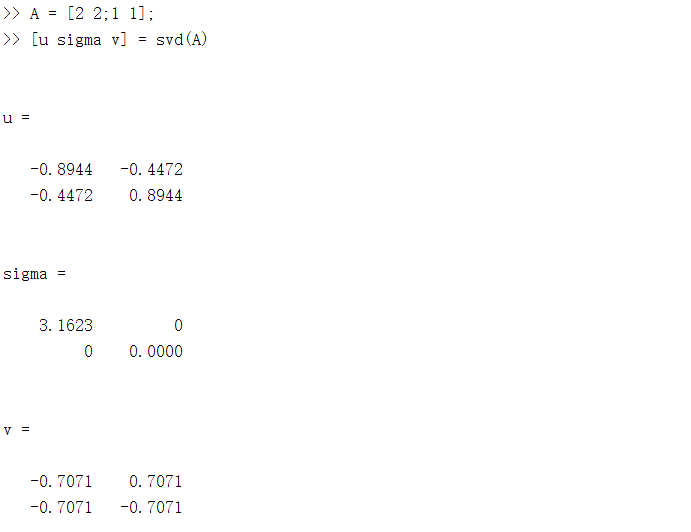

本质上来说,奇异值分解是一个线性变换,对矩阵A进行奇异值分解可以看成是用一组正交基先进行旋转\((V^T e)\),再进行坐标缩放\((\sum V^T e)\),最后再进行坐标旋转\((U\sum V^T e)\),经过这三步操作,正交基可以变换成A,下面是一个简单的例子,用MATLAB可以对任意矩阵进行奇异值分解,并且输出三个矩阵。

3.3 如何求解\(U,\sum,V^T\)

(以下由于编辑问题,会出现几个\(\sum^T\)的T出现在\(\sum\)上面)

对于任意的矩阵都能进行因子分解,这显然是SVD最大的好处,但关键是如何求解三个因子矩阵呢?

3.3.1 求解U

已知\(A=U\sum V^T\),则有

\]

又因为U是正交阵,因此有

\]

左右各乘以\(U^{-1}\),可以得到

\]

也就是U是矩阵\(AA^T\)的特征向量,\((\sum\sum^T)\)是特征值。

3.3.2 求解V

与求解U类似,通过\(AA^T\)来求解,最终可以得到

\]

也就是V是矩阵\(A^TA\)的特征向量,\((\sum^T\sum)\)是特征值

3.3.3 对角矩阵\(\sum\)

\(\sum\)里的元素成为奇异值,从3.3.1和3.3.2可以看出,对角矩阵\(\sum\)的奇异值是\(AA^T\)和\(A^TA\)的特征值的平方根,并且奇异值一定不小于0.以下是简单的证明:

令\(\lambda\)是\(A^TA\)的一个特征值,x是对应的特征向量,则

\]

\]

而奇异值\(\sigma\)是\(\lambda\)的平方根,因此也大于等于0.

3.3.4 SVD与PCA的关系

PCA的目标是求协方差矩阵\(X^TX\)的特征向量和特征值,而协方差矩阵的特征向量就是矩阵X奇异值分解后的右奇异向量V,用下图来说明PCA与SVD的关系

因此,经过PCA处理得到的新数据,其实就是对数据X做奇异值分解,然后乘上右奇异矩阵,或者左奇异矩阵乘上对角矩阵!

四、总结

PCA是一种降维技术,主要用在特征提取。对于PCA,有两种方式:直接对数据的协方差矩阵进行特征向量的求解;对数据进行奇异值分解。实际上,后者会更优于前者。因为求解协方差矩阵的特征值以及特征向量时,有时会出现特征值为虚数,那么这时候算法会失效,而SVD求解出来的奇异值一定是非负数。除此之外,其实可以把PCA看做是对SVD的一种包装,如果实现了SVD,那么PCA也就实现了,而且更好的是,用SVD可以得到两个方向的PCA,而直接分解协方差矩阵,只能得到一个方向的PCA。

浅谈 PCA与SVD的更多相关文章

- [转]浅谈PCA的适用范围

线性代数主要讲矩阵,矩阵就是线性变换,也就是把直线变成直线的几何变换,包括过原点的旋转.镜射.伸缩.推移及其组合.特征向量是对一个线性变换很特殊的向量:只有他们在此变换下可保持方向不变,而对应的特征值 ...

- 浅谈PCA

最近在回顾PCA方面的知识,发现对于之前的很多东西有了新的理解,下面和大家分享下我的一些个人的理解 1.我们为什么要用PCA,它能解决我什么问题? PCA(Principal Component An ...

- 机器学习实战基础(二十三):sklearn中的降维算法PCA和SVD(四) PCA与SVD 之 PCA中的SVD

PCA中的SVD 1 PCA中的SVD哪里来? 细心的小伙伴可能注意到了,svd_solver是奇异值分解器的意思,为什么PCA算法下面会有有关奇异值分解的参数?不是两种算法么?我们之前曾经提到过,P ...

- 浅谈 Fragment 生命周期

版权声明:本文为博主原创文章,未经博主允许不得转载. 微博:厉圣杰 源码:AndroidDemo/Fragment 文中如有纰漏,欢迎大家留言指出. Fragment 是在 Android 3.0 中 ...

- 浅谈 LayoutInflater

浅谈 LayoutInflater 版权声明:本文为博主原创文章,未经博主允许不得转载. 微博:厉圣杰 源码:AndroidDemo/View 文中如有纰漏,欢迎大家留言指出. 在 Android 的 ...

- 浅谈Java的throw与throws

转载:http://blog.csdn.net/luoweifu/article/details/10721543 我进行了一些加工,不是本人原创但比原博主要更完善~ 浅谈Java异常 以前虽然知道一 ...

- 浅谈SQL注入风险 - 一个Login拿下Server

前两天,带着学生们学习了简单的ASP.NET MVC,通过ADO.NET方式连接数据库,实现增删改查. 可能有一部分学生提前预习过,在我写登录SQL的时候,他们鄙视我说:“老师你这SQL有注入,随便都 ...

- 浅谈WebService的版本兼容性设计

在现在大型的项目或者软件开发中,一般都会有很多种终端, PC端比如Winform.WebForm,移动端,比如各种Native客户端(iOS, Android, WP),Html5等,我们要满足以上所 ...

- 浅谈angular2+ionic2

浅谈angular2+ionic2 前言: 不要用angular的语法去写angular2,有人说二者就像Java和JavaScript的区别. 1. 项目所用:angular2+ionic2 ...

随机推荐

- redis实现数据库(一)

转:https://www.cnblogs.com/beiluowuzheng/p/9738159.html 服务器中的数据库 Redis服务器将所有数据库都保存在服务器状态redis.h/redis ...

- python安装包的3的方式

1.pip pip install 包名 2.压缩包(针对pip安装不上) 1.下载源码解压(压缩包有setup.py) 2.python setup.py install 3.****.whl文件 ...

- PBM error occurred during PreCloneCheckCallback: 由于目标计算机积极拒绝,无法连接

问题如下: 迁移存储和主机的时候发生错误,错误如下: 出现了常规系统错误: PBM error occurred during PreCloneCheckCallback: 由于目标计算机积极拒绝,无 ...

- ubutu 12.04

1.[系统设置]->[外观]->[行为]->[自动隐藏启动器],隐藏左侧边栏后,可以按快捷键[CTRL+a]弹出侧边栏. 2.QtCreator调试,提示[ptrace不允许的操作] ...

- DVWA(七):XSS(stored)存储型XSS攻击

存储型XSS : 存储XSS,会把攻击者的数据存储在服务器端,攻击行为将伴随着攻击数据一直存在.提交JS攻击代码存储到数据库然后再输出. low: 观察源码: <?php if( isset( ...

- 五分钟了解Semaphore

一.前言 多个线程之间的同步,我们会用到Semaphore,翻译成中文就是信号量.使用Semaphore可以限制多个线程对同一资源的访问.我们先看下C#中对Semaphore的定义,如下图: 翻译成中 ...

- 关于编码和解码问题——encode、decode

一.背景和问题 近期在做一个关于声卡录音的项目,开发环境是win10 64位家庭中文版,pycharm2019.1,python3.6(Anaconda3),python模块pyaud ...

- Python之split()函数

在Python的高级特性里有切片(Slice)操作符,可以对字符串进行截取.Python还提供split()函数可以将一个字符串分裂成多个字符串组成的列表. split()的语法挺简单的: str.s ...

- 免费开源数字货币交易所——基于Java开发的比特币交易所 | BTC交易所 | ETH交易所 | 数字货币交易所

本项目是基于Java开发的比特币交易所 | BTC交易所 | ETH交易所 | 数字货币交易所 | 交易平台 | 撮合交易引擎.本项目基于SpringCloud微服务开发,可用来搭建和二次开发数字货币 ...

- Longest subarray of target sum

2018-07-08 13:24:31 一.525. Contiguous Array 问题描述: 问题求解: 我们都知道对于subarray的问题,暴力求解的时间复杂度为O(n ^ 2),问题规模已 ...