Android 音视频 - MediaCodec 编解码音视频

我们知道 Camera 采集回传的是 YUV 数据,AudioRecord 是 PCM,我们要对这些数据进行编码(压缩编码),这里我们来说在 Android 上音视频编解码逃不过的坑-MediaCodec

MediaCodec

PSMediaCodec 可以用来

编/解码音/视频。

MediaCodec 简单介绍

MediaCodec 类可用于访问低级媒体编解码器,即编码器/解码器组件。 它是 Android 低级多媒体支持基础结构的一部分(通常与 MediaExtractor,MediaSync,MediaMuxer,MediaCrypto,MediaDrm,Image,Surface 和 AudioTrack 一起使用)。关于 MediaCodec 的描述可参看官方介绍MediaCodec

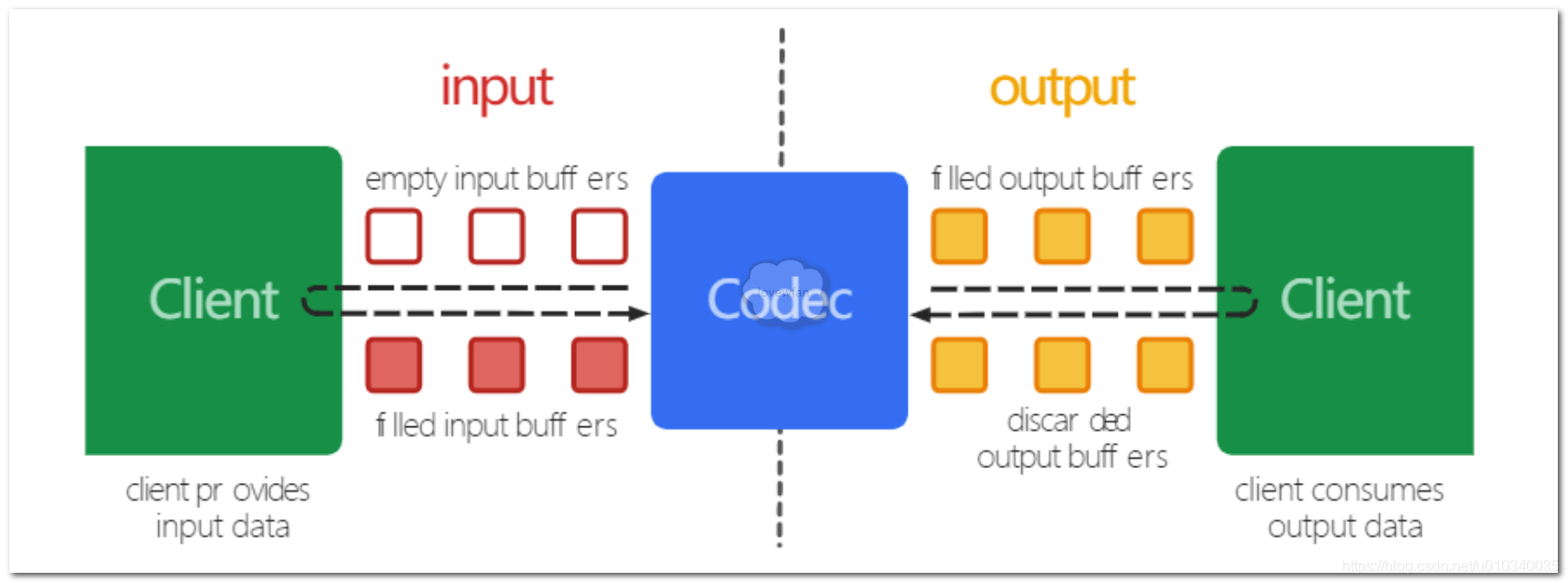

广义而言,编解码器处理输入数据以生成输出数据。 它异步处理数据,并使用一组输入和输出缓冲区。 在简单的情况下,您请求(或接收)一个空的输入缓冲区,将其填充数据并将其发送到编解码器进行处理。 编解码器用完了数据并将其转换为空的输出缓冲区之一。 最后,您请求(或接收)已填充的输出缓冲区,使用其内容并将其释放回编解码器。

PS 读者如果对生产者-消费者模型还有印象的话,那么 MediaCodec 的运行模式其实也不难理解。

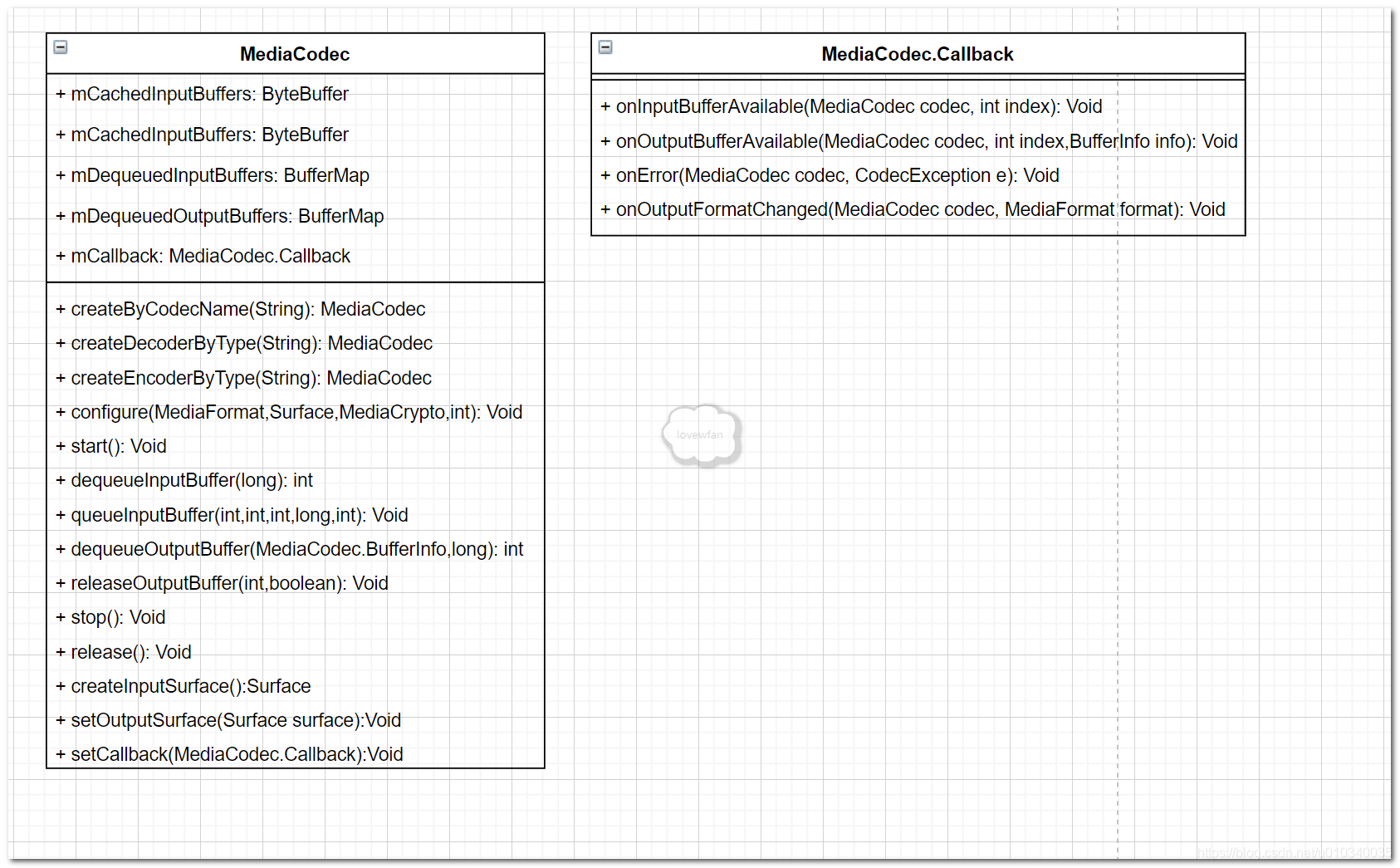

下面是 MediaCodec 的简单类图

MediaCodec 状态机

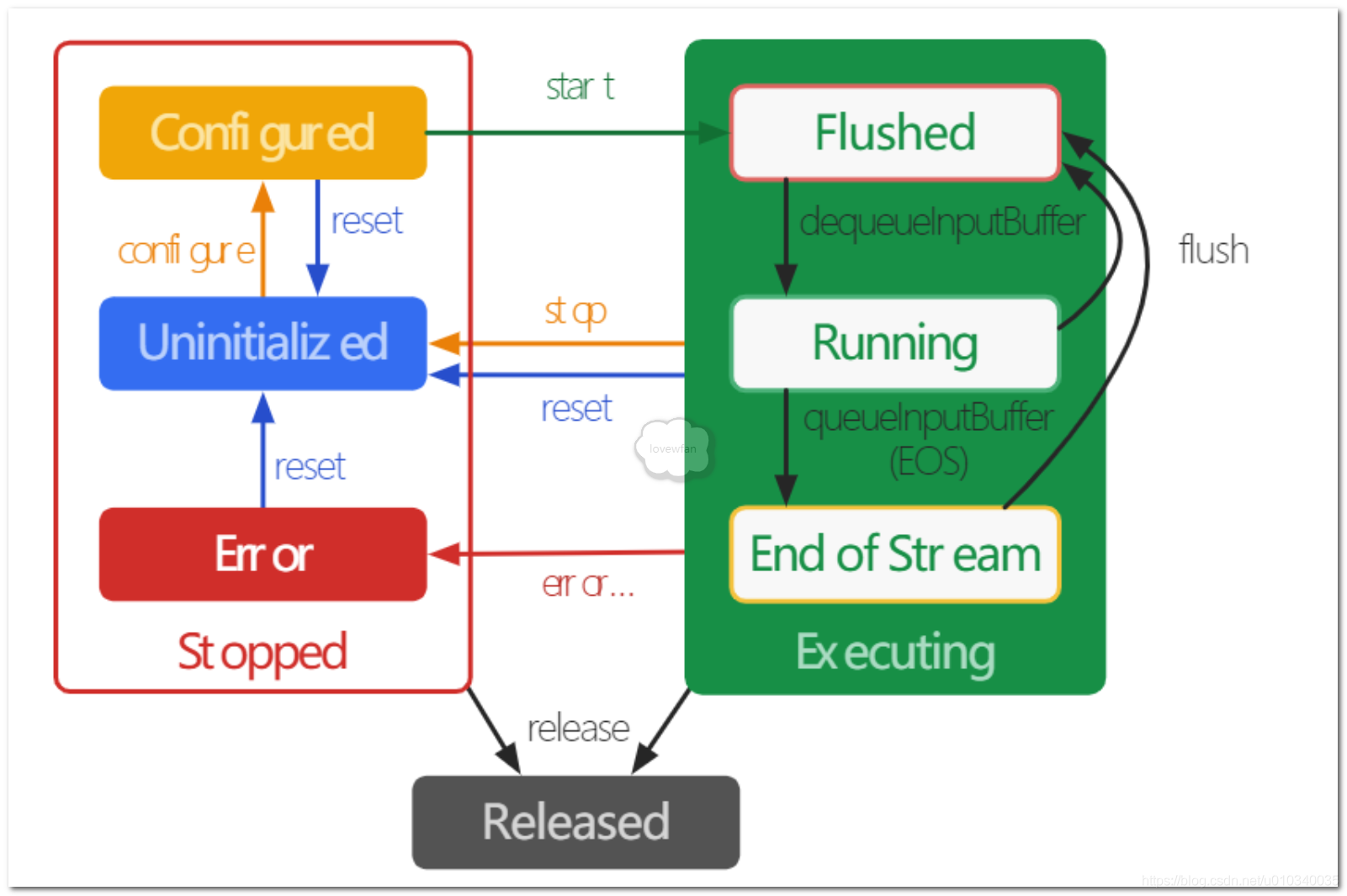

在 MediaCodec 生命周期内,编解码器从概念上讲处于以下三种状态之一:Stopped,Executing 或 Released。Stopped 的集体状态实际上是三个状态的集合:Uninitialized,Configured 和 Error,而 Executing 状态从概念上讲经过三个子状态:Flushed,Running 和 Stream-of-Stream。

使用工厂方法之一创建编解码器时,编解码器处于未初始化状态。首先,您需要通过 configure(…)对其进行配置,使它进入已配置状态,然后调用 start()将其移至执行状态。在这种状态下,您可以通过上述缓冲区队列操作来处理数据。

执行状态具有三个子状态:Flushed,Running 和 Stream-of-Stream。在 start()之后,编解码器立即处于 Flushed 子状态,其中包含所有缓冲区。一旦第一个输入缓冲区出队,编解码器将移至“Running”子状态,在此状态下将花费大部分时间。当您将输入缓冲区与流结束标记排队时,编解码器将转换为 End-of-Stream 子状态。在这种状态下,编解码器将不再接受其他输入缓冲区,但仍会生成输出缓冲区,直到在输出端达到流结束为止。在执行状态下,您可以使用 flush()随时返回到“刷新”子状态。

调用 stop()使编解码器返回 Uninitialized 状态,随后可以再次对其进行配置。使用编解码器完成操作后,必须通过调用 release()释放它。

在极少数情况下,编解码器可能会遇到错误并进入“错误”状态。使用来自排队操作的无效返回值或有时通过异常来传达此信息。调用 reset()使编解码器再次可用。您可以从任何状态调用它,以将编解码器移回“Uninitialized”状态。否则,请调用 release()以移至终端的“Released”状态。

PSMediaCodec 数据处理的模式可分为同步和异步,下面我们会一一分析

MediaCodec 同步模式

上代码

public H264MediaCodecEncoder(int width, int height) {

//设置MediaFormat的参数

MediaFormat mediaFormat = MediaFormat.createVideoFormat(MIMETYPE_VIDEO_AVC, width, height);

mediaFormat.setInteger(MediaFormat.KEY_COLOR_FORMAT, MediaCodecInfo.CodecCapabilities.COLOR_FormatYUV420Flexible);

mediaFormat.setInteger(MediaFormat.KEY_BIT_RATE, width * height * 5);

mediaFormat.setInteger(MediaFormat.KEY_FRAME_RATE, 30);//FPS

mediaFormat.setInteger(MediaFormat.KEY_I_FRAME_INTERVAL, 1);

try {

//通过MIMETYPE创建MediaCodec实例

mMediaCodec = MediaCodec.createEncoderByType(MIMETYPE_VIDEO_AVC);

//调用configure,传入的MediaCodec.CONFIGURE_FLAG_ENCODE表示编码

mMediaCodec.configure(mediaFormat, null, null, MediaCodec.CONFIGURE_FLAG_ENCODE);

//调用start

mMediaCodec.start();

} catch (Exception e) {

e.printStackTrace();

}

}

调用 putData 向队列中 add 原始 YUV 数据。

public void putData(byte[] buffer) {

if (yuv420Queue.size() >= 10) {

yuv420Queue.poll();

}

yuv420Queue.add(buffer);

}

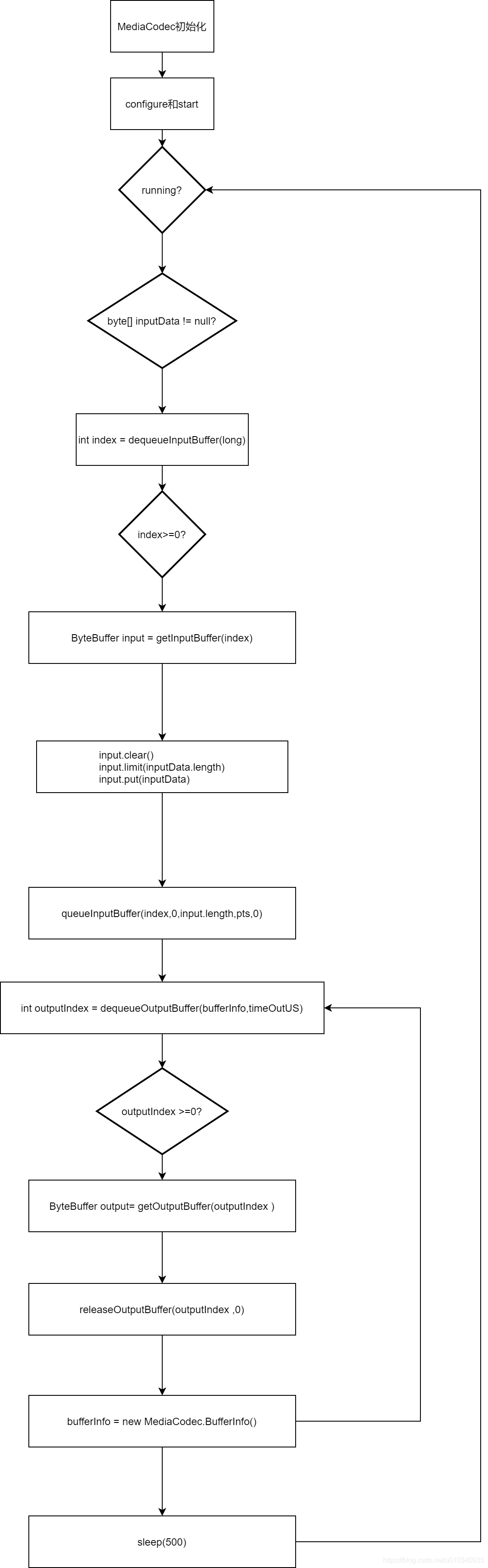

//开启编码

public void startEncoder() {

isRunning = true;

ExecutorService executorService = Executors.newSingleThreadExecutor();

executorService.execute(new Runnable() {

@Override

public void run() {

byte[] input = null;

while (isRunning) { if (yuv420Queue.size() > 0) {

//从队列中取数据

input = yuv420Queue.poll();

}

if (input != null) {

try {

//【1】dequeueInputBuffer

int inputBufferIndex = mMediaCodec.dequeueInputBuffer(TIMEOUT_S);

if (inputBufferIndex >= 0) {

//【2】getInputBuffer

ByteBuffer inputBuffer = null;

if (android.os.Build.VERSION.SDK_INT >= android.os.Build.VERSION_CODES.LOLLIPOP) {

inputBuffer = mMediaCodec.getInputBuffer(inputBufferIndex);

} else {

inputBuffer = mMediaCodec.getInputBuffers()[inputBufferIndex];

}

inputBuffer.clear();

inputBuffer.put(input);

//【3】queueInputBuffer

mMediaCodec.queueInputBuffer(inputBufferIndex, 0, input.length, getPTSUs(), 0);

} MediaCodec.BufferInfo bufferInfo = new MediaCodec.BufferInfo();

//【4】dequeueOutputBuffer

int outputBufferIndex = mMediaCodec.dequeueOutputBuffer(bufferInfo, TIMEOUT_S);

if (outputBufferIndex == MediaCodec.INFO_OUTPUT_FORMAT_CHANGED) {

MediaFormat newFormat = mMediaCodec.getOutputFormat();

if (null != mEncoderCallback) {

mEncoderCallback.outputMediaFormatChanged(H264_ENCODER, newFormat);

}

if (mMuxer != null) {

if (mMuxerStarted) {

throw new RuntimeException("format changed twice");

}

// now that we have the Magic Goodies, start the muxer

mTrackIndex = mMuxer.addTrack(newFormat);

mMuxer.start(); mMuxerStarted = true;

}

} while (outputBufferIndex >= 0) {

ByteBuffer outputBuffer = null;

//【5】getOutputBuffer

if (android.os.Build.VERSION.SDK_INT >= android.os.Build.VERSION_CODES.LOLLIPOP) {

outputBuffer = mMediaCodec.getOutputBuffer(outputBufferIndex);

} else {

outputBuffer = mMediaCodec.getOutputBuffers()[outputBufferIndex];

}

if (bufferInfo.flags == MediaCodec.BUFFER_FLAG_CODEC_CONFIG) {

bufferInfo.size = 0;

} if (bufferInfo.size > 0) { // adjust the ByteBuffer values to match BufferInfo (not needed?)

outputBuffer.position(bufferInfo.offset);

outputBuffer.limit(bufferInfo.offset + bufferInfo.size);

// write encoded data to muxer(need to adjust presentationTimeUs.

bufferInfo.presentationTimeUs = getPTSUs(); if (mEncoderCallback != null) {

//回调

mEncoderCallback.onEncodeOutput(H264_ENCODER, outputBuffer, bufferInfo);

}

prevOutputPTSUs = bufferInfo.presentationTimeUs;

if (mMuxer != null) {

if (!mMuxerStarted) {

throw new RuntimeException("muxer hasn't started");

}

mMuxer.writeSampleData(mTrackIndex, outputBuffer, bufferInfo);

} }

mMediaCodec.releaseOutputBuffer(outputBufferIndex, false);

bufferInfo = new MediaCodec.BufferInfo();

outputBufferIndex = mMediaCodec.dequeueOutputBuffer(bufferInfo, TIMEOUT_S);

}

} catch (Throwable throwable) {

throwable.printStackTrace();

}

} else {

try {

Thread.sleep(500);

} catch (InterruptedException e) {

e.printStackTrace();

}

}

} }

});

}

PS 编解码这种耗时操作要在单独的线程中完成,我们这里有个缓冲队列

ArrayBlockingQueue<byte[]> yuv420Queue = new ArrayBlockingQueue<>(10);用来接收从 Camera 回调中传入的 byte[] YUV 数据,我们又新建立了一个现成来从缓冲队列yuv420Queue中循环读取数据交给 MediaCodec 进行编码处理,编码完成的格式是由mMediaCodec = MediaCodec.createEncoderByType(MIMETYPE_VIDEO_AVC);指定的,这里输出的是目前最为广泛使用的H264格式

完整代码请看H264MediaCodecEncoder

MediaCodec 异步模式

@RequiresApi(api = Build.VERSION_CODES.LOLLIPOP)

public H264MediaCodecAsyncEncoder(int width, int height) {

MediaFormat mediaFormat = MediaFormat.createVideoFormat(MIMETYPE_VIDEO_AVC, width, height);

mediaFormat.setInteger(MediaFormat.KEY_COLOR_FORMAT, MediaCodecInfo.CodecCapabilities.COLOR_FormatYUV420Flexible);

mediaFormat.setInteger(MediaFormat.KEY_BIT_RATE, width * height * 5);

mediaFormat.setInteger(MediaFormat.KEY_FRAME_RATE, 30);//FPS

mediaFormat.setInteger(MediaFormat.KEY_I_FRAME_INTERVAL, 1); try {

mMediaCodec = MediaCodec.createEncoderByType(MIMETYPE_VIDEO_AVC);

mMediaCodec.configure(mediaFormat, null, null, MediaCodec.CONFIGURE_FLAG_ENCODE);

//设置回调

mMediaCodec.setCallback(new MediaCodec.Callback() {

@Override

/**

* Called when an input buffer becomes available.

*

* @param codec The MediaCodec object.

* @param index The index of the available input buffer.

*/

public void onInputBufferAvailable(@NonNull MediaCodec codec, int index) {

Log.i("MFB", "onInputBufferAvailable:" + index);

byte[] input = null;

if (isRunning) {

if (yuv420Queue.size() > 0) {

input = yuv420Queue.poll();

}

if (input != null) {

ByteBuffer inputBuffer = codec.getInputBuffer(index);

inputBuffer.clear();

inputBuffer.put(input);

codec.queueInputBuffer(index, 0, input.length, getPTSUs(), 0);

}

}

} @Override

/**

* Called when an output buffer becomes available.

*

* @param codec The MediaCodec object.

* @param index The index of the available output buffer.

* @param info Info regarding the available output buffer {@link MediaCodec.BufferInfo}.

*/

public void onOutputBufferAvailable(@NonNull MediaCodec codec, int index, @NonNull MediaCodec.BufferInfo info) {

Log.i("MFB", "onOutputBufferAvailable:" + index);

ByteBuffer outputBuffer = codec.getOutputBuffer(index); if (info.flags == MediaCodec.BUFFER_FLAG_CODEC_CONFIG) {

info.size = 0;

} if (info.size > 0) { // adjust the ByteBuffer values to match BufferInfo (not needed?)

outputBuffer.position(info.offset);

outputBuffer.limit(info.offset + info.size);

// write encoded data to muxer(need to adjust presentationTimeUs.

info.presentationTimeUs = getPTSUs(); if (mEncoderCallback != null) {

//回调

mEncoderCallback.onEncodeOutput(H264_ENCODER, outputBuffer, info);

}

prevOutputPTSUs = info.presentationTimeUs;

if (mMuxer != null) {

if (!mMuxerStarted) {

throw new RuntimeException("muxer hasn't started");

}

mMuxer.writeSampleData(mTrackIndex, outputBuffer, info);

} }

codec.releaseOutputBuffer(index, false);

} @Override

public void onError(@NonNull MediaCodec codec, @NonNull MediaCodec.CodecException e) { } @Override

/**

* Called when the output format has changed

*

* @param codec The MediaCodec object.

* @param format The new output format.

*/

public void onOutputFormatChanged(@NonNull MediaCodec codec, @NonNull MediaFormat format) {

if (null != mEncoderCallback) {

mEncoderCallback.outputMediaFormatChanged(H264_ENCODER, format);

}

if (mMuxer != null) {

if (mMuxerStarted) {

throw new RuntimeException("format changed twice");

}

// now that we have the Magic Goodies, start the muxer

mTrackIndex = mMuxer.addTrack(format);

mMuxer.start(); mMuxerStarted = true;

}

}

});

mMediaCodec.start(); } catch (Exception e) {

e.printStackTrace();

} }

完整代码请看H264MediaCodecAsyncEncoder

MediaCodec 小结

MediaCodec 用来音视频的编解码工作(这个过程有的文章也称为硬解),通过MediaCodec.createEncoderByType(MIMETYPE_VIDEO_AVC)函数中的参数来创建音频或者视频的编码器,同理通过MediaCodec.createDecoderByType(MIMETYPE_VIDEO_AVC)创建音频或者视频的解码器。对于音视频编解码中需要的不同参数用MediaFormat来指定。

小结

本篇文章详细的对 MediaCodec 进行了分析,读者可根据博客对应 Demo 来进行实际操练。

放上 Demo 地址详细Demo

Android 音视频 - MediaCodec 编解码音视频的更多相关文章

- iOS8系统H264视频硬件编解码说明

公司项目原因,接触了一下视频流H264的编解码知识,之前项目使用的是FFMpeg多媒体库,利用CPU做视频的编码和解码,俗称为软编软解.该方法比较通用,但是占用CPU资源,编解码效率不高.一般系统都会 ...

- 转:关于视频H264编解码的应用实现

转:http://blog.csdn.net/scalerzhangjie/article/details/8273410 项目要用到视频编解码,最近半个月都在搞,说实话真是走了很多弯路,浪费了很多时 ...

- Android中使用MediaCodec硬件解码,高效率得到YUV格式帧,快速保存JPEG图片(不使用OpenGL)(附Demo)

MediaCodec的使用demo: https://github.com/vecio/MediaCodecDemo https://github.com/taehwandev/MediaCodecE ...

- IOS和Android支持的音频编解码

1.IOS编码 参考文档地址:https://developer.apple.com/library/ios/documentation/AudioVideo/Conceptual/Multimedi ...

- Android 音视频编解码——YUV视频格式详解

一.YUV 介绍 YUV是一种颜色编码方方式,通常由彩色摄像机进行取像,然后把取得的彩色图像信号经过分色.分别放大校正后得到RGB,再经过矩阵变换得到亮度信号Y和两个色差信号B-Y(即U).R-Y(即 ...

- 音视频编解码——YUV视频格式详解

一.YUV 介绍 YUV是一种颜色编码方方式,通常由彩色摄像机进行取像,然后把取得的彩色图像信号经过分色.分别放大校正后得到RGB,再经过矩阵变换得到亮度信号Y和两个色差信号B-Y(即U).R-Y(即 ...

- FFMpeg笔记(二) 使用FFmpeg对视频进行编解码的一般流程

1. 编码: 1.对编码资源的初始化 AVCodec* m_pVideoEncoder;// 特定编码器的参数信息 AVCodecContext* m_pVideoEncoderContext;// ...

- 音视频编解码技术(一):MPEG-4/H.264 AVC 编解码标准

一.H264 概述 H.264,通常也被称之为H.264/AVC(或者H.264/MPEG-4 AVC或MPEG-4/H.264 AVC) 1. H.264视频编解码的意义 H.264的出现就是为了创 ...

- FFmpeg音视频编解码实践总结

PS:由于目前开发RTSP服务器传输模块时用到了h264文件,所以攻了一段时间去实现h264的视频编解码,借用FFmpeg SDK实现了任意文件格式之间的转换,并实现了流媒体实时播放,目前音视频同步需 ...

- ffmpeg编解码视频导致噪声增大的一种解决方法

一.前言 ffmpeg在视音频编解码领域算是一个比较成熟的解决方案了.公司的一款视频编辑软件正是基于ffmpeg做了二次封装,并在此基础上进行音视频的编解码处理.然而,在观察编码后的视频质量时,发现图 ...

随机推荐

- Required request part 'file' is not present

问题描述: @RequestMapping(value = "upload", method = RequestMethod.POST,consumes = MediaType.M ...

- SpringBoot - 参数校验、统一异常、统一响应

转载自: https://blog.csdn.net/chaitoudaren/article/details/105610962 前言 本篇主要要介绍的就是controller层的处理,一个完整的后 ...

- 解决通过Eclipse启动Tomcat-Run On Server出现The selection cannot be run on any server

有时候通过Eclipse启动Tomcat-Run On Server会出现The selection cannot be run on any server的情况如下图: 这是因为没有在eclipse ...

- token能放在cookie中吗

能. token一般是用来判断用户是否登录的, 它内部包含的信息有: uid(用户唯一的身份标识). time(当前时间的时间戳). sign(签名,token 的前几位以哈希算法压缩成的一定长度的十 ...

- Java断言语句

断言语句在调试代码阶段非常有用,断言语句一般用于 程序不准备通过捕获异常来处理的错误,例如,当发生某个错误时,要求程序必须立即停止执行.在调试代码阶段让断言语句发挥作用,这样就可以发现一些致命的错 ...

- python扑克牌

import random import operator def auto(): pokers=[] poker=[] for i in ['','','','']: for j in ['A',' ...

- List的初始化方式

在LinkedIn考试考到了,很遗憾没考过,特意记录一下,下次再战!文章不是我写的,看到别人的总结,发在我这里自己看看 在 Java 中几种初始化 List 的方法: 1. List<Strin ...

- Android studio的使用2

运行按钮First activity: package com.example.activity;import androidx.appcompat.app.AppCompatActivity;imp ...

- SQL Server 还原数据库

1.备份要还原的数据库 选择要备份的数据库,右键单击,任务--备份. 2.备份完成后,将数据库还原 3.新建一个空的数据库,比如Gsy_TestNew,将备份的数据库还原到这个新的库上 4.右键单击[ ...

- VUE keepAlive缓存问题之动态使用exclude(会使用到VUEX)

exclude是啥? 官方解释: 怎么用呢? 处理的问题是什么?(答:返回首页的时候清除B页面的缓存) 我遇到的问题是: 一开始状态:A(首页). B(列表).C(列表中的详情)三个页面,设置B页面的 ...