NLP预训练模型-百度ERNIE2.0的效果到底有多好【附用户点评】

ERNIE是百度自研的持续学习语义理解框架,该框架支持增量引入词汇(lexical)、语法 (syntactic) 、语义(semantic)等3个层次的自定义预训练任务,能够全面捕捉训练语料中的词法、语法、语义等潜在信息。

ERNIE2.0实现了在中英文16个任务上的最优效果,具体效果见下方列表。

一、ERNIE2.0中文效果验证

我们在 9 个任务上验证 ERNIE 2.0 中文模型的效果。这些任务包括:自然语言推断任务 XNLI;阅读理解任务 DRCD、DuReader、CMRC2018;命名实体识别任务 MSRA-NER (SIGHAN2006);情感分析任务 ChnSentiCorp;语义相似度任务 BQ Corpus、LCQMC;问答任务 NLPCC2016-DBQA 。

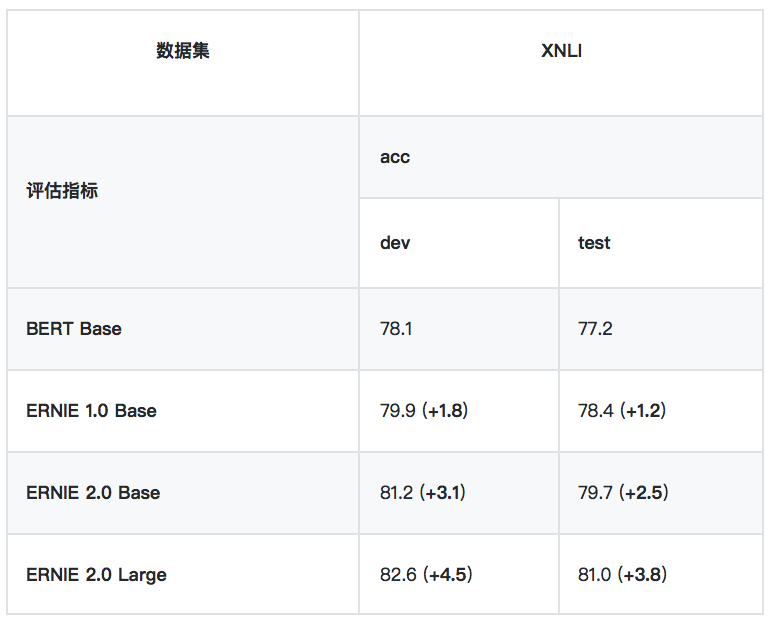

1、自然语言推断任务

• XNLI

XNLI 是由 Facebook 和纽约大学的研究者联合构建的自然语言推断数据集,包括 15 种语言的数据。我们用其中的中文数据来评估模型的语言理解能力。[链接: facebookresearch/XNLI]

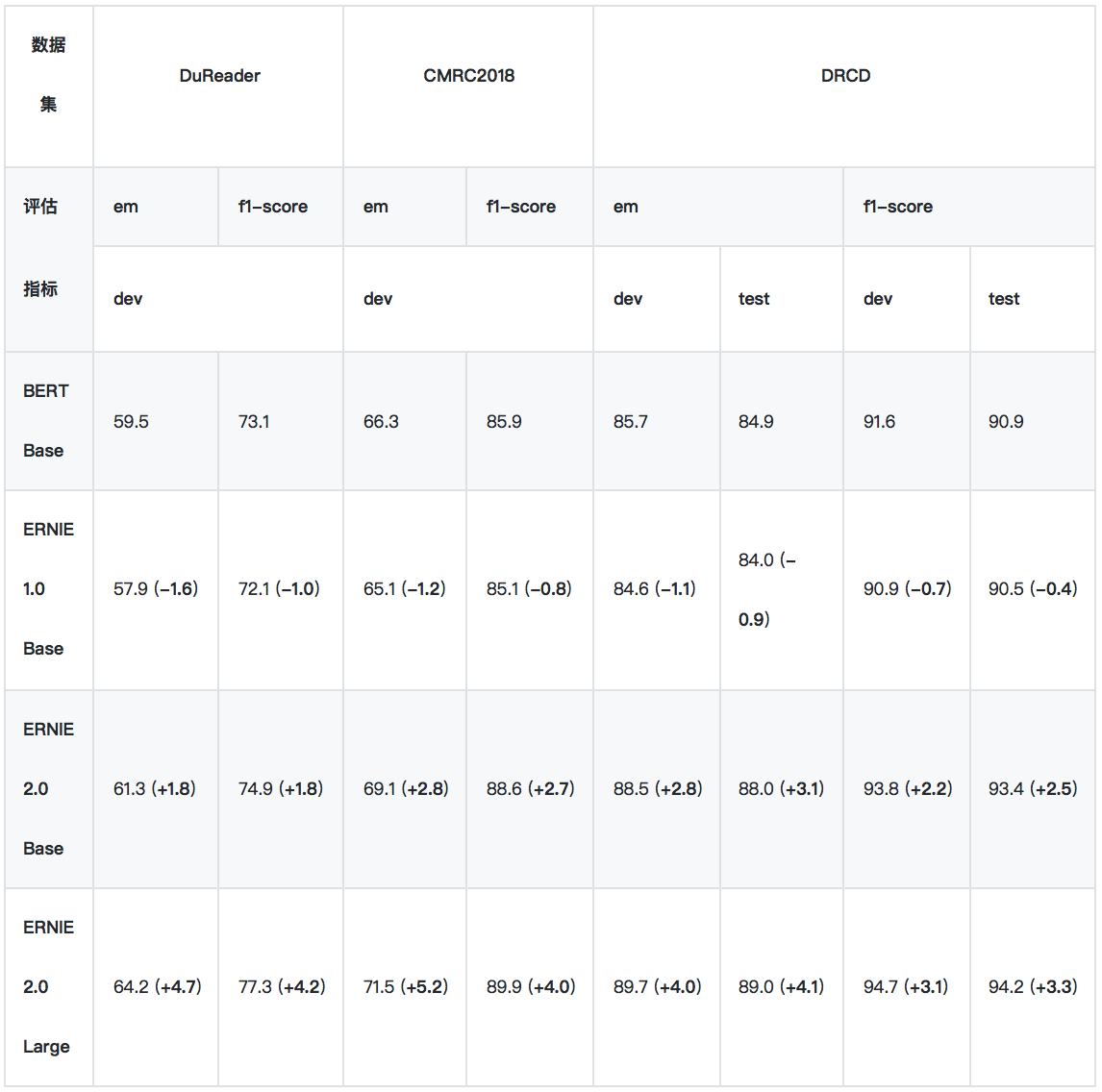

2、阅读理解任务

*实验所用的 DuReader 抽取类、单文档子集为内部数据集。

*实验时将 DRCD 繁体数据转换成简体,繁简转换工具:skydark/nstools

*ERNIE 1.0 的预训练数据长度为 128,其他模型使用 512 长度的数据训练,这导致 ERNIE 1.0 BASE 在长文本任务上性能较差, 为此我们发布了 ERNIE 1.0 Base (max-len-512) 模型 (2019-07-29)

• DuReader

DuReader 是百度在自然语言处理国际顶会 ACL 2018 发布的机器阅读理解数据集,所有的问题、原文都来源于百度搜索引擎数据和百度知道问答社区,答案是由人工整理的。实验是在 DuReader 的单文档、抽取类的子集上进行的,训练集包含15763个文档和问题,验证集包含1628个文档和问题,目标是从篇章中抽取出连续片段作为答案。[链接: https://arxiv.org/pdf/1711.05073.pdf]

• CMRC2018

CMRC2018 是中文信息学会举办的评测,评测的任务是抽取类阅读理解。[链接: ymcui/cmrc2018]

• DRCD

DRCD 是台达研究院发布的繁体中文阅读理解数据集,目标是从篇章中抽取出连续片段作为答案。我们在实验时先将其转换成简体中文。[链接: DRCKnowledgeTeam/DRCD]

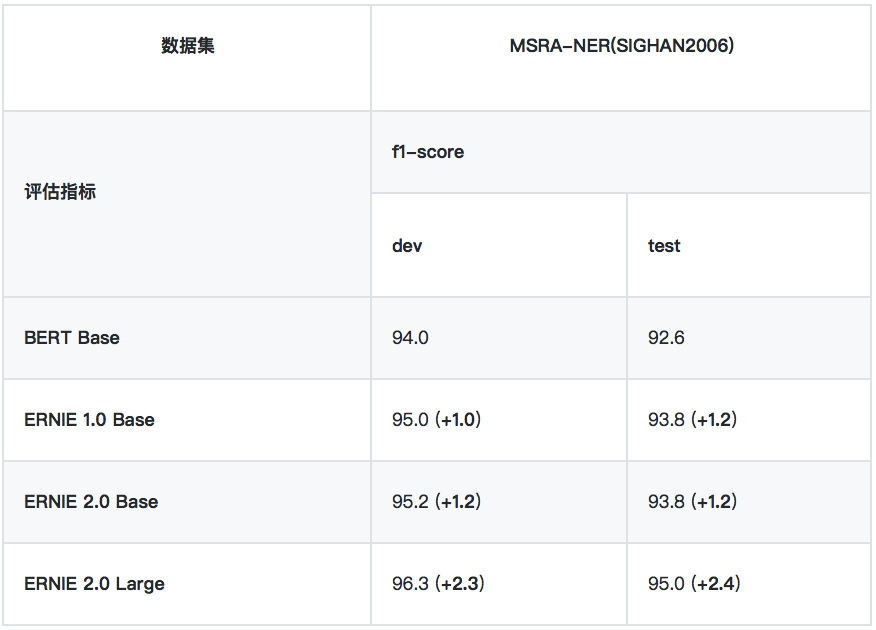

3、命名实体识别任务

• MSRA-NER (SIGHAN2006)

MSRA-NER (SIGHAN2006) 数据集由微软亚研院发布,其目标是识别文本中具有特定意义的实体,包括人名、地名、机构名。

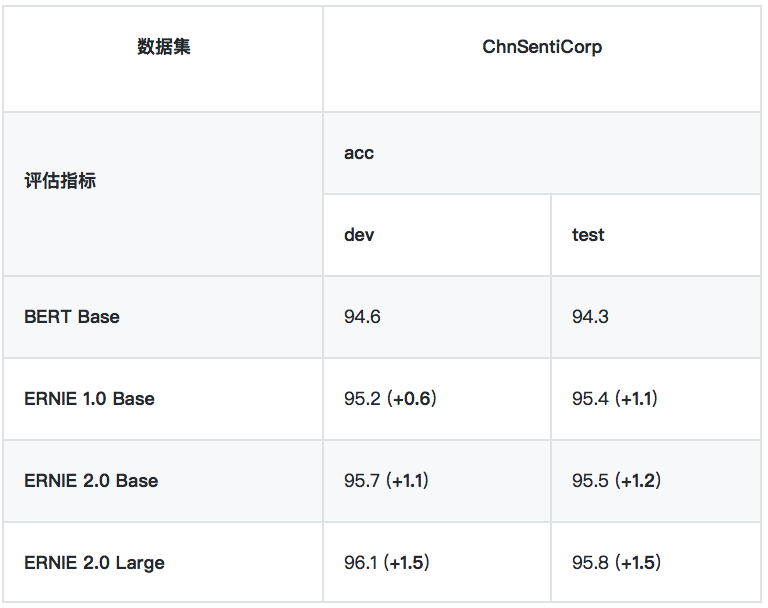

4、情感分析任务

• ChnSentiCorp

ChnSentiCorp 是一个中文情感分析数据集,包含酒店、笔记本电脑和书籍的网购评论。

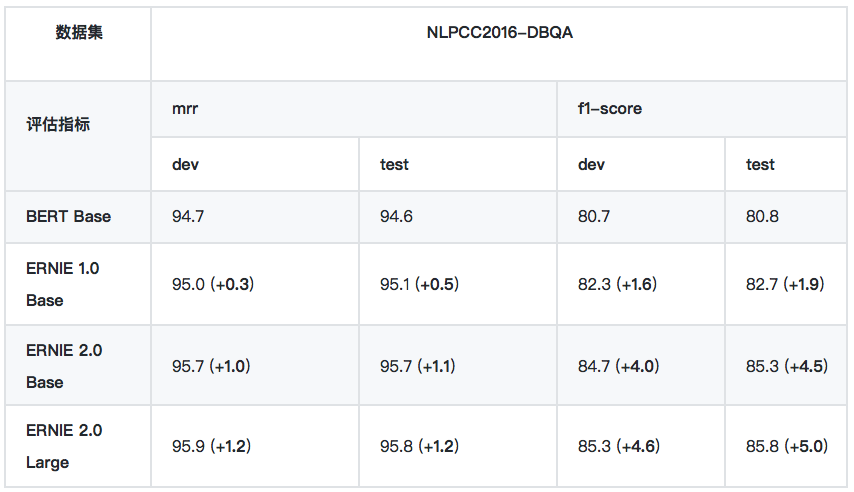

5、问答任务

• NLPCC2016-DBQA

NLPCC2016-DBQA 是由国际自然语言处理和中文计算会议 NLPCC 于 2016 年举办的评测任务,其目标是从候选中找到合适的文档作为问题的答案。[链接: http://tcci.ccf.org.cn/conference/2016/dldoc/evagline2.pdf]

6、语义相似度

*LCQMC 、BQ Corpus 数据集需要向作者申请,LCQMC 申请地址:LCQMC: A Large-scale Chinese Question Matching Corpus, BQ Corpus 申请地址:The BQ Corpus: A Large-scale Domain-specific Chinese Corpus For Sentence Semantic Equivalence Identification

• LCQMC

LCQMC 是在自然语言处理国际顶会 COLING 2018 发布的语义匹配数据集,其目标是判断两个问题的语义是否相同。[链接: LCQMC:A Large-scale Chinese Question Matching Corpus]

• BQ Corpus

BQ Corpus 是在自然语言处理国际顶会 EMNLP 2018 发布的语义匹配数据集,该数据集针对银行领域,其目标是判断两个问题的语义是否相同。[链接: The BQ Corpus: A Large-scale Domain-specific Chinese Corpus For Sentence Semantic Equivalence Identification]

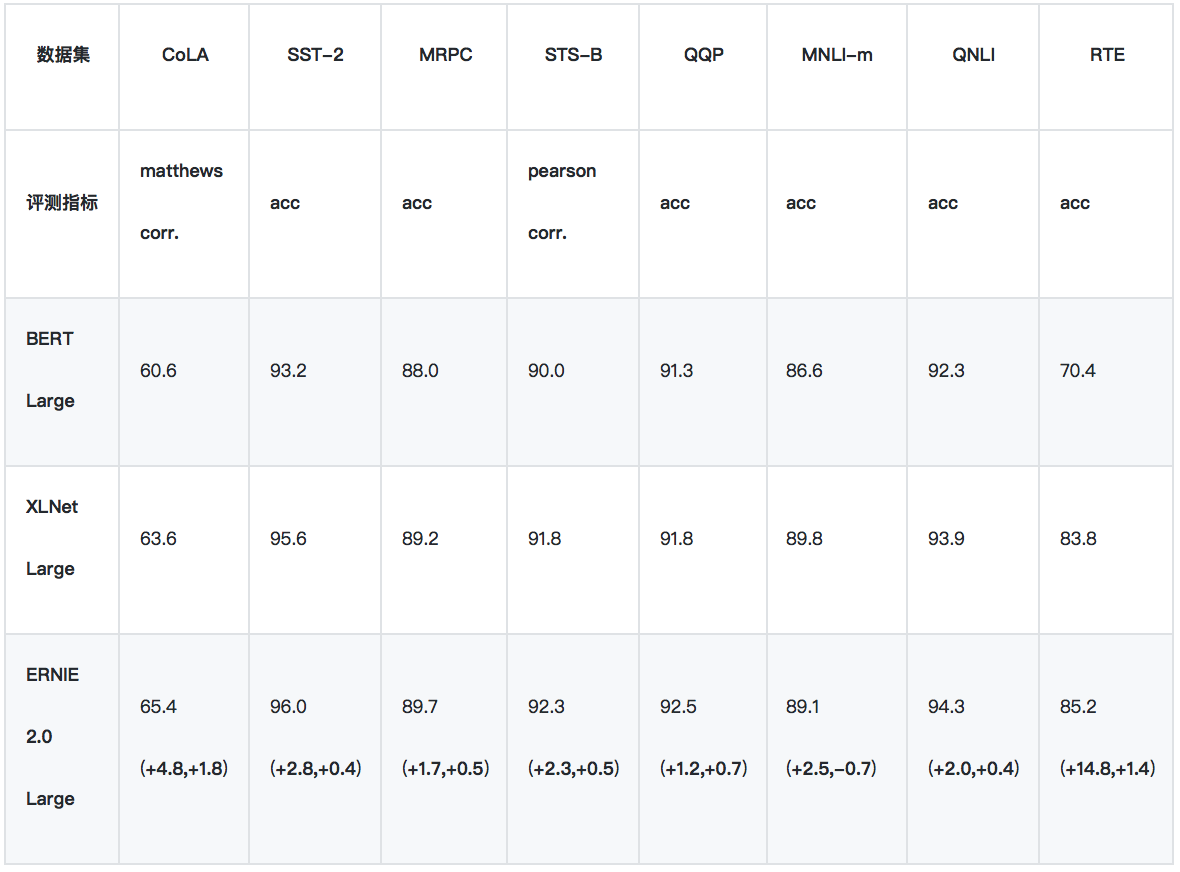

二、英文效果验证

ERNIE 2.0 的英文效果验证在 GLUE 上进行。GLUE 评测的官方地址为 GLUE Benchmark ,该评测涵盖了不同类型任务的 10 个数据集,其中包含 11 个测试集,涉及到 Accuracy, F1-score, Spearman Corr,. Pearson Corr,. Matthew Corr., 5 类指标。GLUE 排行榜使用每个数据集的平均分作为总体得分,并以此为依据将不同算法进行排名。

1、GLUE - 验证集结果

我们使用单模型的验证集结果,来与 BERT/XLNet 进行比较。

2、GLUE - 测试集结果

由于 XLNet 暂未公布 GLUE 测试集上的单模型结果,所以我们只与 BERT 进行单模型比较。上表为ERNIE 2.0 单模型在 GLUE 测试集的表现结果。

三、真实用户点评

“评分表数据很炸裂啊”

“我觉得你们这个模型太棒了,既能学习到实体embedding,又能学到Word embedding”

“ERNIE2.0创新地将过去单一的预训练流程拆解为串行的多个预训练任务,无疑是最大的贡献”

“ERNIE2.0的使用很方便”

“通过预训练模型BERT, ERNIE, BERT-wwm在公开数据集的对比,发现ERNIE表现较好,原因是采用了非正式数据进行预训练”

“ERNIE2.0创新性的运用了连续增量式多任务学习”

…

大家用了都说好,感觉来试用吧。

划重点!

查看ERNIE模型使用的完整内容和教程,请点击下方链接,建议Star收藏到个人主页,方便后续查看。

GitHub:PaddlePaddle/ERNIE

版本迭代、最新进展都会在GitHub第一时间发布,欢迎持续关注!

也邀请大家加入ERNIE官方技术交流QQ群:760439550,可在群内交流技术问题,会有ERNIE的研发同学为大家及时答疑解惑。

NLP预训练模型-百度ERNIE2.0的效果到底有多好【附用户点评】的更多相关文章

- 最强中文NLP预训练模型艾尼ERNIE官方揭秘【附视频】

“最近刚好在用ERNIE写毕业论文” “感觉还挺厉害的” “为什么叫ERNIE啊,这名字有什么深意吗?” “我想让艾尼帮我写作业” 看了上面火热的讨论,你一定很好奇“艾尼”.“ERNIE”到底是个啥? ...

- 【转载】最强NLP预训练模型!谷歌BERT横扫11项NLP任务记录

本文介绍了一种新的语言表征模型 BERT--来自 Transformer 的双向编码器表征.与最近的语言表征模型不同,BERT 旨在基于所有层的左.右语境来预训练深度双向表征.BERT 是首个在大批句 ...

- 百度NLP预训练模型ERNIE2.0最强实操课程来袭!【附教程】

2019年3月,百度正式发布NLP模型ERNIE,其在中文任务中全面超越BERT一度引发业界广泛关注和探讨.经过短短几个月时间,百度ERNIE再升级,发布持续学习的语义理解框架ERNIE 2.0,及基 ...

- 使用Huggingface在矩池云快速加载预训练模型和数据集

作为NLP领域的著名框架,Huggingface(HF)为社区提供了众多好用的预训练模型和数据集.本文介绍了如何在矩池云使用Huggingface快速加载预训练模型和数据集. 1.环境 HF支持Pyt ...

- 中文预训练模型ERNIE2.0模型下载及安装

2019年7月,百度ERNIE再升级,发布持续学习的语义理解框架ERNIE 2.0,及基于此框架的ERNIE 2.0预训练模型, 它利用百度海量数据和飞桨(PaddlePaddle)多机多卡高效训练优 ...

- 预训练模型——开创NLP新纪元

预训练模型--开创NLP新纪元 论文地址 BERT相关论文列表 清华整理-预训练语言模型 awesome-bert-nlp BERT Lang Street huggingface models 论文 ...

- NLP与深度学习(五)BERT预训练模型

1. BERT简介 Transformer架构的出现,是NLP界的一个重要的里程碑.它激发了很多基于此架构的模型,其中一个非常重要的模型就是BERT. BERT的全称是Bidirectional En ...

- 最强 NLP 预训练模型库 PyTorch-Transformers 正式开源:支持 6 个预训练框架,27 个预训练模型

先上开源地址: https://github.com/huggingface/pytorch-transformers#quick-tour 官网: https://huggingface.co/py ...

- 自然语言处理(三) 预训练模型:XLNet 和他的先辈们

预训练模型 在CV中,预训练模型如ImagNet取得很大的成功,而在NLP中之前一直没有一个可以承担此角色的模型,目前,预训练模型如雨后春笋,是当今NLP领域最热的研究领域之一. 预训练模型属于迁移学 ...

随机推荐

- 关于win10、ubuntu双系统安装的 geom erro错误

安装参考这个博客:http://blog.csdn.net/pop_rain/article/details/70477085 只记录安装ubuntu过程遇到的问题: 1.分区不可用(分区按以下设置) ...

- 一道题考你对__autoreleasing和__block的理解

考虑下面的代码,有哪些问题,如何把他改成正确的形式? @interface TestObj : NSObject @end @implementation TestObj - (void)method ...

- Android_布局

<该文章参考各大博客以及书籍总结而来,如有问题欢迎指出^ ^> 一.五大传统布局+新布局 线性布局——LinearLayout 相对布局——RelativeLayout 帧布局——Fram ...

- 理解Android中的注解与反射

反射 Java反射(Reflection)定义 Java反射机制是指在运行状态中 对于任意一个类,都能知道这个类的所有属性和方法:对于任何一个对象,都能够调用它的任何一个方法和属性: 这样动态获取新的 ...

- Swoole4-swoole创建Mysql连接池

一 .什么是mysql连接池 场景:每秒同时有1000个并发,但是这个mysql同时只能处理400个连接,mysql会宕机. 解决方案:连接池,这个连接池建立了200个和mysql的连接,这1000个 ...

- Python 爬虫(四):Selenium 框架

Selenium 是一个用于测试 Web 应用程序的框架,该框架测试直接在浏览器中运行,就像真实用户操作一样.它支持多种平台:Windows.Linux.Mac,支持多种语言:Python.Perl. ...

- .netCore+Vue 搭建的简捷开发框架 (4)--NetCore 基础 -2

上节中,我们初步的介绍了一下NetCore的一些基础知识,为了控制篇幅(其实也是因为偷懒),我将NetCore 基础分为两部分来写. 0.WebAPI 项目的建立 1..NetCore 项目执行(加载 ...

- 第二篇 python进阶

目录 第二篇 python进阶 一 数字类型内置方法 二 字符串类型内置方法 三 列表类型内置方法(list) 四 元组类型内置方法(tuple) 五 字典内置方法 六 集合类型内置方法(self) ...

- .NET Core 3.0中IAsyncEnumerable<T>有什么大不了的?

.NET Core 3.0和C# 8.0最激动人心的特性之一就是IAsyncEnumerable<T>(也就是async流).但它有什么特别之处呢?我们现在可以用它做哪些以前不可能做到的事 ...

- String的常见面试题

下面代码,是我前些天在网上搜集的一小部分String的面试题.个人觉得感触很深,希望对大家有所帮助.不好的也请大家批评指正. package com.zys.string; public class ...