ADADELTA: AN ADAPTIVE LEARNING RATE METHOD

引

这篇论文比较短,先看了这篇,本来应该先把ADAGRAD看了的。普通的基于梯度下降的方法,普遍依赖于步长,起始点的选择,所以,受ADAGRAD的启发,作者提出了一种ADADELTA的方法。

\]

其中\(g_t=\frac{\partial f(x_t)}{\partial x_t}\),所以下一步迭代就是:

\]

主要内容

ADAGRAD方法:

\]

也就是,步长与之前所有的梯度有关,显然这个步长是会逐渐减少的。但是这个缺点也很明显,如果起始点的梯度很大,那么就会导致后续步长很小,而一开始的梯度很小,就会导致后续步长很大,产生振荡,有些怪怪的。

而ADADELTA希望只关心一部分的梯度,比如

\]

但是这么做,每次迭代都必须记录\(k\)个梯度,这显得不怎么效率,于是,作者相处了一个法子:

\]

可以看到,对于\(g_1\),\(t+1\)步之后其影响为:\(\rho^t(1-\rho) g_1\),对整个迭代造成的影响是一个等比序列:

\]

最后趋向于:

\]

这么做就俩劝其美啦。

记:

\]

其中\(\epsilon\)是为了让除法有意义而添加的小量。

所以

\]

这还不是最终版本,另一个启发决定了\(\eta\)的选择。

我们知道,很多问题是有实际含义的,\(x\)可能是有单位的,比如是米,天等,所以,一个很自然的期望是,\(\Delta x\)的单位和\(x\)是保持一致的。但是:

\]

也就是说\(\Delta x\)的步长单位和梯度单位是一致的,就像是\(l=vt\),\(\Delta t\)的步长单位是\(m/s\),是时间单位的倒数。

而利用二阶导数迭代步长就符合单位一致(如Newton方法):

\]

其中\(H\)为Hessian矩阵。

又注意到:

\]

于是,完全体的ADADELTA方法变为如下:

\]

分子式\(t-1\)的原因式\(\Delta x_t\)压根不知道,所木有办法,就将就一下。

算法

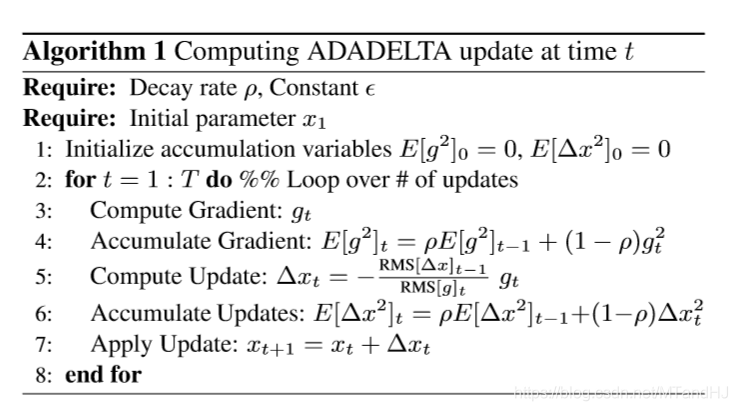

完整的算法如下:

需要注意一点的是,在实际实验中,我们设置\(E[\Delta x^2]_0=1\)而不是如算法中所说的0。因为,如果设置为0,那么意味着第一步只进行相当微小的迭代,所以之后也都是微小的迭代。或许作者是将\(\epsilon\)设置为\(1\)?而不是一个小量?

ADADELTA 代码

import numpy as np

import matplotlib.pyplot as plt

这次用比较怪一点的方式来写,首先,创建一个类,用来存放函数\(f\)和梯度\(g\)

class ADADELTA:

def __init__(self, function, gradient, rho=0.7):

assert hasattr(function, "__call__"), "Invalid function"

assert hasattr(gradient, "__call__"), "Invalid gradient"

assert 0 < rho < 1, "Invalid rho"

self.__function = function

self.__gradient = gradient

self.rho = rho

self.acc_gradient = 0 #初始化accumulate gradient

self.acc_updates = 1 #初始化accumulate updates

self.progress = []

@property

def function(self):

return self.__function

@property

def gradient(self):

return self.__gradient

def reset(self):

self.acc_gradient = 0 #初始化accumulate gradient

self.acc_updates = 1 #初始化accumulate updates

self.progress = []

计算累计梯度

\]

def accumulate_gradient(self, gt):

self.acc_gradient = self.rho * self.acc_gradient \

+ (1 - self.rho) * gt ** 2

return self.acc_gradient

ADADELTA.accumulate_gradient = accumulate_gradient

更新\(E[\Delta x]_t\)

\]

def accumulate_updates(self, deltax):

self.acc_updates = self.rho * self.acc_updates \

+ (1 - self.rho) * deltax ** 2

return self.acc_updates

ADADELTA.accumulate_updates = accumulate_updates

计算更新步长:

\]

def step(self, x, smoothingterm=1e-8):

gt = self.gradient(x)

self.accumulate_gradient(gt)

RMS_gt = np.sqrt(self.acc_gradient + smoothingterm)

RMS_up = np.sqrt(self.acc_updates + smoothingterm)

deltax = -RMS_up / RMS_gt * gt

self.accumulate_updates(deltax)

return x + deltax

ADADELTA.step = step

进行t步

def process(self, startx, t, smoothingterm=1e-8):

x = startx

for i in range(t):

self.progress.append(x)

x = self.step(x, smoothingterm)

return self.progress

ADADELTA.process = process

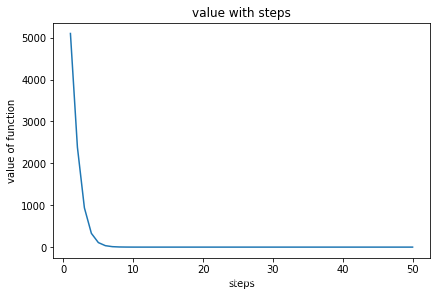

可视化

def plot(self):

x = np.arange(1, len(self.progress) + 1)

y = np.array([

self.function(item) for item in self.progress

])

fig, ax = plt.subplots(constrained_layout=True)

ax.plot(x, y)

ax.set_xlabel("steps")

ax.set_ylabel("value of function")

ax.set_title("value with steps")

plt.show()

ADADELTA.plot = plot

def function(x):

return x[0] ** 2 + 50 * x[1] ** 2

def gradient(x):

return 2 * x[0] + 100 * x[1]

test = ADADELTA(function, gradient, 0.9)

test.reset()

startx = np.array([10, 10])

test.process(startx, 50)

test.plot()

ADADELTA: AN ADAPTIVE LEARNING RATE METHOD的更多相关文章

- Deep Learning 32: 自己写的keras的一个callbacks函数,解决keras中不能在每个epoch实时显示学习速率learning rate的问题

一.问题: keras中不能在每个epoch实时显示学习速率learning rate,从而方便调试,实际上也是为了调试解决这个问题:Deep Learning 31: 不同版本的keras,对同样的 ...

- Keras 自适应Learning Rate (LearningRateScheduler)

When training deep neural networks, it is often useful to reduce learning rate as the training progr ...

- Dynamic learning rate in training - 培训中的动态学习率

I'm using keras 2.1.* and want to change the learning rate during training. I know about the schedul ...

- mxnet设置动态学习率(learning rate)

https://blog.csdn.net/xiaotao_1/article/details/78874336 如果learning rate很大,算法会在局部最优点附近来回跳动,不会收敛: 如果l ...

- 学习率(Learning rate)的理解以及如何调整学习率

1. 什么是学习率(Learning rate)? 学习率(Learning rate)作为监督学习以及深度学习中重要的超参,其决定着目标函数能否收敛到局部最小值以及何时收敛到最小值.合适的学习率 ...

- 跟我学算法-吴恩达老师(mini-batchsize,指数加权平均,Momentum 梯度下降法,RMS prop, Adam 优化算法, Learning rate decay)

1.mini-batch size 表示每次都只筛选一部分作为训练的样本,进行训练,遍历一次样本的次数为(样本数/单次样本数目) 当mini-batch size 的数量通常介于1,m 之间 当 ...

- learning rate warmup实现

def noam_scheme(global_step, num_warmup_steps, num_train_steps, init_lr, warmup=True): ""& ...

- pytorch learning rate decay

关于learning rate decay的问题,pytorch 0.2以上的版本已经提供了torch.optim.lr_scheduler的一些函数来解决这个问题. 我在迭代的时候使用的是下面的方法 ...

- machine learning (5)---learning rate

degugging:make sure gradient descent is working correctly cost function(J(θ)) of Number of iteration ...

随机推荐

- A Child's History of England.30

CHAPTER 10 ENGLAND UNDER HENRY THE FIRST, CALLED FINE-SCHOLAR Fine-scholar, on hearing of the Red Ki ...

- 单体内置对象 Global 和 Math

单体内置对象 Global 和 Math 在所有代码执行前,作用域中就已经存在两个内置对象:Global(全局)和Math.在大多数ES实现中都不能直接访问Global对象.不过,WEB浏览器实现了承 ...

- Set && Map

ES6 提供了新的数据结构 Set, Map Set成员的值都是唯一的,没有重复的值,Set内的元素是强类型,会进行类型检查. let set = new Set([1, true, '1', 'tr ...

- Linux信号1

信号(signal)是一种软中断,他提供了一种处理异步事件的方法,也是进程间唯一的异步通信方式.在Linux系统中,根据POSIX标准扩展以后的信号机制,不仅可以用来通知某进程发生了什么事件,还可以给 ...

- 【Linux】【Shell】【Basic】条件测试和变量

bash脚本编程 脚本文件格式: 第一行,顶格:#!/bin/bash 注释信息:# 代码注释: 缩进,适度添加空白行: ...

- this指针的用法和基本分析

当在不同的对象中采用this指针,就已经是在给它赋值了.对象各自的this指针指向各自对象的首地址,所以不同对象的this指针一定指向不同的内存地址. this 指针是由系统自动提供的指向对象的特殊指 ...

- 【C/C++】二维数组的传参的方法/二维字符数组的声明,使用,输入,传参

[问题] 定义了一个子函数,传参的内容是一个二维数组 编译提示错误 因为多维数组作为形参传入时,必须声明除第一位维外的确定值,否则系统无法编译(算不出偏移地址) [二维数组的传参] 方法一:形参为二维 ...

- numpy基础教程--clip函数的使用

在numpy中,clip函数的原型为clip(self, min=None, max=None, out=None),意思是把小于min的数全部置换为min,大于max的数全部置换为max,在[min ...

- C++STL标准库学习笔记(四)multiset续

自定义排序规则的multiset用法 前言: 在这个笔记中,我把大多数代码都加了注释,我的一些想法和注解用蓝色字体标记了出来,重点和需要关注的地方用红色字体标记了出来,只不过这一次的笔记主要是我的补充 ...

- Linux下安装chrome

目录 一.Centos系列 二.Ubuntu系列 一.Centos系列 1.配置yum下载源 vim /etc/yum.repos.d/chrome.repo [google-chrome] name ...