Hadoop_07_HDFS的Java API 操作

通过Java API来访问HDFS

1.Windows上配置环境变量

解压Hadoop,然后把Hadoop的根目录配置到HADOOP_HOME环境变量里面

然后把HADOOP_HOME/lib和HADOOP_HOME/bin配置到path里面

2.替换bin目录

将官网下载的Hadoop目录下面的bin目录替换成Windows下编译的Hadoop的bin目录:

我已经上传了自己编译好的hadoop-2.6.1的bin目录,可以从https://pan.baidu.com/s/1P50N60Qb16zuZxSwPq6HaA下载

也可参考他人博客http://blog.csdn.net/mrbcy/article/details/55806809 自已编译适合自己电脑系统的版本即可

3.Eclipse需要的jar包依赖

需要添加的jar包列表如下:

- hadoop/share/hadoop/common/hadoop-common-2.6.4.jar

- hadoop/share/hadoop/common/lib/*.jar

- hadoop/share/hadoop/hdfs/hadoop-hdfs-2.6.4.jar

- hadoop/share/hadoop/hdfs/lib/*.jar

4.使用客户端操作HDFS文件系统

4.1.上传文件(有HADOOP_HOME就可以上传)

package cn.bigdata.hdfs;

import java.io.IOException;

import java.net.URI;

import java.net.URISyntaxException;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import org.junit.Before;

import org.junit.Test;

/**

* 客户端去操作HDFS时,是有一个用户身份的

* 默认情况下,hdfs客户端api会从jvm中获取一个参数来作为自己的用户身份:-DHADOOP_USER_NAME=root

* 也可以在构造客户端fs对象时,通过参数传递进去

*/ public class HdfsCientDemo {

private FileSystem fs = null;

Configuration conf = null;

@Before

public void inin() throws IOException, InterruptedException, URISyntaxException{

Configuration conf = new Configuration();

//拿到一个文件系统操作的客户端实例对象,最后一个参数为用户名,nameNode访问路径:hdfs://shizhan2:9000

fs = FileSystem.get(new URI("hdfs://shizhan2:9000"),conf,"root");

} //上传文件

@Test

public void testUpload() throws Exception{

fs.copyFromLocalFile(new Path("c:/regist.log"), new Path("/regist-copy.log"));

fs.close();

}

}

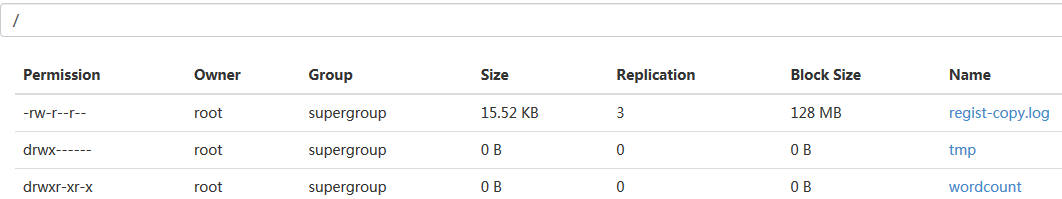

运行后,上传文件成功:

4.2.下载文件(替换了bin才可以下载)

@Test

public void testDownload() throws Exception {

fs.copyToLocalFile(false, new Path("/regist-copy.log"), new Path("D:/"), false);

fs.close();

}

4.3.查看conf参数信息:

//查看conf的配置信息

@Test

public void testConf(){

Iterator<Entry<String, String>> it = conf.iterator();

while(it.hasNext()){

Entry<String, String> ent = it.next();

System.out.println(ent.getKey() + " : " + ent.getValue());

}

}

4.4.创建文件夹:

@Test

public void testMkdir() throws Exception {

boolean result = fs.mkdirs(new Path("/testmkdir/aaa/bbb"));

System.out.println(result);

}

4.5.删除文件夹:

@Test

public void testDelete() throws Exception {

// 递归删除

boolean result = fs.delete(new Path("/testmkdir/aaa/"),true);

System.out.println(result);

}

4.6.查看目录文件夹信息:

@Test

public void testLs() throws Exception {

RemoteIterator<LocatedFileStatus> lt = fs.listFiles(new Path("/"), true); while(lt.hasNext()){

LocatedFileStatus fileStatus = lt.next();

System.out.println("name:" + fileStatus.getPath().getName()

+ " owner:" + fileStatus.getOwner());

}

}

5.总结:

在java中操作hdfs,首先要获得一个客户端实例

|

Configuration conf = new Configuration() FileSystem fs = FileSystem.get(conf) |

而我们的操作目标是HDFS,所以获取到的fs对象应该是DistributedFileSystem的实例;

get方法是从何处判断具体实例化那种客户端类呢?从conf中的一个参数 fs.defaultFS的配置值判断;

如果我们的代码中没有指定fs.defaultFS,并且工程classpath下也没有给定相应的配置,conf中的默认值就来自于hadoop

的jar包中的core-default.xml,默认值为: file:///,则获取的将不是一个DistributedFileSystem的实例,而是一个本地文

件系统的客户端对象

Hadoop_07_HDFS的Java API 操作的更多相关文章

- hive-通过Java API操作

通过Java API操作hive,算是测试hive第三种对外接口 测试hive 服务启动 package org.admln.hive; import java.sql.SQLException; i ...

- hadoop2-HBase的Java API操作

Hbase提供了丰富的Java API,以及线程池操作,下面我用线程池来展示一下使用Java API操作Hbase. 项目结构如下: 我使用的Hbase的版本是 hbase-0.98.9-hadoop ...

- 使用Java API操作HDFS文件系统

使用Junit封装HFDS import org.apache.hadoop.conf.Configuration; import org.apache.hadoop.fs.*; import org ...

- Kafka系列三 java API操作

使用java API操作kafka 1.pom.xml <project xmlns="http://maven.apache.org/POM/4.0.0" xmlns:xs ...

- Hadoop之HDFS(三)HDFS的JAVA API操作

HDFS的JAVA API操作 HDFS 在生产应用中主要是客户端的开发,其核心步骤是从 HDFS 提供的 api中构造一个 HDFS 的访问客户端对象,然后通过该客户端对象操作(增删改查)HDFS ...

- MongoDB Java API操作很全的整理

MongoDB 是一个基于分布式文件存储的数据库.由 C++ 语言编写,一般生产上建议以共享分片的形式来部署. 但是MongoDB官方也提供了其它语言的客户端操作API.如下图所示: 提供了C.C++ ...

- zookeeper的java api操作

zookeeper的java api操作 创建会话: Zookeeper(String connectString,int sessionTimeout,Watcher watcher) Zookee ...

- java api操作

java api操作 导入开发包 将hbase安装包中lib下包导入java项目 创建表 Configuration conf = HBaseConfiguration.create(); c ...

- HDFS 05 - HDFS 常用的 Java API 操作

目录 0 - 配置 Hadoop 环境(Windows系统) 1 - 导入 Maven 依赖 2 - 常用类介绍 3 - 常见 API 操作 3.1 获取文件系统(重要) 3.2 创建目录.写入文件 ...

随机推荐

- golang中字符串内置函数整理

字符串内置函数 1. 判断字符串的长度 str := "korea国" fmt.Println("str len=", len(str)) 2. 字符串遍历,同 ...

- Quickcocos从安装到打包

Quick-Cocos2dx-Community 是跨平台的游戏引擎,支持时下流行的 Android 移动操作系统.本节将教大家如何在 Windows 上把已经开发好的游戏打包为 Android 上可 ...

- 奥比中光Astra Pro的使用(1)

在ubuntu上的使用 首先下载SDK以及OpenNI安装包,下载地址: 解压两个安装包 切换目录到AstraSDK-Linux下的install目录,并输入命令:sudo sh ./install. ...

- C学习笔记-多源文件的编译

多源文件的意义 为了精简代码和更好的维护代码,往往需要将一些功能实现的代码与主函数代码分开来 在使用的时候再主函数中调用 多源文件的使用 假设现有my.c和main.c两个源代码文件,现在要再main ...

- @Transactional事务总结

一:加了注解@Transactional就能起作用的原理总结: 1:首先是由类:JdkDynamicAopProxy,在invoke方法里面创建动态代理类,同时由拦截类进行拦截,代码如下所示: Lis ...

- Linux下将用户添加到sudoers中

Linux默认是没有将用户添加到sudoers列表中的,需要root手动将账户添加到sudoers列表中,才能让普通账户执行sudo命令. root 账户键入visudo即可进入sudo配置,这个命令 ...

- 判断屏幕宽度px大小鉴别是移动设备或者PC

if(window.matchMedia("(max-width: 767px)").matches){ alert("这是一个移动设备.");}else { ...

- springboot整合filter

新建一个项目 新建Firstfilter类 Firstfliter.java package com.example.filter; import java.io.IOException; impor ...

- FileSystemResource 找不到文件

环境 Spring 3.2.5.RELEASE 原因 使用 FileSystemResource 加载文件的过程中,发现一个奇怪的现象,路径完全正确,但是找不到文件的情况.可能的原因是文件的路径上有压 ...

- idea模块在maven projects中显示灰色的解决办法

如题,出现的情况如下图所示 解决方式 将√去掉,点击确定关闭,对maven进行刷新操作 解决