"揭秘CentosChina爬虫项目:掌握Scrapy框架的必备技巧与数据库设计"

Centoschina

项目要求

爬取centoschina_cn的所有问题,包括文章标题和内容

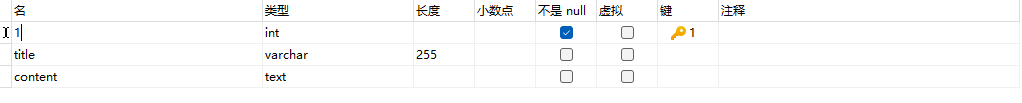

数据库表设计

库表设计:

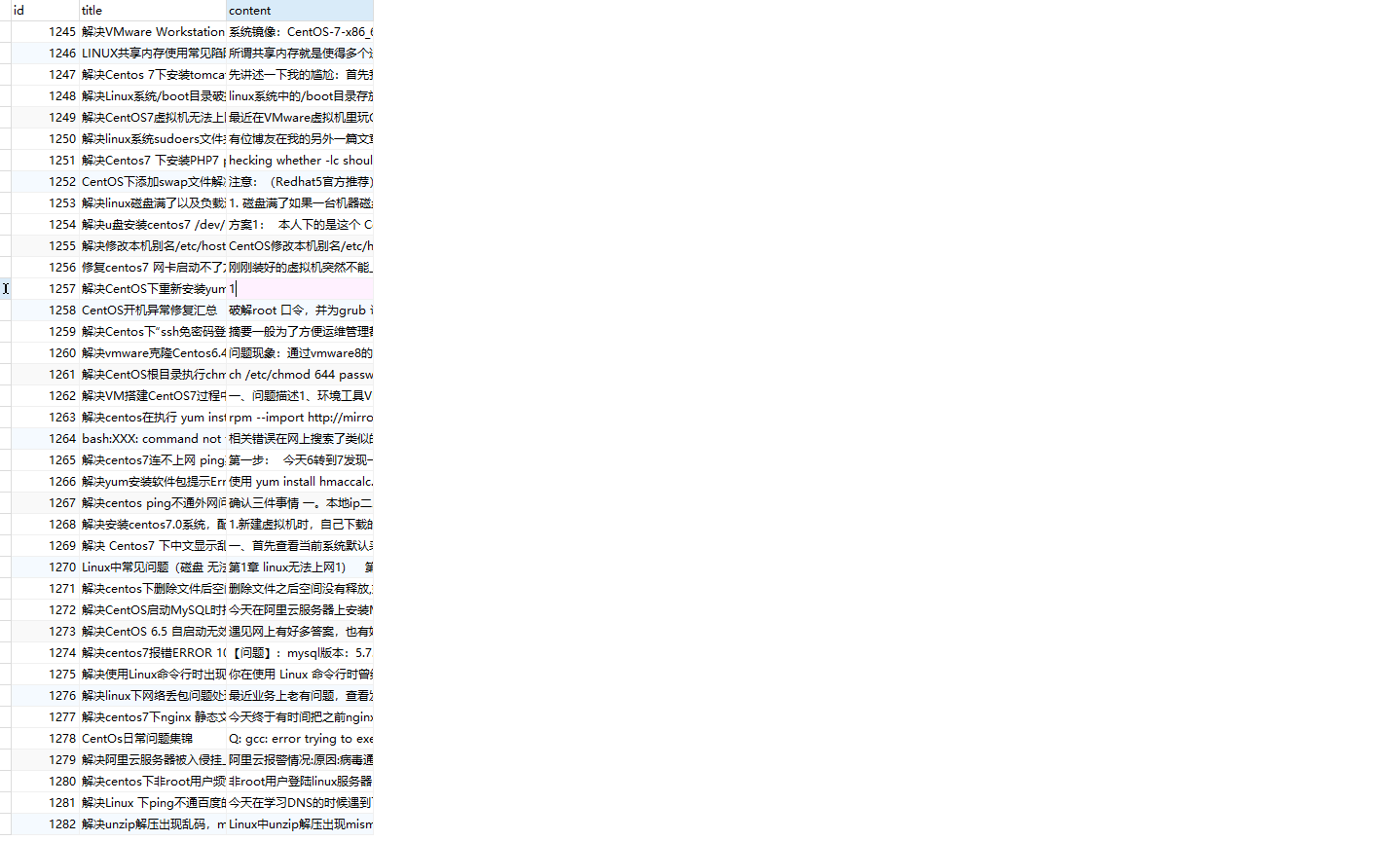

数据展示:

项目亮点

低耦合,高内聚。

爬虫专有settings

custom_settings = custom_settings_for_centoschina_cn

custom_settings_for_centoschina_cn = {

'MYSQL_USER': 'root',

'MYSQL_PWD': '123456',

'MYSQL_DB': 'questions',

}

DownloaderMiddleware使用

class CentoschinaDownloaderMiddleware:

# Not all methods need to be defined. If a method is not defined,

# scrapy acts as if the downloader middleware does not modify the

# passed objects. @classmethod

def from_crawler(cls, crawler):

# This method is used by Scrapy to create your spiders.

s = cls()

crawler.signals.connect(s.spider_opened, signal=signals.spider_opened)

return s # 处理请求

def process_request(self, request, spider):

# Called for each request that goes through the downloader

# middleware. # Must either:

# - return None: continue processing this request 继续执行下一步操作,不处理默认返回None

# - or return a Response object 直接返回响应, 如scrapy和pyppeteer不需要用下载器中间件访问外网,直接返回响应, pyppeteer有插件,一般和scrapy还能配合,selenium不行,没有插件

# - or return a Request object 将请求返回到schdular的调度队列中供以后重新访问

# - or raise IgnoreRequest: process_exception() methods of

# installed downloader middleware will be called

return None # 处理响应

def process_response(self, request, response, spider):

# Called with the response returned from the downloader. # Must either;

# - return a Response object 返回响应结果

# - return a Request object 结果不对(判断结果对不对一般判断状态码和内容大小)一般返回request,也是将请求返回到schdular的调度队列中供以后重新访问

# - or raise IgnoreRequest

return response # 处理异常:如超时错误等

def process_exception(self, request, exception, spider):

# Called when a download handler or a process_request()

# (from other downloader middleware) raises an exception. # Must either:

# - return None: continue processing this exception 继续执行下一步,没有异常

# - return a Response object: stops process_exception() chain 如果其返回一个 Response 对象,则已安装的中间件链的 process_response() 方法被调用。Scrapy将不会调用任何其他中间件的 process_exception() 方法。

# - return a Request object: stops process_exception() chain 将请求返回到schdular的调度队列中供以后重新访问

pass def spider_opened(self, spider):

spider.logger.info("Spider opened: %s" % spider.name)

DownloaderMiddleware中抛弃请求写法

- 适用场景:请求异常,换代理或者换cookie等操作

# from scrapy.exceptions import IgnoreRequest

# raise IgnoreRequest(f'Failed to retrieve {request.url} after {max_retries} retries')

例子:处理下载异常并重试请求

import logging

from scrapy.exceptions import IgnoreRequest class RetryExceptionMiddleware:

def __init__(self):

self.logger = logging.getLogger(__name__) def process_exception(self, request, exception, spider):

# 记录异常信息

self.logger.warning(f'Exception {exception} occurred while processing {request.url}') # 检查是否达到重试次数限制

max_retries = 3

retries = request.meta.get('retry_times', 0) + 1 if retries <= max_retries:

self.logger.info(f'Retrying {request.url} (retry {retries}/{max_retries})')

# 增加重试次数

request.meta['retry_times'] = retries

return request

else:

self.logger.error(f'Failed to retrieve {request.url} after {max_retries} retries')

raise IgnoreRequest(f'Failed to retrieve {request.url} after {max_retries} retries')例子:切换代理

import random class SwitchProxyMiddleware:

def __init__(self, proxy_list):

self.proxy_list = proxy_list

self.logger = logging.getLogger(__name__) @classmethod

def from_crawler(cls, crawler):

proxy_list = crawler.settings.get('PROXY_LIST')

return cls(proxy_list) def process_exception(self, request, exception, spider):

self.logger.warning(f'Exception {exception} occurred while processing {request.url}') # 切换代理

proxy = random.choice(self.proxy_list)

self.logger.info(f'Switching proxy to {proxy}')

request.meta['proxy'] = proxy # 重试请求

return requestpiplines中抛弃item写法

- 适用场景:数据清洗、去重、验证等操作

# from scrapy.exceptions import DropItem

# raise DropItem("Duplicate item found: %s" % item)

保存到文件(通过命令)

from scrapy.cmdline import execute

execute(['scrapy', 'crawl', 'centoschina_cn', '-o', 'questions.csv'])

更多精致内容:

"揭秘CentosChina爬虫项目:掌握Scrapy框架的必备技巧与数据库设计"的更多相关文章

- 第三百三十一节,web爬虫讲解2—Scrapy框架爬虫—Scrapy安装—Scrapy指令

第三百三十一节,web爬虫讲解2—Scrapy框架爬虫—Scrapy安装—Scrapy指令 Scrapy框架安装 1.首先,终端执行命令升级pip: python -m pip install --u ...

- 关于Scrapy爬虫项目运行和调试的小技巧(下篇)

前几天给大家分享了关于Scrapy爬虫项目运行和调试的小技巧上篇,没来得及上车的小伙伴可以戳超链接看一下.今天小编继续沿着上篇的思路往下延伸,给大家分享更为实用的Scrapy项目调试技巧. 三.设置网 ...

- 第三百三十五节,web爬虫讲解2—Scrapy框架爬虫—豆瓣登录与利用打码接口实现自动识别验证码

第三百三十五节,web爬虫讲解2—Scrapy框架爬虫—豆瓣登录与利用打码接口实现自动识别验证码 打码接口文件 # -*- coding: cp936 -*- import sys import os ...

- 第三百三十四节,web爬虫讲解2—Scrapy框架爬虫—Scrapy爬取百度新闻,爬取Ajax动态生成的信息

第三百三十四节,web爬虫讲解2—Scrapy框架爬虫—Scrapy爬取百度新闻,爬取Ajax动态生成的信息 crapy爬取百度新闻,爬取Ajax动态生成的信息,抓取百度新闻首页的新闻rul地址 有多 ...

- 第三百三十三节,web爬虫讲解2—Scrapy框架爬虫—Scrapy模拟浏览器登录—获取Scrapy框架Cookies

第三百三十三节,web爬虫讲解2—Scrapy框架爬虫—Scrapy模拟浏览器登录 模拟浏览器登录 start_requests()方法,可以返回一个请求给爬虫的起始网站,这个返回的请求相当于star ...

- 第三百三十二节,web爬虫讲解2—Scrapy框架爬虫—Scrapy使用

第三百三十二节,web爬虫讲解2—Scrapy框架爬虫—Scrapy使用 xpath表达式 //x 表示向下查找n层指定标签,如://div 表示查找所有div标签 /x 表示向下查找一层指定的标签 ...

- Python爬虫进阶之Scrapy框架安装配置

Python爬虫进阶之Scrapy框架安装配置 初级的爬虫我们利用urllib和urllib2库以及正则表达式就可以完成了,不过还有更加强大的工具,爬虫框架Scrapy,这安装过程也是煞费苦心哪,在此 ...

- python爬虫入门(六) Scrapy框架之原理介绍

Scrapy框架 Scrapy简介 Scrapy是用纯Python实现一个为了爬取网站数据.提取结构性数据而编写的应用框架,用途非常广泛. 框架的力量,用户只需要定制开发几个模块就可以轻松的实现一个爬 ...

- 爬虫基础(五)-----scrapy框架简介

---------------------------------------------------摆脱穷人思维 <五> :拓展自己的视野,适当做一些眼前''无用''的事情,防止进入只关 ...

- 爬虫(二)之scrapy框架

01-scrapy介绍 02-项目的目录结构: scrapy.cfg 项目的主配置信息.(真正爬虫相关的配置信息在settings.py 文件中) items.py 设置数据存储模板,用于结构化数据, ...

随机推荐

- uniapp ios推送 离线推送收不到消息

突然之间收不到离线推送消息了,角标也不显示了. 查了很长时间发现是ios的推送证书过期了. 我用的是appuploader登陆上以后在证书管理中新创建证书就可以了.

- HTML5 在泛在电力物联网的 10 大业务领域 2/3D 可视化应用

过去的 2018 年,我们认为是国内工业互联网可视化的元年,图扑软件作为在工业可视化领域的重度参与者,一线见证了众多 HTML5/Web 化.2D/3D 化的项目在工业界应用落地. 2019 年可以定 ...

- Atcoder Beginner Contest 324 F Beautiful Path 题解-分数规划

为了更好的阅读体验,请点击这里 分数规划小技巧:尽可能将式子写成存在某种取值,使得不等式成立的形式. 不然可能需要绕几个弯才能想出来. 题目链接 题目大意:给出一个 DAG,每条边有一个 \(b_i, ...

- 记录一下第一次webSocket通信成功

webSocket前端代码 <!DOCTYPE html> <html lang="en"> <head> <meta charset=& ...

- Kubernetes(四)Pod详解

Pod详解 本章主要介绍Pod资源的各种配置(yaml文件)和原理 1. Pod介绍 如上图所示,每个Pod中都可以包含一个或多个Container,这些Containers 可以分为2类: 用户程序 ...

- .NET 个人博客-首页排版优化

个人博客-首页排版优化 优化计划 置顶3个且可滚动或切换 推荐改为4个,然后新增历史文章,将推荐的加载更多放入历史文章,按文章发布时间降序排列. 标签功能,可以为文章贴上标签 推荐点赞功能 本篇文章优 ...

- Ubuntu 18.04 安装OneDrive自动同步

Ubuntu 18.04 安装OneDrive自动同步 Windows10系统已经自带了OneDrive的自动同步功能,对于多设备用户而言已经成为了一个非常方便传输保存文件的途径,在Ubuntu下也有 ...

- Nuxt3 的生命周期和钩子函数(五)

title: Nuxt3 的生命周期和钩子函数(五) date: 2024/6/29 updated: 2024/6/29 author: cmdragon excerpt: 摘要:本文详细介绍了Nu ...

- 详解Web应用安全系列(5)敏感数据泄露漏洞

在最近几年,这是最常见的,最具影响力的攻击.这个领域最常见的漏洞是不对敏感数据进行加密.在数据加密过程中,常见的问题是不安全的密钥生成和管理以及使用弱密码算法,弱协议和弱密码.特别是使用弱的哈希算法来 ...

- 新品来袭,全国产ARM+FPGA--"RK3568J+Logos-2"工业核心板,让您的硬件设计“更简单”!

如需选购,请登录创龙科技天猫旗舰店: tronlong.tmall.com! 欢迎加入RK3568J技术交流群:567208221 欢迎加入Logos-2技术交流群:311416997 更多产品详情以 ...