使用python爬虫爬取股票数据

前言:

编写一个爬虫脚本,用于爬取东方财富网的上海股票代码,并通过爬取百度股票的单个股票数据,将所有上海股票数据爬取下来并保存到本地文件中

系统环境:

64位win10系统,64位python3.6,IDE位pycharm

预备知识:

BeautifulSoup的基本知识,re正则表达式的基本知识

代码:

import requests

from bs4 import BeautifulSoup

import traceback

import re

def getHTMLText(url):

try:

user_agent = '自己的浏览器头部信息'

headers = {'User-Agent': user_agent}

r = requests.get(url,headers = headers,timeout = 30)

r.raise_for_status()

r.encoding = r.apparent_encoding

return r.text

except:

return "" def getStockList(lst,stock_list_url):

html = getHTMLText(stock_list_url)

soup = BeautifulSoup(html,'html.parser')

a = soup.find_all('a')

for i in a:

try:

href = i.attrs['href']

lst.append(re.findall(r"sh\d{6}",href)[0])

#print(lst)

except:

continue def getStockInfo(lst,stock_info_url,fpath):

for stock in lst:

url = stock_info_url + stock + '.html'

html = getHTMLText(url)

try:

if html =="":

continue

infoDict = { }

soup = BeautifulSoup(html,'html.parser')

stockInfo = soup.find('div',attrs = {'class':'stock-bets'})

if stockInfo == None:

continue

#print(stockInfo)

name = stockInfo.find_all(attrs={'class':'bets-name'})[0]

#print(name)

infoDict.update({'股票名称': name.text.split()[0]}) keyList = stockInfo.find_all('dt')

valueList = stockInfo.find_all('dd')

for i in range(len(keyList)): key = keyList[i].text

val = valueList[i].text

infoDict[key] = val

with open(fpath,'a',encoding = 'utf-8') as f:

f.write(str(infoDict) + '\n')

except:

traceback.print_exc()

continue def main():

stock_list_url = 'http://quote.eastmoney.com/stocklist.html'

stock_info_url = 'http://gupiao.baidu.com/stock/'

output_file = 'D://Postgraduate//Python//python项目//Python网络爬虫与信息提取-中国大学MOOC//3 网络爬虫之实战//BaiduStockInfo.txt'

slist = []

getStockList(slist,stock_list_url)

getStockInfo(slist,stock_info_url,output_file) main()

代码解释:

第一个getHTMLText函数的作用是获得所需的网页源代码

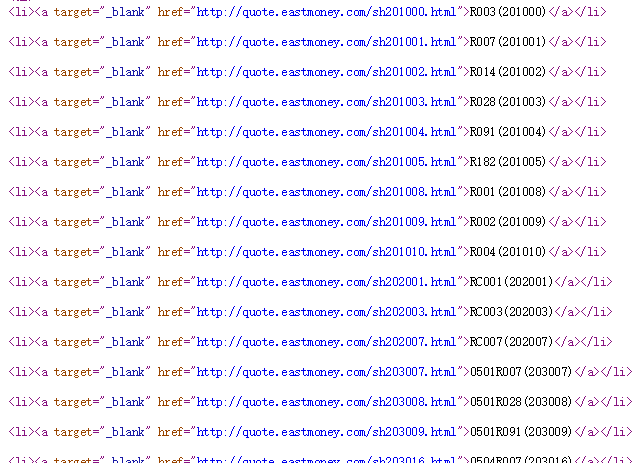

第二个getStockList函数的作用是获得东方财富网上面上海股票的全部代码,查看网页源代码可知,股票代码的数据放在'a'标签里面,如下图所示:

因此,首先用find_all方法遍历所有'a'标签,然后在'a'标签里面提取出href部分信息,在提取出来的href信息里面,用正则表达式匹配所需的信息,“sh\d{6}”,即徐亚匹配例如sh200010的信息

第三个函数需要根据第二个函数得到的股票代码,拼接出一个url,在这个特定的url的网页里,使用第一个函数解析网页,首先加一个判断,如果遇到html为空,那么要继续执行下去,同样,我们也需要再加一个判断(关键之处),遇到网页不存在,

但html源代码仍然是存在的,因此接下去这个命令

stockInfo = soup.find('div',attrs = {'class':'stock-bets'})

可能为空,如果不加判断,程序执行到这里就会报错而无法继续执行,因此添加:

if stockInfo == None:

continue

使用python爬虫爬取股票数据的更多相关文章

- MATLAB爬虫爬取股票数据

近年来,大数据盛行,有关爬虫的教程层次不穷.那么,爬虫到底是什么呢? 什么是爬虫? 百度百科是这样定义的: 网络爬虫(又被称为网页蜘蛛,网络机器人,在FOAF社区中间,更经常的称为网页追逐者),是一种 ...

- python爬虫爬取天气数据并图形化显示

前言 使用python进行网页数据的爬取现在已经很常见了,而对天气数据的爬取更是入门级的新手操作,很多人学习爬虫都从天气开始,本文便是介绍了从中国天气网爬取天气数据,能够实现输入想要查询的城市,返回该 ...

- python爬虫——爬取网页数据和解析数据

1.网络爬虫的基本概念 网络爬虫(又称网络蜘蛛,机器人),就是模拟客户端发送网络请求,接收请求响应,一种按照一定的规则,自动地抓取互联网信息的程序.只要浏览器能够做的事情,原则上,爬虫都能够做到. 2 ...

- python爬虫----爬取阿里数据银行websocket接口

业务需求:爬取阿里品牌数据银行的自定义模块==>>>人群透视==>>>查看报告==>>数据 发现:数据通过websocket接口传递,此类型接口的详细理 ...

- 用Python爬取股票数据,绘制K线和均线并用机器学习预测股价(来自我出的书)

最近我出了一本书,<基于股票大数据分析的Python入门实战 视频教学版>,京东链接:https://item.jd.com/69241653952.html,在其中用股票范例讲述Pyth ...

- 用Python爬虫爬取广州大学教务系统的成绩(内网访问)

用Python爬虫爬取广州大学教务系统的成绩(内网访问) 在进行爬取前,首先要了解: 1.什么是CSS选择器? 每一条css样式定义由两部分组成,形式如下: [code] 选择器{样式} [/code ...

- 使用Python爬虫爬取网络美女图片

代码地址如下:http://www.demodashi.com/demo/13500.html 准备工作 安装python3.6 略 安装requests库(用于请求静态页面) pip install ...

- Python爬虫|爬取喜马拉雅音频

"GOOD Python爬虫|爬取喜马拉雅音频 喜马拉雅是知名的专业的音频分享平台,用户规模突破4.8亿,汇集了有声小说,有声读物,儿童睡前故事,相声小品等数亿条音频,成为国内发展最快.规模 ...

- Python爬虫爬取全书网小说,程序源码+程序详细分析

Python爬虫爬取全书网小说教程 第一步:打开谷歌浏览器,搜索全书网,然后再点击你想下载的小说,进入图一页面后点击F12选择Network,如果没有内容按F5刷新一下 点击Network之后出现如下 ...

随机推荐

- 常见的机器学习&数据挖掘知识点

原文:http://blog.csdn.net/heyongluoyao8/article/details/47840255 常见的机器学习&数据挖掘知识点 转载请说明出处 Basis(基础) ...

- ng-repeat不添加容器标签

如UL中的循环, 我们不期望添加额外的div之类的容器标签, 使用ng-repeat-start和ng-repeat-end可以实现 <li class="item item-icon ...

- Nginx 状态信息功能配置

Nginx 状态信息功能介绍 Nginx 有一个 ngx_http_stub_status_module 模块,主要功能是记录 Nginx 的基本访问状态信息,让使用者了解 Nginx 的工作状态 要 ...

- 10.翻译系列:EF 6中的Fluent API配置【EF 6 Code-First系列】

原文链接:https://www.entityframeworktutorial.net/code-first/fluent-api-in-code-first.aspx EF 6 Code-Firs ...

- [转]linux(ubuntu)上运行网易popo

popo没有linux版,连web版和android版都没有,这个实在是不方便.搞了很久,终于搞定了ubuntu上运行popo,暂时还没出现什么问题. 首先要安装PlayOnLinux,直接安装win ...

- SNF快速开发平台MVC-表格单元格合并组件

1. 表格单元格合并组件 1.1. 效果展示 1.1.1. 页面展现表格合并单元格 图 4.1 1.1.2. 导出excel合并单元格 图 4.2 1.2. 调用说 ...

- (5) 电商场景下的常见业务SQL处理

1. 如何对评论进行分页展示 一般情况下都是这样写 SELECT customer_id,title,content FROM product_comment WHERE audit_status = ...

- SAP BW: Replacement Path Variables

How to use Replacement Path Variables to perform Date Calculations A Step-by-Step guide Have you eve ...

- js的new Date()日期的使用

<script type="text/javascript"> //js获取某个月的天数 function days(year,month){ var dayCount ...

- PentesterLab渗透演练平台

转载自: https://www.blackh4t.org/archives/1143.html http://www.91ri.org/5958.html 1. 什么是WebApp Pen ...