python爬虫学习之使用XPath解析开奖网站

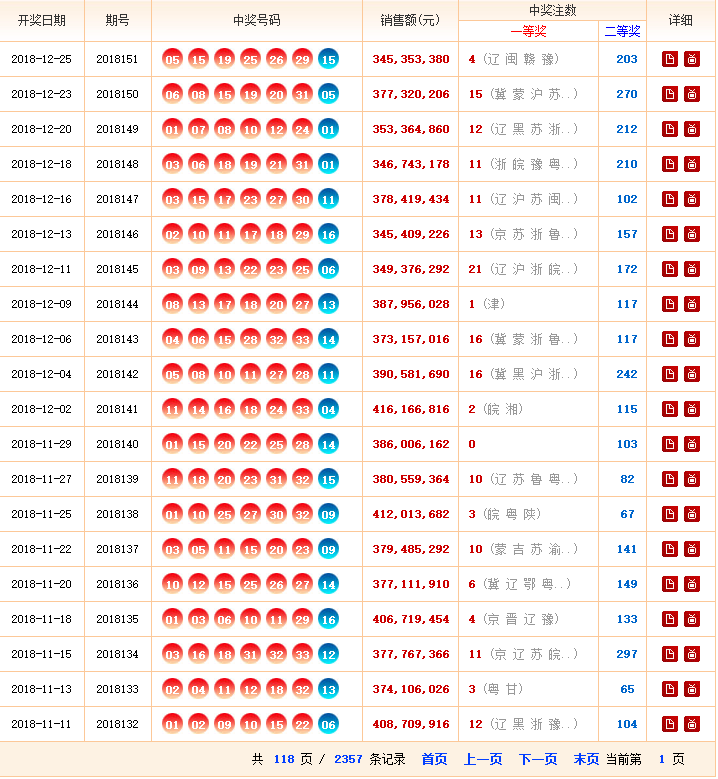

实例需求:运用python语言爬取http://kaijiang.zhcw.com/zhcw/html/ssq/list_1.html这个开奖网站所有的信息,并且保存为txt文件。

实例环境:python3.7

BeautifulSoup库、XPath(需手动安装)

urllib库(内置的python库,无需手动安装)

实例网站:

第一步,点击链接http://kaijiang.zhcw.com/zhcw/html/ssq/list_1.html进入网站,查看网站基本信息,注意一共要爬取118页数据。

第二步,查看网页源代码,熟悉网页结构,标签等信息。

实例代码:

#encoding=utf-8

#pip install lxml

from bs4 import BeautifulSoup

import urllib.request

from lxml import etree class GetDoubleColorBallNumber(object):

def __init__(self):

self.urls = []

self.getUrls()

self.items = self.spider(self.urls)

self.pipelines(self.items) def getUrls(self):

URL = r'http://kaijiang.zhcw.com/zhcw/html/ssq/list.html'

htmlContent = self.getResponseContent(URL)

soup = BeautifulSoup(htmlContent, 'html.parser')

tag = soup.find_all('p')[-1]

pages = tag.strong.get_text()

pages = '3'

for i in range(2, int(pages)+1):

url = r'http://kaijiang.zhcw.com/zhcw/html/ssq/list_' + str(i) + '.html'

self.urls.append(url) #3、 网络模块(NETWORK)

def getResponseContent(self, url):

try:

response = urllib.request.urlopen(url)

except urllib.request.URLError as e:

raise e

else:

return response.read().decode("utf-8") #3、爬虫模块(Spider)

def spider(self,urls):

items = []

for url in urls:

try:

html = self.getResponseContent(url)

xpath_tree = etree.HTML(html)

trTags = xpath_tree.xpath('//tr[not(@*)]') # 匹配所有tr下没有任何属性的节点

for tag in trTags: # if tag.xpath('../html'):

# print("找到了html标签")

# if tag.xpath('/td/em'):

# print("****************") #如果存在em子孙节点

if tag.xpath('./td/em'):

item = {}

item['date'] = tag.xpath('./td[1]/text()')[0]

item['order'] = tag.xpath('./td[2]/text()')[0]

item['red1'] = tag.xpath('./td[3]/em[1]/text()')[0]

item['red2'] = tag.xpath('./td[3]/em[2]/text()')[0]

item['red3'] = tag.xpath('./td[3]/em[3]/text()')[0]

item['red4'] = tag.xpath('./td[3]/em[4]/text()')[0]

item['red5'] = tag.xpath('./td[3]/em[5]/text()')[0]

item['red6'] = tag.xpath('./td[3]/em[6]/text()')[0]

item['blue'] = tag.xpath('./td[3]/em[7]/text()')[0]

item['money'] = tag.xpath('./td[4]/strong/text()')[0]

item['first'] = tag.xpath('./td[5]/strong/text()')[0]

item['second'] = tag.xpath('./td[6]/strong/text()')[0]

items.append(item)

except Exception as e:

print(str(e))

raise e

return items def pipelines(self,items):

fileName = u'双色球.txt'

with open(fileName, 'w') as fp:

for item in items:

fp.write('%s %s \t %s %s %s %s %s %s %s \t %s \t %s %s \n'

%(item['date'],item['order'],item['red1'],item['red2'],item['red3'],item['red4'],item['red5'],item['red6'],item['blue'],item['money'],item['first'],item['second'])) if __name__ == '__main__':

GDCBN = GetDoubleColorBallNumber()

实例结果:

python爬虫学习之使用XPath解析开奖网站的更多相关文章

- Python爬虫学习之使用beautifulsoup爬取招聘网站信息

菜鸟一只,也是在尝试并学习和摸索爬虫相关知识. 1.首先分析要爬取页面结构.可以看到一列搜索的结果,现在需要得到每一个链接,然后才能爬取对应页面. 关键代码思路如下: html = getHtml(& ...

- python爬虫学习之使用BeautifulSoup库爬取开奖网站信息-模块化

实例需求:运用python语言爬取http://kaijiang.zhcw.com/zhcw/html/ssq/list_1.html这个开奖网站所有的信息,并且保存为txt文件和excel文件. 实 ...

- python爬虫学习笔记(一)——环境配置(windows系统)

在进行python爬虫学习前,需要进行如下准备工作: python3+pip官方配置 1.Anaconda(推荐,包括python和相关库) [推荐地址:清华镜像] https://mirrors ...

- Python爬虫学习:三、爬虫的基本操作流程

本文是博主原创随笔,转载时请注明出处Maple2cat|Python爬虫学习:三.爬虫的基本操作与流程 一般我们使用Python爬虫都是希望实现一套完整的功能,如下: 1.爬虫目标数据.信息: 2.将 ...

- Python爬虫教程-22-lxml-etree和xpath配合使用

Python爬虫教程-22-lxml-etree和xpath配合使用 lxml:python 的HTML/XML的解析器 官网文档:https://lxml.de/ 使用前,需要安装安 lxml 包 ...

- 小白学 Python 爬虫(21):解析库 Beautiful Soup(上)

小白学 Python 爬虫(21):解析库 Beautiful Soup(上) 人生苦短,我用 Python 前文传送门: 小白学 Python 爬虫(1):开篇 小白学 Python 爬虫(2):前 ...

- 小白学 Python 爬虫(22):解析库 Beautiful Soup(下)

人生苦短,我用 Python 前文传送门: 小白学 Python 爬虫(1):开篇 小白学 Python 爬虫(2):前置准备(一)基本类库的安装 小白学 Python 爬虫(3):前置准备(二)Li ...

- 小白学 Python 爬虫(23):解析库 pyquery 入门

人生苦短,我用 Python 前文传送门: 小白学 Python 爬虫(1):开篇 小白学 Python 爬虫(2):前置准备(一)基本类库的安装 小白学 Python 爬虫(3):前置准备(二)Li ...

- python爬虫学习01--电子书爬取

python爬虫学习01--电子书爬取 1.获取网页信息 import requests #导入requests库 ''' 获取网页信息 ''' if __name__ == '__main__': ...

随机推荐

- python day03_ 文件处理

一.文件操作的基本流程 计算机操作文件的过程 #1. 打开文件,得到文件句柄并赋值给一个变量 #2. 通过句柄对文件进行操作 #3. 关闭文件 1.文件的打开过程 # f被程序持有,文件被操作系统持有 ...

- java_25.1字节转为字符OutputStreamWriter

public class Demo { public static void main(String[] args){ try { FileOutputStream fos = new FileOut ...

- Java并发编程:深入剖析ThreadLocal(转)

目录大纲: 一.对ThreadLocal的理解 二.深入解析ThreadLocal类 三.ThreadLocal的应用场景 原文链接:http://www.cnblogs.com/dolphin052 ...

- Python:a,*args,**kwargs的理解

1.何时用这些参数? 在任何时候继承类和重写方法时,应当用到’*args’和’**kwargs’将接收到的位置参数和键值参数给父类方法 . 2.一句话清晰说明: a是常规的变量类型,比如int,str ...

- Oracle定时任务Job笔记

定时任务应用场景: 某一个生产系统上面,临时表不断变多,占了不少磁盘空间.由于这套软件是直接买的,不方便修改源代码.所以考虑使用Oracle定时任务直接从数据库层删除临时表. 定时任务业务: 首先写好 ...

- laravel项目安装与重要目录文件说明(一)

一.laravel创建项目的二种方式: 1.通过laravel安装器,进行创建 composer global require laravel/installer laravel new 项目名 co ...

- JavaSE基础知识(5)—面向对象(Object类)

一.包 java.lang包,属于java中的核心包,系统默认导入的,不用手动导入该包中的类:Object.System.String.Integer等 1.包的好处 ①分类管理java文件,查找和管 ...

- python基础之Day17

一.包 1.包 含有--init--.py的文件夹 是模块的一种形式 本质是一个文件夹(用来存放文件,包内所有的文件都是用来被导入的) import 包 包.名字 往包的init里加名字 导 ...

- Scikit-learn 安装

Scikit-Learn 3 pip 安装 如果安装了Python,没有安装pip,使用Windows + R,输入cmd,回车打开命令行,输入 python -m pip install -U pi ...

- 【机器学习】K均值算法(II)

k聚类算法中如何选择初始化聚类中心所在的位置. 在选择聚类中心时候,如果选择初始化位置不合适,可能不能得出我们想要的局部最优解. 而是会出现一下情况: 为了解决这个问题,我们通常的做法是: 我们选取K ...