[Python数据挖掘]第5章、挖掘建模(下)

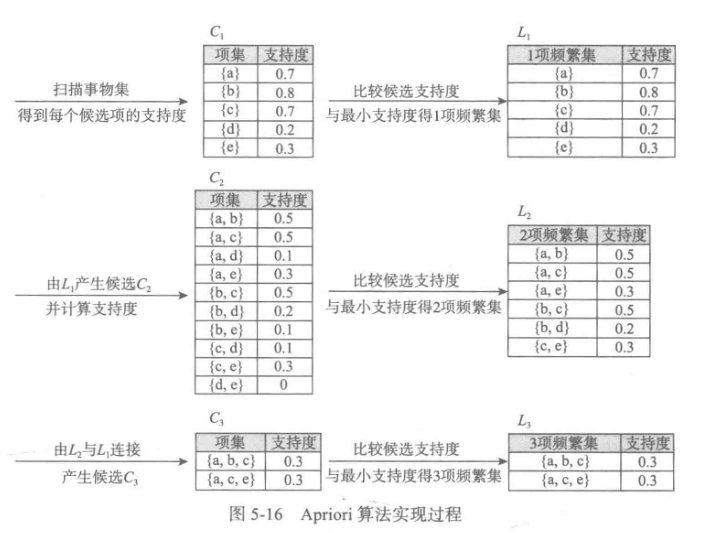

四、关联规则

Apriori算法代码(被调函数部分没怎么看懂)

from __future__ import print_function

import pandas as pd #自定义连接函数,用于实现L_{k-1}到C_k的连接

def connect_string(x, ms):

x = list(map(lambda i:sorted(i.split(ms)), x))

l = len(x[0])

r = []

for i in range(len(x)):

for j in range(i,len(x)):

if x[i][:l-1] == x[j][:l-1] and x[i][l-1] != x[j][l-1]:

r.append(x[i][:l-1]+sorted([x[j][l-1],x[i][l-1]]))

return r #寻找关联规则的函数

def find_rule(d, support, confidence, ms = u'--'):

result = pd.DataFrame(index=['support', 'confidence']) #定义输出结果 support_series = 1.0*d.sum()/len(d) #支持度序列

column = list(support_series[support_series > support].index) #初步根据支持度筛选

k = 0 while len(column) > 1:

k = k+1

print(u'\n正在进行第%s次搜索...' %k)

column = connect_string(column, ms)

print(u'数目:%s...' %len(column))

sf = lambda i: d[i].prod(axis=1, numeric_only = True) #新一批支持度的计算函数 #创建连接数据,这一步耗时、耗内存最严重。当数据集较大时,可以考虑并行运算优化。

d_2 = pd.DataFrame(list(map(sf,column)), index = [ms.join(i) for i in column]).T support_series_2 = 1.0*d_2[[ms.join(i) for i in column]].sum()/len(d) #计算连接后的支持度

column = list(support_series_2[support_series_2 > support].index) #新一轮支持度筛选

support_series = support_series.append(support_series_2)

column2 = [] for i in column: #遍历可能的推理,如{A,B,C}究竟是A+B-->C还是B+C-->A还是C+A-->B?

i = i.split(ms)

for j in range(len(i)):

column2.append(i[:j]+i[j+1:]+i[j:j+1]) cofidence_series = pd.Series(index=[ms.join(i) for i in column2]) #定义置信度序列 for i in column2: #计算置信度序列

cofidence_series[ms.join(i)] = support_series[ms.join(sorted(i))]/support_series[ms.join(i[:len(i)-1])] for i in cofidence_series[cofidence_series > confidence].index: #置信度筛选

result[i] = 0.0

result[i]['confidence'] = cofidence_series[i]

result[i]['support'] = support_series[ms.join(sorted(i.split(ms)))] result = result.T.sort_values(['confidence','support'], ascending = False) #结果整理,输出

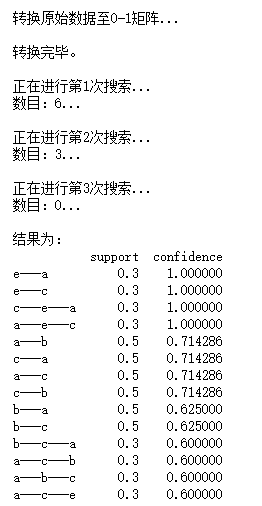

print(u'\n结果为:')

print(result)

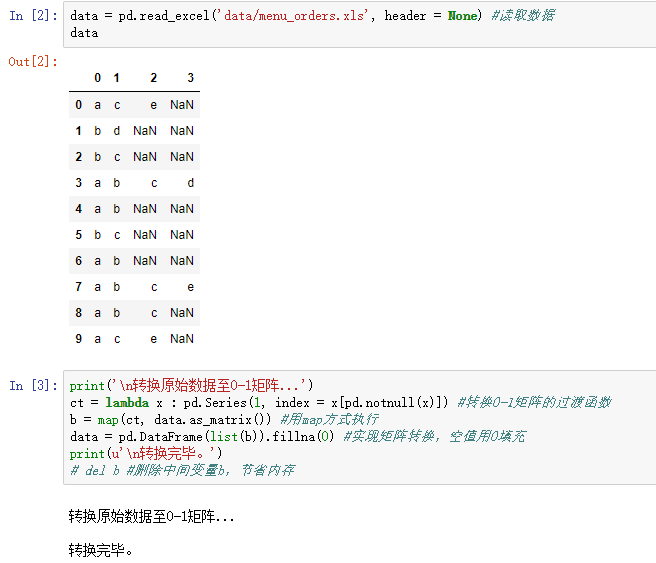

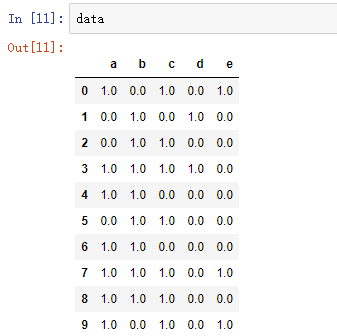

return result ## 上面部分可以封装在一个类中,然后在下面的主程序中直接调用find_rule函数 data = pd.read_excel('data/menu_orders.xls', header = None) #读取数据

print(u'\n转换原始数据至0-1矩阵...')

ct = lambda x : pd.Series(1, index = x[pd.notnull(x)]) #转换0-1矩阵的过渡函数

b = map(ct, data.as_matrix()) #用map方式执行

data = pd.DataFrame(list(b)).fillna(0) #实现矩阵转换,空值用0填充

print(u'\n转换完毕。')

del b #删除中间变量b,节省内存 support = 0.2 #最小支持度

confidence = 0.5 #最小置信度

ms = '---' #连接符,默认'--',用来区分不同元素,如A--B。需要保证原始表格中不含有该字符 find_rule(data, support, confidence, ms)

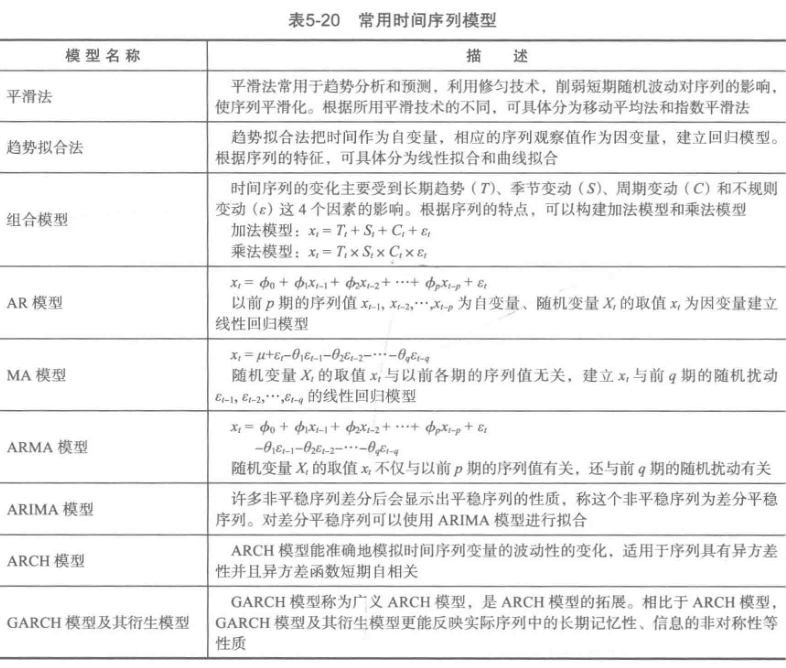

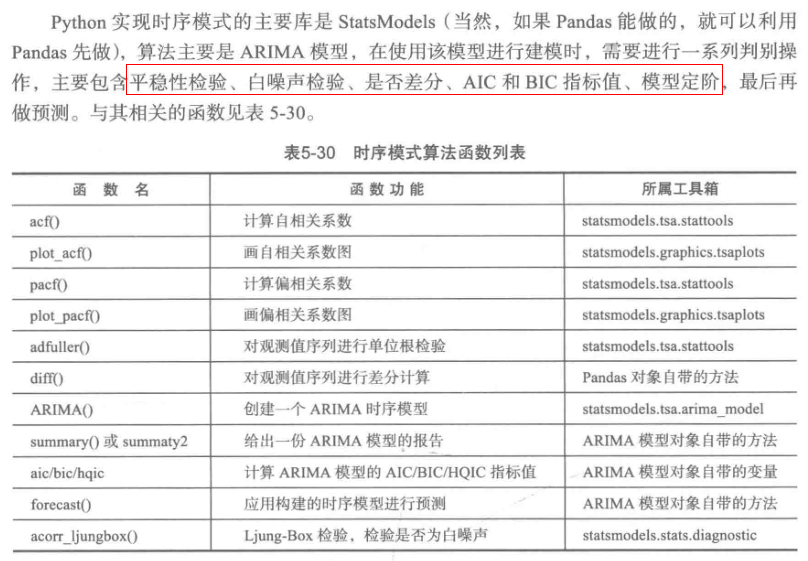

五、时序模式

以下代码全程懵逼

#arima时序模型

import matplotlib.pyplot as plt

import pandas as pd

%matplotlib inline

plt.rcParams['axes.unicode_minus']=False #正常显示负号 #读取数据,指定日期列为指标,Pandas自动将“日期”列识别为Datetime格式

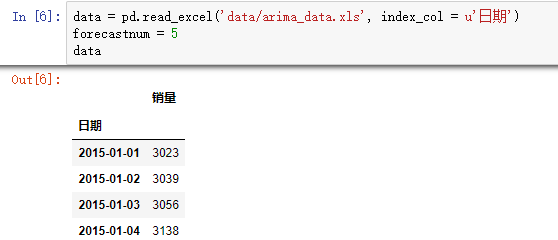

data = pd.read_excel('data/arima_data.xls', index_col = u'日期')

forecastnum = 5 #时序图

data.plot() #自相关图

from statsmodels.graphics.tsaplots import plot_acf

plot_acf(data).show() #平稳性检测

from statsmodels.tsa.stattools import adfuller as ADF

print(u'原始序列的ADF检验结果为:', ADF(data[u'销量']))

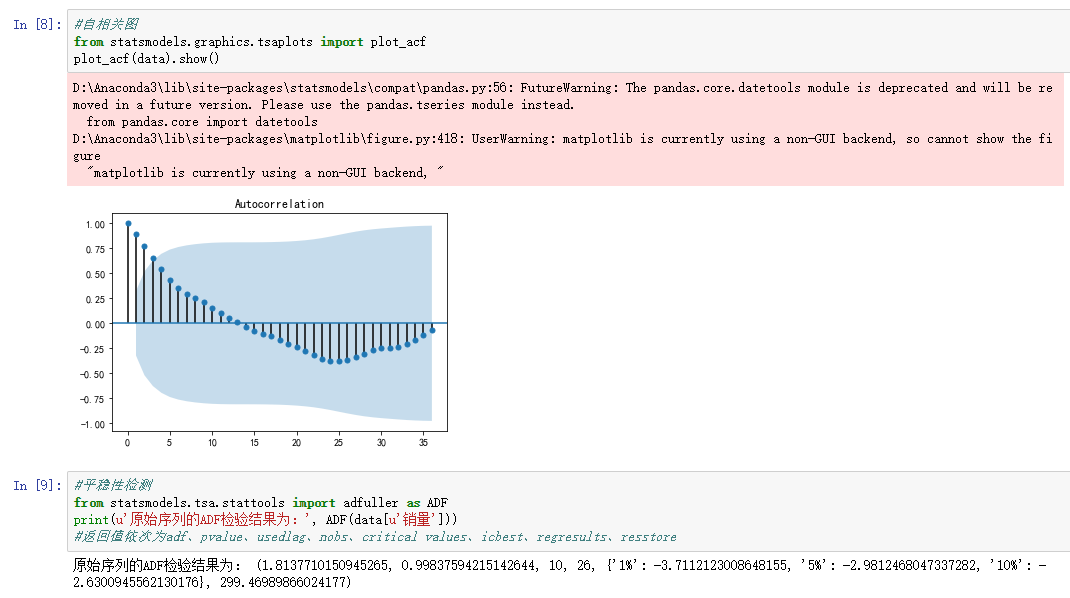

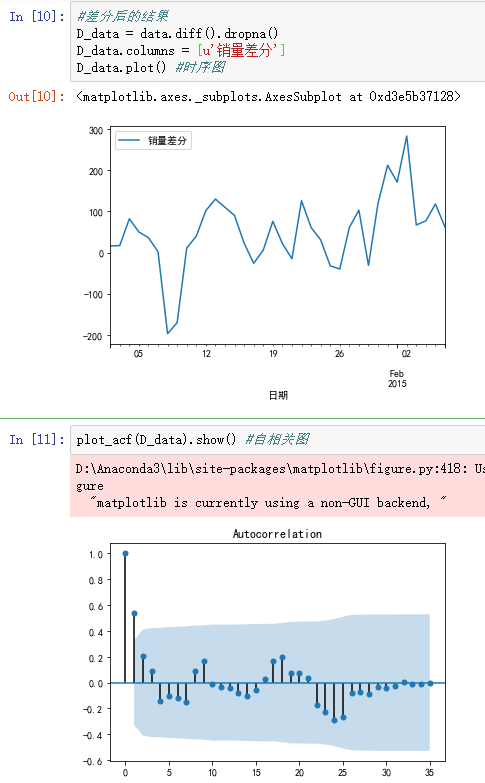

#返回值依次为adf、pvalue、usedlag、nobs、critical values、icbest、regresults、resstore #差分后的结果

D_data = data.diff().dropna()

D_data.columns = [u'销量差分']

D_data.plot() #时序图

plot_acf(D_data).show() #自相关图

from statsmodels.graphics.tsaplots import plot_pacf

plot_pacf(D_data).show() #偏自相关图

print(u'差分序列的ADF检验结果为:', ADF(D_data[u'销量差分'])) #平稳性检测 #白噪声检验

from statsmodels.stats.diagnostic import acorr_ljungbox

print(u'差分序列的白噪声检验结果为:', acorr_ljungbox(D_data, lags=1)) #返回统计量和p值 from statsmodels.tsa.arima_model import ARIMA data[u'销量'] = data[u'销量'].astype(float)

#定阶

pmax = int(len(D_data)/10) #一般阶数不超过length/10

qmax = int(len(D_data)/10) #一般阶数不超过length/10

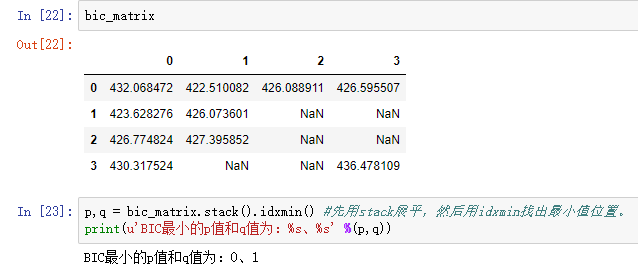

bic_matrix = [] #bic矩阵

for p in range(pmax+1):

tmp = []

for q in range(qmax+1):

try: #存在部分报错,所以用try来跳过报错。

tmp.append(ARIMA(data, (p,1,q)).fit().bic)

except:

tmp.append(None)

bic_matrix.append(tmp) bic_matrix = pd.DataFrame(bic_matrix) #从中可以找出最小值 p,q = bic_matrix.stack().idxmin() #先用stack展平,然后用idxmin找出最小值位置。

print(u'BIC最小的p值和q值为:%s、%s' %(p,q))

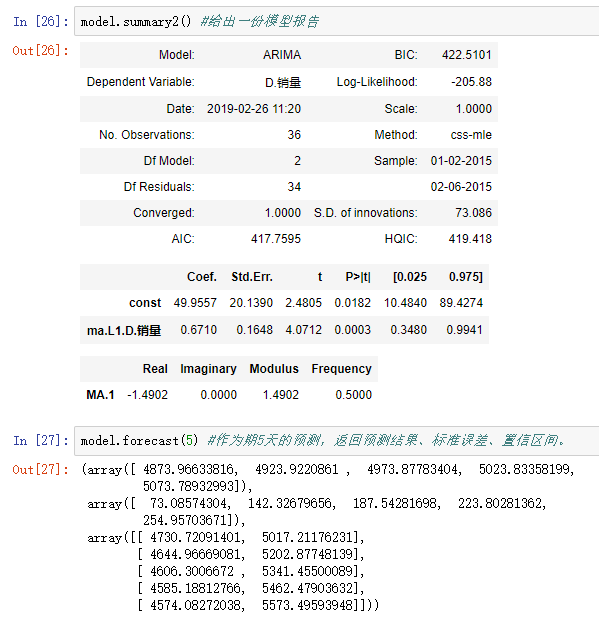

model = ARIMA(data, (p,1,q)).fit() #建立ARIMA(0, 1, 1)模型

model.summary2() #给出一份模型报告

model.forecast(5) #作为期5天的预测,返回预测结果、标准误差、置信区间。

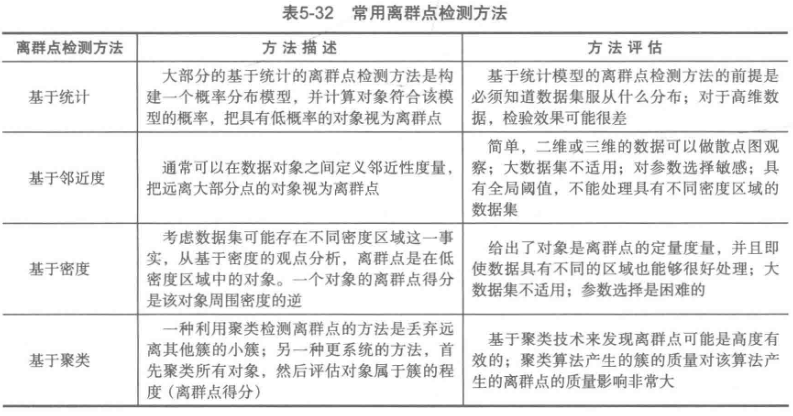

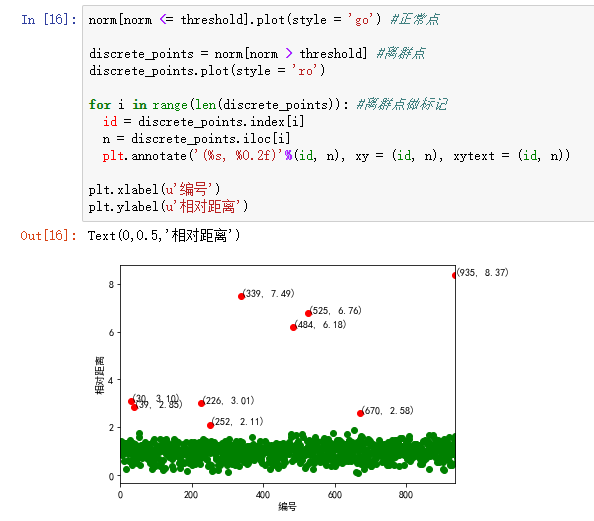

六、离群点检测

#使用K-Means算法聚类消费行为特征数据

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

from sklearn.cluster import KMeans

%matplotlib inline

plt.rcParams['axes.unicode_minus']=False #正常显示负号 #参数初始化

k = 3 #聚类的类别

threshold = 2 #离散点阈值

iteration = 500 #聚类最大循环次数 data = pd.read_excel('data/consumption_data.xls', index_col = 'Id') #读取数据

data_zs = 1.0*(data - data.mean())/data.std() #数据标准化 model = KMeans(n_clusters = k, n_jobs = 4, max_iter = iteration) #分为k类,并发数4

model.fit(data_zs) #开始聚类 #标准化数据及其类别

r = pd.concat([data_zs, pd.Series(model.labels_, index = data.index)], axis = 1) #每个样本对应的类别

r.columns = list(data.columns) + [u'聚类类别'] #重命名表头 norm = []

for i in range(k): #逐一处理

norm_tmp = r[['R', 'F', 'M']][r[u'聚类类别'] == i]-model.cluster_centers_[i]

norm_tmp = norm_tmp.apply(np.linalg.norm, axis = 1) #求出绝对距离

norm.append(norm_tmp/norm_tmp.median()) #求相对距离并添加

norm = pd.concat(norm) #合并 norm[norm <= threshold].plot(style = 'go') #正常点

discrete_points = norm[norm > threshold] #离群点

discrete_points.plot(style = 'ro')

for i in range(len(discrete_points)): #离群点做标记

id = discrete_points.index[i]

n = discrete_points.iloc[i]

plt.annotate('(%s, %0.2f)'%(id, n), xy = (id, n), xytext = (id, n))

plt.xlabel(u'编号')

plt.ylabel(u'相对距离')

plt.show()

七、小结

[Python数据挖掘]第5章、挖掘建模(下)的更多相关文章

- [Python数据挖掘]第5章、挖掘建模(上)

一.分类和回归 回归分析研究的范围大致如下: 1.逻辑回归 #逻辑回归 自动建模 import pandas as pd from sklearn.linear_model import Logist ...

- [Python数据挖掘]第8章、中医证型关联规则挖掘

一.背景和挖掘目标 二.分析方法与过程 1.数据获取 2.数据预处理 1.筛选有效问卷(根据表8-6的标准) 共发放1253份问卷,其中有效问卷数为930 2.属性规约 3.数据变换 ''' 聚类 ...

- [Python数据挖掘]第7章、航空公司客户价值分析

一.背景和挖掘目标 二.分析方法与过程 客户价值识别最常用的是RFM模型(最近消费时间间隔Recency,消费频率Frequency,消费金额Monetary) 1.EDA(探索性数据分析) #对数据 ...

- [Python数据挖掘]第6章、电力窃漏电用户自动识别

一.背景与挖掘目标 相关背景自查 二.分析方法与过程 1.EDA(探索性数据分析) 1.分布分析 2.周期性分析 2.数据预处理 1.数据清洗 过滤非居民用电数据,过滤节假日用电数据(节假日用电量明显 ...

- [Python数据挖掘]第4章、数据预处理

数据预处理主要包括数据清洗.数据集成.数据变换和数据规约,处理过程如图所示. 一.数据清洗 1.缺失值处理:删除.插补.不处理 ## 拉格朗日插值代码(使用缺失值前后各5个未缺失的数据建模) impo ...

- [Python数据挖掘]第2章、Python数据分析简介

<Python数据分析与挖掘实战>的数据和代码,可从“泰迪杯”竞赛网站(http://www.tipdm.org/tj/661.jhtml)下载获得 1.Python数据结构 2.Nump ...

- [Python数据挖掘]第3章、数据探索

1.缺失值处理:删除.插补.不处理 2.离群点分析:简单统计量分析.3σ原则(数据服从正态分布).箱型图(最好用) 离群点(异常值)定义为小于QL-1.5IQR或大于Qu+1.5IQR import ...

- Ubuntu系统下创建python数据挖掘虚拟环境

虚拟环境: 虚拟环境是用于创建独立的python环境,允许我们使用不同的python模块和版本,而不混淆. 让我们了解一下产品研发过程中虚拟环境的必要性,在python项目中,显然经常要使用不 ...

- ROS机器人程序设计(原书第2版)补充资料 (柒) 第七章 3D建模与仿真 urdf Gazebo V-Rep Webots Morse

ROS机器人程序设计(原书第2版)补充资料 (柒) 第七章 3D建模与仿真 urdf Gazebo V-Rep Webots Morse 书中,大部分出现hydro的地方,直接替换为indigo或ja ...

随机推荐

- Mysqlutil.JDBCutil.Dtabaseutil数据库操作工具类[批量操作]

一个用来操作数据库的常用工具类. 提供批量操作,生成建表,插入语句等 操作示例: // 1.获取连接 DataBaseUtil jdbc = new DataBaseUtil(); jdbc.getC ...

- jmeter数据库连接配置

一.实际试过的mysql配置 1.导入一个JDBC jar包(我是直接把jar包放在了jmeter的lib目录),包:mysql-connector-java-5.1.7-bin.jar 2.设置JD ...

- Holt-Winters

https://blog.csdn.net/u010665216/article/details/78051192 mark

- 软件工程第二次作业-VSTS单元测试

一.选择开发工具 开发工具选择 Visual studio 2017 社区版,开发语言为C 由于之前已经安装完毕,所以不上传安装过程,主界面如下: 二.练习自动单元测试 使用的测试工具是VSTS,具体 ...

- windows 启动停止 java进程

本案例以 xxx.jar 为列子 我们一般启动的jar 在任务管理器中查看进程都是javaw.exe ,无法用命令来 kill,所以我们得给自己的java 进程设置个新 title 1: 首先 ...

- 2018-2019-2 网络对抗技术 20165336 Exp3 免杀原理与实践

2018-2019-2 网络对抗技术 20165336 Exp3 免杀原理与实践 1.基础问题回答 (1)杀软是如何检测出恶意代码的? 根据计算机病毒课程知道了每个病毒都有其对应的特征码,杀软是根据这 ...

- 使用STS创建springboot项目pom.xml文件报错org.apache.maven.archiver.MavenArchiver.getManifest

首先我的STS版本时:3.7.3 解决办法:->help->Install New Software -> add->location ->输入: http://repo ...

- 2018(5)软件架构设计,架构风格,REST

2018上半年系统分析师试题五 阅读以下关于Web应用设计开发的描述,在答题纸上回答问题1至问题3. [说明] 某公司拟开发一个自由,可定制性强.用户界面友好的在线调查系统,以获取员工在课程学习.对公 ...

- python continue的应用

count = 1sum = 0while count < 100: if count == 88: count += 1 continue if count % 2 == 0: sum = s ...

- btcpool之StratumServer

一.简介 StratumServer(简称sserver)接收JobMaker发送的stratumjob消息,从http api获取用户列表,对外部矿机提供服务. 二.处理stratumjob消息 s ...