Python pycharm(windows版本)部署spark环境

一 部署本地spark环境

解压下载的文件,假设解压 目录为:D:\Spark-1.6.0-bin-hadoop2.6。将D:\spark-1.6.0-bin-hadoop2.6\bin添加到系统Path变量,同时新建SPARK_HOME变量,变量值为:D:\spark-1.6.0-bin-hadoop2.6

1.3 Hadoop相关包的安装

spark是基于hadoop之上的,运行过程中会调用相关hadoop库,如果没配置相关hadoop运行环境,会提示相关出错信息,虽然也不影响运行。

去下载hadoop 2.6编译好的包https://www.barik.net/archive/2015/01/19/172716/,我下载的是hadoop-2.6.0.tar.gz,解压下载的文件夹,将相关库添加到系统Path变量中:D:\hadoop-2.6.0\bin;同时新建HADOOP_HOME变量,变量值为:D:\hadoop-2.6.0。同时去github上下载一个叫做 winutils 的组件,地址是 https://github.com/srccodes/hadoop-common-2.2.0-bin 如果没有hadoop对应的版本(此时版本是 2.6),则去csdn上下载 http://download.csdn.net/detail/luoyepiaoxin/8860033,

我的做法是把CSDN这个压缩包里的所有文件都复制到 hadoop_home的bin目录下

二 Python环境

Spark提供了2个交互式shell, 一个是pyspark(基于python), 一个是spark_shell(基于Scala). 这两个环境其实是并列的, 并没有相互依赖关系, 所以如果仅仅是使用pyspark交互环境, 而不使用spark-shell的话, 甚至连scala都不需要安装.

2.1 下载并安装Anaconda

anaconda是一个集成了python解释器和大多数python库的系统,安装anaconda 后可以不用再安装python和pandas numpy等这些组件了。下载地址是 https://www.continuum.io/downloads。将python加到path环境变量中

三 启动pyspark验证

在windows下命令行中启动pyspark,如图:

四 在pycharm中配置开发环境

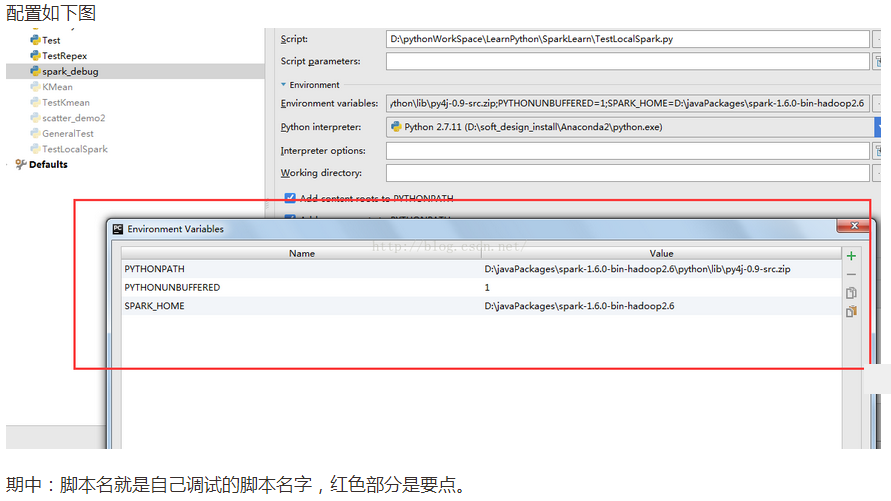

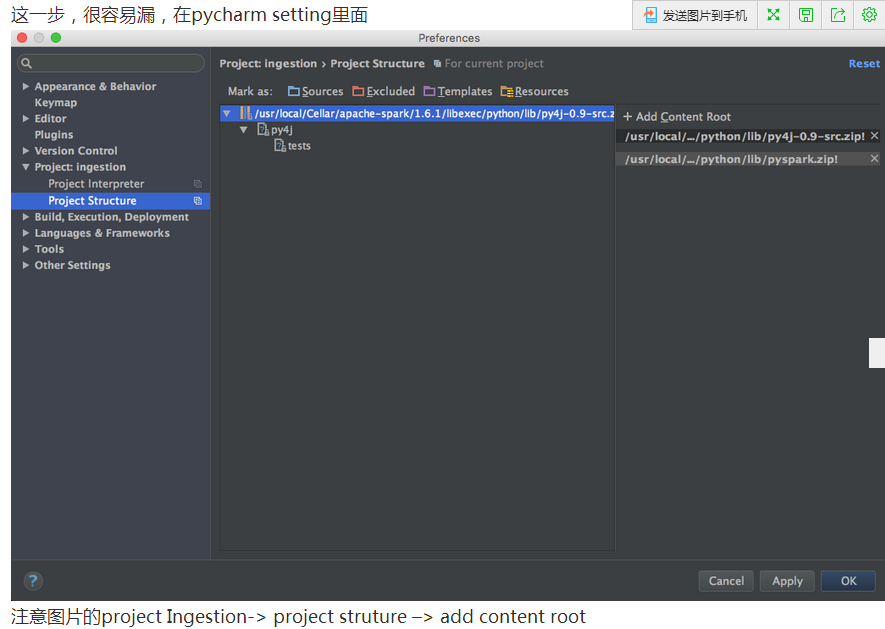

4.1 配置Pycharm

打开PyCharm,创建一个Project。然后选择“Run” ->“Edit Configurations”

SPARK_HOME:Spark安装目录

PYTHONPATH:Spark安装目录下的Python目录

4.2 测试程序

先测试环境是否正确,代码如下:

import os

import sys # Path for spark source folder

os.environ['SPARK_HOME']="D:\javaPackages\spark-1.6.0-bin-hadoop2.6" # Append pyspark to Python Path

sys.path.append("D:\javaPackages\spark-1.6.0-bin-hadoop2.6\python") try:

from pyspark import SparkContext

from pyspark import SparkConf print ("Successfully imported Spark Modules") except ImportError as e:

print ("Can not import Spark Modules", e)

sys.exit(1)

测试程序代码来源于 github :https://gist.github.com/bigaidream/40fe0f8267a80e7c9cf8

转原博客地址:http://blog.csdn.net/huangxia73/article/details/51372557

注意:

可能会报没有 py4j ( 它是python用来连接java的中间件)

可以用命令安装:pip install py4j

Python pycharm(windows版本)部署spark环境的更多相关文章

- 使用Vagrant在Windows下部署开发环境

做Web开发少不了要在本地搭建好开发环境,虽然说目前各种脚本都有对应的Windows版,甚至是一键安装包,但很多时候和Windows环境的相性并不是那么好,各麻烦的问题是实际部署的环境通常是Linux ...

- Windows下安装Spark环境

根据博客总结 https://blog.csdn.net/nxw_tsp/article/details/78281533 需要的安装软件可以在网盘下载: 链接:https://pan.baidu.c ...

- python+pycharm+selenium+谷歌浏览器驱动 自动化环境部署(一)

准备工作: 第一步:安装python.打开网址https://www.python.org/downloads/windows/ 现在最新版本3.7,本人使用的是3.6. 第二步:安装pych ...

- Python & PyCharm & Django 搭建web开发环境

一.安装软件 1.安装 Python 2.7.PyCharm.pip(Python包管理工具).Django ( pip install Django) 二.部署 1.PyCharm 新建Django ...

- windows 10 安装 spark 环境(spark 2.2.1 + hadoop2.7)

安装步骤基本参考 Spark在Windows下的环境搭建.不过在安装新版本 spark2.2.1(基于 hadoop2.7)的配置时,略略有一些不同. 1. sqlContext => spar ...

- Python & PyCharm & Django 搭建web开发环境(续)

由于Django自带轻量级的server,因此在前篇博文中,默认使用该server,但实际生产中是不允许这么干的,生产环境中通常使用Apache Httpd Server结合mod_wsgi.so来做 ...

- Scala,Java,Python 3种语言编写Spark WordCount示例

首先,我先定义一个文件,hello.txt,里面的内容如下: hello sparkhello hadoophello flinkhello storm Scala方式 scala版本是2.11.8. ...

- windows下搭建spark+python 开发环境

有时候我们会在windows 下开发spark程序,测试程序运行情况,再部署到真实服务器中运行. 那么本文介绍如何在windows 环境中搭建简单的基于hadoop 的spark 环境. 我的wind ...

- [转]windows环境下使用virtualenv对python进行多版本隔离

windows环境下使用virtualenv对python进行多版本隔离 最近在用python做一个文本的情感分析的项目,用到tensorflow,需要用python3的版本,之前因为<机器学习 ...

随机推荐

- 视图Ext.Viewport和窗口Ext.Window用法

Viewport不需要再指定renderTo,而我们也看到Viewport确实填充了整个浏览器显示区域,并会随着浏览器显示区域大小的改变而改改.他有三个特点: 1).创建即可使用.不需要渲染,当组件在 ...

- svn(subversion)版本控制系统学习与理解

定义:Apache Subversion(简称SVN,svn),一个开放源代码的版本控制系统,相较于RCS.CVS,它采用了分支管理系统,它的设计目标就是取代CVS. 从这段话,我们可以得到四点信息: ...

- windowsxp下的mysql集群技术

1.准备工作 a.系统环境为:Windows Xp系统 b.mysql版本为:MySQL Server 5.5 c.mysql cluster版本为:mysql-cluster-gpl-noinsta ...

- js读取json方法

json也是对象,可以直接使用对象调用 var json = {contry:{area:{man:"12万",women:"10万"}}}; json.con ...

- 学习笔记:AC自动机

话说AC自动机有什么用......我想要自动AC机 AC自动机简介: 首先简要介绍一下AC自动机:Aho-Corasick automation,该算法在1975年产生于贝尔实验室,是著名的多模匹配 ...

- 【BZOJ】【1968】【AHOI2005】COMMON 约数研究

数论 原谅我这么傻逼的题都不会做…… 或许写成数学公式的形式比较容易想到解法? $$ans=\sum_{i=1}^n \sum_{d|i} 1$$ ……是不是感觉很水呀……是吧……改成先枚举d再枚举 ...

- google protocol buffer的原理和使用(二)

本文主要会介绍怎么使用Google Protocol的Lib来序列化我们的数据,方法非常多种,本文仅仅介绍当中的三种.其它的方法读者能够通过自行研究摸索.但总的来说,序列化数据总的来说分为下面俩步: ...

- SQL Server AlwaysOn Setup Step-By-Step Guide

Step-By-Step: Creating a SQL Server 2012 AlwaysOn Availability Group http://blogs.technet.com/b/cani ...

- request和request.form和request.querystring的区别

asp中获取传递的参数,一般用request或者用request成员函数request.form,两种方式都可以获取页面表单传递过来的参数值,一直没留意两种方法有什么区别,我一般喜欢用request( ...

- Partition List leetcode java

题目: Given a linked list and a value x, partition it such that all nodes less than x come before node ...