聊聊order by的工作机制

总结写在前面:

1. 介绍了orderBy的两种算法流程:全字段排序 和 rowid排序。

2. rowid排序 相比 全字段排序,参与排序字段较少,耗内存较少,多一步回表,如果内存够的情况下MySQL会考虑优先使用全字段排序

3.MySQL做排序是较高成本的操作,可以在排序字段上加索引,减少消耗;更进一步的还可以用覆盖索引。

假设有一张表

CREATE TABLE `t` (

`id` int(11) NOT NULL,

`city` varchar(16) NOT NULL,

`name` varchar(16) NOT NULL,

`age` int(11) NOT NULL,

`addr` varchar(128) DEFAULT NULL,

PRIMARY KEY (`id`),

KEY `city` (`city`)

) ENGINE=InnoDB;

假设要查询“杭州”的所有人名字,并且按照姓名排序返回前 1000 个人的姓名、年龄。

select city,name,age from t where city='杭州' order by name limit 1000 ;

全字段排序

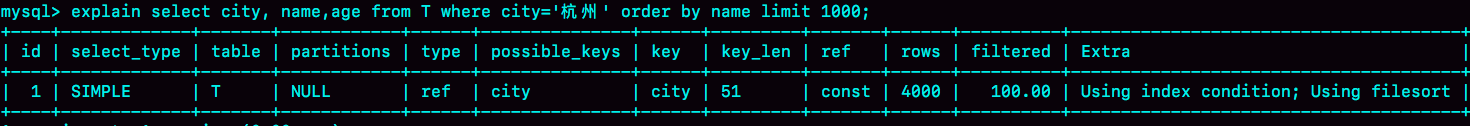

为避免全表扫描,在 city 字段加上索引。然后用 explain 命令看看这个语句的执行情况

Extra 字段中的“Using filesort”表示的就是需要排序,MySQL 会给每个线程分配一块用于排序的内存,称为 sort_buffer。

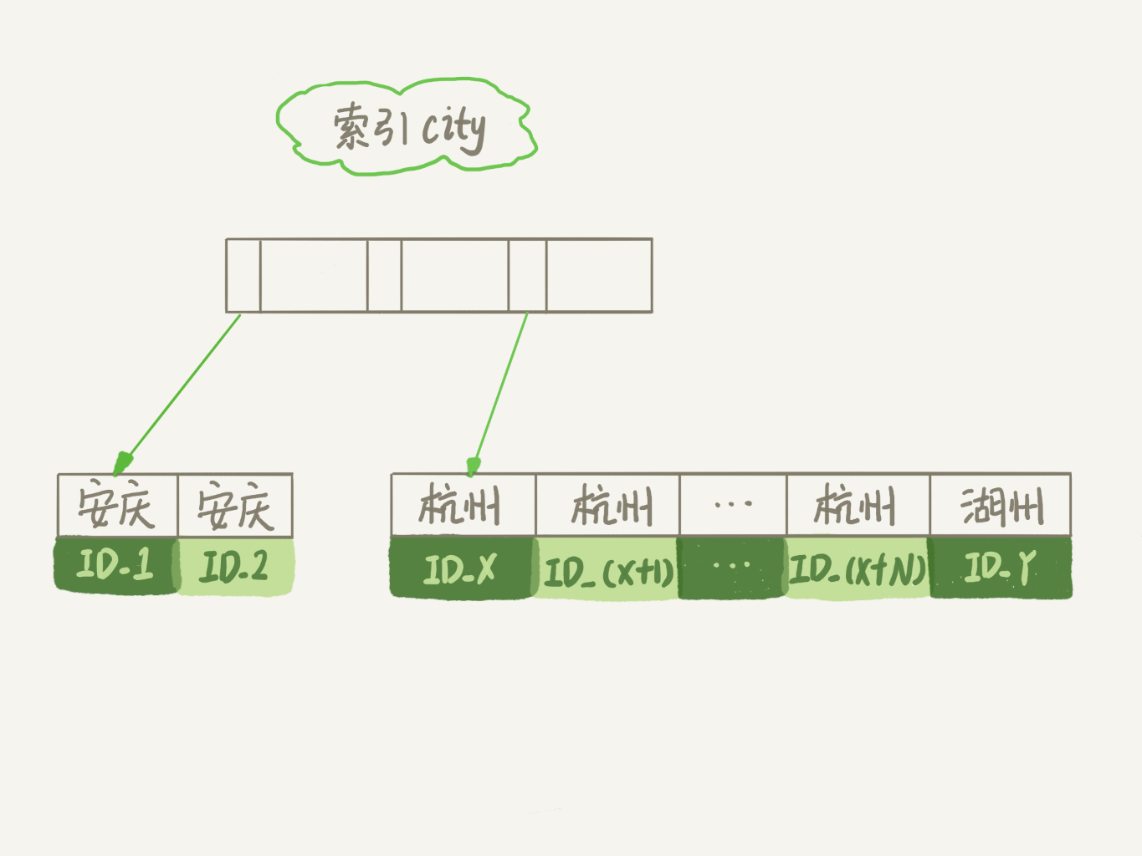

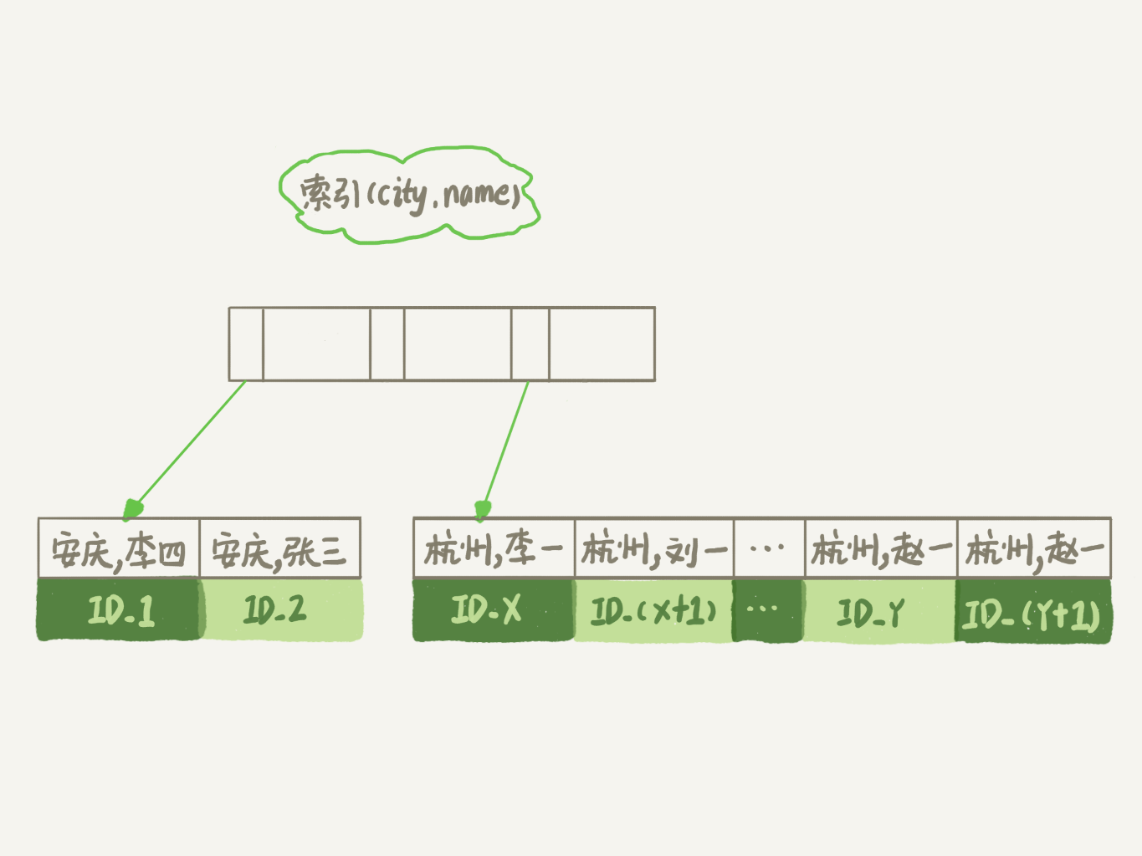

city索引的示意图如下:

可以看到,满足 city='杭州’条件的行,是从 ID_X 到 ID_(X+N) 的这些记录。

通常情况下,这个语句执行流程如下所示 :

1. 初始化 sort_buffer,确定放入 name、city、age 这三个字段;

2. 从索引 city 找到第一个满足 city='杭州’条件的主键 id,也就是图中的 ID_X;

3. 到主键 id 索引取出整行,取 name、city、age 三个字段的值,存入 sort_buffer 中;

4. 从索引 city 取下一个记录的主键 id;

5. 重复步骤 3、4 直到 city 的值不满足查询条件为止,对应的主键 id 也就是图中的 ID_Y;

6. 对 sort_buffer 中的数据按照字段 name 做快速排序;

7. 按照排序结果取前 1000 行返回给客户端。

第6步中的“按 name 排序”这个动作,可能在内存中完成,也可能需要使用外部排序,这取决于排序所需的内存和参数 sort_buffer_size。

sort_buffer_size,就是 MySQL 为排序开辟的内存(sort_buffer)的大小。如果要排序的数据量小于 sort_buffer_size,排序就在内存中完成。但如果排序数据量太大,内存放不下,则不得不利用磁盘临时文件辅助排序。

下面介绍一个方法,可以确定一个排序语句是否使用了临时文件。

/* 打开optimizer_trace,只对本线程有效 */

SET optimizer_trace='enabled=on'; /* @a保存Innodb_rows_read的初始值 */

select VARIABLE_VALUE into @a from performance_schema.session_status where variable_name = 'Innodb_rows_read'; /* 执行语句 */

select city, name,age from t where city='杭州' order by name limit 1000; /* 查看 OPTIMIZER_TRACE 输出 */

SELECT * FROM `information_schema`.`OPTIMIZER_TRACE`\G /* @b保存Innodb_rows_read的当前值 */

select VARIABLE_VALUE into @b from performance_schema.session_status where variable_name = 'Innodb_rows_read'; /* 计算Innodb_rows_read差值 */

select @b-@a;

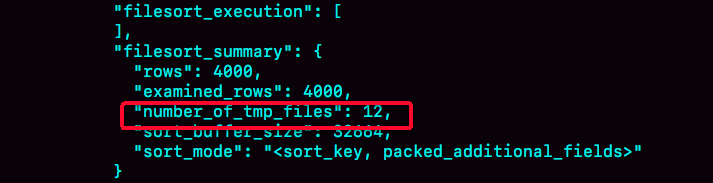

这个方法是通过查看 OPTIMIZER_TRACE 的结果来确认的,可以从 number_of_tmp_files 中看到是否使用了临时文件。

图 1 全排序的 OPTIMIZER_TRACE 部分结果

number_of_tmp_files 表示的是,排序过程中使用的临时文件数。

内存放不下时,就需要使用外部排序,外部排序一般使用归并排序算法。

可以这么简单理解,MySQL 将需要排序的数据分成 12 份,每一份单独排序后存在这些临时文件中。然后把这 12 个有序文件再合并成一个有序的大文件。

如果 sort_buffer_size 超过了需要排序的数据量的大小,number_of_tmp_files 就是 0,表示排序可以直接在内存中完成。

否则就需要放在临时文件中排序。sort_buffer_size 越小,需要分成的份数越多,number_of_tmp_files 的值就越大。

下面解释一下图 1 中其他两个值的意思。

示例表中有 4000 条满足 city='杭州’的记录,所以examined_rows=4000,表示参与排序的行数是 4000 行。

sort_mode 里面的 packed_additional_fields 的意思是,排序过程对字符串做了“紧凑”处理。即使 name 字段的定义是 varchar(16),在排序过程中还是要按照实际长度来分配空间的。

最后一个查询语句 select @b-@a 的返回结果是 4000,表示整个执行过程只扫描了 4000 行。

这里需要注意的是,为了避免对结论造成干扰,我把 internal_tmp_disk_storage_engine 设置成 MyISAM。否则,select @b-@a 的结果会显示为 4001。

这是因为查询 OPTIMIZER_TRACE 这个表时,需要用到临时表,而 internal_tmp_disk_storage_engine 的默认值是 InnoDB。如果使用的是 InnoDB 引擎的话,把数据从临时表取出来的时候,会让 Innodb_rows_read 的值加 1。

rowid 排序

上面这个算法过程里面,只对原表的数据读了一遍,剩下的操作都是在 sort_buffer 和临时文件中执行的。

显然,如果查询要返回的字段很多的话, sort_buffer 里面要放的字段数太多,就会导致内存放不下,要分成很多个临时文件,排序的性能会很差。

即如果单行记录很大,全字段排序效率不好。

接下来,我们修改一个参数,让 MySQL 采用另外一种算法。

SET max_length_for_sort_data = 16;

max_length_for_sort_data是 MySQL 中专门控制用于排序的行数据的长度的一个参数。它的意思是,如果单行的长度超过这个值,MySQL 就认为单行太大,要换一个算法。

city、name、age 这三个字段的定义总长度是 36,大于16。

新的算法放入 sort_buffer 的字段,只有要排序的列(即 name 字段)和主键 id。

此时,排序的结果因为少了 city 和 age 字段的值,不能直接返回了,整个执行流程就变成:

1. 初始化 sort_buffer,确定放入两个字段,即 name 和 id;

2. 从索引 city 找到第一个满足 city='杭州’条件的主键 id,也就是图中的 ID_X;

3. 到主键 id 索引取出整行,取 name、id 这两个字段,存入 sort_buffer 中;

4. 从索引 city 取下一个记录的主键 id;

5. 重复步骤 3、4 直到不满足 city='杭州’条件为止,也就是图中的 ID_Y;

6. 对 sort_buffer 中的数据按照字段 name 进行排序;

7. 遍历排序结果,取前 1000 行;

8. 按照 id 的值回表取出 city、name 和 age 三个字段返回给客户端。

显然,rowid排序相比全字段排序多了一次访问表的主键索引,即第8步。

这里需要注意,实际上 MySQL 服务端从排序后的 sort_buffer 中依次取出 id,然后到原表查到 city、name 和 age 这三个字段的结果,不需要在服务端再耗费内存存储结果,是直接返回给客户端的。

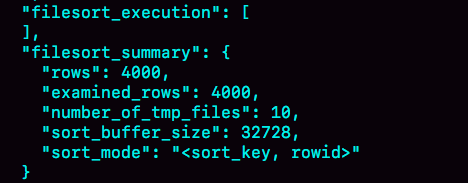

再用OPTIMIZER_TRACE看看有什么不同:

- examined_rows 的值还是 4000,表示用于排序的数据是 4000 行。

- 但是 select @b-@a 这个语句的值变成 5000 了。因为除了排序过程外,还要根据 id 去原表取值。由于语句是 limit 1000,因此会多读 1000 行。

- sort_mode 变成了 <sort_key, rowid="">,表示参与排序的只有 name 和 id 这两个字段。

- number_of_tmp_files 变成 10 了,是因为这时候参与排序的行数虽然仍然是 4000 行,但是每一行都变小了,因此需要排序的总数据量就变小了,需要的临时文件也相应地变少了。

全字段排序 VS rowid 排序

从上面两种算法简单分析:

如果 MySQL 实在是担心排序内存太小,会影响排序效率,才会采用 rowid 排序算法,这样排序过程中一次可以排序更多行,但是需要再回到原表去取数据。

如果 MySQL 认为内存足够大,会优先选择全字段排序,把需要的字段都放到 sort_buffer 中,这样排序后就会直接从内存里面返回查询结果了,不用再回到原表去取数据。

这也就体现了 MySQL 的一个设计思想:如果内存够,就要多利用内存,尽量减少磁盘访问。

对于 InnoDB 表来说,rowid 排序会要求回表多造成磁盘读,因此不会被优先选择。

到这里我们发现,MySQL 做排序是一个成本比较高的操作。那么你会问,是不是所有的 order by 都需要排序操作呢?

显然,如果不排序就能得到正确的结果,那对系统的消耗会小很多,语句的执行时间也会变得更短。

谈到有序数据很自然就能想到索引,假设在表上创建一个 city 和 name 的联合索引,作为与city索引的对比:

在这个索引里面,我们依然可以用树搜索的方式定位到第一个满足 city='杭州’的记录,并且额外确保了,接下来按顺序取“下一条记录”的遍历过程中,只要 city 的值是杭州,name 的值就一定是有序的。

整个查询过程的流程就变成了:

1. 从索引 (city,name) 找到第一个满足 city='杭州’条件的主键 id;

2. 到主键 id 索引取出整行,取 name、city、age 三个字段的值,作为结果集的一部分直接返回;

3. 从索引 (city,name) 取下一个记录主键 id;

4. 重复步骤 2、3,直到查到第 1000 条记录,或者是不满足 city='杭州’条件时循环结束。

可以看到,这个查询过程不需要临时表,也不需要排序。

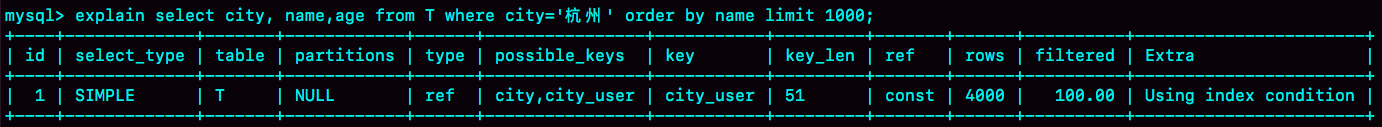

接下来,我们用 explain 的结果来印证一下。

Extra 字段中没有 Using filesort 了,也就是不需要排序了。

而且由于 (city,name) 这个联合索引本身有序,所以这个查询也不用把 4000 行全都读一遍,只要找到满足条件的前 1000 条记录就可以退出了。也就是说,只需要扫描 1000 次。

讲到了索引,我们可以再思考下有没办法再进一步优化这个查询呢?有的,覆盖索引。

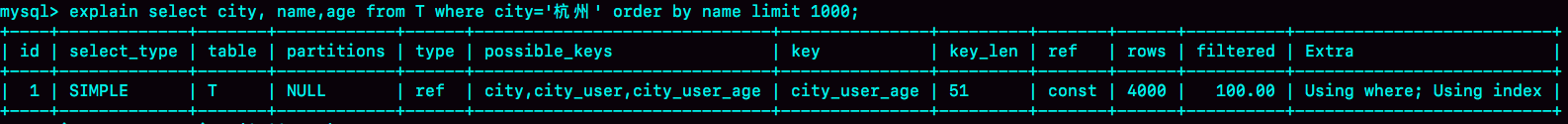

针对这个查询,我们可以创建一个 city、name 和 age 的联合索引。

这时,对于 city 字段的值相同的行来说,还是按照 name 字段的值递增排序的,此时的查询语句也就不再需要排序了。这样整个查询语句的执行流程就变成了:

1. 从索引 (city,name,age) 找到第一个满足 city='杭州’条件的记录,取出其中的 city、name 和 age 这三个字段的值,作为结果集的一部分直接返回;

2. 从索引 (city,name,age) 取下一个记录,同样取出这三个字段的值,作为结果集的一部分直接返回;

3. 重复执行步骤 2,直到查到第 1000 条记录,或者是不满足 city='杭州’条件时循环结束。

再来看看 explain 的结果。

可以看到,Extra 字段里面多了“Using index”,表示的就是使用了覆盖索引,性能上会快很多。

注意:通常不能每个查询都为了用上覆盖索引,就要把语句中涉及的字段都建上联合索引,毕竟索引还是有维护代价的。这是一个需要权衡的决定。

聊聊order by的工作机制的更多相关文章

- 大数据学习笔记——Spark工作机制以及API详解

Spark工作机制以及API详解 本篇文章将会承接上篇关于如何部署Spark分布式集群的博客,会先对RDD编程中常见的API进行一个整理,接着再结合源代码以及注释详细地解读spark的作业提交流程,调 ...

- 聊聊order by rand()

总结写在前面: 1. 不建议直接使用order by rand(),原因是执行代价比较大 2. 介绍了内存临时表,对于内存临时表,由于回表不需要访问磁盘,所以往往是用rowid排序,可以减少参与排序字 ...

- android 6.0 高通平台sensor 工作机制及流程(原创)

最近工作上有碰到sensor的相关问题,正好分析下其流程作个笔记. 这个笔记分三个部分: sensor硬件和驱动的工作机制 sensor 上层app如何使用 从驱动到上层app这中间的流程是如何 Se ...

- Java IO工作机制分析

Java的IO类都在java.io包下,这些类大致可分为以下4种: 基于字节操作的 I/O 接口:InputStream 和 OutputStream 基于字符操作的 I/O 接口:Writer 和 ...

- malloc 函数工作机制(转)

malloc()工作机制 malloc函数的实质体现在,它有一个将可用的内存块连接为一个长长的列表的所谓空闲链表.调用malloc函数时,它沿连接表寻找一个大到足以满足用户请求所需要的内存块.然后,将 ...

- springMVC工作机制和框架搭建配置说明

先说一下springMVC的工作机制 1.springmvc把 所有的请求都提交给DispatcherServlet,它会委托应用系统的其他模块负责对请求进行真正的处理工作. 2.Dispatcher ...

- CKPT进程工作机制

CKPT进程工作示意图 2.CKPT进程工作机制 检查点进程被触发的条件为: a> 当发生日志组切换时: b> 用户提交了事务时(commit): c> Redo log buf ...

- 15 sql base line 工作机制

<个人Configuration> 正常配置一下, 就OK了, 不用理了, oracle 11g 默认启动 发展: .从Oracle的发展角度来看,估计这种方法是Oracle发展和改进的方 ...

- HBase读写路径的工作机制

出处:http://wuyudong.com/1946.html HBase 写路径工作机制 在HBase 中无论是增加新行还是修改已有的行,其内部流程都是相同的.HBase 接到命令后存下变化信息, ...

随机推荐

- win10安装CAD失败,怎么强力卸载删除注册表并重新安装

一些搞设计的朋友在win10系统下安装CAD失败或提示已安装,也有时候想重新安装CAD的时候会出现本电脑windows系统已安装CAD,你要是不留意直接安装CAD,只会安装CAD的附件或者直接提示失败 ...

- 二、Android XML数据解析

XML,可扩展标记语言.可以用来存储数据,可以看做是一个小型的数据库,SharedPreference就是使用XML文件存储数据的,SQLite底层也是一个XML文件,而在网络应用方面,通常作为信息的 ...

- 吴裕雄--天生自然 R语言开发学习:方差分析

#-------------------------------------------------------------------# # R in Action (2nd ed): Chapte ...

- stat()函数--------------获取文件信息

stat():用于获取文件的状态信息,使用时需要包含<sys/stat.h>头文件. 函数原型:int stat(const char *path, struct stat *buf): ...

- flask 参数校验

校验参数是否存在,不存在返回400 @app.route('/check',methods=['POST']) def check(): values = request.get_json() req ...

- JavaScript 执行环境以及作用域链

执行环境(execution context,为简单起见,有时也称为"环境")是 JavaScript 中最为重要的一个概念.执行环境定义了变量或函数有权访问的其他数据,决定了它们 ...

- Scrum 敏捷实践中的三大角色

在我过去的近两年工作中,我们一直在应用 Scrum 敏捷项目管理方法来开展工作,今天,我先从它的角色划分来讲起,毕竟这可是它最鲜明的特征. 首先,为什么这种项目管理方法叫 Scrum ? Scrum ...

- Metaploit-永恒之蓝漏洞利用

目录 Metaploit介绍 实验环境 漏洞利用过程 Metaploit介绍 本次测试主要是利用永恒之蓝漏洞对windows7进行控制利用,掌握Metaploit工具的使用,知道永恒之蓝的漏洞利用原理 ...

- 说一说 HTML 中的 script 标签

我们在 <Javascript简史>这遍文章中说过,「Javascript」这门语言是由 Netscape开发而来,当初开发的时候为了能让 「Javascript」这门语言能与 HTML ...

- Python爬虫抓取微博评论

第一步:引入库 import time import base64 import rsa import binascii import requests import re from PIL impo ...