如何查看HBase的HFile

记一个比较初级的笔记。

===流程===

1. 创建一张表

2. 插入10条数据

3. 查看HFile

===操作===

1.创建表

package api; import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.hbase.HBaseConfiguration;

import org.apache.hadoop.hbase.HColumnDescriptor;

import org.apache.hadoop.hbase.HTableDescriptor;

import org.apache.hadoop.hbase.TableName;

import org.apache.hadoop.hbase.client.Admin;

import org.apache.hadoop.hbase.client.Connection;

import org.apache.hadoop.hbase.client.ConnectionFactory;

import org.apache.hadoop.hbase.client.Durability;

import org.apache.hadoop.hbase.io.compress.Compression;

import org.apache.hadoop.hbase.regionserver.BloomType; public class create_table_sample1 {

public static void main(String[] args) throws Exception {

Configuration conf = HBaseConfiguration.create();

conf.set("hbase.zookeeper.quorum", "192.168.1.80,192.168.1.81,192.168.1.82");

Connection connection = ConnectionFactory.createConnection(conf);

Admin admin = connection.getAdmin(); HTableDescriptor desc = new HTableDescriptor(TableName.valueOf("TEST1"));

desc.setMemStoreFlushSize(2097152L); //2M(默认128M)

desc.setMaxFileSize(10485760L); //10M(默认10G)

desc.setDurability(Durability.SYNC_WAL); //WAL落盘方式:同步刷盘 HColumnDescriptor family1 = new HColumnDescriptor(constants.COLUMN_FAMILY_DF.getBytes());

family1.setTimeToLive(2 * 60 * 60 * 24); //过期时间

family1.setMaxVersions(2); //版本数

family1.setBlockCacheEnabled(false);

desc.addFamily(family1);

HColumnDescriptor family2 = new HColumnDescriptor(constants.COLUMN_FAMILY_EX.getBytes());

family2.setTimeToLive(3 * 60 * 60 * 24); //过期时间

family2.setMinVersions(2); //最小版本数

family2.setMaxVersions(3); //版本数

family2.setBloomFilterType(BloomType.ROW); //布隆过滤方式

family2.setBlocksize(1024);

family2.setBlockCacheEnabled(false);

desc.addFamily(family2); admin.createTable(desc);

admin.close();

connection.close();

}

}

2.插入10条数据

package api; import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.hbase.HBaseConfiguration;

import org.apache.hadoop.hbase.TableName;

import org.apache.hadoop.hbase.client.*; import java.util.ArrayList;

import java.util.List;

import java.util.UUID; public class table_put_sample4 {

public static void main(String[] args) throws Exception {

Configuration conf = HBaseConfiguration.create();

conf.set("hbase.zookeeper.quorum", "192.168.1.80,192.168.1.81,192.168.1.82");

conf.set("hbase.client.write.buffer", "1048576");//1M

Connection connection = ConnectionFactory.createConnection(conf);

BufferedMutator table = connection.getBufferedMutator(TableName.valueOf(constants.TABLE_NAME)); List<Put> puts = new ArrayList<>();

for(int i = 0; i < 10; i++) {

Put put = new Put(("row" + UUID.randomUUID().toString()).getBytes());

put.addColumn(constants.COLUMN_FAMILY_DF.getBytes(), "name".getBytes(), random.getName());

put.addColumn(constants.COLUMN_FAMILY_DF.getBytes(), "sex".getBytes(), random.getSex());

put.addColumn(constants.COLUMN_FAMILY_EX.getBytes(), "height".getBytes(), random.getHeight());

put.addColumn(constants.COLUMN_FAMILY_EX.getBytes(), "weight".getBytes(), random.getWeight());

puts.add(put);

} table.mutate(puts);

table.flush();

table.close();

connection.close();

}

}

3. 查看HFile

命令:hbase hfile -v -p -m -f hdfs://ns/hbase/data/default/TEST1/5cd31c374a3b30bb859175495cbd6905/df/9df89dc0db7f401e943c5ded6d49d956

Scanning -> hdfs://ns/hbase/data/default/TEST1/5cd31c374a3b30bb859175495cbd6905/df/9df89dc0db7f401e943c5ded6d49d956

2017-09-29 03:53:57,233 INFO [main] hfile.CacheConfig: Created cacheConfig: CacheConfig:disabled

K: row0324f6ce-dec9-474a-b3fd-202b0c482756/df:name/1506670800587/Put/vlen=7/seqid=8 V: wang wu

K: row0324f6ce-dec9-474a-b3fd-202b0c482756/df:sex/1506670800587/Put/vlen=3/seqid=8 V: men

K: row284986a4-66c3-4ac6-96f1-76cbf66ec0b0/df:name/1506670800410/Put/vlen=7/seqid=4 V: wei liu

K: row284986a4-66c3-4ac6-96f1-76cbf66ec0b0/df:sex/1506670800410/Put/vlen=3/seqid=4 V: men

K: row5b3796d7-0d95-4114-b8fe-15a194b87172/df:name/1506670800559/Put/vlen=5/seqid=7 V: li si

K: row5b3796d7-0d95-4114-b8fe-15a194b87172/df:sex/1506670800559/Put/vlen=3/seqid=7 V: men

K: row620c7f4b-cb20-4175-b12b-5f71349ca52e/df:name/1506670800699/Put/vlen=7/seqid=12 V: wang wu

K: row620c7f4b-cb20-4175-b12b-5f71349ca52e/df:sex/1506670800699/Put/vlen=5/seqid=12 V: women

K: row91963615-e76f-4911-be04-fcfb1e47cf64/df:name/1506670800733/Put/vlen=7/seqid=13 V: wei liu

K: row91963615-e76f-4911-be04-fcfb1e47cf64/df:sex/1506670800733/Put/vlen=5/seqid=13 V: women

K: row98e7aeea-bd63-45f3-ad28-690256303b6a/df:name/1506670800677/Put/vlen=7/seqid=11 V: wang wu

K: row98e7aeea-bd63-45f3-ad28-690256303b6a/df:sex/1506670800677/Put/vlen=3/seqid=11 V: men

K: rowa0d3ac08-188a-4869-8dcd-43cd874ae34e/df:name/1506670800476/Put/vlen=7/seqid=5 V: wang wu

K: rowa0d3ac08-188a-4869-8dcd-43cd874ae34e/df:sex/1506670800476/Put/vlen=3/seqid=5 V: men

K: rowd0584d40-bf2c-4f07-90c9-394470cc54c7/df:name/1506670800611/Put/vlen=7/seqid=9 V: wei liu

K: rowd0584d40-bf2c-4f07-90c9-394470cc54c7/df:sex/1506670800611/Put/vlen=5/seqid=9 V: women

K: rowd5e46f02-7d22-444a-a086-f0936ca81728/df:name/1506670800652/Put/vlen=7/seqid=10 V: wang wu

K: rowd5e46f02-7d22-444a-a086-f0936ca81728/df:sex/1506670800652/Put/vlen=3/seqid=10 V: men

K: rowf17bfb40-f658-4b4b-a9da-82abf455f4e6/df:name/1506670800531/Put/vlen=5/seqid=6 V: li si

K: rowf17bfb40-f658-4b4b-a9da-82abf455f4e6/df:sex/1506670800531/Put/vlen=3/seqid=6 V: men

Block index size as per heapsize: 432

reader=hdfs://ns/hbase/data/default/TEST1/5cd31c374a3b30bb859175495cbd6905/df/9df89dc0db7f401e943c5ded6d49d956,

compression=none,

cacheConf=CacheConfig:disabled,

firstKey=row0324f6ce-dec9-474a-b3fd-202b0c482756/df:name/1506670800587/Put,

lastKey=rowf17bfb40-f658-4b4b-a9da-82abf455f4e6/df:sex/1506670800531/Put,

avgKeyLen=56,

avgValueLen=5,

entries=20,

length=6440

Trailer:

fileinfoOffset=1646,

loadOnOpenDataOffset=1502,

dataIndexCount=1,

metaIndexCount=0,

totalUncomressedBytes=6313,

entryCount=20,

compressionCodec=NONE,

uncompressedDataIndexSize=70,

numDataIndexLevels=1,

firstDataBlockOffset=0,

lastDataBlockOffset=0,

comparatorClassName=org.apache.hadoop.hbase.KeyValue$KeyComparator,

encryptionKey=NONE,

majorVersion=3,

minorVersion=0

Fileinfo:

BLOOM_FILTER_TYPE = ROW

DELETE_FAMILY_COUNT = \x00\x00\x00\x00\x00\x00\x00\x00

EARLIEST_PUT_TS = \x00\x00\x01^\xCC\x93\xEE\x1A

KEY_VALUE_VERSION = \x00\x00\x00\x01

LAST_BLOOM_KEY = rowf17bfb40-f658-4b4b-a9da-82abf455f4e6

MAJOR_COMPACTION_KEY = \x00

MAX_MEMSTORE_TS_KEY = \x00\x00\x00\x00\x00\x00\x00\x0D

MAX_SEQ_ID_KEY = 15

TIMERANGE = 1506670800410....1506670800733

hfile.AVG_KEY_LEN = 56

hfile.AVG_VALUE_LEN = 5

hfile.CREATE_TIME_TS = \x00\x00\x01^\xCC\x9B\xAD\xCF

hfile.LASTKEY = \x00'rowf17bfb40-f658-4b4b-a9da-82abf455f4e6\x02dfsex\x00\x00\x01^\xCC\x93\xEE\x93\x04

Mid-key: \x00'row0324f6ce-dec9-474a-b3fd-202b0c482756\x02dfname\x00\x00\x01^\xCC\x93\xEE\xCB\x04

Bloom filter:

BloomSize: 16

No of Keys in bloom: 10

Max Keys for bloom: 13

Percentage filled: 77%

Number of chunks: 1

Comparator: RawBytesComparator

Delete Family Bloom filter:

Not present

Scanned kv count -> 20

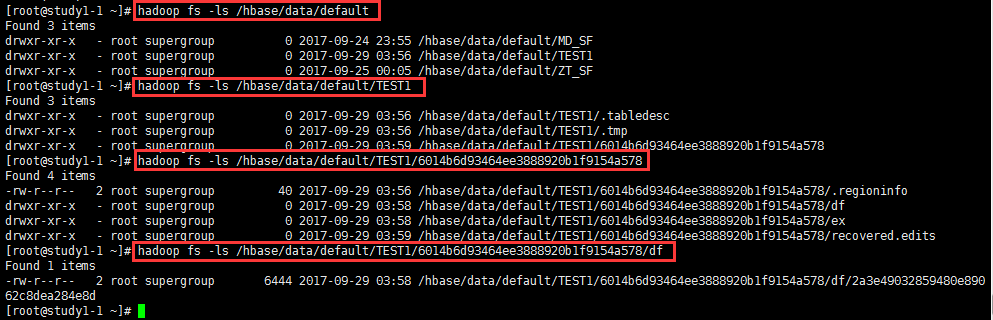

===Tips===:

1. HFile放在哪里了?

查看方式一:

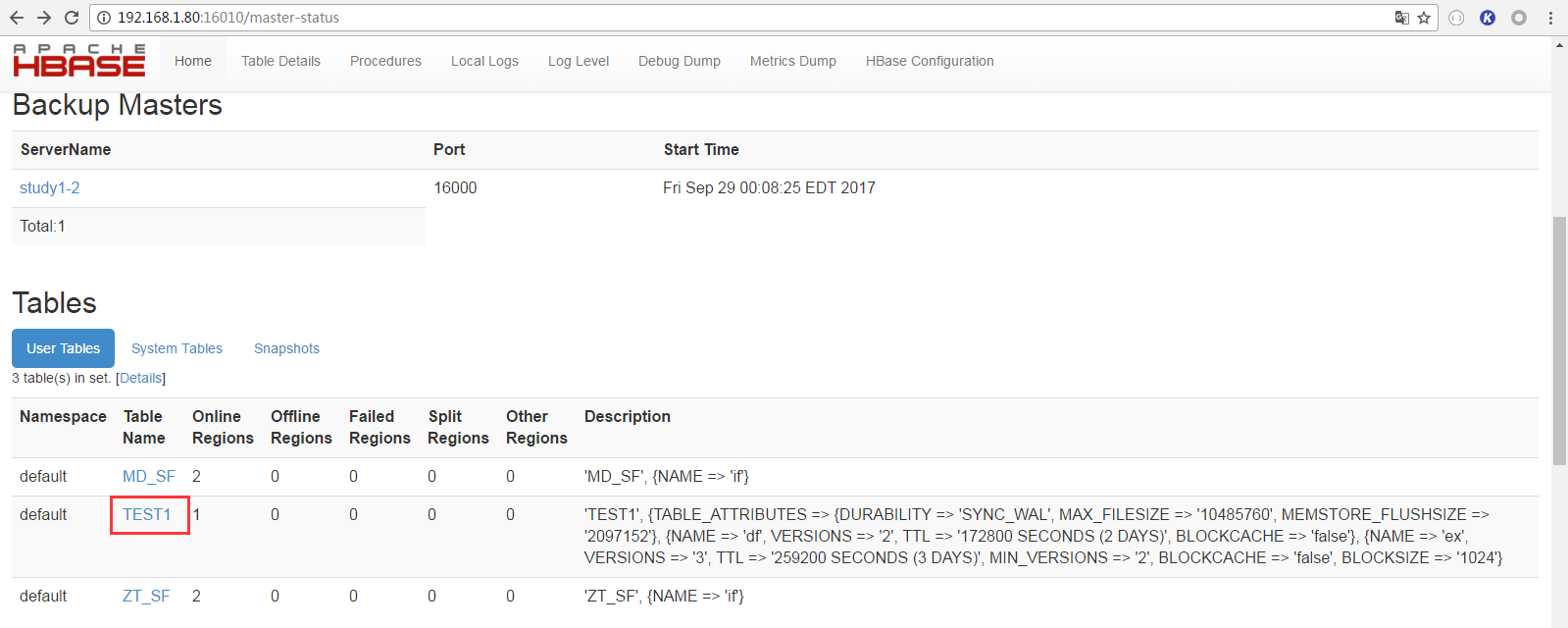

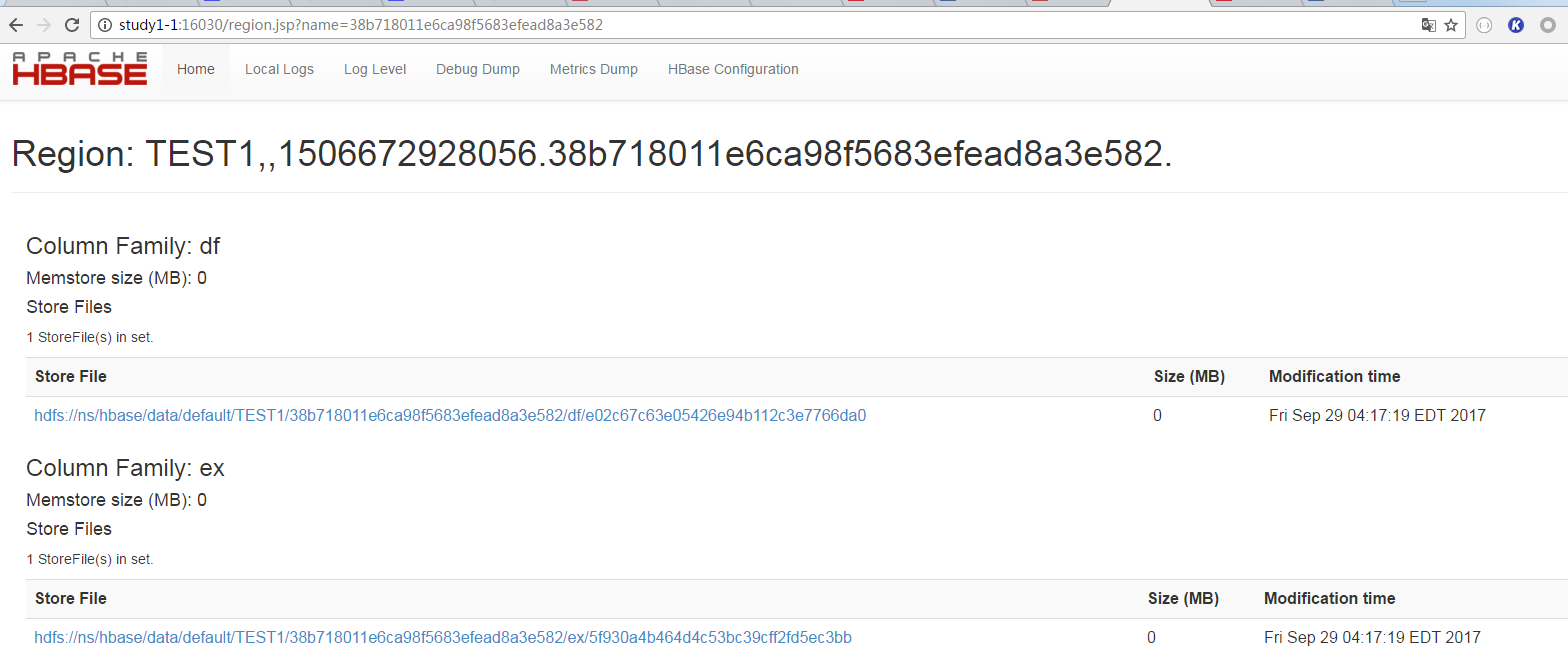

可以通过HBase的web页面查看HFile名称及路径。步骤如下:

① 打开Web管理页面,选择表

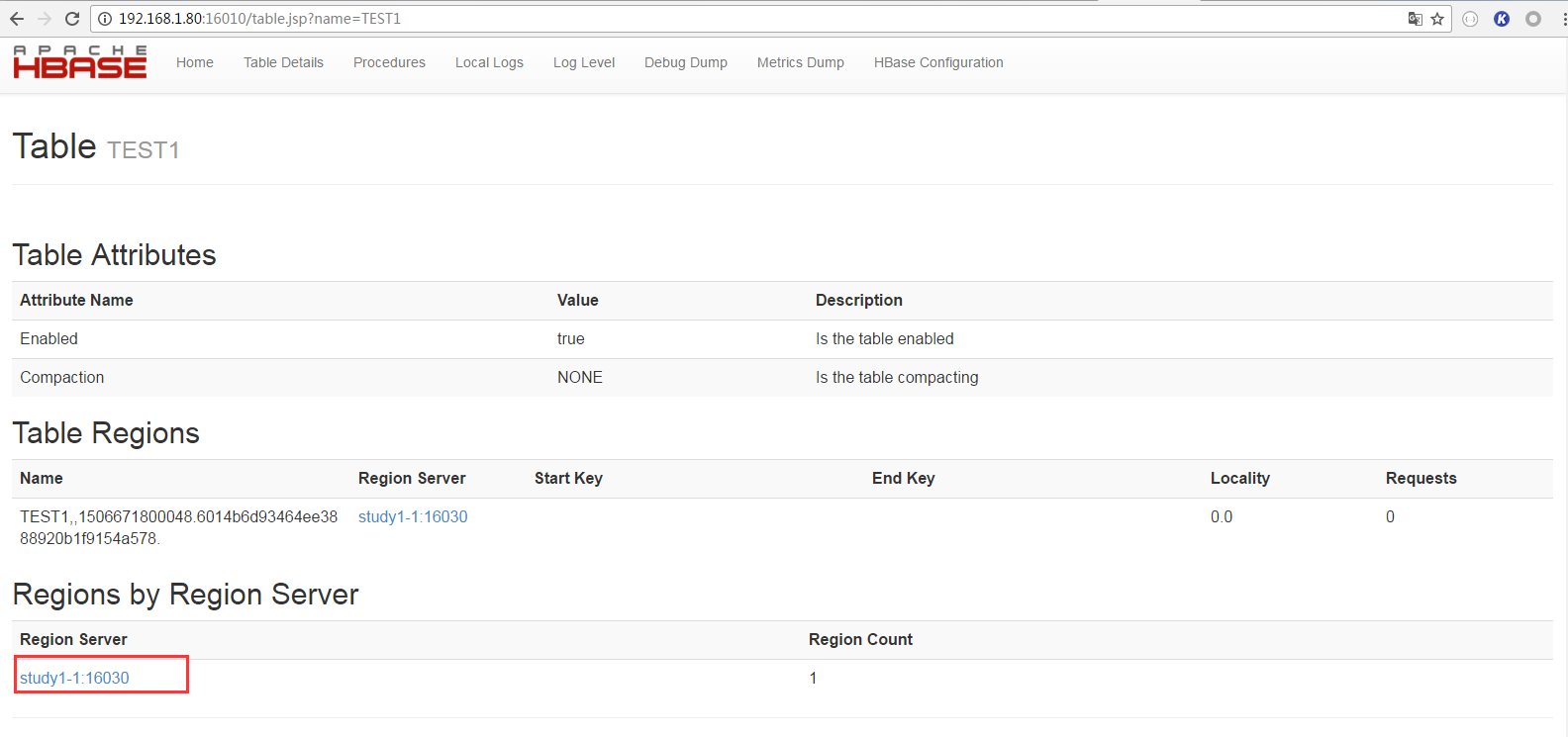

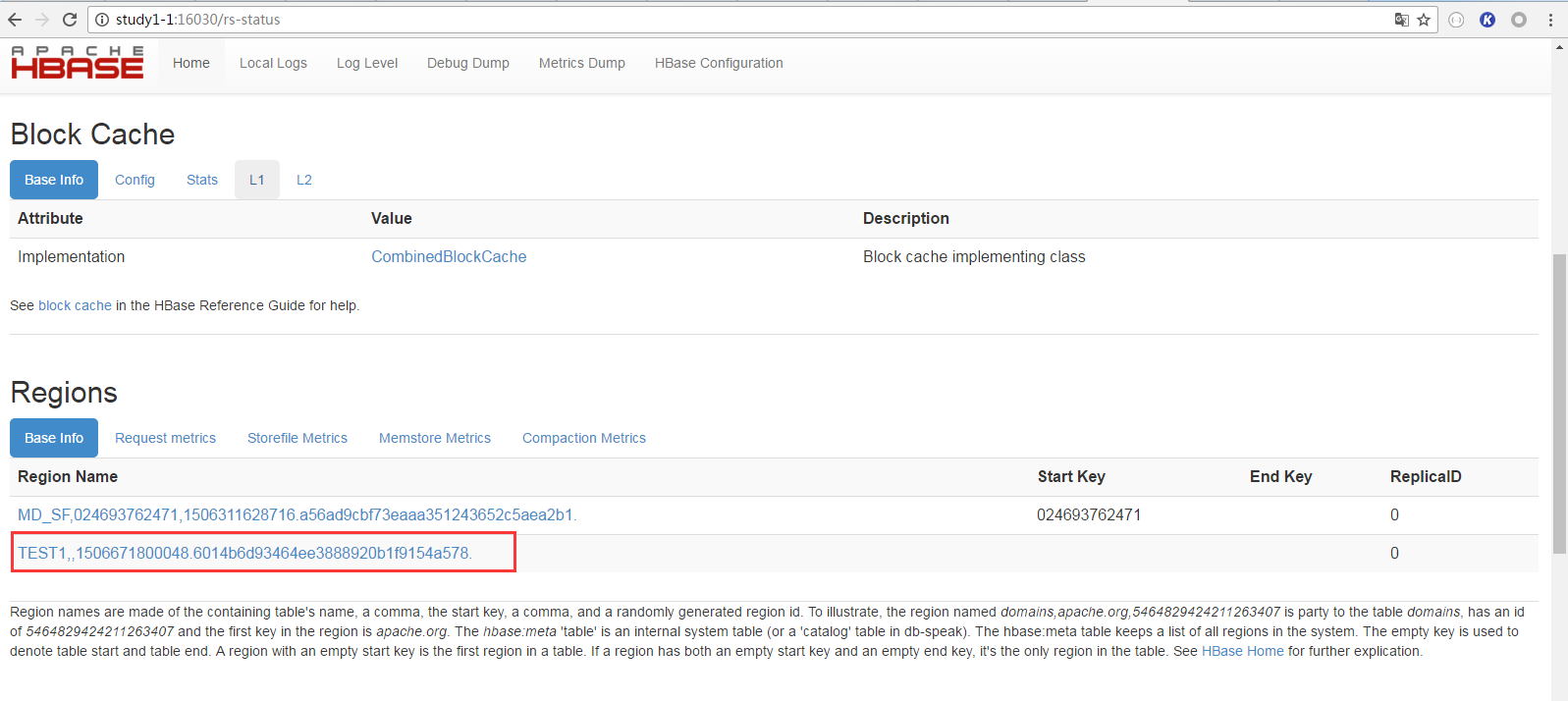

② 选择HRegion Server

③ 选择Region

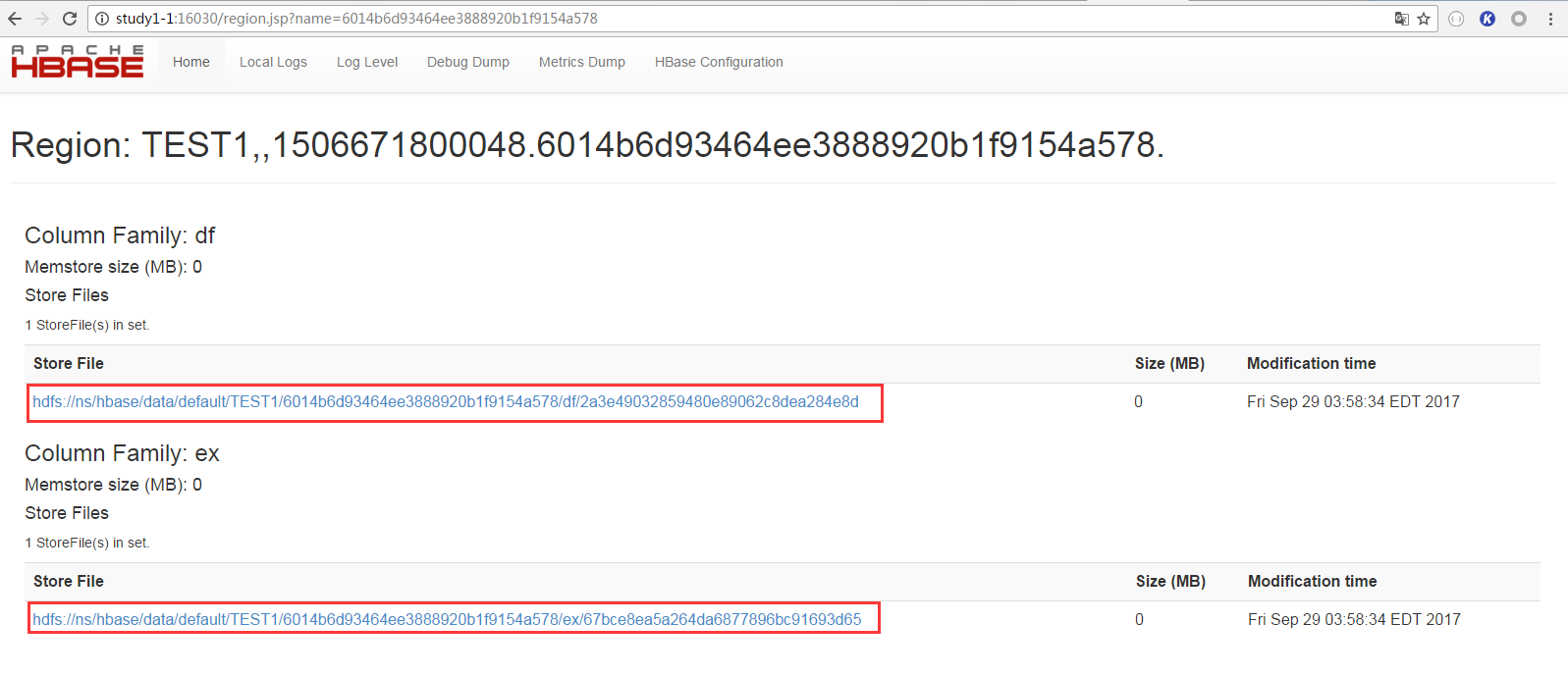

④ 查看HFile路径

HFile是以列族为单位的,我建立的表有两个列族,所以这里就有两个HFile

查看方式二:

直接使用hdfs命令,逐层查看

命令样例:hadoop fs -ls /hbase/data/default

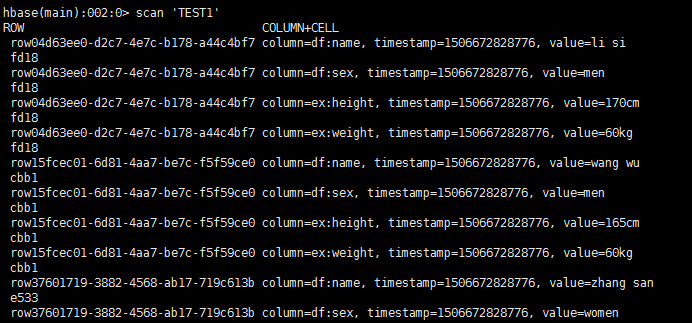

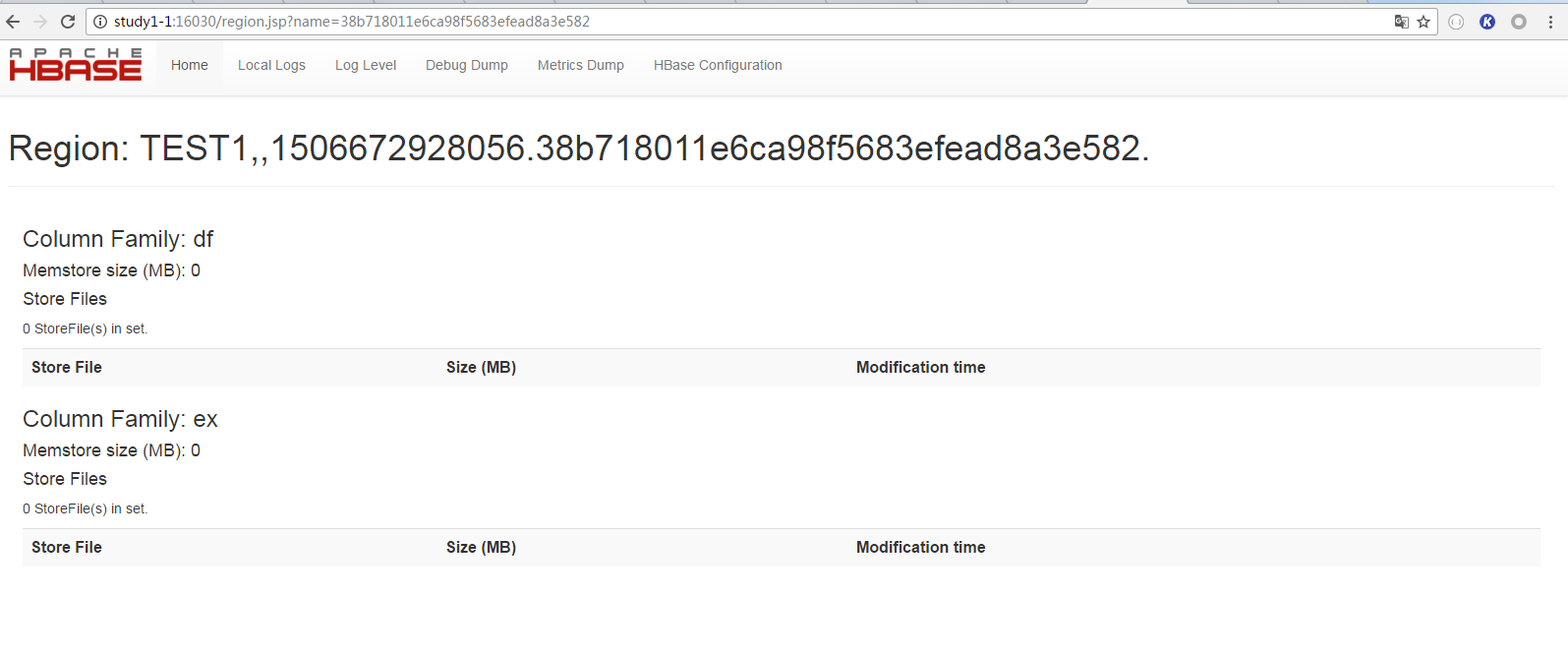

2. 为什么能scan到数据,却没有hfile?

通过程序向HBase插入数据之后,能够scan到数据,不过hdfs上确没有hfile。

如下图所示:scan 'TEST1' 能够看到表中有数据。

从Web页面上却看不到hfile

原因:

插入的数据在memstore(写缓存)中,还没有flush到hdfs上。

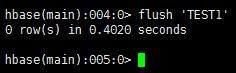

解决办法:

手动flush。在hbase shell环境下,有一个flush命令,可以手动刷某张表

flush之后,就可以看到hfile了

--END--

如何查看HBase的HFile的更多相关文章

- HBase工具:如何查看HBase的HFile

root@root:~/Desktop/sourceCodes/hbase-2.1.1/bin# ./hbase Usage: hbase [<options>] <command& ...

- Hadoop生态圈-HBase的HFile创建方式

Hadoop生态圈-HBase的HFile创建方式 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. 废话不多说,直接上代码,想说的话都在代码的注释里面. 一.环境准备 list cr ...

- pinpoint:查看hbase表和修改数据过期时间

先做个记录,监控数据量过大时可以设置表的数据过期时间来清理数据. 1. 查找本地数据表大小 [root@ZWZF-CWY-LZY-12 ~]# cd /home/pinpoint/hbase/data ...

- HBase – 存储文件HFile结构解析

本文由 网易云发布. 作者:范欣欣 本篇文章仅限内部分享,如需转载,请联系网易获取授权. HFile是HBase存储数据的文件组织形式,参考BigTable的SSTable和Hadoop的TFile ...

- Hbase写Hfile报错:Trying to load more than 32 hfiles to one family of one region

在写Hfile的时候 ,如果一个family下超过了默认的32个hfile,就会报如下错误: ERROR mapreduce.LoadIncrementalHFiles: Trying to load ...

- 通过phoenix查看hbase中表的结构

需求描述: 今天一个同事,问如何在phoenix中查询hbase中表的结构,在此记录下. 操作过程: 1.通过phoenix客户端连接到hbase数据库 [aiprd@host---- bin]$ . ...

- HBase – 探索HFile索引机制

本文由 网易云发布. 作者: 范欣欣 本篇文章仅限内部分享,如需转载,请联系网易获取授权. 01 HFile索引结构解析 HFile中索引结构根据索引层级的不同分为两种:single-level和m ...

- HBase之HFile解析

Sumary: Protobuf BinarySearch 本篇主要讲HFileV2的相关内容,包括HFile的构成.解析及怎么样从HFile中快速找到相关的KeyValue.基于Hbase 0.98 ...

- hbase数据导出和恢复 设置双master + 查看hbase表占用磁盘大小

1.备份TETST111hbase org.apache.hadoop.hbase.mapreduce.Export TEST111 /do1/hh2.drop 掉test111表 -- 只能dro ...

随机推荐

- 学习FPGA,踏上一步台阶

学习FPGA的过程中,要想踏上一步台阶,需要注意一下几点: 时序约束的原因和使用方法,能熟练正确的应用最基本的时钟周期约束,时序例外约束,异步时钟域约束,同步复位的约束,高扇出约束. 清楚FPGA芯片 ...

- Nginx+jwPlay搭建流媒体服务器,记忆播放

1.具体的流媒体服务器的搭建参考博客: http://blog.chinaunix.net/uid-20639775-id-154556.html 具体可能编译的时候有个地方报错 /root/ngin ...

- li布局问题

问题示意,好多网站一般都有这种布局,如 问题主要原因,第一个li没有margin-left 其余有(这里只考虑一排的情况) 第一种解决方式: <!DOCTYPE html> <htm ...

- Java GC日志查看

Java GC类型 Java中的GC有哪几种类型? 参数 描述 UseSerialGC 虚拟机运行在Client模式的默认值,打开此开关参数后, 使用Serial+Serial Old收集器组合进行垃 ...

- 《Java核心技术》 -- 读书笔记 ① - 预热

引言 之前通过网上的实例自己使用了Java的一些技术及轮子快速的的“烂“造了一些小应用,但是毕竟没有认真地了解和认知Java,遂打算花一个月左右的时间来细细品味一下... 从头开始,慢慢深入!! Ja ...

- Entity Framework 5.0系列之EF概览-三种编程方式

概述 在开发面向数据的软件时我们常常为了解决业务问题实体.关系和逻辑构建模型而费尽心机,ORM的产生为我们提供了一种优雅的解决方案.ADO.NET Entity Framework是.NET开发中一种 ...

- Django 模型层(2)

多表操作: 创建模型: 作者模型:把作者的详情放到详情表,包含生日,手机号,家庭住址等信息.作者详情模型和作者模型之间是一对一的关系(one-to-one) 出版商模型:出版商有名称,所在城市以及em ...

- ethereum

几个网址 https://github.com/ethereum/go-ethereum/wikihttp://ethfans.org windows下安装以太币钱包 从下面网址下载钱包,不用安装是绿 ...

- docker学习记录1

起因 现在自己学习微服务,服务器越来越多,虽然自己写了一些shell脚本来安装需要的软件,比如mysql,redis,jdk等等,但是还是好麻烦.希望学习docker能够快速安装部署这些东西. 记录一 ...

- jquery ui的css设计

jquery ui 是当前最强大的UI库之一,其两大卖点是对IE6的良好支持与换肤功能.为了构建avalon ui,今天起我将投入一部分精力来研究时下最流行的几个CSS框架.它是首当其冲. jquer ...