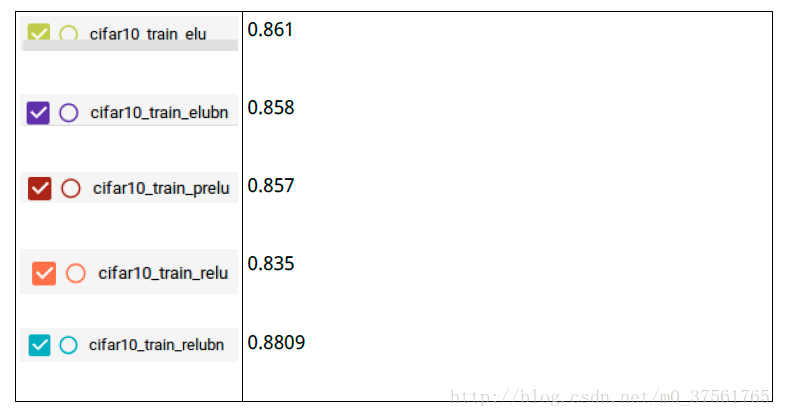

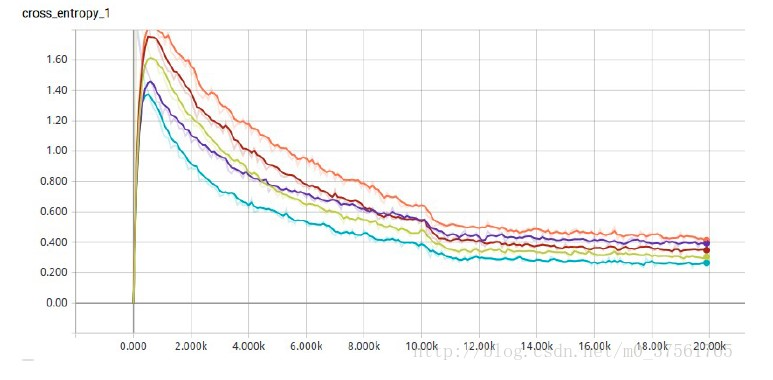

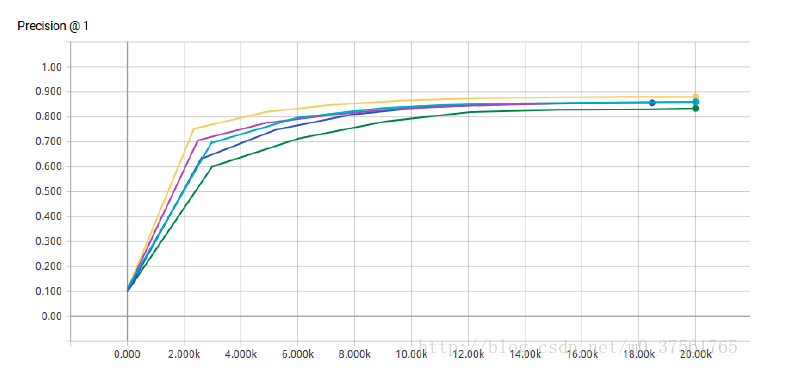

激活函数(relu,prelu,elu,+BN)对比on cifar10

Lrelu实现:

def lrelu(x, leak=0.2, name="lrelu"):

return tf.maximum(x, leak * x) Prelu实现:

def parametric_relu(_x):

alphas = tf.get_variable('alpha', _x.get_shape()[-1],

initializer=tf.constant_initializer(0.25),

dtype = tf.float32

)

pos = tf.nn.relu(_x)

neg = alphas * (_x - abs(_x)) * 0.5

print(alphas)

return pos + neg BN实现:

def batch_norm(x, n_out,scope='bn'):

"""

Batch normalization on convolutional maps.

Args:

x: Tensor, 4D BHWD input maps

n_out: integer, depth of input maps

phase_train: boolean tf.Variable, true indicates training phase

scope: string, variable scope Return:

normed: batch-normalized maps

"""

with tf.variable_scope(scope):

beta = tf.Variable(tf.constant(0.0, shape=[n_out]),

name='beta', trainable=True)

gamma = tf.Variable(tf.constant(1.0, shape=[n_out]),

name='gamma', trainable=True)

tf.add_to_collection('biases', beta)

tf.add_to_collection('weights', gamma) batch_mean, batch_var = tf.nn.moments(x, [0,1,2], name='moments')

ema = tf.train.ExponentialMovingAverage(decay=0.99) def mean_var_with_update():

ema_apply_op = ema.apply([batch_mean, batch_var])

with tf.control_dependencies([ema_apply_op]):

return tf.identity(batch_mean), tf.identity(batch_var)

#mean, var = control_flow_ops.cond(phase_train,

# mean, var = control_flow_ops.cond(phase_train,

# mean_var_with_update,

# lambda: (ema.average(batch_mean), ema.average(batch_var)))

mean, var = mean_var_with_update()

normed = tf.nn.batch_normalization(x, mean, var,

beta, gamma, 1e-3)

return normed

解压:tar -zxvf xxx.tar.gz

cifar-100-python/

cifar-100-python/file.txt~

cifar-100-python/train

cifar-100-python/test

cifar-100-python/meta

def unpickle(file):

import cPickle

fo = open(file, ‘rb’)

dict = cPickle.load(fo)

fo.close()

return dict

label_bytes =2 # 2 for CIFAR-100

#取第二个标签100维

result.label = tf.cast(

tf.strided_slice(record_bytes, [1], [label_bytes]), tf.int32)

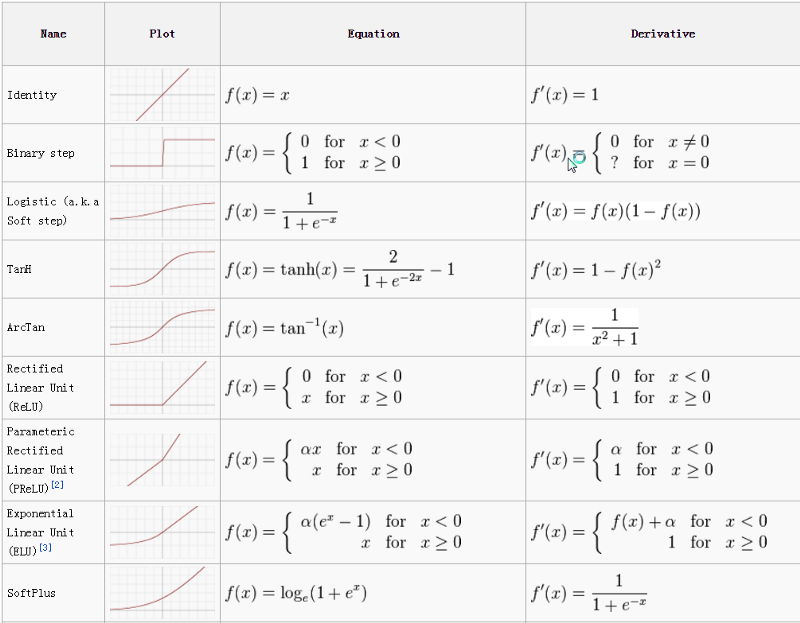

https://towardsdatascience.com/activation-functions-neural-networks-1cbd9f8d91d6

激活函数(relu,prelu,elu,+BN)对比on cifar10的更多相关文章

- 激活函数ReLU、Leaky ReLU、PReLU和RReLU

“激活函数”能分成两类——“饱和激活函数”和“非饱和激活函数”. sigmoid和tanh是“饱和激活函数”,而ReLU及其变体则是“非饱和激活函数”.使用“非饱和激活函数”的优势在于两点: 1 ...

- [转]激活函数ReLU、Leaky ReLU、PReLU和RReLU

“激活函数”能分成两类——“饱和激活函数”和“非饱和激活函数”. sigmoid和tanh是“饱和激活函数”,而ReLU及其变体则是“非饱和激活函数”.使用“非饱和激活函数”的优势在于两点: 1 ...

- 激活函数(ReLU, Swish, Maxout)

神经网络中使用激活函数来加入非线性因素,提高模型的表达能力. ReLU(Rectified Linear Unit,修正线性单元) 形式如下: \[ \begin{equation} f(x)= \b ...

- 【机器学习】激活函数(ReLU, Swish, Maxout)

https://blog.csdn.net/ChenVast/article/details/81382939 神经网络中使用激活函数来加入非线性因素,提高模型的表达能力. ReLU(Rectifie ...

- ReLU 和sigmoid 函数对比

详细对比请查看:http://www.zhihu.com/question/29021768/answer/43517930 . 激活函数的作用: 是为了增加神经网络模型的非线性.否则你想想,没有激活 ...

- ReLU 和sigmoid 函数对比以及droupout

参考知乎的讨论:https://www.zhihu.com/question/29021768 1.计算简单,反向传播时涉及除法,sigmod求导要比Relu复杂: 2.对于深层网络,sigmod反向 ...

- caffe Python API 之激活函数ReLU

import sys import os sys.path.append("/projects/caffe-ssd/python") import caffe net = caff ...

- Difference between ReLU、LReLU、PReLU、CReLU、ELU、SELU

激活函数 ReLU.LReLU.PReLU.CReLU.ELU.SELU 的定义和区别 ReLU tensorflow中:tf.nn.relu(features, name=None) LReLU ...

- 神经网络中的激活函数具体是什么?为什么ReLu要好过于tanh和sigmoid function?(转)

为什么引入激活函数? 如果不用激励函数(其实相当于激励函数是f(x) = x),在这种情况下你每一层输出都是上层输入的线性函数,很容易验证,无论你神经网络有多少层,输出都是输入的线性组合,与没有隐藏层 ...

随机推荐

- 【BZOJ2082】【POI2010】Divine divisor 假的pollard-rho

题目大意:给你$m$个数$a_i$,定义$n=\Pi_{i=1}^{m}a_i$.将$n$分解质因数为$\Pi p_i^{k_i} $,$p_i$是质数.请输出$2^{max(k_i)}-1$,以及存 ...

- apache2.4配置weblogic12c集群(linux环境)

首先确定环境已装apache2.4,没装的话可以看下这篇文章apache2.4一键脚本安装(linux环境) 1.下载apache分发模块mod_wl_24.so 下载apache2.4的weblog ...

- Top Leaders社区发现算法(top leaders community detection approach in information networks)

一.概念 复杂网络:现实生活中各种系统都可以看做成复杂网络,复杂网络构成包括节点和边,节点是网络中的基本组成单元,节点之间的联系或者关系是网络中的边.例如 电力网络:基站代表节点,基站之间是否互通表示 ...

- Vue-router的基本使用

Vue-router的基本使用 相关Html: <!DOCTYPE html> <html lang="en"> <head> <meta ...

- Spring中的BeanPostProcessor

一.何谓BeanProcessor BeanPostProcessor是SpringFramework里非常重要的核心接口之一,我先贴出一段源代码: /* * Copyright 2002-2015 ...

- 《LeetBook》leetcode题解(15):3Sum[M]

我现在在做一个叫<leetbook>的免费开源书项目,力求提供最易懂的中文思路,目前把解题思路都同步更新到gitbook上了,需要的同学可以去看看 书的地址:https://hk029.g ...

- 关于C++中操作符重载的疑问 :四个运算符=, ->, [], ()不可以重载为全局函数(友员函数)

转载自:http://blog.csdn.net/u014610226/article/details/47679323 以下是对C++中不能重载为友元函数的四个运算符进行了详细的分析介绍,需 ...

- 数据库报错com.mysql.jdbc.MysqlDataTruncation: Data truncation: Data too long for column 'ua' at row 1

记一次报错记录,成长路上的点滴 明明使用浏览器或者微信开发工具调试接口没有问题,但是在真机测试时候就出问题了.(((¬_¬)) 500服务器内部错误,要死的节奏啊 登陆tomcat服务器 使用命令ta ...

- Ubuntu系统下OpenDaylight源码编译安装

操作系统:Linux x64 / Ubuntu 14.04 研究领域:软件定义网络SDN (Software-defined Networking) 开发组件:OpenDaylight 声明:转载请注 ...

- java aop做一个接口耗时的计算

看代码: @Aspect @Component public class TimeCostAspect { private static Logger logger = LoggerFactory.g ...