Kafka设计解析(十八)Kafka与Flink集成

转载自 huxihx,原文链接 Kafka与Flink集成

Apache Flink是新一代的分布式流式数据处理框架,它统一的处理引擎既可以处理批数据(batch data)也可以处理流式数据(streaming data)。在实际场景中,Flink利用Apache Kafka作为上下游的输入输出十分常见,本文将给出一个可运行的实际例子来集成两者。

目录

一、目标

二、环境准备

三、创建Flink Streaming工程

四、增加kafka和kafka-connector依赖

五、启动Flink环境(本例使用local测试环境)

六、启动Kafka单节点集群

七、代码开发

八、部署Flink jar包

1. 打包Flink jar包

2. 部署jar包

3. 运行KafkaProducerTest

一、目标

本例模拟中将集成Kafka与Flink:Flink实时从Kafka中获取消息,每隔10秒去统计机器当前可用的内存数并将结果写入到本地文件中。

二、环境准备

- Apache Kafka 0.11.0.0

- Apache Flink 1.3.1

- Gradle 3.5 (版本号不是强要求)

本例运行在Windows环境,但可以很容易地移植到其他平台上。

三、创建Flink Streaming工程

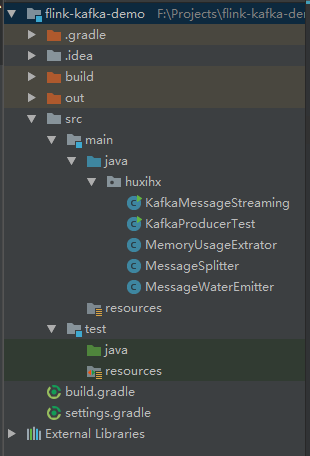

本例使用Intellij IDEA作为项目开发的IDE。首先创建Gradle project,group为'huxihx.flink.demo',artifact id为‘flink-kafka-demo’,version为‘1.0-SNAPSHOT’。整个项目结构如图所示:

四、增加kafka和kafka-connector依赖

增加下列gradle依赖:

compile group: 'org.apache.flink', name: 'flink-connector-kafka-0.10_2.11', version: '1.3.1'

compile group: 'org.apache.flink', name: 'flink-streaming-java_2.11', version: '1.3.1'

compile group: 'org.apache.kafka', name: 'kafka-clients', version: '0.11.0.0'

设置gradle打包依赖

jar {

manifest {

attributes(

"Manifest-Version": 1.0,

"Main-Class": "huxihx.KafkaMessageStreaming")

}

from { configurations.compile.collect { it.isDirectory() ? it : zipTree(it) } }

into('assets') {

from 'assets'

}

}

五、启动Flink环境(本例使用local测试环境)

F:\SourceCode\flink-1.3.1

> bin\start-local.bat

Starting Flink job manager. Webinterface by default on http://localhost:8081/.

Don't close this batch window. Stop job manager by pressing Ctrl+C.

六、启动Kafka单节点集群

启动Zookeeper:

cd F:\SourceCode\zookeeper

> bin\zkServer.cmd

启动Kafka broker:

> cd F:\SourceCode\kafka_1

> set JMX_PORT=9999

> bin\windows\kafka-server-start.bat F:\\SourceCode\\configs\\server.properties

七、代码开发

代码主要由两部分组成:

- MessageSplitter类、MessageWaterEmitter类和KafkaMessageStreaming类:Flink streaming实时处理Kafka消息类

- KafkaProducerTest类和MemoryUsageExtrator类:构建Kafka测试消息

本例中,Kafka消息格式固定为:时间戳,主机名,当前可用内存数。其中主机名固定设置为machine-1,而时间戳和当前可用内存数都是动态获取。由于本例只会启动一个Kafka producer来模拟单台机器发来的消息,因此在最终的统计结果中只会统计machine-1这一台机器的内存。下面我们先来看flink部分的代码实现。

MessageSplitter类(将获取到的每条Kafka消息根据“,”分割取出其中的主机名和内存数信息)

public class MessageSplitter implements FlatMapFunction<String, Tuple2<String, Long>> {

@Override

public void flatMap(String value, Collector<Tuple2<String, Long>> out) throws Exception {

if (value != null && value.contains(",")) {

String[] parts = value.split(",");

out.collect(new Tuple2<>(parts[1], Long.parseLong(parts[2])));

}

}

}

MessageWaterEmitter类(根据Kafka消息确定Flink的水位)

public class MessageWaterEmitter implements AssignerWithPunctuatedWatermarks<String> {

@Nullable

@Override

public Watermark checkAndGetNextWatermark(String lastElement, long extractedTimestamp) {

if (lastElement != null && lastElement.contains(",")) {

String[] parts = lastElement.split(",");

return new Watermark(Long.parseLong(parts[0]));

}

return null;

}

@Override

public long extractTimestamp(String element, long previousElementTimestamp) {

if (element != null && element.contains(",")) {

String[] parts = element.split(",");

return Long.parseLong(parts[0]);

}

return 0L;

}

}

KafkaMessageStreaming类(Flink入口类,封装了对于Kafka消息的处理逻辑。本例每10秒统计一次结果并写入到本地文件)

public class KafkaMessageStreaming {

public static void main(String[] args) throws Exception {

final StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

env.enableCheckpointing(5000); // 非常关键,一定要设置启动检查点!!

env.setStreamTimeCharacteristic(TimeCharacteristic.EventTime);

Properties props = new Properties();

props.setProperty("bootstrap.servers", "localhost:9092");

props.setProperty("group.id", "flink-group");

FlinkKafkaConsumer010<String> consumer =

new FlinkKafkaConsumer010<>(args[0], new SimpleStringSchema(), props);

consumer.assignTimestampsAndWatermarks(new MessageWaterEmitter());

DataStream<Tuple2<String, Long>> keyedStream = env

.addSource(consumer)

.flatMap(new MessageSplitter())

.keyBy(0)

.timeWindow(Time.seconds(10))

.apply(new WindowFunction<Tuple2<String, Long>, Tuple2<String, Long>, Tuple, TimeWindow>() {

@Override

public void apply(Tuple tuple, TimeWindow window, Iterable<Tuple2<String, Long>> input, Collector<Tuple2<String, Long>> out) throws Exception {

long sum = 0L;

int count = 0;

for (Tuple2<String, Long> record: input) {

sum += record.f1;

count++;

}

Tuple2<String, Long> result = input.iterator().next();

result.f1 = sum / count;

out.collect(result);

}

});

keyedStream.writeAsText(args[1]);

env.execute("Flink-Kafka demo");

}

}

实现了这些代码之后我们已然可以打包进行部署了,不过在其之前我们先看下Kafka producer测试类的实现——该类每1秒发送一条符合上面格式的Kafka消息供下游Flink集群消费。

MemoryUsageExtrator类(很简单的工具类,提取当前可用内存字节数)

public class MemoryUsageExtrator {

private static OperatingSystemMXBean mxBean =

(OperatingSystemMXBean) ManagementFactory.getOperatingSystemMXBean();

/**

* Get current free memory size in bytes

* @return free RAM size

*/

public static long currentFreeMemorySizeInBytes() {

return mxBean.getFreePhysicalMemorySize();

}

}

KafkaProducerTest类(发送Kafka消息)

public class KafkaProducerTest {

public static void main(String[] args) throws Exception {

Properties props = new Properties();

props.put("bootstrap.servers", "localhost:9092");

props.put("acks", "all");

props.put("retries", 0);

props.put("batch.size", 16384);

props.put("linger.ms", 1);

props.put("buffer.memory", 33554432);

props.put("key.serializer", "org.apache.kafka.common.serialization.StringSerializer");

props.put("value.serializer", "org.apache.kafka.common.serialization.StringSerializer");

Producer<String, String> producer = new KafkaProducer<>(props);

int totalMessageCount = 10000;

for (int i = 0; i < totalMessageCount; i++) {

String value = String.format("%d,%s,%d", System.currentTimeMillis(), "machine-1", currentMemSize());

producer.send(new ProducerRecord<>("test", value), new Callback() {

@Override

public void onCompletion(RecordMetadata metadata, Exception exception) {

if (exception != null) {

System.out.println("Failed to send message with exception " + exception);

}

}

});

Thread.sleep(1000L);

}

producer.close();

}

private static long currentMemSize() {

return MemoryUsageExtrator.currentFreeMemorySizeInBytes();

}

}

八、部署Flink jar包

1. 打包Flink jar包

> cd flink-kafka-demo

> gradle clean build

生成的jar包在项目目录下的build/libs/下,本例中是flink-kafka-demo-1.0-SNAPSHOT.jar

2. 部署jar包

> bin\flink.bat run -c huxihx.KafkaMessageStreaming F:\\Projects\\flink-kafka-demo\\build\\libs\\flink-kafka-demo-1.0-SNAPSHOT.jar test F:\\temp\result.txt

KafkaMessageStreaming类接收两个命令行参数,第一个是Kafka topic名字,第二个是输出文件路径

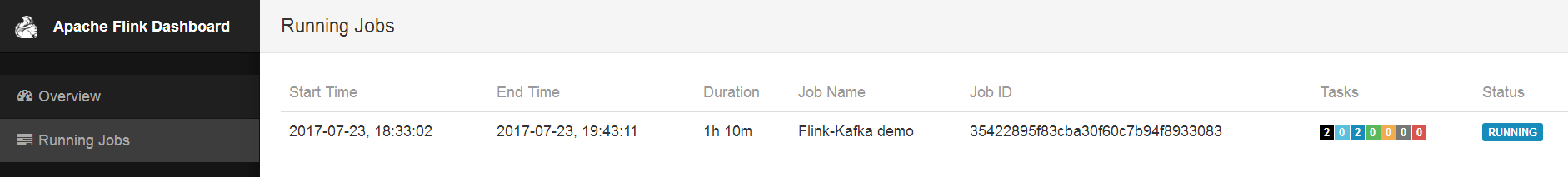

部署成功之后,可以在Flink控制台(本例中是http://localhost:8081/)中看到job已成功部署,如下图所示:

3. 运行KafkaProducerTest

运行Kafka producer,给Flink job创建输入数据,然后启动一个终端,监控输出文件的变化,

> cd F:\temp

> tail -f result.txt

(machine-1,3942129078)

(machine-1,3934864179)

(machine-1,4044071321)

(machine-1,4091437056)

(machine-1,3925701836)

(machine-1,3753678438)

(machine-1,3746314649)

......

可以看到,Flink每隔10s就会保存一条新的统计记录到result.txt文件中,该记录会统计主机名为machine-1的机器在过去10s的平均可用内存字节数。

总结

本文给出了一个可运行的Flink + Kafka的项目配置及代码实现。值得注意的是,上面例子中用到的Flink Kafka connector使用了Kafka新版本consumer的API,因此不再需要连接Zookeeper信息。

Kafka设计解析(十八)Kafka与Flink集成的更多相关文章

- Kafka设计解析(八)- Exactly Once语义与事务机制原理

原创文章,首发自作者个人博客,转载请务必将下面这段话置于文章开头处. 本文转发自技术世界,原文链接 http://www.jasongj.com/kafka/transaction/ 写在前面的话 本 ...

- Kafka设计解析(八)Exactly Once语义与事务机制原理

转载自 技术世界,原文链接 Kafka设计解析(八)- Exactly Once语义与事务机制原理 本文介绍了Kafka实现事务性的几个阶段——正好一次语义与原子操作.之后详细分析了Kafka事务机制 ...

- Kafka设计解析

Kafka剖析(一):Kafka背景及架构介绍 Kafka设计解析(二):Kafka High Availability (上) Kafka设计解析(三):Kafka High Availabilit ...

- Kafka设计解析(十三)Kafka消费组(consumer group)

转载自 huxihx,原文链接 Kafka消费组(consumer group) 一直以来都想写一点关于kafka consumer的东西,特别是关于新版consumer的中文资料很少.最近Kafka ...

- Kafka设计解析(五)- Kafka性能测试方法及Benchmark报告

本文转发自Jason’s Blog,原文链接 http://www.jasongj.com/2015/12/31/KafkaColumn5_kafka_benchmark 摘要 本文主要介绍了如何利用 ...

- 揭秘Kafka高性能架构之道 - Kafka设计解析(六)

原创文章,同步首发自作者个人博客.转载请务必在文章开头处以超链接形式注明出处http://www.jasongj.com/kafka/high_throughput/ 摘要 上一篇文章<Kafk ...

- 流式处理的新贵 Kafka Stream - Kafka设计解析(七)

原创文章,转载请务必将下面这段话置于文章开头处. 本文转发自技术世界,原文链接 http://www.jasongj.com/kafka/kafka_stream/ Kafka Stream背景 Ka ...

- Kafka设计解析(六)- Kafka高性能架构之道

本文从宏观架构层面和微观实现层面分析了Kafka如何实现高性能.包含Kafka如何利用Partition实现并行处理和提供水平扩展能力,如何通过ISR实现可用性和数据一致性的动态平衡,如何使用NIO和 ...

- Kafka设计解析(七)- Kafka Stream

本文介绍了Kafka Stream的背景,如Kafka Stream是什么,什么是流式计算,以及为什么要有Kafka Stream.接着介绍了Kafka Stream的整体架构,并行模型,状态存储,以 ...

- [Big Data - Kafka] Kafka设计解析(五):Kafka Benchmark

性能测试及集群监控工具 Kafka提供了非常多有用的工具,如Kafka设计解析(三)- Kafka High Availability (下)中提到的运维类工具——Partition Reassign ...

随机推荐

- 【学习笔记】--- 老男孩学Python,day9, 文件操作

有 + 就是有光标,注意光标位置 不同模式打开文件的完全列表: http://www.runoob.com/python/python-files-io.html 模式 描述 r 以只读方式打开文件 ...

- js-权威指南学习笔记15

第十五章 脚本化文档 1.文档对象模型DOM是表示和操作HTML和XML文档内容的基础API. 2.Document.Element.Text是Node的子类. 3.查询文档的一个或多个元素有如下方法 ...

- 图片按钮(imageButton)

图片按钮(imageButton) 常用属性: android:src="@drawable/download" (这里的download是一张图片的名称,通过引用该图片的名称直接 ...

- 前端 css+js实现返回顶部功能

描述: 本文主要是讲,通过css+js实现网页中的[返回顶部]功能. 实现代码: HTML: <div> <button onclick="returnTop()" ...

- Oracle如何把数据库表迁移到指定表空间

问题描述: 将测试数据库中的表结果导入到正式数据库.需要在正式库中建立独立的表空间存放新导入的表,以避免和正式库中原来的表混淆. 处理步骤: 1. 在命令行中用exp指令导出测试库中指定表到指定 ...

- 混淆矩阵(Confusion matrix)的原理及使用(scikit-learn 和 tensorflow)

原理 在机器学习中, 混淆矩阵是一个误差矩阵, 常用来可视化地评估监督学习算法的性能. 混淆矩阵大小为 (n_classes, n_classes) 的方阵, 其中 n_classes 表示类的数量. ...

- [翻译] CRPixellatedView-用CIPixellate滤镜动态渲染UIView

CRPixellatedView-用CIPixellate滤镜动态渲染UIView https://github.com/chroman/CRPixellatedView 本人测试的效果: Usage ...

- Linux 文件的读写执行权限的说明

文件的读写执行权限的说明 X 进入目录的权限: cd 1.文件本身是可执行的 2.普通用户还具备r的权限 3.root用户只需要有r的权限即可 r 查看目录/文件的内容 :ls dir 没有读的权 限 ...

- September 08th 2017 Week 36th Friday

Death is so terribly final, while life is full of possibilities. 死亡是冰冷可怕的绝境,而或者却充满了无限的可能. It isn't t ...

- lambda 形参:返回值 lambda 匿名函数 格式:

lambda 匿名函数 格式: lambda 形参:返回值 e.g f = lambda n:n**2 print(f(10))