Python-爬虫-猫眼T100

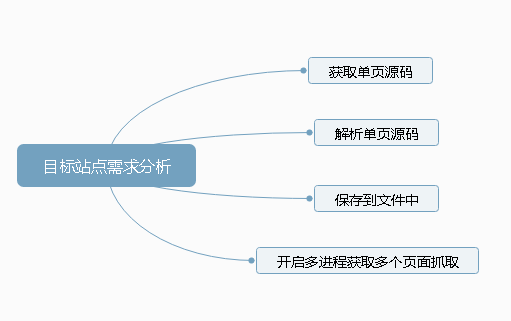

目标站点需求分析

涉及的库

from multiprocessing import Pool

from requests.exceptions import RequestException

import requests

import json,csv,time,re

获取单页源码

def get_one_page(url):

'''获取单页源码'''

try:

headers = {

"User-Agent":"Mozilla/5.0 (Windows NT 6.1; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/70.0.3538.77 Safari/537.36",

}

res = requests.get(url, headers=headers)

time.sleep(1)

# 判断响应是否成功

if res.status_code == 200:

# print(res.text)

return res.text

return ('status_code error')

except RequestException:

return ('RequestException error'

解析单页源码

def parse_one_page(html):

'''解析单页源码'''

pattern = re.compile('<dd>.*?board-index.*?>(\d+)</i>.*?name"><a.*?>(.*?)</a>.*?star">(.*?)</p>.*?releasetime'

+ '.*?>(.*?)</p>.*?score.*?integer">(.*?)</i>.*?>(.*?)</i>.*?</dd>',re.S)

items = re.findall(pattern,html)

#循环提取信息

for item in items:

yield {

'rank' :item[0],

'name':item[1],

# 'actor':item[2].strip()[3:] if len(item[2])>3 else '', #判断是否大于3个字符

# 'time' :item[3].strip()[5:] if len(item[3])>5 else '',

'actor':item[2].strip()[3:],

'time' :item[3].strip()[5:15],

'score':item[4] + item[5]

}

保存到文件中

def write_to_textfile(content):

'''写入text'''

with open("MovieResult.text",'a',encoding='utf-8') as f:

#利用json.dumps()将字典序列化,并将ensure_ascii设置为False,从而显示中文.+换行

f.write(json.dumps(content,ensure_ascii=False) + "\n")

f.close() def write_to_csvField(fieldnames):

'''写入csv表头'''

with open("MovieResult.csv", 'a', encoding='gb18030', newline='') as f:

#将字段名传给Dictwriter来初始化一个字典写入对象

writer = csv.DictWriter(f,fieldnames=fieldnames)

#调用writeheader方法写入字段名

writer.writeheader() def write_to_csvRows(content,fieldnames):

'''写入csv内容'''

with open("MovieResult.csv",'a',encoding='gb18030',newline='') as f:

#将字段名传给Dictwriter来初始化一个字典写入对象

writer = csv.DictWriter(f,fieldnames=fieldnames)

writer.writerows(content)

f.close()

开启多进程获取多个页面抓取

# 将字段名传入列表

fieldnames = ["rank", "name", "actor", "time", "score"] def task(offset):

url = "http://maoyan.com/board/4?offset={0}".format(offset)

html = get_one_page(url)

rows = []

for item in parse_one_page(html):

# write_to_textfile(item)

rows.append(item)

# 写入csv内容

write_to_csvRows(rows,fieldnames) if __name__ == '__main__':

#写入csv表头

write_to_csvField(fieldnames)

#map方法会把每个元素当做函数的参数,,在进程池中创建多进程.循环写入10页传参

pool = Pool()

pool.map(task,[i*10 for i in range(10)])

Python-爬虫-猫眼T100的更多相关文章

- Python爬虫实例:爬取猫眼电影——破解字体反爬

字体反爬 字体反爬也就是自定义字体反爬,通过调用自定义的字体文件来渲染网页中的文字,而网页中的文字不再是文字,而是相应的字体编码,通过复制或者简单的采集是无法采集到编码后的文字内容的. 现在貌似不少网 ...

- Python爬虫教程-11-proxy代理IP,隐藏地址(猫眼电影)

Python爬虫教程-11-proxy代理IP,隐藏地址(猫眼电影) ProxyHandler处理(代理服务器),使用代理IP,是爬虫的常用手段,通常使用UserAgent 伪装浏览器爬取仍然可能被网 ...

- Python之爬虫-猫眼电影

Python之爬虫-猫眼电影 #!/usr/bin/env python # coding: utf-8 import json import requests import re import ti ...

- Python爬虫实例:爬取B站《工作细胞》短评——异步加载信息的爬取

很多网页的信息都是通过异步加载的,本文就举例讨论下此类网页的抓取. <工作细胞>最近比较火,bilibili 上目前的短评已经有17000多条. 先看分析下页面 右边 li 标签中的就是短 ...

- python爬虫数据解析之正则表达式

爬虫的一般分为四步,第二个步骤就是对爬取的数据进行解析. python爬虫一般使用三种解析方式,一正则表达式,二xpath,三BeautifulSoup. 这篇博客主要记录下正则表达式的使用. 正则表 ...

- Python爬虫实例:爬取豆瓣Top250

入门第一个爬虫一般都是爬这个,实在是太简单.用了 requests 和 bs4 库. 1.检查网页元素,提取所需要的信息并保存.这个用 bs4 就可以,前面的文章中已经有详细的用法阐述. 2.找到下一 ...

- Python爬虫教程-01-爬虫介绍

Spider-01-爬虫介绍 Python 爬虫的知识量不是特别大,但是需要不停和网页打交道,每个网页情况都有所差异,所以对应变能力有些要求 爬虫准备工作 参考资料 精通Python爬虫框架Scrap ...

- Python爬虫教程-00-写在前面

鉴于好多人想学Python爬虫,缺没有简单易学的教程,我将在CSDN和大家分享Python爬虫的学习笔记,不定期更新 基础要求 Python 基础知识 Python 的基础知识,大家可以去菜鸟教程进行 ...

- Python爬虫编程常见问题解决方法

Python爬虫编程常见问题解决方法: 1.通用的解决方案: [按住Ctrl键不送松],同时用鼠标点击[方法名],查看文档 2.TypeError: POST data should be bytes ...

- Python爬虫教程-32-Scrapy 爬虫框架项目 Settings.py 介绍

本篇介绍项目开发的过程中,对 Setting 文件的配置和使用 Python爬虫教程-32-Scrapy 爬虫框架项目 Settings.py 介绍 settings.py 文件的使用 想要详细查看 ...

随机推荐

- TCP时间获取程序

一.服务器程序 #include <stdio.h> #include <stdlib.h> #include <time.h> #include <sys/ ...

- MySQL之数据表(五)

1.数据表是数据库的重要内容,首先打开数据库. USE DATABASE; mysql> SHOW DATABASES;+--------------------+| Database |+-- ...

- 使用PHP+MySql+Ajax+jQuery实现省市区三级联动功能

使用PHP+MySql+Ajax+jQuery实现省市区三级联动功能 要求:写一个省市区(或者年月日)的三级联动,实现地区或时间的下拉选择. 实现技术:php ajax 实现:省级下拉变化时市下拉区下 ...

- 面向对象 ( OO ) 的程序设计——创建对象

本文地址:http://www.cnblogs.com/veinyin/p/7608000.html 为了避免大量重复代码产生,可采用以下方法创建对象 1 工厂模式 function createP ...

- CountDownLatch学习

看了几篇博客,说用CountDownLatch实现一个先执行完子线程,再执行主线程的例子.因此写一篇博客总结一下. 一.CountDownLatch了解 1.CountDownLatch继承了Abst ...

- 课程10:《黑马程序员_Hibernate开发资料》视频目录--没有细看

老师很厉害,讲得蛮详细的 \Hibernate视频教程\01_黑马程序员_Hibernate教程__Hibernate入门基础.avi; \Hibernate视频教程\02_黑马程序员_Hiberna ...

- Spring boot中普通工具类不能使用@Value注入yml文件中的自定义参数的问题

在写一个工具类的时候,因为要用到yml中的自定义参数,使用@Value发现值不能正常注入,都显示为null: yml文件中的自定义格式 调用工具类的时候不能new的方式 要使用@Autowired的方 ...

- SQL操作json类型数据的函数

MySQL5.7之后对json数据格式进行了函数支持 Json_contains(字段名, '值') 1.表中json格式的某个字段 2.json里的某个键值 Json_search(字段名, 'on ...

- 使用WinIo32绕过密码控件实现自动登录

通过winIO32绕过密码控件,实现自动登录 环境: vmware上安装windows 32位系统:windows xp / windows 7 selenium版本: 3.11.0 IEDriver ...

- python3字典中items()和python2.x中iteritems()有什么不同?

在Python2.x中: items() 用于返回一个字典的拷贝列表[Returns a copy of the list of all items (key/value pairs) in D],占 ...