【机器学习】BP & softmax求导

目录

一、BP原理及求导

二、softmax及求导

一、BP

1、为什么沿梯度方向是上升最快方向

根据泰勒公式对f(x)在x0处展开,得到f(x) ~ f(x0) + f'(x0)(x-x0), 故得到f(x) - f(x0) ~ f'(x0)(x-x0), 所以从x0出发,变化最快,即使f(x)-f(x0)最大,也就f'(x0)(x-x0),由于f'(x0)与(x-x0)均为向量(现在x0取的是一个数,如果放在多维坐标那么x0就是一个多维向量),由余弦定理f'(x0) 与(x-x0)方向相同时,点积最大,故梯度方向是上升最快方向。

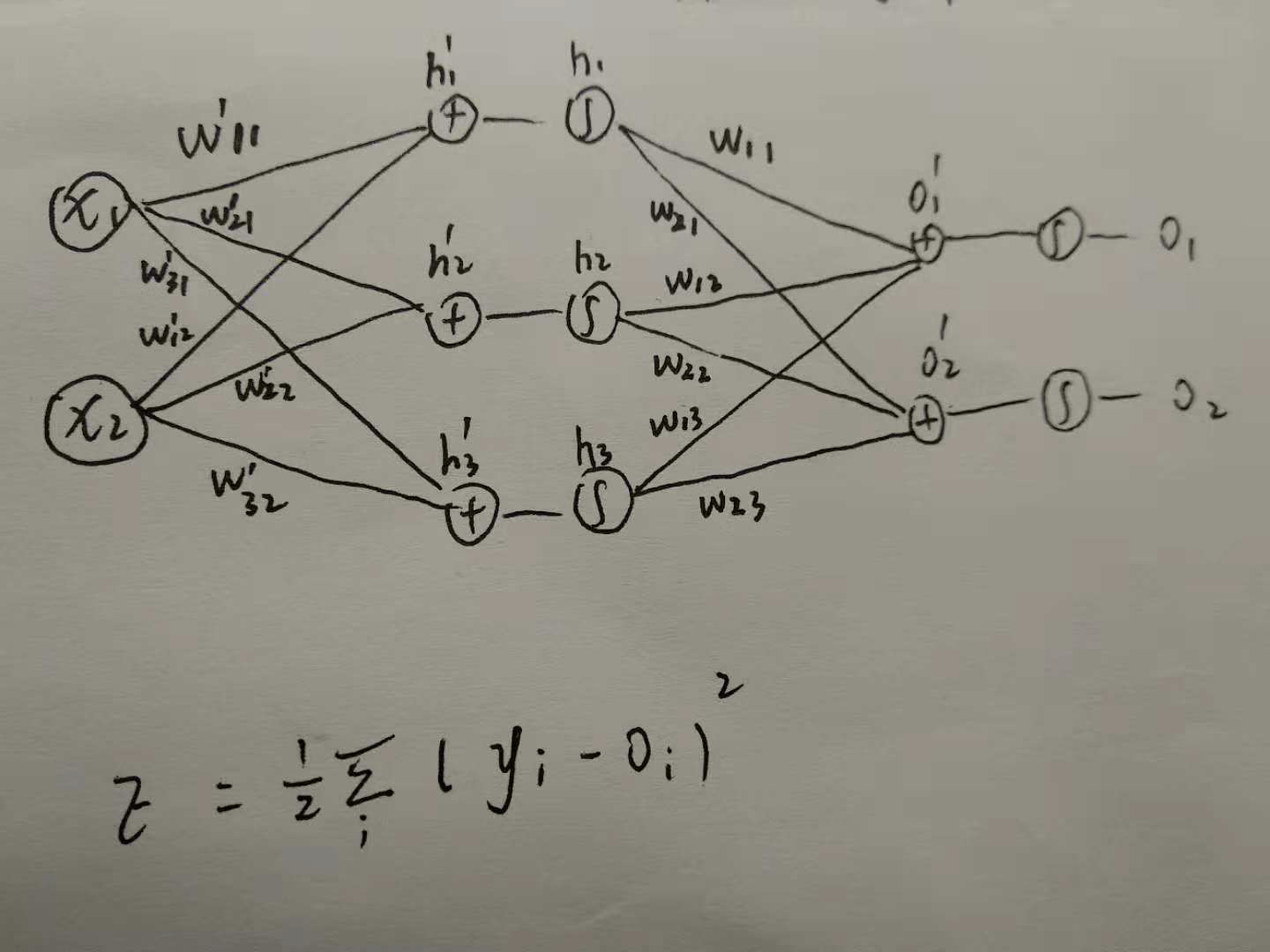

2、什么是BP

梯度反向传播(back propagation)过程就是: 由前馈神经网络得到损失函数,然后根据损失函数后向地更新每一层的权重,目的就是让损失函数变小

3、BP的优势

- 与从前往后进行求导相比,BP能够避开了路径被重复访问,它对于每一个路径只访问一次就能求顶点对所有下层节点的偏导值。

- 能够自适应、自主学习。这是BP算法的根本以及其优势所在,BP算法根据预设的参数更新规则,不断地调整神经网络中的参数,以达到最符合期望的输出。

4、BP的不足

- BP是基于梯度下降算法实现的,所以容易陷入局部最小而不是全局最小

- 由于BP神经网络中的参数众多,每次都需要更新数量较多的阈值和权值,故会导致收敛速度过慢

二、softmax函数及求导

1、softmax函数

在Logistic regression二分类问题中,我们可以使用sigmoid函数将输入映射到

区间中,从而得到属于某个类别的概率。将这个问题进行泛化,推广到多分类问题中,我们可以使用softmax函数,对输出的值归一化为概率值。

这里假设在进入softmax函数之前,已经有模型输出值,其中

是要预测的类别数,模型可以是全连接网络的输出

,其输出个数为

,即输出为

。

所以对每个样本,它属于类别的概率为:

通过上式可以保证 ,即属于各个类别的概率和为1。

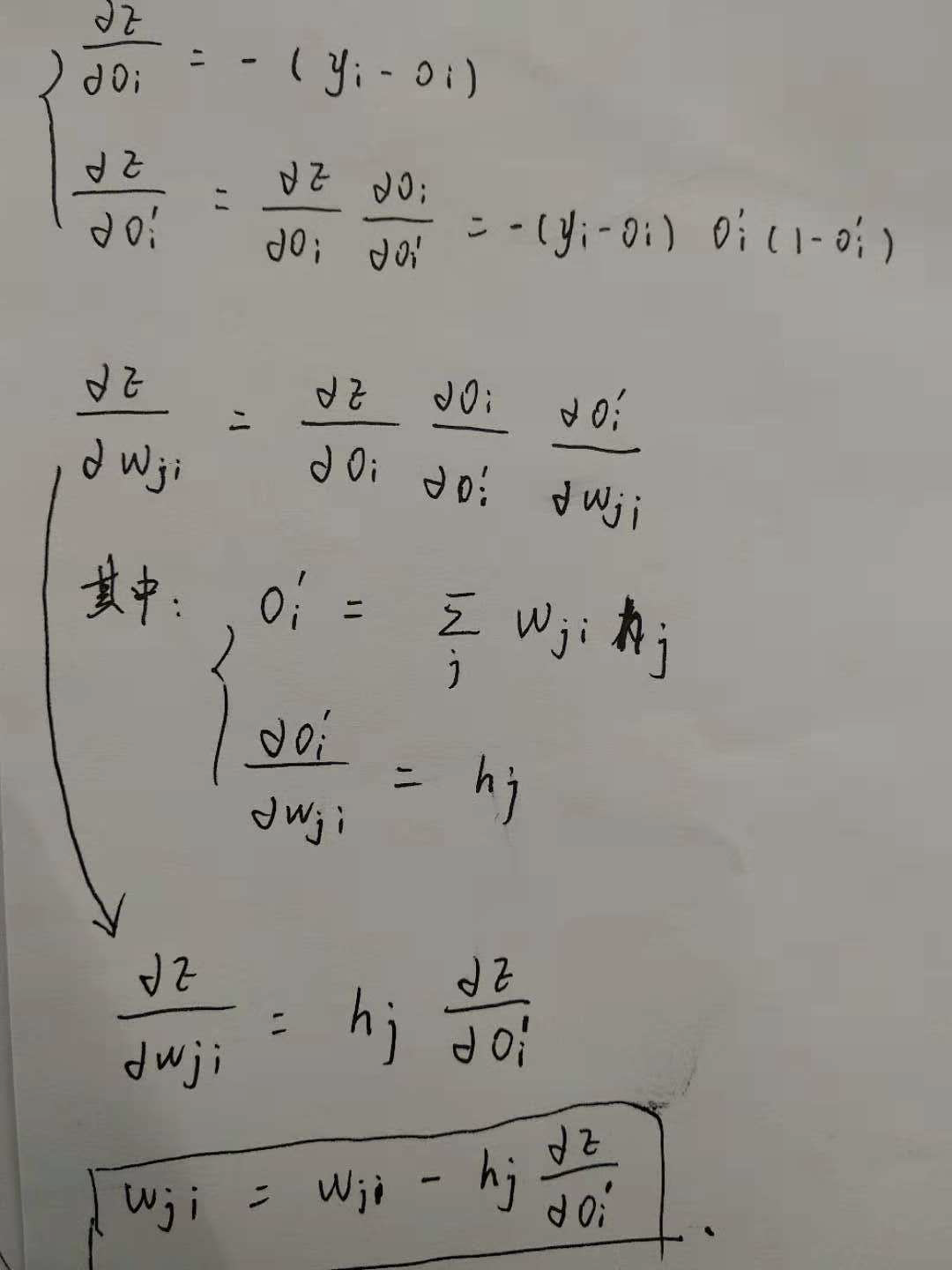

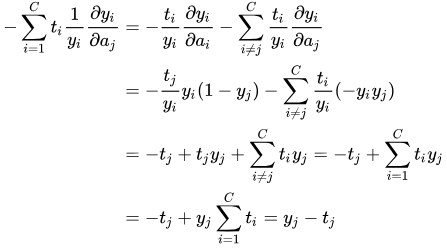

2、求导

对softmax函数进行求导,即求

第项的输出对第

项输入的偏导。

代入softmax函数表达式,可以得到:

所以,当时:

当时:

LOSS 求导

对一个样本来说,真实类标签分布与模型预测的类标签分布可以用交叉熵来表示:

最终,对所有的样本,我们有以下loss function:

其中是样本

属于类别

的概率,

是模型对样本

预测为属于类别

的概率。

对单个样本来说,loss function对输入

的导数为:

上面对求导结果已经算出:

当时:

当时:

所以,将求导结果代入上式

参考博客:

1、https://zhuanlan.zhihu.com/p/27223959

【机器学习】BP & softmax求导的更多相关文章

- Deep Learning基础--Softmax求导过程

一.softmax函数 softmax用于多分类过程中,它将多个神经元的输出,映射到(0,1)区间内,可以看成概率来理解,从而来进行多分类! 假设我们有一个数组,V,Vi表示V中的第i个元素,那么这个 ...

- softmax求导、cross-entropy求导及label smoothing

softmax求导 softmax层的输出为 其中,表示第L层第j个神经元的输入,表示第L层第j个神经元的输出,e表示自然常数. 现在求对的导数, 如果j=i, 1 如果ji, 2 cross-e ...

- 【机器学习基础】对 softmax 和 cross-entropy 求导

目录 符号定义 对 softmax 求导 对 cross-entropy 求导 对 softmax 和 cross-entropy 一起求导 References 在论文中看到对 softmax 和 ...

- 前馈网络求导概论(一)·Softmax篇

Softmax是啥? Hopfield网络的能量观点 1982年的Hopfiled网络首次将统计物理学的能量观点引入到神经网络中, 将神经网络的全局最小值求解,近似认为是求解热力学系统的能量最低点(最 ...

- softmax交叉熵损失函数求导

来源:https://www.jianshu.com/p/c02a1fbffad6 简单易懂的softmax交叉熵损失函数求导 来写一个softmax求导的推导过程,不仅可以给自己理清思路,还可以造福 ...

- 关于 RNN 循环神经网络的反向传播求导

关于 RNN 循环神经网络的反向传播求导 本文是对 RNN 循环神经网络中的每一个神经元进行反向传播求导的数学推导过程,下面还使用 PyTorch 对导数公式进行编程求证. RNN 神经网络架构 一个 ...

- cnn softmax regression bp求导

内容来自ufldl,代码参考自tornadomeet的cnnCost.m 1.Forward Propagation convolvedFeatures = cnnConvolve(filterDim ...

- softmax分类器+cross entropy损失函数的求导

softmax是logisitic regression在多酚类问题上的推广,\(W=[w_1,w_2,...,w_c]\)为各个类的权重因子,\(b\)为各类的门槛值.不要想象成超平面,否则很难理解 ...

- softmax 损失函数求导过程

前言:softmax中的求导包含矩阵与向量的求导关系,记录的目的是为了回顾. 下图为利用softmax对样本进行k分类的问题,其损失函数的表达式为结构风险,第二项是模型结构的正则化项. 首先,每个qu ...

随机推荐

- 批量删除MSSQL 中主外键约束

转自: http://www.maomao365.com/?p=813 在制作 MSSQL同步工具的时候,发现由于主外键的约束,导致数据同步异常,所有我们需要把 读数据库里面的主外键约束,进行批量删除 ...

- 自动化测试之路2---python安装

借鉴这位老哥的文章http://www.cnblogs.com/shabbylee/p/6792555.html

- LeetCode算法题-Minimum Index Sum of Two Lists(Java实现)

这是悦乐书的第272次更新,第286篇原创 01 看题和准备 今天介绍的是LeetCode算法题中Easy级别的第139题(顺位题号是599).假设Andy和Doris想要选择一家餐馆吃晚餐,他们都有 ...

- C语言----int (*p)[4] ---思考总结

a+1 跳4个int (*a)+1 跳一个int

- Django组件--分页器(有用)

一.分页器对象 from django.core.paginator import Paginator,EmptyPage book_list = Book.objects.all() #假设有100 ...

- kernel笔记——库文件与系统调用

库文件 先从我们熟悉的c库入手,理解系统调用(system call).c代码中调用printf函数,经历了以下调用过程: 最终输出的功能由内核中write调用完成,c库封装了系统调用. 对于以下 ...

- LInkedHashMap实现最近被使用(LRU)缓存

在最近的面试中,我曾被多次问到,怎么实现一个最近最少使用(LRU)的缓存.缓存可以通过哈希表来实现,然而为这个缓存增加大小限制会变成另一个有意思的问题.现在我们看一下怎么实现. 最近最少使用缓存的回收 ...

- VMware Workstation中安装linux系统(CentOS)超详细(部分转载)

首先准备一下VMware虚拟机和linux镜像文件,链接如下: 对于32位windows机子安装的是10.0.7版本的VMware Workstation,链接: https://pan.baidu. ...

- Centos7.x做开机启动脚本

cat /etc/centos-release CentOS Linux release 7.4.1708 (Core) uname -r 3.10.0-693.11.1.el7.x86_64 vim ...

- <转>性能测试指标

下午在家看书,清理收藏栏的内容,翻出来几篇去年收藏的博文,此时再看,真切的感觉到了自己这一年的成长,分享出来,希望看到的童鞋都能有所得,就好... 原文地址:性能测试指标 一.通用指标 指Web应用服 ...