Spark环境搭建(四)-----------数据仓库Hive环境搭建

Hive产生背景

1)MapReduce的编程不便,需通过Java语言等编写程序

2) HDFS上的文缺失Schema(在数据库中的表名列名等),方便开发者通过SQL的方式处理结构化的数据,而不需要Java等编写程序

Hive是什么

1)facebook开源,最初为解决海量的结构化日志数据统计问题

2)构建中Hadoop上的数据仓库

3)Hive定义了一种SQL查询语言:HQL(类似SQl但又不完全相同)

4)通常进行离线处理(采用MapReduce)

5)多种不同的底层执行引擎(Hive on MapReduce/Tez/Spark)

6)支持多种不同的压缩格式,存储格式以及自定义函数

压缩格式:GZIP,LZO,Snappy,BZIP2..

存储格式:TextFile,SequenceFile,RCFile,ORC,PARquet

UDF:自定义函数

为什么使用Hive

1) 简单,容易上手(提供了类似SQL查询语言HQL)

2) 为超大数据集设计的计算、存储扩展能力(MR计算,HDFS存储)

3) 统一的元数据管理(可与Presto/Impala/SparkSQL等共享数据)

Hive环境搭建

1)使用版本:hive-1.1.0-cdh5.7.0.tar.gz

2) 下载:

wget http://archive.cloudera.com/cdh5/cdh/5/

3)解压:tar -zxvf hive-1.1.0-cdh5.7.0.tar.gz -C ~/app/

4)配置

(1) 系统环境变量(~/.bash_profile)

export HIVE_HOME=/root/app/hive-1.1.0-cdh5.7.0 export PATH=$HIVE_HOME/bin:$PATH

(2) 安装一个Mysql (可以参考我这篇博文)

命令 yum install ***

(3) 在conf下新建一个 hive-site.xml

插入以下内容

<configuration>

<property>

<name>javax.jdo.option.ConnectionURL</name>

<value>jdbc:mysql://localhost:3306/sparksql?createDatabaseIfNotExist=true</value>

</property>

<property>

<name>javax.jdo.option.ConnectionDriverName</name>

<value>com.mysql.jdbc.Driver</value>

</property> <property>

<name>javax.jdo.option.ConnectionUserName</name>

<value>root</value>

</property> <property>

<name>javax.jdo.option.ConnectionPassword</name>

<value>root</value>

</property

</configuration>

其中需要填写你的数据库用户名和密码以及连接数据库的驱动

(4) 拷贝数据库驱动(点击这里下载)到$HIVE_HOME/lib/下

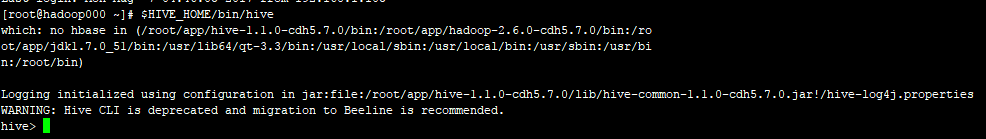

(5) 启动Hive

命令: $HIVE_HOME/bin/hive

没有报错,至此Hive环境搭建完毕

Spark环境搭建(四)-----------数据仓库Hive环境搭建的更多相关文章

- 《OD大数据实战》Hive环境搭建

一.搭建hadoop环境 <OD大数据实战>hadoop伪分布式环境搭建 二.Hive环境搭建 1. 准备安装文件 下载地址: http://archive.cloudera.com/cd ...

- Hadoop环境搭建|第四篇:hive环境搭建

一.环境搭建 注意:hive版本不能太高,否则会出现兼容性问题 1.1.上传hive安装包 创建文件夹用于存放hive文件命令:mkdir hive 1.2.解压hive安装包 命令:tar -zxv ...

- 数据仓库组件:Hive环境搭建和基础用法

本文源码:GitHub || GitEE 一.Hive基础简介 1.基础描述 Hive是基于Hadoop的一个数据仓库工具,用来进行数据提取.转化.加载,是一个可以对Hadoop中的大规模存储的数据进 ...

- Hadoop生态圈-Hive快速入门篇之Hive环境搭建

Hadoop生态圈-Hive快速入门篇之Hive环境搭建 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. 一.数据仓库(理论性知识大多摘自百度百科) 1>.什么是数据仓库 数据 ...

- 基于【CentOS-7+ Ambari 2.7.0 + HDP 3.0】搭建HAWQ数据仓库01 —— 准备环境,搭建本地仓库,安装ambari

一.集群软硬件环境准备: 操作系统: centos 7 x86_64.1804 Ambari版本:2.7.0 HDP版本:3.0.0 HAWQ版本:2.3.05台PC作为工作站: ep-bd01 e ...

- ubantu上搭建hive环境

上次我们在ubantu上安装了hadoop,那我们现在再进一步,开始我们的学习之旅--hive板块吧! 第一步:准备! 软件: I.一个搭建好的hadoop环境 II.hive的bin文件(前往apa ...

- Hive环境搭建和SparkSql整合

一.搭建准备环境 在搭建Hive和SparkSql进行整合之前,首先需要搭建完成HDFS和Spark相关环境 这里使用Hive和Spark进行整合的目的主要是: 1.使用Hive对SparkSql中产 ...

- 大数据学习系列之四 ----- Hadoop+Hive环境搭建图文详解(单机)

引言 在大数据学习系列之一 ----- Hadoop环境搭建(单机) 成功的搭建了Hadoop的环境,在大数据学习系列之二 ----- HBase环境搭建(单机)成功搭建了HBase的环境以及相关使用 ...

- Hive环境搭建

hive 环境搭建需要hadoop的环境.hadoop环境的搭建不在这里赘述.参考:http://www.cnblogs.com/parkin/p/6952370.html 1.准备阶段 hive 官 ...

随机推荐

- WEB-INF 目录

WEB-INF 目录是必须的,其中包括: web.xml 文件,该 Web 基本配置,必须. classes 目录,存放 .class 文件,当然也可以将 .java 文件一并放进去. lib 目录, ...

- js介绍,js三种引入方式,js选择器,js四种调试方式,js操作页面文档DOM(修改文本,修改css样式,修改属性)

js介绍 js运行编写在浏览器上的脚本语言(外挂,具有逻辑性) 脚本语言:运行在浏览器上的独立的代码块(具有逻辑性) 操作BOM 浏览器对象盒子 操作DOM 文本对象 js三种引入方式 (1)行间式: ...

- Aurora的安装和中文配置

转载自: http://blog.csdn.net/wdkirchhoff/article/details/72903885 要用 Aurora 很烦躁. 时不时出问题... 看看以下转载的吧. Au ...

- 【js课设】电子画板01

这学期web开发课的课设选了电子画板课题.(人家本来想做富文本编辑器的嘛然鹅老师在第二版里把这题删掉了。゚ヽ(゚´Д`)ノ゚。) 主要考虑的有[界面美观][画笔类型][画布分层]这三个点了. [界面美 ...

- 大数据基础-2-Hadoop-1环境搭建测试

Hadoop环境搭建测试 1 安装软件 1.1 规划目录 /opt [root@host2 ~]# cd /opt [root@host2 opt]# mkdir java [root@host2 o ...

- Java并发之Thread类的使用

一.线程的几种状态 线程从创建到最终的消亡,要经历若干个状态.一般来说,线程包括以下这几个状态:创建(new).就绪(runnable).运行(running).阻塞(blocked).time wa ...

- Django的项目创建,以及该端口号,语言随地区而变化

注:myway是项目的名称创建项目:cd wwwdjango-admin startproject mywaycd mywaypython manage.py runserver 如果想改Django ...

- 函数的if--while流程控制

一.流程控制---if 1.if条件判断 age=18 hight=1.70 sex="female" is_beautiful=True if sex=="female ...

- 「luogu3313」[SDOI2014] 旅行

题目大意 :有 n 个城市连成一棵树, 每个城市有两个关键字, 一个是该城市的宗教, 另一个是城市的评级;旅行者要在城市间旅行, 他只会在和自己宗教相同的城市留宿;维护四个树上操作 { 1. “CC ...

- SQL join 连接时 条件加在 on后面和 where 的区别

task 是用户任务表,manageuser是用户表,以left join 为参考: 此时主表是task,三条sql语句:注意区别.第一句无筛选条件,第二句筛选条件在on后面,第三句sql的筛选语句放 ...