Scrapy 分布式数据采集方案

运行环境 CentOS7. + Python2. + Scrapy1. + MongoDB3. + BeautifulSoup4.

编程工具 PyCharm + Robomongo + Xshell 请确保你的 python版本为2..5以上 版本

强烈推荐直接【翻 墙 安 装】,简单轻松

yum install gcc libffi-devel python-devel openssl-devel

pip install scrapy 如果提示以下错误

AttributeError: 'module' object has no attribute 'OP_NO_TLSv1_1'

说明你的 Twisted 版本过高,请执行

pip install Twisted==16.4. 然后再安装以下内容

pip install scrapyd

pip install scrapy-mongodb

pip install beautifulsoup4

pip install scrapy-redis

pip install pymongo

pip install scrapyd-client

pip install Pillow

pip install python-scrapyd-api # windows下安装方法也是一样的,推荐顺手安装一下windows版本,这样在 IDE(PyCharm)下能够得到Scrapy的代码提示,而且不会报 类不存在 的错误 然后执行

scrapy startproject fusnion

就可以创建一个名为 funsion 的项目 附录A:Scrapy Shell 调试

Linux 命令行下输入(以本站点为例)

scrapy shell 'http://www.cnblogs.com/funsion/'

进入交互式shell,输入以下内容

>>> from bs4 import BeautifulSoup

>>> soup = BeautifulSoup(response.body, 'html.parser')

>>> print soup.title

如果能输出 <title>Funsion Wu - 博客园</title> 则代表成功 附录B:参考文档

Scrapy 中文文档 http://scrapy-chs.readthedocs.org/zh_CN/latest/index.html

参考文档 https://piaosanlang.gitbooks.io/spiders/01day/README1.html

Scrapyd 文档 http://scrapyd.readthedocs.io/en/stable/

BeautifulSoup 中文手册 http://www.crummy.com/software/BeautifulSoup/bs4/doc/index.zh.html

Scrapy-Redis 文档 http://scrapy-redis.readthedocs.io/en/stable/

Scrapy-Mongodb 文档 https://github.com/sebdah/scrapy-mongodb

Pillow 文档 http://pillow.readthedocs.io/en/latest/index.html

Python-Scrapyd-Api 文档 http://python-scrapyd-api.readthedocs.io/en/latest/

参考文档 http://www.pastandnow.com/2015/11/16/Use-Scrapyd-client-Deploy-Spider/ 附录C:mongodb安装方法

下载文件 https://fastdl.mongodb.org/linux/mongodb-linux-x86_64-rhel70-3.4.6.tgz

tar zxf mongodb-linux-x86_64-rhel70-3.4..tgz

cd mongodb-linux-x86_64-rhel70-3.4./

mkdir -p /data/{mongodb_data,mongodb_log}

ln -s /usr/local/src/mongodb-linux-x86_64-rhel70-3.4./bin/mongo /usr/local/bin/

nohup /usr/local/src/mongodb-linux-x86_64-rhel70-3.4./bin/mongod --dbpath=/data/mongodb_data --logpath=/data/mongodb_log/mongodb.log --logappend --fork > /dev/null >& &

编辑/etc/rc.local,加入下述代码然后再保存即可。

nohup /usr/local/src/mongodb-linux-x86_64-rhel70-3.4./bin/mongod --dbpath=/data/mongodb_data --logpath=/data/mongodb_log/mongodb.log --logappend --fork > /dev/null >& & 附录D:Scrapy代理解决方案

https://github.com/TeamHG-Memex/scrapy-rotating-proxies

https://github.com/luyishisi/Anti-Anti-Spider (防采集策略)

http://www.cnblogs.com/kylinlin/p/5242266.html (Scrapy+Tor防采集) 附录E:Scrapy-Demo地址

https://gitee.com/funsion_wu/demo/tree/master/scrapy

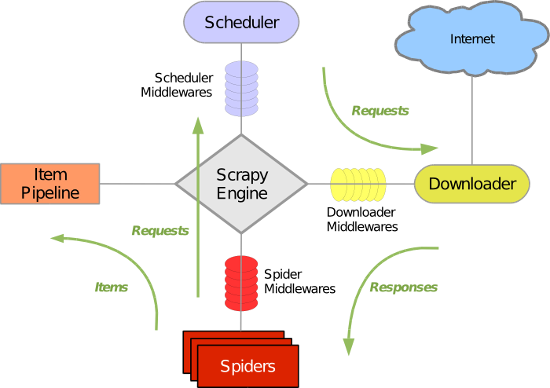

Scrapy架构图

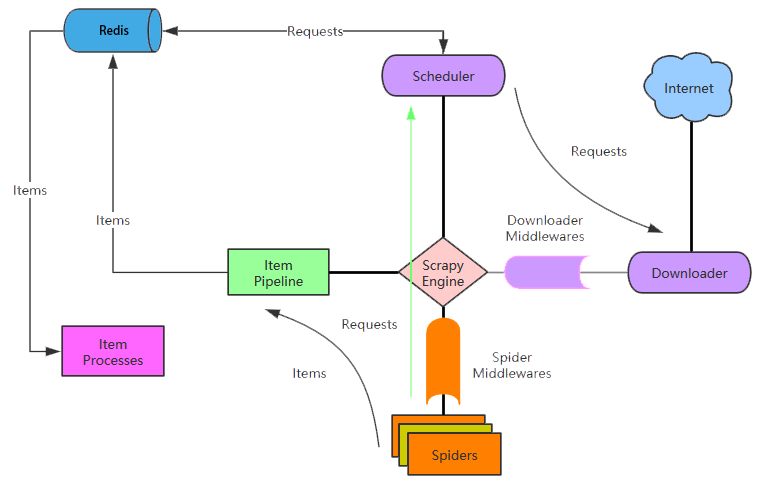

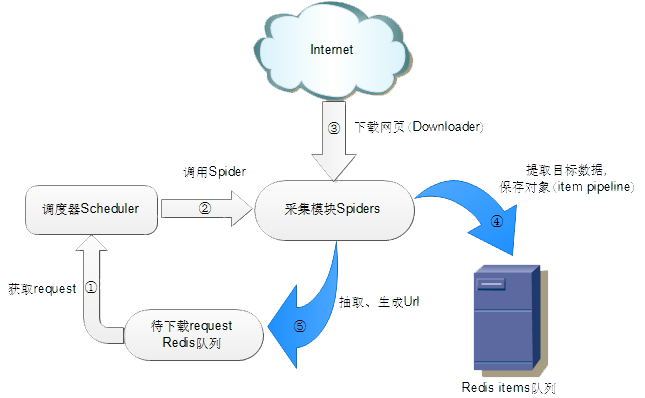

Scrapy-Redis架构图

Scrapy 分布式数据采集方案的更多相关文章

- Memcached常规应用与分布式部署方案

1.Memcached常规应用 $mc = new Memcache(); $mc->conncet('127.0.0.1', 11211); $sql = sprintf("SELE ...

- Window Redis分布式部署方案 java

Redis分布式部署方案 Window 1. 基本介绍 首先redis官方是没有提供window下的版本, 是window配合发布的.因现阶段项目需求,所以研究部署的是window版本的,其实都 ...

- Python爬虫从入门到放弃(二十)之 Scrapy分布式原理

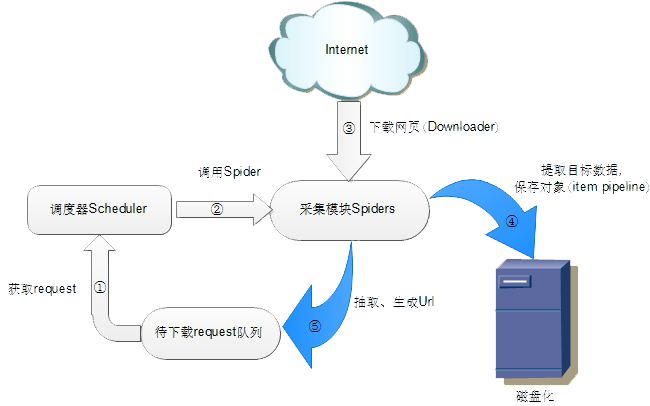

关于Scrapy工作流程回顾 Scrapy单机架构 上图的架构其实就是一种单机架构,只在本机维护一个爬取队列,Scheduler进行调度,而要实现多态服务器共同爬取数据关键就是共享爬取队列. 分布式架 ...

- scrapy分布式的几个重点问题

我们之前的爬虫都是在同一台机器运行的,叫做单机爬虫.scrapy的经典架构图也是描述的单机架构.那么分布式爬虫架构实际上就是:由一台主机维护所有的爬取队列,每台从机的sheduler共享该队列,协同存 ...

- Python爬虫【五】Scrapy分布式原理笔记

Scrapy单机架构 在这里scrapy的核心是scrapy引擎,它通过里面的一个调度器来调度一个request的队列,将request发给downloader,然后来执行request请求 但是这些 ...

- 第三百五十六节,Python分布式爬虫打造搜索引擎Scrapy精讲—scrapy分布式爬虫要点

第三百五十六节,Python分布式爬虫打造搜索引擎Scrapy精讲—scrapy分布式爬虫要点 1.分布式爬虫原理 2.分布式爬虫优点 3.分布式爬虫需要解决的问题

- 基于Solr和Zookeeper的分布式搜索方案的配置

1.1 什么是SolrCloud SolrCloud(solr 云)是Solr提供的分布式搜索方案,当你需要大规模,容错,分布式索引和检索能力时使用 SolrCloud.当一个系统的索引数据量少的时候 ...

- ebay分布式事务方案中文版

http://cailin.iteye.com/blog/2268428 不使用分布式事务实现目的 -- ibm https://www.ibm.com/developerworks/cn/clou ...

- Python 爬虫之 Scrapy 分布式原理以及部署

Scrapy分布式原理 关于Scrapy工作流程 Scrapy单机架构 上图的架构其实就是一种单机架构,只在本机维护一个爬取队列,Scheduler进行调度,而要实现多态服务器共同爬取数据关键就是共享 ...

随机推荐

- CSS 中 BEM命名方式

BEM的意思就是块(block).元素(element).修饰符(modifier),是一种CSS Class 命名方法. 类似于: .block{} .block__element{} .block ...

- Quick UDP Internet Connections 让互联网更快的协议,QUIC在腾讯的实践及性能优化

https://mp.weixin.qq.com/s/44ysXnVBUq_nJByMyX9n5A 让互联网更快:通往QUIC之路 原创: 史天 翻译 云技术实践 8月15日 QUIC(Quick U ...

- 把www.domain.com均衡到本机不同的端口 反向代理 隐藏端口 Nginx做非80端口转发 搭建nginx反向代理用做内网域名转发 location 规则

负载均衡-Nginx中文文档 http://www.nginx.cn/doc/example/loadbanlance.html 负载均衡 一个简单的负载均衡的示例,把www.domain.com均衡 ...

- app后端设计(0)--总目录(转)

原文:http://blog.csdn.net/newjueqi/article/details/19003775 做了接近两年app相关的系统架构,api设计,先后在两个创业公司中工作,经历过手机网 ...

- zabbix详解(一)

zabbix简介 zabbix是一个基于WEB界面的提供分布式系统监视以及网络监视功能的企业级的开源解决方案. zabbix能监视各种网络参数,保证服务器系统的安全运营:并提供柔软的通知机制以让系统管 ...

- 使用php来操作EXCEL文件

最近,刚过完年,部门想要统计一下去年部门的各种各样的一些数据,因此有一些EXCEL表格中的数据统计难以实现,需要借助程序来完成复杂的数据统计,因此自己最近也了解 了一下关于php操作excel的一些东 ...

- PAT 1120 Friend Numbers[简单]

1120 Friend Numbers (20 分) Two integers are called "friend numbers" if they share the same ...

- MongoDB的分布式部署

一.分片的概念 分片(sharding)是指根据片键,将数据进行拆分,使其落在不同的机器上的过程.如此一来,不需要功能,配置等强大的机器,也能储存大数据量,处理更高的负载. 二.分片的原理和思想 Mo ...

- PHP压缩与解压Zip(PHPZip类)

<?php class PHPZip { private $ctrl_dir = array(); private $datasec ...

- Castle连接多数据库配置

ActiveRecord 的多数据库配置基本沿袭了 NHibernate 的思想,只不过在配置文件结构上作了些调整.1. 采用继承方式,归纳使用同一数据库的类型.比如 A.B.C.D.E 中 A.B连 ...