python 使用for循环简单爬取图片(1)

现在的网站大多做了反爬处理,找一个能爬的网站还真不容易。

下面开始一步步实现:

1.简单爬录目图片

import urllib.request

import re def gethtml(url):

page=urllib.request.urlopen(url)

html=page.read().decode('utf-8') return html def getimg(html): a=re.compile(r'src="(.+?\.jpg)"')

tp=a.findall(html)

x=0 for img in tp:

urllib.request.urlretrieve(img,'d:/tupian/%s.jpg' % x)

x+=1

url="http://www.meituba.com/yijing/28426.html" html=gethtml(url)

getimg(html)

2.爬图集

这里仅仅是爬取了录目上的图片,还没有涉及到for循环遍历,针对我们的目标,我们要尽可能仔细观察它的规律。

这里我们随便点进去一个图片集,如图:

打开后看到该图片集一共是6张,

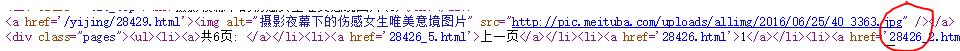

分析一下它的url 和页面的源代码:

1,url分析

这里就不贴图片了,我直接说吧

第一张图片(也就是第一页)的url=“http://www.meituba.com/yijing/28426.html”

第二张图片的url=“http://www.meituba.com/yijing/28426_2.html”

。。。。。

第六页图片的url=“http://www.meituba.com/yijing/28426_6.html”

我们可以发现规律,这里直接改一下'_'后面的数字,这里就需要for循环了

2,源代码的规律:

这里我们用正则表达式就应该稍作修改:

应该这样写:r'src="(.+?\.jpg)" /'

好了,下面就开始代码实现:

import urllib.request

import re def gethtml(url):

page=urllib.request.urlopen(url)

html=page.read().decode('utf-8') return html def getimg(html): a=re.compile(r'src="(.+?\.jpg)" /')

b=a.findall(html) for img in b:

urllib.request.urlretrieve(img,'d:/tupian/%s.jpg' % x) x=0 for i in range(1,7): if i==1:

url="http://www.meituba.com/yijing/28426.html"

else:

url=("http://www.meituba.com/yijing/28426_%s.html" % i) html=gethtml(url) x+=1 getimg(html)

1.这里有很多值得我们研究的问题比如第一页的url跟其他页的url有出入,所以我们应该想办法把第一页的图片也加进去,大家可以用if函数实现

看代码吧

2.关于urlretrieve()函数,在保存下载路径的时候要写出全路径,这里的

urllib.request.urlretrieve(img,'d:/tupian/%s.jpg' % x) 就应该做出变化了,我们可以理解一下,在第一个代码中,

我们将 x 这个函数直接定义在函数中,但那是在爬取一个网页下的所有图片,可我们的第二个代码是爬取每个页面下的一张图片,如果我们还是将 x 定义在函数中,那么就会出现一个问题,在文件夹中只会爬到一张图片

大家可以想想原因,

其实当我们用for循环遍历所有url时,getimg()函数是被一遍遍调用的,当第一个url下的图片被爬下来后,它的名称是 0.jpg 那么下一次下一个页面爬到的图片也将被命名为0.jpg

这样系统就只会默认的保存一张图片,所以我们在命名的时候应该注意这一点,

只需要将 x 的初始值定义在for循环的外面就可以了

参考:https://my.oschina.net/talentwang/blog/48524

3.一个图集的图片实在不能满足我们。

一般来说,我们可以通过观察页面url的规律来推出下一个url的地址,可我接下来观察了几个连续图集中的url的信息

28426

28429

28435

28438

28443

28445

28456

28461

本人数学不好,实在发现不了规律,其实在每个图集的下方都会给下一个图集的链接,这就给我们提供了思路,大家如果在爬取某个页面时遇到这种问题,不妨试一下

好了开始我们的代码实现了:下面仅仅是获取下个图集的url地址的代码,其余的下次补全:

import urllib.request

import re

from bs4 import BeautifulSoup def gethtml(url):

page=urllib.request.urlopen(url)

html=page.read().decode('utf-8')

soup=BeautifulSoup(html,'html.parser')

return soup def getimg(html): b=html.find_all("div",{"class":"descriptionBox"})

href=re.compile(r'<b>下一篇:</b><a href="(.+?\.html)">')

c=href.findall(str(b))

print(c)

print(type(c))

e="http://www.meituba.com"+('').join(c)

print(e)

d=urllib.request.urlopen(e)

f=d.read().decode('utf-8')

print(f)

url="http://www.meituba.com/yijing/28426.html"

soup=gethtml(url)

getimg(soup)

运行可以看到它已经可以成功的打印出下一个图集的html页面源代码。

之后再把所有代码总结一下,

今天就写到这,(明天继续)

python 使用for循环简单爬取图片(1)的更多相关文章

- 孤荷凌寒自学python第八十二天学习爬取图片2

孤荷凌寒自学python第八十二天学习爬取图片2 (完整学习过程屏幕记录视频地址在文末) 今天在昨天基本尝试成功的基础上,继续完善了文字和图片的同时爬取并存放在word文档中. 一.我准备爬取一个有文 ...

- 使用Scrapy爬虫框架简单爬取图片并保存本地(妹子图)

初学Scrapy,实现爬取网络图片并保存本地功能 一.先看最终效果 保存在F:\pics文件夹下 二.安装scrapy 1.python的安装就不说了,我用的python2.7,执行命令pip ins ...

- [python学习] 简单爬取图片站点图库中图片

近期老师让学习Python与维基百科相关的知识,无聊之中用Python简单做了个爬取"游讯网图库"中的图片,由于每次点击下一张感觉很浪费时间又繁琐.主要分享的是怎样爬取HTML的知 ...

- 简单的python爬虫教程:批量爬取图片

python编程语言,可以说是新型语言,也是这两年来发展比较快的一种语言,而且不管是少儿还是成年人都可以学习这个新型编程语言,今天南京小码王python培训机构变为大家分享了一个python爬虫教程. ...

- Python爬虫--简单爬取图片

今天晚上弄了一个简单的爬虫,可以爬取网页的图片,现在现在做一下准备工作. 需要的库:urllib 和 re urllib库可以理解为是一个url下载器,其中有三个重要的方法 urllib.urlope ...

- python网络爬虫之四简单爬取豆瓣图书项目

一.爬虫项目一: 豆瓣图书网站图书的爬取: import requests import re content = requests.get("https://book.douban.com ...

- [python爬虫] 爬取图片无法打开或已损坏的简单探讨

本文主要针对python使用urlretrieve或urlopen下载百度.搜狗.googto(谷歌镜像)等图片时,出现"无法打开图片或已损坏"的问题,作者对它进行简单的探讨.同时 ...

- python如何使用request爬取图片

下面是代码的简单实现,变量名和方法都是跑起来就行,没有整理,有需要的可以自己整理下: image2local: import requests import time from lxml import ...

- python +requests 爬虫-爬取图片并进行下载到本地

因为写12306抢票脚本需要用到爬虫技术下载验证码并进行定位点击所以这章主要讲解,爬虫,从网页上爬取图片并进行下载到本地 爬虫实现方式: 1.首先选取你需要的抓取的URL:2.将这些URL放入待抓 ...

随机推荐

- C# 递归与非递归算法与数学公式

1.递归 递归:程序调用自身的编程技巧称为递归(recursion). 优点是:代码简洁,易于理解. 缺点是:运行效率较低. 递归思想:把问题分解成规模更小,但和原问题有着相同解法的问题. 1)下面是 ...

- 爬取博主的所有文章并保存为PDF文件

继续改进上一个项目,上次我们爬取了所有文章,但是保存为TXT文件,查看不方便,而且还无法保存文章中的代码和图片. 所以这次保存为PDF文件,方便查看. 需要的工具: 1.wkhtmltopdf安装包, ...

- Pandas的append方法

相当于添加一行记录,这个方法也是比较管用的: # 测试pandas.append方法 def use_pd_append(): df = pd.DataFrame([[1, 2], [3, 4]], ...

- bit 32/64

[asm]64位编译32位汇编需要注意的 汇编语言在32位和64位下有区别 32位的汇编在代码前增加.code32 as可以通过--32指定生成32位汇编 在64位系统下ld链接生成3 ...

- ECharts修改坐标轴,坐标轴字体,坐标轴网格样式以及控制坐标轴是否显示

转自:http://blog.csdn.net/kirinlau/article/details/72876689 首先要将一个图表显示在前端页面上: var myChart = echarts.in ...

- win7系统注册表的权限修改

重装win7系统后,安装软件时提示注册表项拒绝访问 解决方法: 输入“Gpedit.msc”后回车,打开“组策略”.然后,依次展开“用户配置→管理模板→系统”,双击右侧窗口中的“阻止访问注册表编辑工具 ...

- LoadRunner-关联相关(解决方法二)

用例为:添加通知,下发给用户. 录制好脚本,replay时脚本未报错,但实际登录网页操作未完成(只添加了通知,未下发给用户). LR自动关联没有内容,手动查看服务器response,在保存时有一个id ...

- 1128 - Greatest Parent---LightOj(LCA+离线算法)

题目链接:http://lightoj.com/volume_showproblem.php?problem=1128 给你一颗树,树的每个节点都有一个权值,树根是节点0,权值为1,树中每个节点的权值 ...

- Charles maplocal 时中文显示乱码问题

用Charles对request进行Map Local后,app上看返回的中文是乱码? 是Map Local的文件编码有问题?是Charles设置有问题?是电脑环境有问题?哈哈,都不是 你是Andro ...

- 学习Linux二(创建、删除文件和文件夹命令)

转自:http://www.cnblogs.com/zf2011/archive/2011/05/17/2049155.html 今天学习了几个命令,是创建.删除文件和文件夹的,在linux里,文件 ...