kubernets监控

[root@cicd kubernetes]# ls

bash ca harbor-offline-installer-v1.4.0.tgz image.tar.gz kube-yunwei-.tar.gz sock-shop

bin ca.tar.gz image k8s197.tar.gz scope.yaml

2)创建weave名称空间

[root@cicd kubernetes]# kubectl create namespace weave

[root@cicd kubernetes]# kubectl get pod -n weave

NAME READY STATUS RESTARTS AGE

weave-scope-agent-4xw7b / Running 2h

weave-scope-agent-cll6f / Running 2h

weave-scope-agent-nfl8c / Running 2h

weave-scope-app-5969c9bc78-fmm4s / Running 2h

[root@cicd kubernetes]# kubectl get svc -n weave

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

weave-scope-app NodePort 10.68.210.240 <none> :/TCP 2h

注意port端口号,用来浏览器访问。

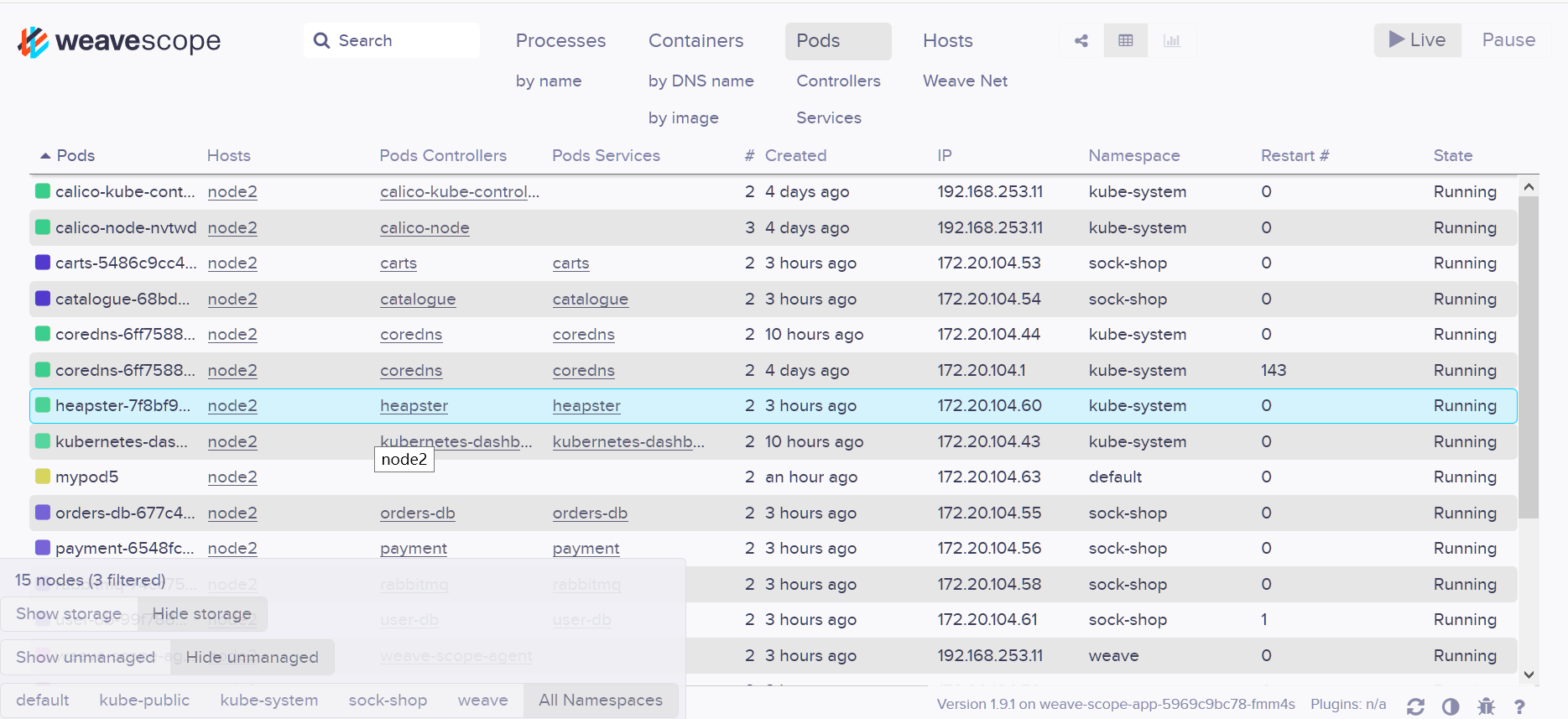

- DaemonSet weave-scope-agent,集群每个节点上都会运行的 scope agent 程序,负责收集数据。

- Deployment weave-scope-app,scope 应用,从 agent 获取数据,通过 Web UI 展示并与用户交互。

- Service weave-scope-app,默认是 ClusterIP 类型,为了方便已通过 kubectl edit 修改为 NodePort。

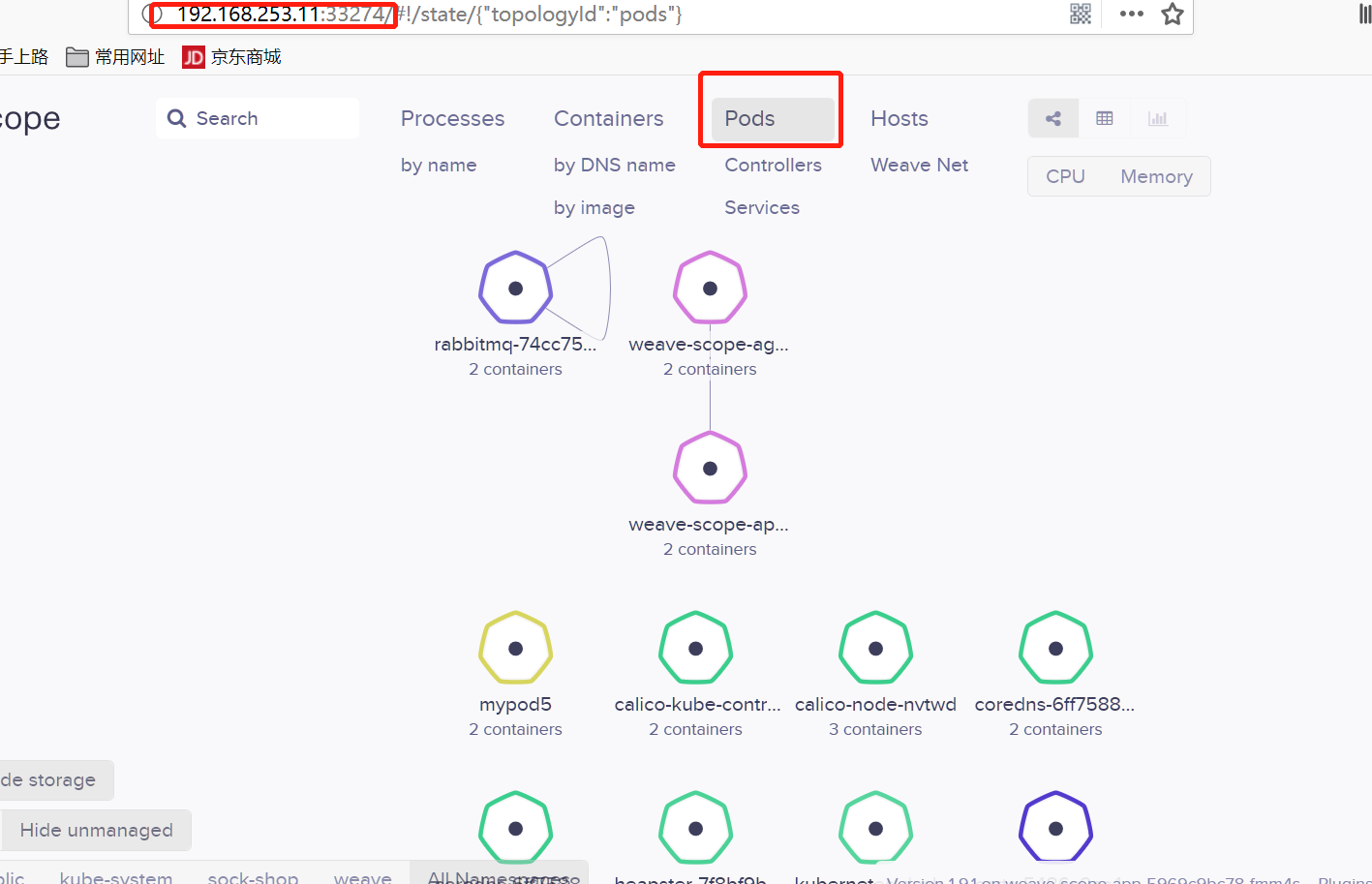

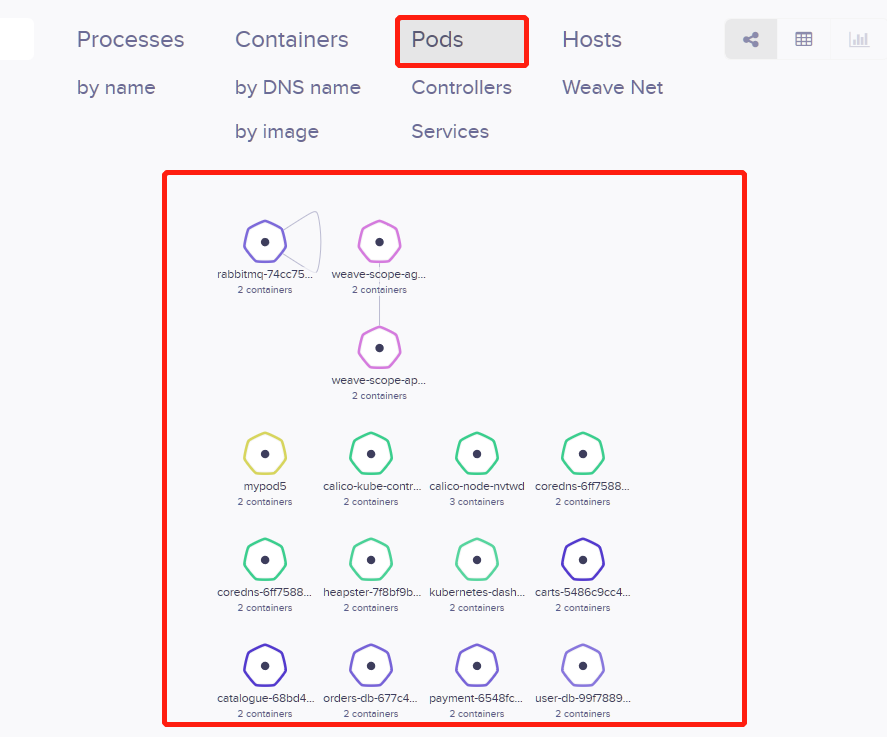

拓扑结构

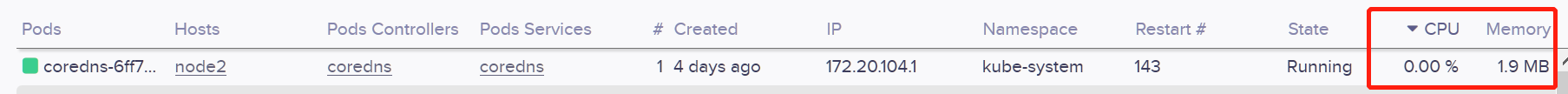

实时资源监控

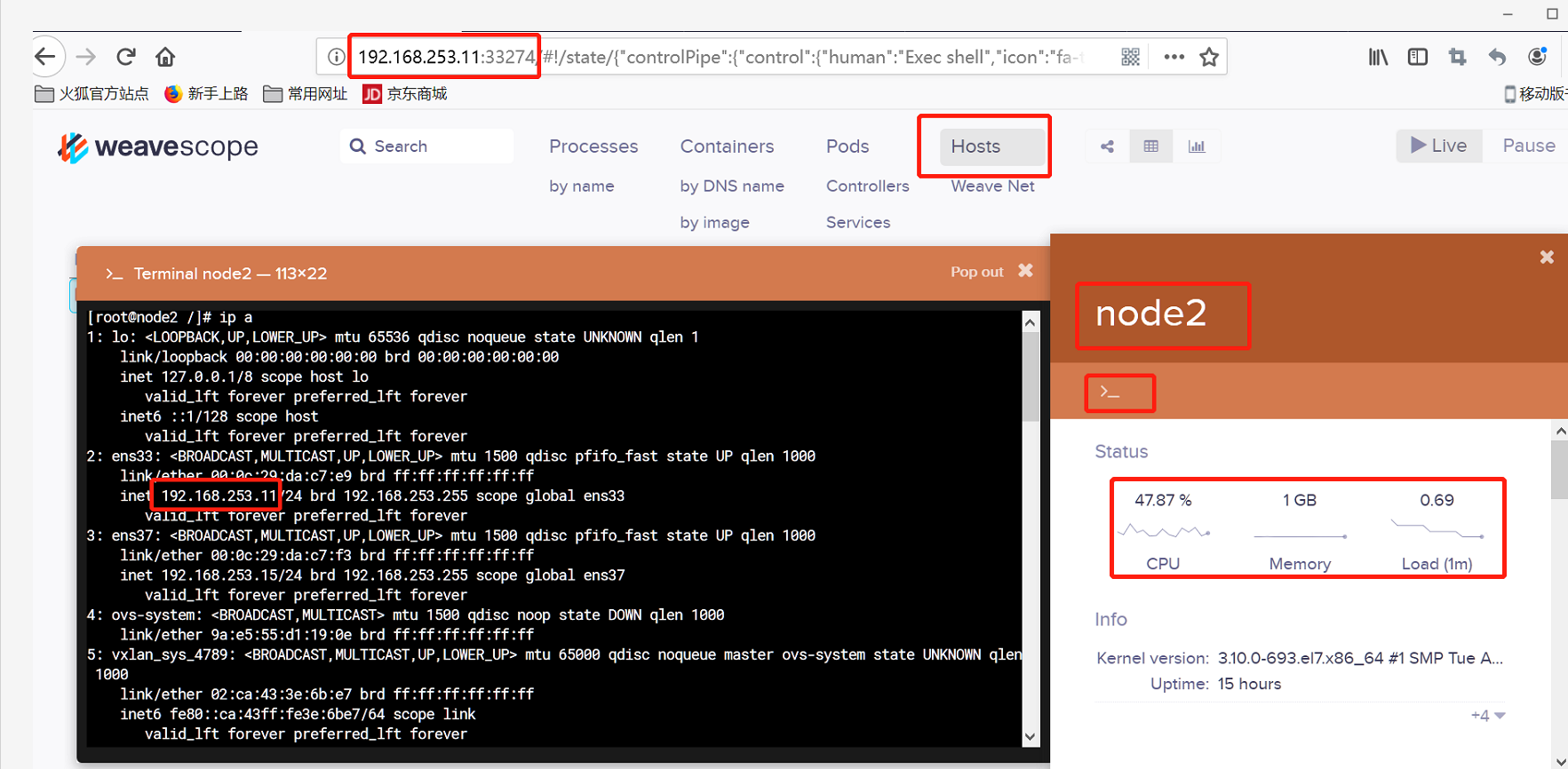

在线操作

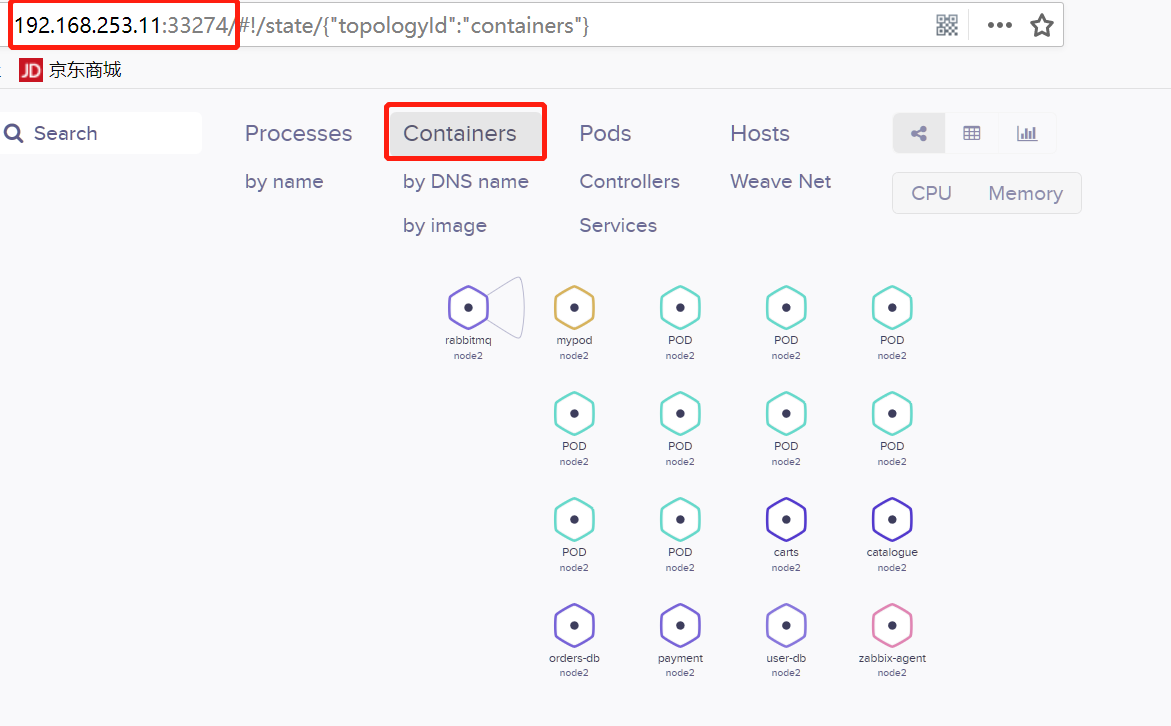

PROCESSES:容器中运行的进程。

在容器信息的上面还有一排操作按钮。

上图:左边框为atach按钮,右边框为exec按钮。一个是继续进程,一个是重开终端。

强大的搜索功能

部署步骤:

[root@cicd kubernetes]# docker ps -a

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

415b685b8ace 1acb4fd5df5b "/bin/sh" days ago Up days keen_noyce

22c236dd2666 1acb4fd5df5b "/bin/sh" days ago Up days eloquent_bhabha

[root@cicd kubernetes]# docker exec -it 415b685b8ace /bin/sh

[root@cicd kubernetes]# docker exec -it 415b685b8ace /bin/sh

/ # cd /etc/ansible//etc/ansible # ls

.prepare.yml .docker.yml .kube-node.yml .clean.yml bin hosts roles

.etcd.yml .kube-master.yml .network.yml ansible.cfg example manifests tools

/etc/ansible # cd manifests/

/etc/ansible/manifests # ls

coredns dashboard efk heapster ingress kubedns

/etc/ansible/manifests # cd heapster/

/etc/ansible/manifests/heapster # ls

grafana.yaml heapster.yaml influxdb-v1.1.1 influxdb-with-pv influxdb.yaml

/etc/ansible/manifests/heapster # kubectl apply -f .

/etc/ansible/manifests/heapster # kubectl get pod -n kube-system -o wide

NAME READY STATUS RESTARTS AGE IP NODE

calico-kube-controllers-754c88ccc8-fm9kn / Running 4d 192.168.253.11 192.168.253.11

calico-node-62wzk / Running 4d 192.168.253.14 192.168.253.14

calico-node-lszzj / Running 4d 192.168.253.10 192.168.253.10

calico-node-nvtwd / Running 4d 192.168.253.11 192.168.253.11

coredns-6ff7588dc6-62nnv / Running 9h 172.20.104.44 192.168.253.11

coredns-6ff7588dc6-f6d4z / Running 4d 172.20.104.1 192.168.253.11

heapster-7f8bf9bc46-l8qv5 / Running 3h 172.20.104.60 192.168.253.11

kubernetes-dashboard-545b66db97-mmt6p / Running 9h 172.20.104.43 192.168.253.11

monitoring-grafana-64747d765f-rb59j / Running 3h 172.20.135.23 192.168.253.10

monitoring-influxdb-565ff5f9b6-m99z8 / Running 3h 172.20.135.21 192.168.253.10

/etc/ansible/manifests/heapster # kubectl get svc -n kube-system -o wide

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE SELECTOR

coredns ClusterIP 10.68.0.2 <none> /UDP,/TCP 4d k8s-app=coredns

heapster ClusterIP 10.68.198.107 <none> /TCP 3h k8s-app=heapster

kubernetes-dashboard NodePort 10.68.6.114 <none> :/TCP 4d k8s-app=kubernetes-dashboard

monitoring-grafana ClusterIP 10.68.59.90 <none> /TCP 3h k8s-app=grafana

monitoring-influxdb ClusterIP 10.68.11.36 <none> /TCP 3h k8s-app=influxdb

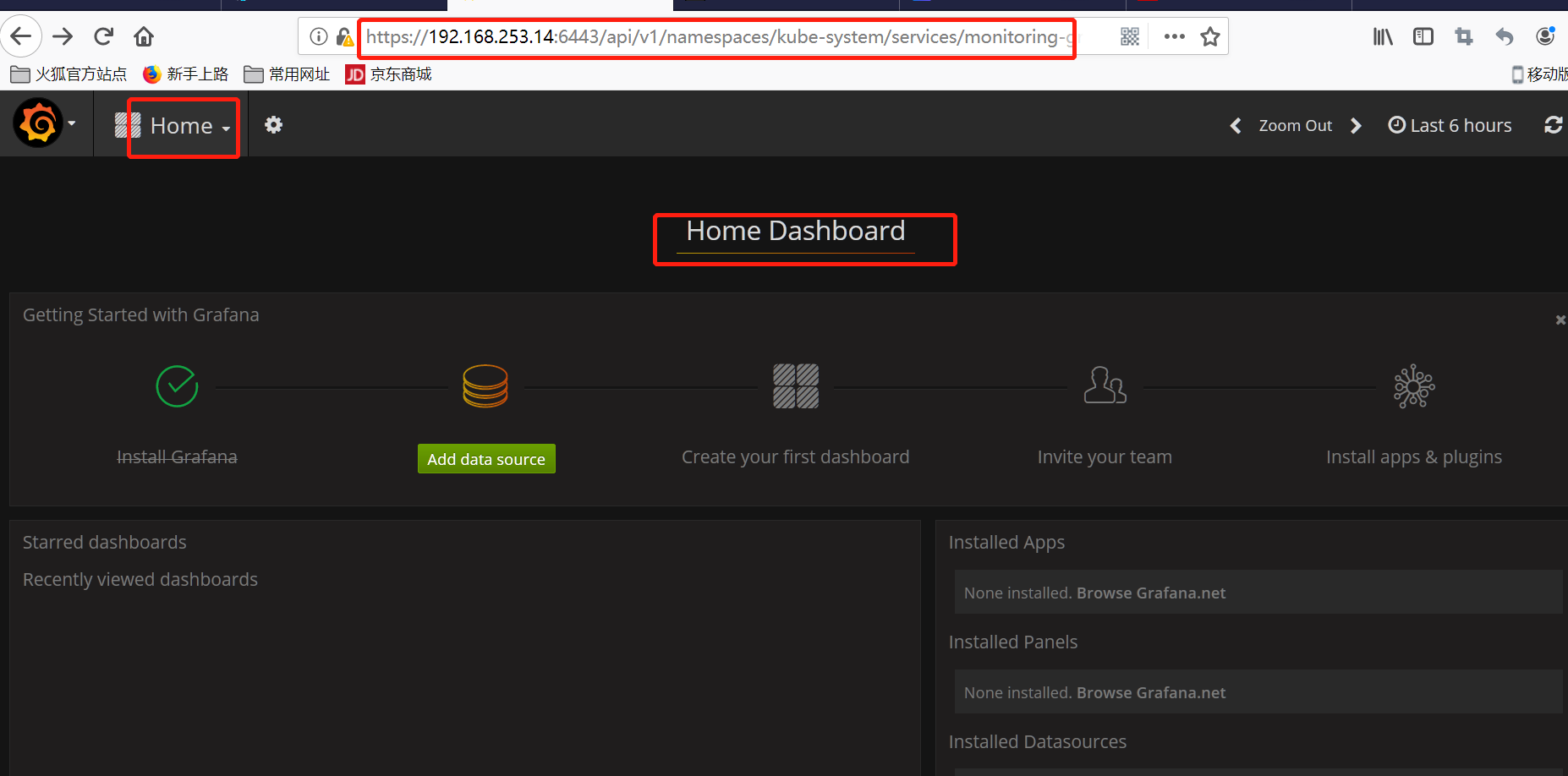

/etc/ansible/manifests/heapster # kubectl cluster-info

Kubernetes master is running at https://192.168.253.14:6443

CoreDNS is running at https://192.168.253.14:6443/api/v1/namespaces/kube-system/services/coredns:dns/proxy

kubernetes-dashboard is running at https://192.168.253.14:6443/api/v1/namespaces/kube-system/services/https:kubernetes-dashboard:/proxy

monitoring-grafana is running at https://192.168.253.14:6443/api/v1/namespaces/kube-system/services/monitoring-grafana/proxy

并打开浏览器访问。

kubernets监控的更多相关文章

- 详解k8s一个完整的监控方案(Heapster+Grafana+InfluxDB) - kubernetes

1.浅析整个监控流程 heapster以k8s内置的cAdvisor作为数据源收集集群信息,并汇总出有价值的性能数据(Metrics):cpu.内存.网络流量等,然后将这些数据输出到外部存储,如Inf ...

- Prometheus监控⼊⻔简介

文档目录: • prometheus是什么?• prometheus能为我们带来些什么• prometheus对于运维的要求• prometheus多图效果展示 1) Prometheus是什么pro ...

- 详解k8s原生的集群监控方案(Heapster+InfluxDB+Grafana) - kubernetes

1.浅析监控方案 heapster是一个监控计算.存储.网络等集群资源的工具,以k8s内置的cAdvisor作为数据源收集集群信息,并汇总出有价值的性能数据(Metrics):cpu.内存.netwo ...

- 介绍Kubernetes监控Heapster

什么是Heapster? Heapster是容器集群监控和性能分析工具,天然的支持Kubernetes和CoreOS,Kubernetes有个出名的监控agent—cAdvisor.在每个kubern ...

- kubernets基础

1.定义和功能. 1.1定义:kubernets解释为舵手或者飞行员,以Borg为主衍生出. 1.2功能:自动装箱,自我修复,水平扩展,服务发现和负载均衡,自动发布和回滚. 密钥和配置管理,存储编排, ...

- Kubernets 第一讲 初探

1.kubernets的工作流程 (1)开始部署新的应用程序,使用kubectl客户端工具和一个准备好的包含应用程序的Deployment的yaml文件:用户通过kubectl命令将文件的内容发送给A ...

- Kubernetes监控:部署Heapster、InfluxDB和Grafana

本节内容: Kubernetes 监控方案 Heapster.InfluxDB和Grafana介绍 安装配置Heapster.InfluxDB和Grafana 访问 grafana 访问 influx ...

- 【01】Kubernets:捋一捋概念性东西

写在前面的话 docker 先告一段,现在开始进入 Kubernets(K8S) 的学习阶段,在学习过程中,可结合之前学的 docker swarm 比对着理解. 啥是 K8S 先来看一下两个 log ...

- kubernets之机理概览

一 了解kubernets的运行机理 1.1 了解架构 众所周知,kubernets的组成由2个部分组成 kubernets 平面 node节点 (工作节点) 控制平面的组成 etcd 分布 ...

随机推荐

- 用 C++ 模板元编程实现有限的静态 introspection

C++ 中的奇技淫巧大部分来源于模板技术,尤其是模版元编程技术(Template Meta-Programming, TMP).TMP 通过将一部分计算任务放在编译时完成,不仅提高了程序的性能,还能让 ...

- inux下:热插拔和模块是什么

一.何为模块? 文件系统.设备驱动程序.网络协议都可以理解为模块.模块本质也是普通的软件系统. 二.热插拔 硬件层面:只在不断电.不关闭系统的情况下增加或者删除对应部件,比如电源.硬盘.一些高端设备硬 ...

- 015-Zabbix自动发现和自动注册

前言 对于监控服务器越来越多的情况,如果还单独一个一个添加,那效率也太低,因此就要实现批量添加监控服务器的操作,Zabbix提供两种批量自动监控的方式: 自动发现:由服务端主动发起,Zabbix ...

- 用PS修改PNG格式图标的颜色

需求:将黑色的PNG格式图标,更改为其它颜色 原始图标: 原始图标 - 黑色 方法1: 图层样式 -> 颜色叠加 选择颜色叠加 选择想要的颜色 方法2: 更换颜色 一 ...

- 用Maven搭建简单的SpringMVC框架

本文会详细阐述如何用Maven搭建一个简单的SpringMVC框架 这里就不介绍SpringMVC框架了,咱们直接来搭建 第一步 创建一个Maven的web项目 这里有一个简单的方法 new一个Ma ...

- 【HDU5289】Assignment

题目大意:给定一个长度为 N 的序列,求序列中最大值和最小值相差小于 K 的连续段的个数. 题解: 最大值和最小值相差不超过 K 是一个在值域角度的限制,应考虑采用平衡树或权值...数据结构进行维护. ...

- Python之面向对象之初识面向对象

初始面向对象 一.面向过程:面向过程的程序设计的核心是过程(流水线式思维),过程即解决问题的步骤,面向过程的设计就好比精心设计好一条流水线,考虑周全什么时候处理什么东西. 优点:极大地降低了写成学的复 ...

- 微信小程序-饮食日志_开发记录03

这段时间主要是收尾阶段. 美化界面,排版分部等. 并进行上传,审核. 环境部署一直出现问题,所以测试版食物查找查找不到. 主要问题是:https://的网页证书没有通过审核. 所以现在推行开发,调试版 ...

- .net reactor 加密混淆使用办法

https://www.cnblogs.com/bile/p/10250888.html 概述:安装了.net reactor之后,可以在安装目录下找到帮助文档REACTOR_HELP.chm,目前没 ...

- js 获取dom 为null 测试

<!DOCTYPE html> <html> <head> </head> <body> <h1> 这是H1 </h1&g ...