Spark&Hive结合起来

1.spark与Hive结合起来

前提:当你spark的版本是1.6.1的时候,你的Hive版本要1.2.1,用别的版本会有问题

我们在做的时候,Hive的版本很简单,我们只需要解压缩,告诉他Hive的源数据在哪里即可

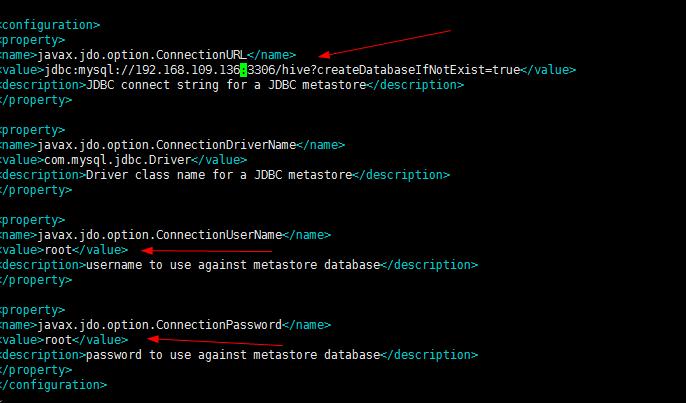

1.首先我们进入/conf/hive-site.xml文件,进行修改jdbc的配置

则此时这个IP要改为only的vm1下的那个IP,不能改为自己无线网络的IP

2.进入bin:./bin/hive

执行成功,会自动创建hive这个库

hive中创建person表

切记:在此之前,由于我们的mysql的字符集编码是utf-8,则我们要是用hive,则就要使用latin1

alter databases hive character set latin1

3.建表

create table person(id int,name string,age int) row format delimited fields terminated by ","

4.从hdfs导入数据

load data inpath "hdfs://192.168.109.136:9000/person/person.txt" into table person

此时上面的操作报

Please check that values for params "default.name" and "hive.metastore.warehouse.dir" do

not conf 是由于namenode的不一致

此时修改为weekday01正确

load data inpath "hdfs://weekday01:9000/person/person.txt" into table person

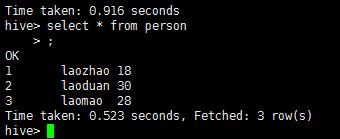

select * from person

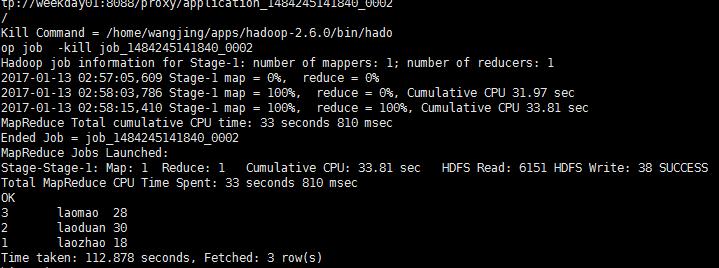

select * from person order by id desc此时这个就会调用集群上的mapReduce

不过这个样子有点慢,我们可以使用spark来进行计算

Spark&Hive结合起来的更多相关文章

- Spark(Hive) SQL中UDF的使用(Python)

相对于使用MapReduce或者Spark Application的方式进行数据分析,使用Hive SQL或Spark SQL能为我们省去不少的代码工作量,而Hive SQL或Spark SQL本身内 ...

- Spark(Hive) SQL数据类型使用详解(Python)

Spark SQL使用时需要有若干“表”的存在,这些“表”可以来自于Hive,也可以来自“临时表”.如果“表”来自于Hive,它的模式(列名.列类型等)在创建时已经确定,一般情况下我们直接通过Spar ...

- [Spark][Hive][Python][SQL]Spark 读取Hive表的小例子

[Spark][Hive][Python][SQL]Spark 读取Hive表的小例子$ cat customers.txt 1 Ali us 2 Bsb ca 3 Carls mx $ hive h ...

- [Spark][Hive]Hive的命令行客户端启动:

[Spark][Hive]Hive的命令行客户端启动: [training@localhost Desktop]$ chkconfig | grep hive hive-metastore 0:off ...

- Spark记录-源码编译spark2.2.0(结合Hive on Spark/Hive on MR2/Spark on Yarn)

#spark2.2.0源码编译 #组件:mvn-3.3.9 jdk-1.8 #wget http://mirror.bit.edu.cn/apache/spark/spark-2.2.0/spark- ...

- Spark(Hive) SQL中UDF的使用(Python)【转】

相对于使用MapReduce或者Spark Application的方式进行数据分析,使用Hive SQL或Spark SQL能为我们省去不少的代码工作量,而Hive SQL或Spark SQL本身内 ...

- spark hive结合杂记(hive-site.xml)

1.下载spark源码,在spark源码目录下面有个make-distribution.sh文件,修改里面的参数,使编译后能支持hive,修改后执行该文件.(要预先安装好maven才能编译). 2.将 ...

- Spark&Hive:如何使用scala开发spark访问hive作业,如何使用yarn resourcemanager。

背景: 接到任务,需要在一个一天数据量在460亿条记录的hive表中,筛选出某些host为特定的值时才解析该条记录的http_content中的经纬度: 解析规则譬如: 需要解析host: api.m ...

- spark hive 结合处理 把多行变成多列

原数据格式 : gid id score a1 1 90 a1 2 80 a1 3 79 a1 ...

- Hadoop+HBase+Spark+Hive环境搭建

杨赟快跑 简书作者 2018-09-24 10:24 打开App 摘要:大数据门槛较高,仅仅环境的搭建可能就要耗费我们大量的精力,本文总结了作者是如何搭建大数据环境的(单机版和集群版),希望能帮助学弟 ...

随机推荐

- 用Android studio进行 OpenCV 开发的第一个项目

我的天! 折腾了好久终于搭建成功了第一个项目. 项目环境: Windows 7 家庭普通版 64位 Android studio 1.5.1 OpenCV-2.4.9-android-sdk 基于 ...

- 【起航计划 006】2015 起航计划 Android APIDemo的魔鬼步伐 05 App->Activity->Custom Title 自定义标题栏

Android UI缺省的标题栏由android:label 定义,显示在屏幕左上角,Android允许Activity自定义标题栏,使用自定义Layout重新设置标题栏,比如实现Windows Mo ...

- IO文件操作

× 目录 [1]IO文件的操作 [2]Directory类 [3]File类 [4]FileStream类 [5]文本文件的操作 一.IO文件的操作: .net中对文件操作,经常会用到这样几个类: ...

- 聪明的Azure CDN,帮你找到云端捷径

你知道吗?身处上海和纽约的两个用户同时通过网络收看“春晚”直播,纽约播放得可能比上海还要更流畅,这当然不是因为纽约距离北京的直播机房更近或者网速更快,而是因为大年夜在大洋彼岸围观“春晚”的观众相对较少 ...

- Java问题定位之Java线程堆栈分析

采用Java开发的大型应用系统越来越大,越来越复杂,很多系统集成在一起,整个系统看起来像个黑盒子.系统运行遭遇问题(系统停止响应,运行越来越慢,或者性能低下,甚至系统宕掉),如何速度命中问题的根本原因 ...

- Element-ui(el-table、el-pagination)实现表格分页

HTML代码:(重点关注el-table中:data数据的绑定) el-pagination中: layout代表组件布局,子组件名用逗号分隔 属性: total代表总条目数 事件: current- ...

- 在VirtualBox ubuntu/linux虚拟机中挂载mount共享文件夹

referemce: https://www.smarthomebeginner.com/mount-virtualbox-shared-folder-on-ubuntu-linux/ 1) Virt ...

- 数据库连接-ADO.NET

版权声明:本文为博主原创文章,未经博主同意不得转载. https://blog.csdn.net/huo065000/article/details/25830291 非常早就知道了ADO ...

- Uva 11732 strcmp()函数

题目链接:https://vjudge.net/contest/158125#problem/A 题意: 系统中,strcmp函数是这样执行的,给定 n 个字符串,求两两比较时,strcmp函数要比较 ...

- python Unittest+excel+ddt数据驱动测试

#!user/bin/env python # coding=utf- # @Author : Dang # @Time : // : # @Email : @qq.com # @File : # @ ...