【python】用python爬取中科院院士简介信息

018/07/09 23:43

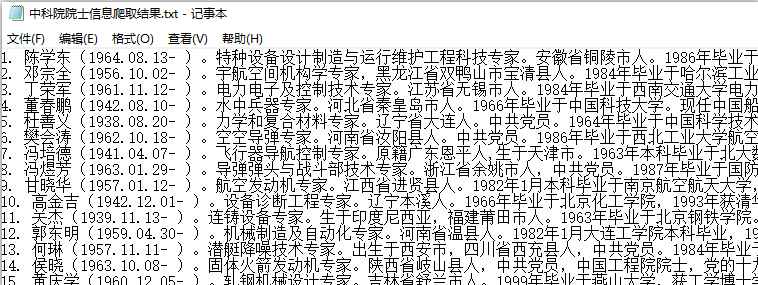

项目名称:爬取中科院871个院士的简介信息

1.爬取目的:中科院871个院士的简介信息

2.爬取最终结果:

3.具体代码如下:

import re # 不用安装(注意!!)

import os # 文件夹等的操作(注意!!)

import time

import requests # http urllib2 url = 'http://www.cae.cn/cae/html/main/col48/column_48_1.html'

html = requests.get(url)

# print(html.status_code) # 状态码200 404 500 502

html.encoding = 'utf-8'

# print(html.text) # 以文本形式返回网页 # 提取数据

# + 一次或多次 大于等于一次

# findall返回的是列表(注意!!)

number = re.findall(

'<a href="/cae/html/main/colys/(\d+).html" target="_blank">', html.text) i = 1 # 这里的i变量是由我创造进行明确区分所抓取的院士的数量的;

for m in number[:871]:

# for m in number[:4]: # 这里控制要爬取的个数

# for m in number[28:88]:

nextUrl = 'http://www.cae.cn/cae/html/main/colys/{}.html'.format(m)

# 再次请求数据

nexthtml = requests.get(nextUrl)

nexthtml.encoding = 'utf-8'

# 注意正则表达式:

# () 提取数据

# . 匹配除了换行\n的任意单个字符

# * 匹配前面的表达式任意次 {1,5}

# ? 如果前面有限定符 非贪婪模式,注意!!!

# 尽量可能少的匹配所搜索的字符串

text = re.findall('<div class="intro">(.*?)</div>', nexthtml.text, re.S) # re.S匹配换行的

text2 = re.sub(r'<p>| | |</p>', '', text[0]).strip() # .strip()清楚空格 # 保存数据

with open(r'E:\02中科院院士信息爬取结果.txt', mode='a+', encoding="utf-8") as f: # 特别注意这里的要以编码utf-8方式打开

f.write('{}. '.format(i) + text2 + '\n')

i += 1 # 不要下载太快

# 限制下载的速度

time.sleep(1)

# 程序运行到这个地方 暂停1s

【python】用python爬取中科院院士简介信息的更多相关文章

- [Python爬虫] Selenium爬取新浪微博客户端用户信息、热点话题及评论 (上)

转载自:http://blog.csdn.net/eastmount/article/details/51231852 一. 文章介绍 源码下载地址:http://download.csdn.net/ ...

- Python爬虫项目--爬取自如网房源信息

本次爬取自如网房源信息所用到的知识点: 1. requests get请求 2. lxml解析html 3. Xpath 4. MongoDB存储 正文 1.分析目标站点 1. url: http:/ ...

- 【Python项目】爬取新浪微博个人用户信息页

微博用户信息爬虫 项目链接:https://github.com/RealIvyWong/WeiboCrawler/tree/master/WeiboUserInfoCrawler 1 实现功能 这个 ...

- python之scrapy爬取某集团招聘信息以及招聘详情

1.定义爬取的字段items.py # -*- coding: utf-8 -*- # Define here the models for your scraped items # # See do ...

- Python爬虫项目--爬取某宝男装信息

本次爬取用到的知识点有: 1. selenium 2. pymysql 3 pyquery 正文 1. 分析目标网站 1. 打开某宝首页, 输入"男装"后点击"搜索&q ...

- python之crawlscrapy爬取某集团招聘信息以及招聘详情

针对这种招聘信息,使用crawlscrapy很适合. 1.settings.py # -*- coding: utf-8 -*- # Scrapy settings for gosuncn proje ...

- python之scrapy爬取某集团招聘信息

1.创建工程 scrapy startproject gosuncn 2.创建项目 cd gosuncn scrapy genspider gaoxinxing gosuncn.zhiye.com 3 ...

- Python爬虫之爬取慕课网课程评分

BS是什么? BeautifulSoup是一个基于标签的文本解析工具.可以根据标签提取想要的内容,很适合处理html和xml这类语言文本.如果你希望了解更多关于BS的介绍和用法,请看Beautiful ...

- python爬取 “得到” App 电子书信息

前言 文的文字及图片来源于网络,仅供学习.交流使用,不具有任何商业用途,版权归原作者所有,如有问题请及时联系我们以作处理. 作者: 静觅 崔庆才 PS:如有需要Python学习资料的小伙伴可以加点击下 ...

随机推荐

- HttpServerUtility 和 HttpUyility

参考:msdn HttpServerUtility 提供用于处理 Web 请求的 Helper 方法. 2017/08/07 加密解码 这个类没有构造函数,所以不能直接new. ...

- jQuery 二级联动

jQuery 二级联动 ----请选择省份---- 北京 上海 江苏 ----请选择城市---- 东城 西城 崇文 宣武 朝阳 黄浦 卢湾 徐汇 长宁 静安 南京 镇江 苏州 南通 扬州 & ...

- Webpack4 学习笔记三 ES6+语法降级为ES5

前言 此内容是个人学习笔记,以便日后翻阅.非教程,如有错误还请指出 Webpack 将es6.es7语法降级为es5 需要通过 babel JavaScript编译器. 安装: npm i babel ...

- jquery 筛选元素 (2)

.add() 创建一个新的对象,元素添加到匹配的元素集合中. .add(selector) selector 一个字符串表示的选择器表达式.找到更多的元素添加到匹配的元素集合. $("p&q ...

- Linux添加swap分区

swap分区的作用为当系统的物理内存不够用的时候,就需要将物理内存中的一部分空间释放出来,以供当前运行的程序使用,那些被释放的空间可能来自一些很长时间没有什么操作的程序,这些被释放的空间被临时保存到S ...

- 前端vue项目部署到tomcat,一刷新报错404解决方法

公司前端写的后台部署到tomcat webapps目录下后,无法进行刷新,一刷新就会报错404,自动跳的404页面.在网上查了下,官方说是HTML5 History 模式引发的问题,但是解决方案中,并 ...

- SpringMVC使用注解@RequestMapping映射请求

pringMVC通过使用@RequestMapping注解,实现指定控制器可以处理哪些URL请求. 控制器的类定义及方法定义处都可以标注@RequestMapping: 类定义处:提供初步的请求映射信 ...

- MyEclipse - 问题集 - build properties does not exist

方案1 受MyEclipse生成的项目文件.project影响,检查其中是否含有“<nature>org.eclipse.pde.PluginNature</nature>”, ...

- DNSSec

Domain Name System Security Extensions (DNSSEC)DNS安全扩展,是由IETF提供的一系列DNS安全认证的机制(可参考RFC2535).它提供了一种来源鉴定 ...

- PowerShell技巧:使用XPath语法查询XML文件

[TechTarget中国原创] XML是存储结构化数据的一个很好的途径,但是想要让数据在其中发挥作用又会有些困难.每一种语言都有其特定方式来查询XML文件中的命名空间.元素及属性.PowerShel ...