CHD-5.3.6集群上sqoop安装

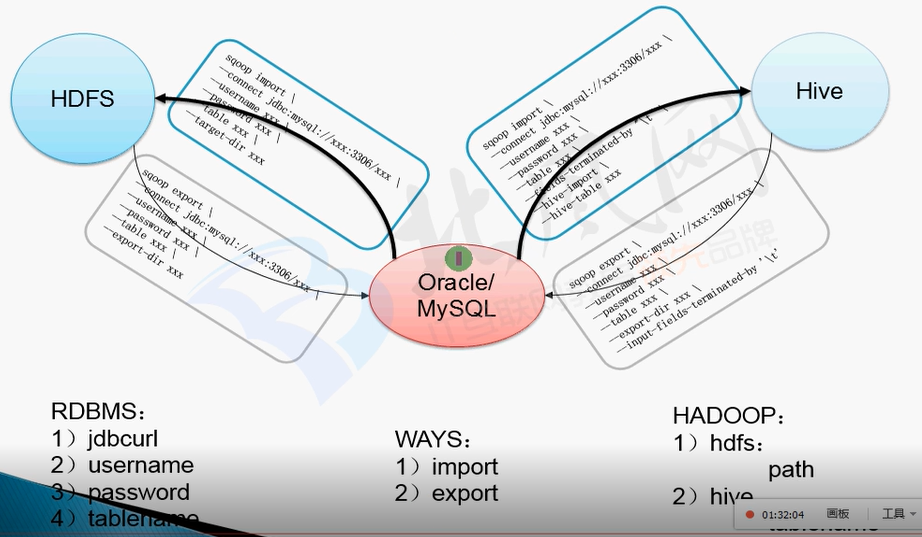

Sqoop(发音:skup)是一款开源的工具,主要用于在Hadoop(Hive)与传统的数据库(mysql、postgresql...)间进行数据的传递,可以将一个关系型数据库(例如 : MySQL ,Oracle ,Postgres等)中的数据导进到Hadoop的HDFS中,也可以将HDFS的数据导进到关系型数据库中。

对于某些Nosql数据库它也提供了连接器。Sqoop,类似于其他ETL工具,使用元数据模型来判断数据类型并在数据从数据源转移到Hadoop时确保类型安全的数据处理。Sqoop专为大数据批量传输设计,能够分割数据集并创建Hadoop任务来处理每个区块。

1.解压:

tar -xvf sqoop-1.4.-cdh5.3.6.tar.gz -C /home/hadoop/CDH5.3.6

2.进去conf目录

/home/hadoop/CDH5.3.6/sqoop-1.4.-cdh5.3.6/conf

3.重命名文件

[hadoop@master conf]$ cp sqoop-env-template.sh sqoop-env.sh

4.修改配置文件sqoop-env.sh

export HADOOP_COMMON_HOME=/home/hadoop/CDH5.3.6/hadoop-2.5.-cdh5.3.6 export HADOOP_MAPRED_HOME=/home/hadoop/CDH5.3.6/hadoop-2.5.-cdh5.3.6 export HIVE_HOME=/home/hadoop/CDH5.3.6/hive-0.13.-cdh5.3.6

5.验证:

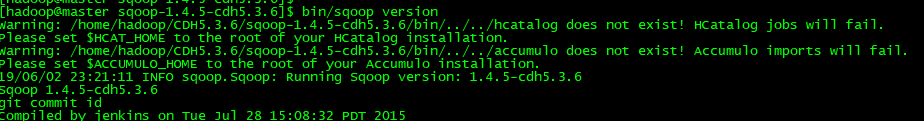

查看版本:

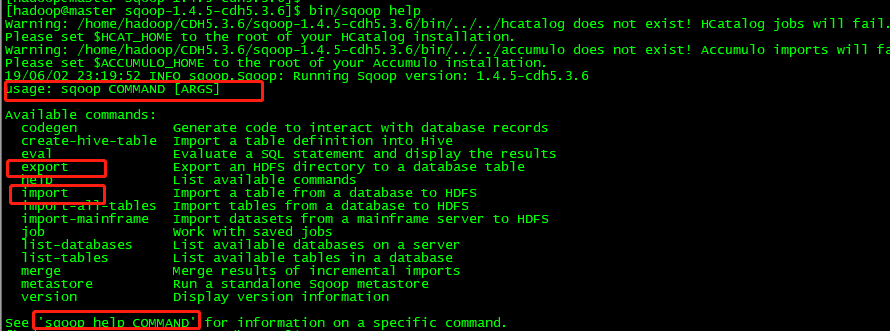

查看命令怎么用:

bin/sqoop help list-databases

链接的是MySQL数据库,需要拷贝一个jdbc驱动包

cp /home/hadoop/CDH5.3.6/hive-0.13.-cdh5.3.6/lib/mysql-connector-java-5.1..jar ./lib/

[hadoop@master lib]$ mysql -u root -p

Enter password:

mysql> update user set host = '%' where user = 'root';

Query OK, row affected (0.00 sec)

Rows matched: Changed: Warnings: mysql> FLUSH PRIVILEGES;

Query OK, rows affected (0.00 sec)

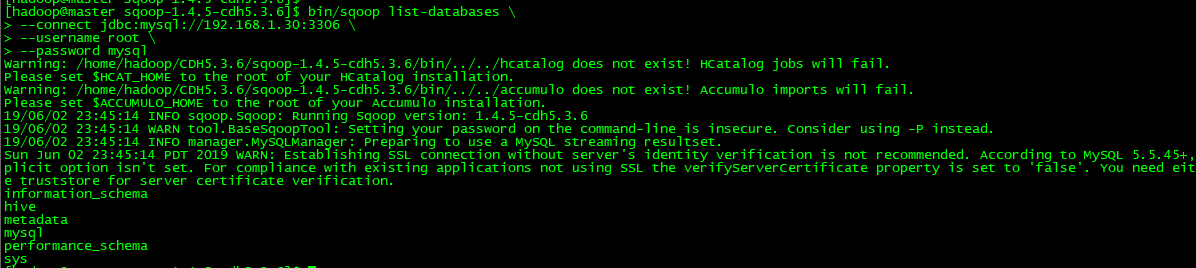

展现数据库有哪些database:

bin/sqoop list-databases \

--connect jdbc:mysql://192.168.1.30:3306 \

--username root \

--password mysql

安装完成,sqoop主要作用于export 、import 导入导出,见下次随笔

CHD-5.3.6集群上sqoop安装的更多相关文章

- CHD-5.3.6集群上Flume安装

Flume is a distributed, reliable, and available service for efficiently collecting, aggregating, and ...

- CHD-5.3.6集群上oozie安装

参考文档:http://archive.cloudera.com/cdh5/cdh/5/oozie-4.0.0-cdh5.3.6/DG_QuickStart.html tar -zxvf oozie ...

- CHD-5.3.6集群上hive安装

解压过后: [hadoop@master CDH5.3.6]$ ls -rlttotal 8drwxr-xr-x. 17 hadoop hadoop 4096 Jun 2 16:07 hadoop- ...

- hive1.2.1安装步骤(在hadoop2.6.4集群上)

hive1.2.1在hadoop2.6.4集群上的安装 hive只需在一个节点上安装即可,这里再hadoop1上安装 1.上传hive安装包到/usr/local/目录下 2.解压 tar -zxvf ...

- 在Ubuntu16.04集群上手工部署Kubernetes

目前Kubernetes为Ubuntu提供的kube-up脚本,不支持15.10以及16.04这两个使用systemd作为init系统的版本. 这里详细介绍一下如何以非Docker方式在Ubuntu1 ...

- 在集群上运行caffe程序时如何避免Out of Memory

不少同学抱怨,在集群的GPU节点上运行caffe程序时,经常出现"Out of Memory"的情况.实际上,如果我们在提交caffe程序到某个GPU节点的同时,指定该节点某个比较 ...

- 分布式Hbase-0.98.4在Hadoop-2.2.0集群上的部署

fesh个人实践,欢迎经验交流!本文Blog地址:http://www.cnblogs.com/fesh/p/3898991.html Hbase 是Apache Hadoop的数据库,能够对大数据提 ...

- Hadoop集群上使用JNI,调用资源文件

hadoop是基于java的数据计算平台,引入第三方库,例如C语言实现的开发包将会大大增强数据分析的效率和能力. 通常在是用一些工具的时候都要用到一些配置文件.资源文件等.接下来,借一个例子来说明ha ...

- spark在集群上运行

1.spark在集群上运行应用的详细过程 (1)用户通过spark-submit脚本提交应用 (2)spark-submit脚本启动驱动器程序,调用用户定义的main()方法 (3)驱动器程序与集群管 ...

随机推荐

- 图像分割-Mask Scoring R-CNN

转载:https://zhuanlan.zhihu.com/p/58291808 论文链接:https://arxiv.org/abs/1903.00241 代码链接:https://github.c ...

- iOS 11适配和iPhone X的适配

这两天对自己负责的项目进行iOS 11和iPhone X的适配,网上的博客很多,也看了很多别人的记录博客,这里把自己遇到的问题记录下,当然有些不仅仅是iOS 11和iPhone X的适配,还包括自己遇 ...

- Ubuntu 18.04 上使用xrdp远程桌面连接

参考:https://blog.csdn.net/qq_25556149/article/details/82216190 1,环境查看 2,安装 xrdp.tightvncserver apt-ge ...

- MySQL创建用户、授权、删除

1.在MySQL中创建新用户 使用具有shell访问权限的root用户登录MySQL服务器并创建名为“rahul”的新用户.下面的命令只允许从localhost系统访问用户rahul的MySQL服务器 ...

- Linux上安装Julia-1.1

Julia 在Linux上的安装 浙江大学Julia镜像: 浙江大学Julia镜像 下载1.1版本: wget https://mirrors.zju.edu.cn/julia/releases/v1 ...

- docker挂载本地目录的方法总结

docker挂载本地目录的方法总结: Docker容器启动的时候,如果要挂载宿主机的一个目录,可以用-v参数指定. 譬如我要启动一个centos容器,宿主机的/test目录挂载到容器的/soft目录, ...

- Centos6.5搭建方法

# VSFTP # ## ###安装 vsftp yum install vsftpd* -y ###启动服务 /etc/init.d/vsftpd restart ###配置 ...

- Java学习笔记-基础语法

Java基础包含关键字,标识符,注释,常量和变量,运算符 关键字 关键字的定义和特点 定义:被Java语言赋予了特殊含义的单词 特点:关键字中所有字母都为小写 Java的关键字 用于定义数据类型的关键 ...

- SpringBoot异步编程

异步调用:当我们执行一个方法时,假如这个方法中有多个耗时的任务需要同时去做,而且又不着急等待这个结果时可以让客户端立即返回然后,后台慢慢去计算任务.当然你也可以选择等这些任务都执行完了,再返回给客户端 ...

- 在springMVC框架中集成quartz作业调度器

1.首先需要导入这几个jar包,如下图: 其中log4j,quartz,slf4j-api,slf4j-log4j12我是在项目中都引用了 2.引用完jar包后,新建一个作业调度类,执行作业调度逻辑, ...