配置BeautifulSoup4+lxml+html5lib

序

Windows平台 + Python3.5

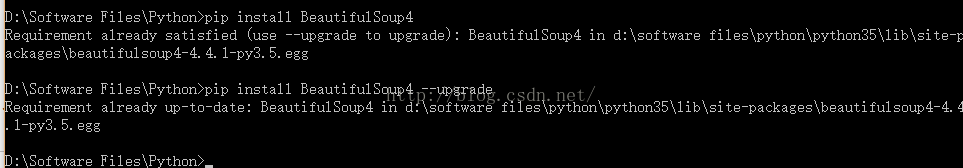

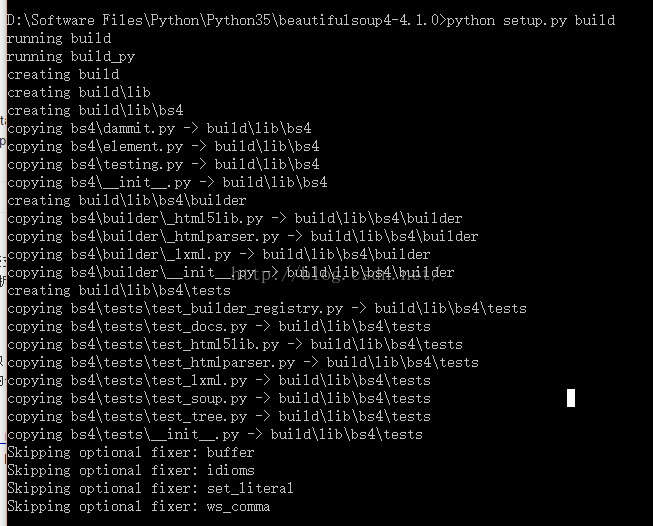

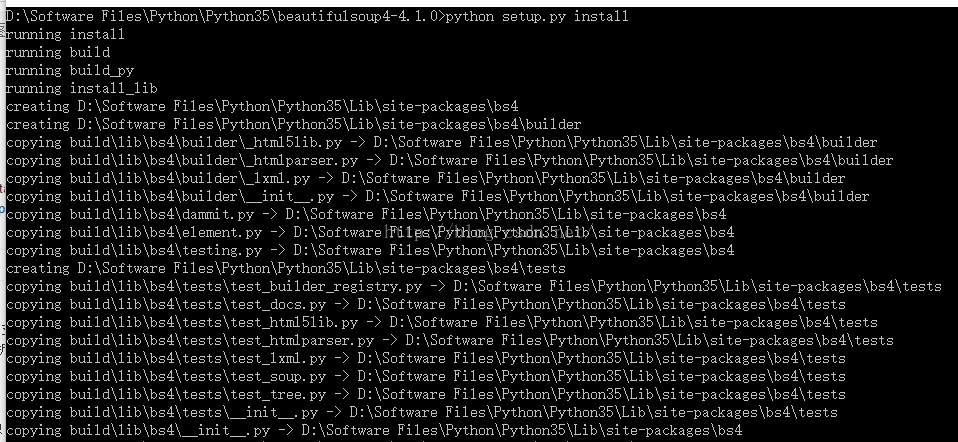

安装BeautifulSoup4

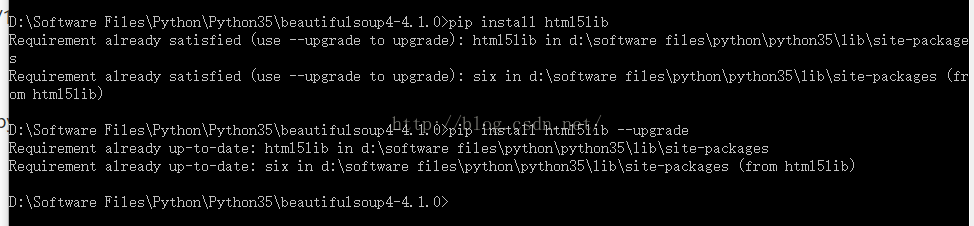

安装html5lib

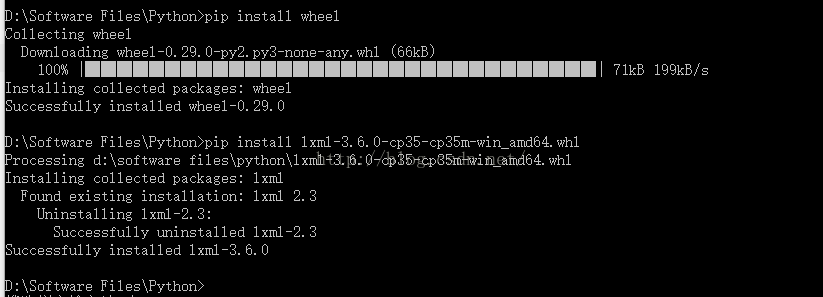

安装lxml

Lxml, a binding for the libxml2 and libxslt libraries.

lxml‑3.4.4‑cp27‑none‑win32.whl

lxml‑3.4.4‑cp27‑none‑win_amd64.whl

lxml‑3.4.4‑cp33‑none‑win32.whl

lxml‑3.4.4‑cp33‑none‑win_amd64.whl

lxml‑3.4.4‑cp34‑none‑win32.whl

lxml‑3.4.4‑cp34‑none‑win_amd64.whl

lxml‑3.4.4‑cp35‑none‑win32.whl

lxml‑3.4.4‑cp35‑none‑win_amd64.whl

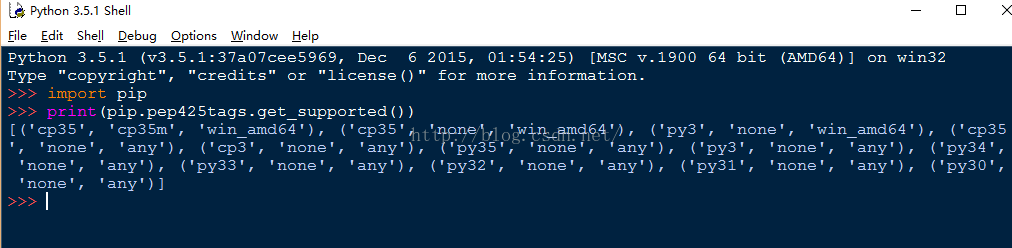

cp后面是Python的版本号,27表示2.7,根据你的Python版本选择下载。

- pip install BeautifulSoup4 或 easy_install BeautifulSoup4

- pip install html5lib

- pip install lxml

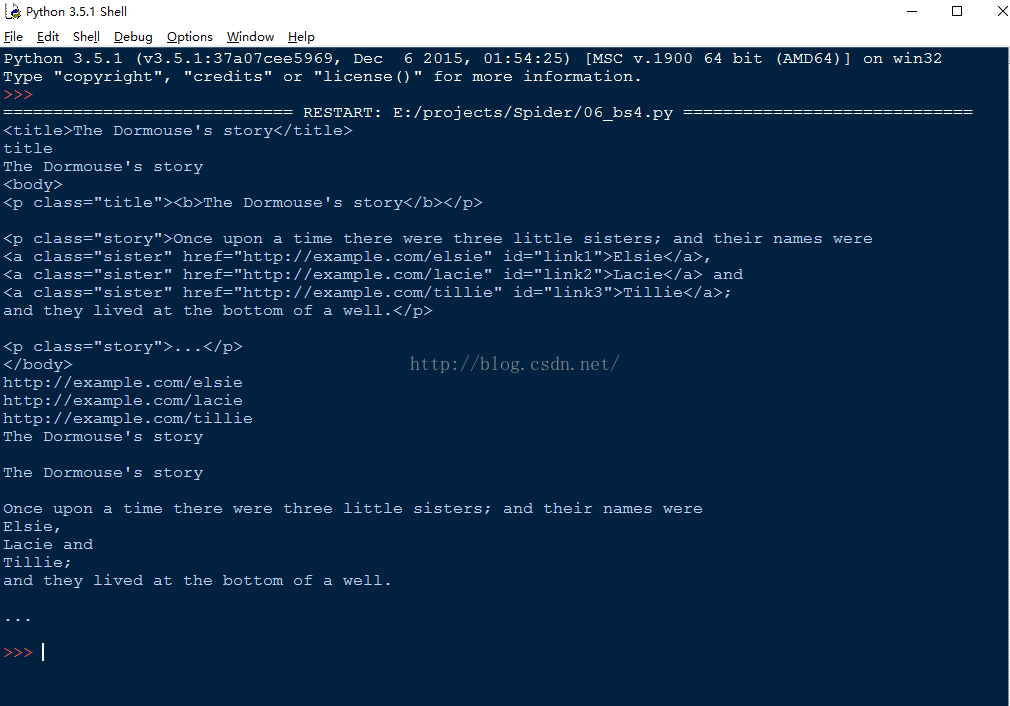

使用BeautifulSoup

- html = """

- <html><head><title>The Dormouse's story</title></head>

- <body>

- <p class="title"><b>The Dormouse's story</b></p>

- <p class="story">Once upon a time there were three little sisters; and their names were

- <a href="http://example.com/elsie" class="sister" id="link1">Elsie</a>,

- <a href="http://example.com/lacie" class="sister" id="link2">Lacie</a> and

- <a href="http://example.com/tillie" class="sister" id="link3">Tillie</a>;

- and they lived at the bottom of a well.</p>

- <p class="story">...</p>

- """

- from bs4 import BeautifulSoup

- #添加一个解析器

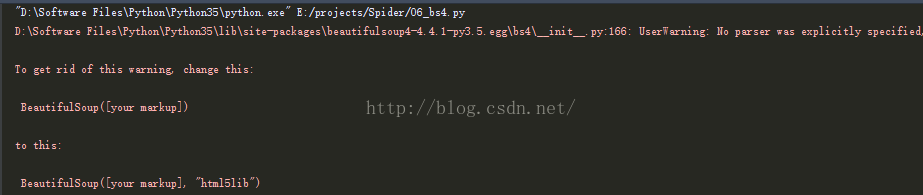

- soup = BeautifulSoup(html,'html5lib')

- print(soup.title)

- print(soup.title.name)

- print(soup.title.text)

- print(soup.body)

- #从文档中找到所有<a>标签的内容

- for link in soup.find_all('a'):

- print(link.get('href'))

- #从文档中找到所有文字内容

- print(soup.get_text())

注意:

配置BeautifulSoup4+lxml+html5lib的更多相关文章

- Python爬虫beautifulsoup4常用的解析方法总结

摘要 如何用beautifulsoup4解析各种情况的网页 beautifulsoup4的使用 关于beautifulsoup4,官网已经讲的很详细了,我这里就把一些常用的解析方法做个总结,方便查阅. ...

- Python爬虫beautifulsoup4常用的解析方法总结(新手必看)

今天小编就为大家分享一篇关于Python爬虫beautifulsoup4常用的解析方法总结,小编觉得内容挺不错的,现在分享给大家,具有很好的参考价值,需要的朋友一起跟随小编来看看吧摘要 如何用beau ...

- 爬虫基础以及 re,BeatifulSoup,requests模块使用

爬虫基础以及BeatifulSoup模块使用 爬虫的定义:向网站发起请求,获取资源后分析并提取有用数据的程序 爬虫的流程 发送请求 ---> request 获取响应内容 ---> res ...

- 【学习笔记】PYTHON网络爬虫与信息提取(北理工 嵩天)

学习目的:掌握定向网络数据爬取和网页解析的基本能力the Website is the API- 1 python ide 文本ide:IDLE,Sublime Text集成ide:Pychar ...

- Python网络爬虫与信息提取笔记

直接复制粘贴笔记发现有问题 文档下载地址//download.csdn.net/download/hide_on_rush/12266493 掌握定向网络数据爬取和网页解析的基本能力常用的 Pytho ...

- 1 python大数据挖掘系列之基础知识入门

preface Python在大数据行业非常火爆近两年,as a pythonic,所以也得涉足下大数据分析,下面就聊聊它们. Python数据分析与挖掘技术概述 所谓数据分析,即对已知的数据进行分析 ...

- 转:Beautiful Soup

Beautiful Soup 是一个可以从HTML或XML文件中提取数据的Python库.它能够通过你喜欢的转换器实现惯用的文档导航,查找,修改文档的方式.Beautiful Soup会帮你节省数小时 ...

- 【bs4】安装beautifulsoup

Debian/Ubuntu,install $ apt-get install python-bs4 easy_install/pip $ easy_install beautifulsoup4 $ ...

- requests和BeautifulSoup

一:Requests库 Requests is an elegant and simple HTTP library for Python, built for human beings. 1.安装 ...

随机推荐

- deploy KBA 2167993

The default trace shows the following error: ****************************************** Unable to cr ...

- java线程中如何使用spring依赖注入

实现一个线程继承了Thread或实现Runnable接口,想在run方法中使用spring依赖注入(操作数据库),此时报错为空指针,就是说没有注入进来. 实验了几种方式,分别说一下优缺点. 1:写了工 ...

- apache ftp server 设置

<server xmlns="http://mina.apache.org/ftpserver/spring/v1" xmlns:xsi="http://www.w ...

- unity 刚体

刚体属性(rigidbody)标明物体受物理影响,包括重力,阻力等等. mass为重量,当大质量物体被小重量物体碰撞时只会发生很小的影响.. Drag现行阻力决定组件在没有发生物理行为下停止移动的速度 ...

- 你的系统需要SMB2或者更高版本,才能访问共享

- 【转载】解密ThreadLocal

概述 相信读者在网上也看了很多关于ThreadLocal的资料,很多博客都这样说:ThreadLocal为解决多线程程序的并发问题提供了一种新的思路:ThreadLocal的目的是为了解决多线程访问资 ...

- kubernetes集群初始化(二)

参考地址:https://github.com/unixhot/salt-kubernetes 一.系统初始化 1.1.安装docker 所有节点都安装docker,设置docker国内yum源 [r ...

- FRDM-KL43开发板驱动段式液晶SLCD的实现方法

LCD的驱动不像LED那样,加上电压(LED实际上是电流驱动)就可以长期显示的. LCD驱动必须使用交流电压驱动才能保持稳定的显示,如果在LCD上加上稳定的直流电压, 不但不能正常显示,时间久了还会损 ...

- 基于Java+Selenium的WebUI自动化测试框架(二)-----页面操作接口

在有了基础的Position类之后,我们需要考虑我们在寻找完页面元素之后,需要做什么.这个“做”什么,可以理解为我们在页面上需要对应的一系列动作.比如:点击,输入,切换窗口,寻找元素,判断元素是否存在 ...

- Python离线断网情况下安装numpy、pandas和matplotlib等常用第三方包

联网情况下在命令终端CMD中输入“pip install numpy”即可自动安装,pandas和matplotlib同理一样方法进行自动安装. 工作的电脑不能上外网,所以不能通过直接输入pip命令来 ...