【lucene系列学习四】使用IKAnalyzer分词器实现敏感词和停用词过滤

Lucene自带的中文分词器SmartChineseAnalyzer不太好扩展,于是我用了IKAnalyzer来进行敏感词和停用词的过滤。

首先,下载IKAnalyzer,我下载了

然后,由于IKAnalyzer已经很久不更新了,不兼容现在的Lucene6版本,所以我参考网上的资料,重写了IKTokenizer和IKAnalyzer两个类。

package kidsearch;

import java.io.IOException;

import java.io.Reader; import org.apache.lucene.analysis.Tokenizer;

import org.apache.lucene.analysis.tokenattributes.CharTermAttribute;

import org.apache.lucene.analysis.tokenattributes.OffsetAttribute;

import org.apache.lucene.analysis.tokenattributes.TypeAttribute;

import org.wltea.analyzer.core.IKSegmenter;

import org.wltea.analyzer.core.Lexeme; public class MyIKTokenizer extends Tokenizer {

// IK分词器实现

private IKSegmenter _IKImplement; // 词元文本属性

private final CharTermAttribute termAtt;

// 词元位移属性

private final OffsetAttribute offsetAtt;

// 词元分类属性(该属性分类参考org.wltea.analyzer.core.Lexeme中的分类常量)

private final TypeAttribute typeAtt;

// 记录最后一个词元的结束位置

private int endPosition; public MyIKTokenizer(Reader in) {

this(in, true);

} public MyIKTokenizer(Reader in, boolean useSmart) {

offsetAtt = addAttribute(OffsetAttribute.class);

termAtt = addAttribute(CharTermAttribute.class);

typeAtt = addAttribute(TypeAttribute.class);

_IKImplement = new IKSegmenter(input, useSmart);

} @Override

public boolean incrementToken() throws IOException {

// 清除所有的词元属性

clearAttributes();

Lexeme nextLexeme = _IKImplement.next();

if (nextLexeme != null) {

// 将Lexeme转成Attributes

// 设置词元文本

termAtt.append(nextLexeme.getLexemeText());

// 设置词元长度

termAtt.setLength(nextLexeme.getLength());

// 设置词元位移

offsetAtt.setOffset(nextLexeme.getBeginPosition(),

nextLexeme.getEndPosition());

// 记录分词的最后位置

endPosition = nextLexeme.getEndPosition();

// 记录词元分类

typeAtt.setType(String.valueOf(nextLexeme.getLexemeType()));

// 返会true告知还有下个词元

return true;

}

// 返会false告知词元输出完毕

return false;

} public void reset() throws IOException {

super.reset();

_IKImplement.reset(input);

} @Override

public final void end() {

// set final offset

int finalOffset = correctOffset(this.endPosition);

offsetAtt.setOffset(finalOffset, finalOffset);

} }

MyIKTokenizer

package kidsearch;

import java.io.Reader;

import java.io.StringReader; import org.apache.lucene.analysis.Analyzer;

import org.apache.lucene.util.IOUtils;

import kidsearch.MyIKTokenizer;

public class MyIkAnalyzer extends Analyzer { @Override

protected TokenStreamComponents createComponents(String arg0) {

Reader reader=null;

try{

reader=new StringReader(arg0);

MyIKTokenizer it = new MyIKTokenizer(reader);

return new Analyzer.TokenStreamComponents(it);

}finally {

IOUtils.closeWhileHandlingException(reader);

}

} }

MyIKAnalyzer

参考的博客里有一部分是错误的

于是我又下载了IKAnalyzer的源码,仔细看了一下Lexeme.java,发现没有这个方法,只有getLexemeType,而且返回值是int,于是自己做了点小改动,终于编译通过了!

值得注意的是,MyIKTokenizer里

public MyIKTokenizer(Reader in) {

this(in, true);

}

true为选择智能划分(北京师范大学),而false为最细粒度划分(北京师范大学,北京,京师,师范大学,师范,大学)。

最后,要配置自己的停用词和敏感词。

自定义词典一定要使用UTF-8无BOM编码,否则不能实现过滤功能。

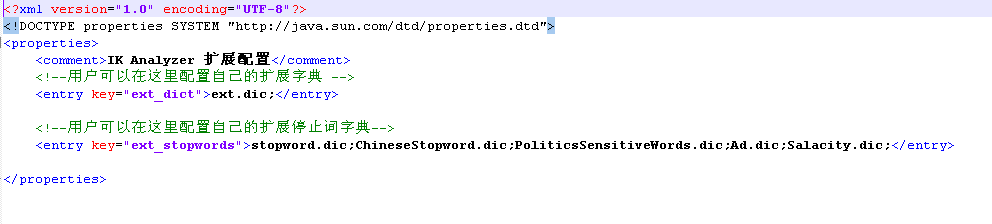

然后,在配置文件IKAnalyzer.cfg.xml里配置自定义词典

最后,分别把所有的自定义词典和IKAnalyzer.cfg.xml加到工程里的src(为了保险起见,我又把他们加到了bin里,IK的jar包里也加了)。

为了测试停用词的效果,可以自己写几个小程序。

import java.io.IOException;

import java.io.StringReader; import org.apache.lucene.analysis.Analyzer;

import org.apache.lucene.analysis.TokenStream;

import org.apache.lucene.analysis.tokenattributes.CharTermAttribute;

import org.wltea.analyzer.cfg.Configuration;

import org.wltea.analyzer.cfg.DefaultConfig;

import org.wltea.analyzer.core.IKSegmenter;

import org.wltea.analyzer.core.Lexeme;

import org.wltea.analyzer.lucene.IKAnalyzer; public class OwnIKAnalyzer {

public static void main(String[] args) throws IOException {

String text="我有一个红红的苹果";

StringReader sr=new StringReader(text);

// IKSegmenter ik=new IKSegmenter(sr, true);

IKSegmenter ik=new IKSegmenter(sr,true);

Lexeme lex=null;

while((lex=ik.next())!=null){

System.out.print(lex.getLexemeText()+",");

}

// String text = "这是一个红红的苹果";

// Configuration configuration = DefaultConfig.getInstance();

// configuration.setUseSmart(true);

// IKSegmenter ik = new IKSegmenter(new StringReader(text), configuration);

// Lexeme lexeme = null;

// while ((lexeme = ik.next()) != null) {

// System.out.println(lexeme.getLexemeText());

}

}

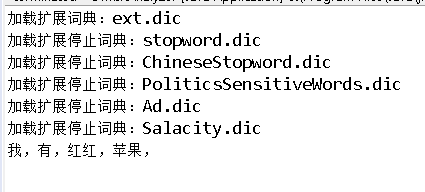

测试结果为:(词典里并没有过滤“我”)

另外,IKAnalyzer可以配置自己的扩展词典,比如“你的名字”本来会被分词为“你,的,名字”,但是在ext.dic里加入“你的名字”后就是一个完整的整体,不会被切分了!

关于IKAnalyzer词语过滤的功能今天就做了多,以后还会继续补充~

【lucene系列学习四】使用IKAnalyzer分词器实现敏感词和停用词过滤的更多相关文章

- lucene全文搜索之二:创建索引器(创建IKAnalyzer分词器和索引目录管理)基于lucene5.5.3

前言: lucene全文搜索之一中讲解了lucene开发搜索服务的基本结构,本章将会讲解如何创建索引器.管理索引目录和中文分词器的使用. 包括标准分词器,IKAnalyzer分词器以及两种索引目录的创 ...

- lucene内存索引库、分词器

内存索引库 特点 在内存中开辟一块空间,专门为索引库存放.这样有以下几个特征: 1) 因为索引库在内存中,所以访问速度更快. 2) 在程序退出时,索引库中的文件也相应的消失了. 3) ...

- Solr配置Ikanalyzer分词器

上一篇文章讲解在win系统中如何安装solr并创建一个名为test_core的Core,接下为text_core配置Ikanalyzer 分词器 1.打开text_core的instanceDir目录 ...

- lucene全文搜索之四:创建索引搜索器、6种文档搜索器实现以及搜索结果分析(结合IKAnalyzer分词器的搜索器)基于lucene5.5.3

前言: 前面几章已经很详细的讲解了如何创建索引器对索引进行增删查(没有更新操作).如何管理索引目录以及如何使用分词器,上一章讲解了如何生成索引字段和创建索引文档,并把创建的索引文档保存到索引目录,到这 ...

- Lucene.Net3.0.3+盘古分词器学习使用

一.Lucene.Net介绍 Lucene.net是Lucene的.net移植版本,是一个开源的全文检索引擎开发包,即它不是一个完整的全文检索引擎,而是一个全文检索引擎的架构,提供了完整的查询引擎和索 ...

- python调用jieba(结巴)分词 加入自定义词典和去停用词功能

把语料从数据库提取出来以后就要进行分词啦,我是在linux环境下做的,先把jieba安装好,然后找到内容是build jieba PKG-INFO setup.py test的那个文件夹(我这边是ji ...

- IKanalyzer分词器分词并且统计词频

<dependency> <groupId>com.janeluo</groupId> <artifactId>ikanalyzer</artif ...

- 【lucene系列学习四】log4j日志文件实现多线程的测试

参考资料:http://nudtgk2000.iteye.com/blog/1716379 首先,在http://www.apache.org/dyn/closer.cgi/logging/log4j ...

- Lucene系列四:Lucene提供的分词器、IKAnalyze中文分词器集成、扩展 IKAnalyzer的停用词和新词

一.Lucene提供的分词器StandardAnalyzer和SmartChineseAnalyzer 1.新建一个测试Lucene提供的分词器的maven项目LuceneAnalyzer 2. 在p ...

随机推荐

- css兼容问题 ie6,7

H5标签兼容 元素浮动之后能设置宽度的话就给元素加宽度,如果需要元素宽度是内容撑开,就给他里面的块元素加上浮动 第一块加浮动,第二块加margin等于第一块元素在IE6下会有间隙问题 IE6下子元素超 ...

- JavaWeb之Listener监听器

监听在Java体系中运用的很广泛,在安卓开发.JavaWeb开发中到处存在,在其他语言也有类似的,如果有了解过设计模式那很容易理解实现的原理.不过对于开发者来说,使用观察者模式只需实现相应的接口就好, ...

- otool介绍(转http://www.mc2lab.com/?p=68)

1. Otool简介 Otool可以提取并显示ios下目标文件的相关信息,包括头部,加载命令,各个段,共享库,动态库等等.它拥有大量的命令选项,是一个功能强大的分析工具,当然还可以做反汇编的工具使用. ...

- Python快速入门(4)

输入输出: open() read() readine() readlines() write() pickle模块可以做序列化操作,持久保持对象的信息. 我们可以很容易的读写文件中的字符串.数值就要 ...

- 期待微软平台即服务技术Service Fabric 开源

微软的Azure Service Fabric的官方博客在3.24日发布了一篇博客 Service Fabric .NET SDK goes open source ,介绍了社区呼声最高的Servic ...

- get_category_recommend_goods的正确使用

get_category_recommend_goods($type = '', $cats = '', $brand = 0, $min =0, $max = 0, $ext='') 位于lib_ ...

- 设计模式(一)—单例模式

一.概述 1.单例模式的优点 由于单例模式只生成一个实例,减少了系统性能的开销,当一个对象的产生需要比较多的资源时,如读取配置,产生其他依赖对象时,则可以通过在应用启动时直接产生一个单例对象 ...

- Shiro基础学习(一)—权限管理

一.基本概念 1.权限管理 只要有用户参与的系统一般都要有权限管理,权限管理实现对用户访问系统的控制,按照安全规则或者安全策略控制用户可以访问而且只能访问自己被授权的资源. 权限管理 ...

- jQuery基础学习(二)—jQuery选择器

一.jQuery基本选择器 1.CSS选择器 在学习jQuery选择器之前,先介绍一下之前学过的CSS选择器. 选择器 语法 描述 示例 标签选择器 E { ...

- MongoDB基础教程系列--第六篇 MongoDB 索引

使用索引可以大大提高文档的查询效率.如果没有索引,会遍历集合中所有文档,才能找到匹配查询语句的文档.这样遍历集合中整个文档的方式是非常耗时的,特别是处理大数据时,耗时几十秒甚至几分钟都是有可能的. 创 ...