莫烦 - Pytorch学习笔记 [ 二 ] CNN ( 1 )

CNN原理和结构

观点提出

关于照片的三种观点引出了CNN的作用。

- 局部性:某一特征只出现在一张image的局部位置中。

- 相同性: 同一特征重复出现。例如鸟的羽毛。

- 不变性:subsampling下图片性质不变。类似于图片压缩。

相比与Fully Connected,减少了权重数目。

组成结构

卷积层

使用一个集合的滤波器在输入数据上滑动,得到内积,形成K张二维的激活图,作为该层卷积层的输出。

- 每类的滤波器寻找一种特征进行激活。

- 一个滤波器的高度必须与输入数据体的深度一致。

- 卷积层的输出深度是一个超参数,它与使用的滤波器的数量一致。

例如:

一张28 * 28 * 3的照片,\(W_1=28, H_1=28, D_1=3\),故感受野的尺寸可以是 5 * 5 * 3的。

若有16个滤波器同时运算,则输出层数为16。

4个超参数:滤波器数量\(K\),空间尺寸\(F\),滑动步长\(S\),零填充数量\(P\)。

一次过滤后输出体的尺寸 \(W_2 * H_2 * D_2\)

\]

步长必须是整数,零填充数量$ \frac{F - step}{2}$

参数共享:相同的滤波器可以检测出不同位置的相同特征,可以有效减少参数。

小滤波器的有效性:多个卷积层首先与非线性激活层交替的结构,比单一卷积层的结构更能提取出深层的特征;小滤波器组合使用参数更少,但不足的是反向更新参数时,可能会使用更多的内存。

池化层

逐渐降低数据体的空间尺寸,这样能够减少网络中参数的数量。

2个超参数:空间尺寸\(F\),滑动步长\(S\)。

最常用的池化层形式是尺寸为2*2的窗口,滑动步长为2,对图像进行采样,将其中75%的激活信息都丢掉,只选择其中最大的保留,以此去掉一些噪声信息。

平均池化一般放在CNN的最后一层。

CNN模块等

参数列表

卷积层参数:

in_channels: 当图片为RGB时为3,否则为1。对应的是输入数据体的深度。out_channels:输出数据体的深度。kernel_size:滤波器的大小,单位pixel。stride:步长padding:=0表示四周不进行0填充,=1表示进行1个像素点的填充。

池化层参数:

kernel_size:=2表示 2*2的小矩阵中选max。

CNN模型:ResNet

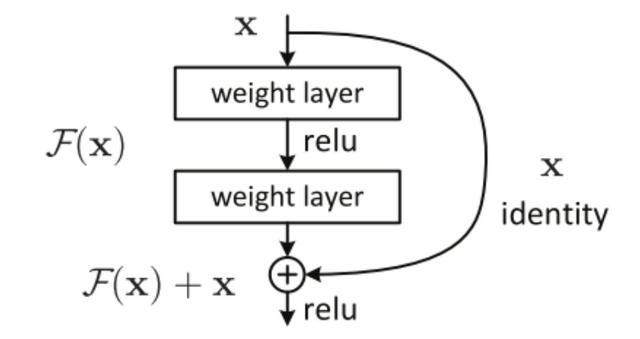

若将输入设为X,将某一有参网络层设为H,那么以X为输入的此层的输出将为H(X)。一般的CNN网络如Alexnet/VGG等会直接通过训练学习出参数函数H的表达,从而直接学习X -> H(X)。

而残差学习则是致力于使用多个有参网络层来学习输入、输出之间的参差即H(X) - X即学习X -> (H(X) - X) + X。其中X这一部分为直接的identity mapping,而H(X) - X则为有参网络层要学习的输入输出间残差。

class CNN(nn.Module):

..

def forward(self, x):

residual = x

# 代入层结构

if self.downsample is not None:

residual = self.downsample(x)

out += residual

#...

莫烦 - Pytorch学习笔记 [ 二 ] CNN ( 1 )的更多相关文章

- 莫烦pytorch学习笔记(二)——variable

.简介 torch.autograd.Variable是Autograd的核心类,它封装了Tensor,并整合了反向传播的相关实现 Variable和tensor的区别和联系 Variable是篮子, ...

- 莫烦pytorch学习笔记(八)——卷积神经网络(手写数字识别实现)

莫烦视频网址 这个代码实现了预测和可视化 import os # third-party library import torch import torch.nn as nn import torch ...

- 莫烦pytorch学习笔记(七)——Optimizer优化器

各种优化器的比较 莫烦的对各种优化通俗理解的视频 import torch import torch.utils.data as Data import torch.nn.functional as ...

- 莫烦PyTorch学习笔记(五)——模型的存取

import torch from torch.autograd import Variable import matplotlib.pyplot as plt torch.manual_seed() ...

- 莫烦PyTorch学习笔记(六)——批处理

1.要点 Torch 中提供了一种帮你整理你的数据结构的好东西, 叫做 DataLoader, 我们能用它来包装自己的数据, 进行批训练. 而且批训练可以有很多种途径. 2.DataLoader Da ...

- 莫烦PyTorch学习笔记(三)——激励函数

1. sigmod函数 函数公式和图表如下图 在sigmod函数中我们可以看到,其输出是在(0,1)这个开区间内,这点很有意思,可以联想到概率,但是严格意义上讲,不要当成概率.sigmod函数 ...

- 莫烦 - Pytorch学习笔记 [ 一 ]

1. Numpy VS Torch #相互转换 np_data = torch_data.numpy() torch_data = torch.from_numpy(np_data) #abs dat ...

- 莫烦PyTorch学习笔记(五)——分类

import torch from torch.autograd import Variable import torch.nn.functional as F import matplotlib.p ...

- 莫烦PyTorch学习笔记(四)——回归

下面的代码说明个整个神经网络模拟回归的过程,代码含有详细注释,直接贴下来了 import torch from torch.autograd import Variable import torch. ...

随机推荐

- pycharm中的搜索快捷键

- 2、基本方法(Basic Recipes)

学习目录:树莓派学习之路-GPIO Zero 官网地址:http://gpiozero.readthedocs.io/en/stable/recipes.html 环境:UbuntuMeta-16.0 ...

- AcWing - 156 矩阵(二维哈希)

题目链接:矩阵 题意:给定一个$m$行$n$列的$01$矩阵$($只包含数字$0$或$1$的矩阵$)$,再执行$q$次询问,每次询问给出一个$a$行$b$列的$01$矩阵,求该矩阵是否在原矩阵中出现过 ...

- C 语言实例 -求分数数列1/2+2/3+3/5+5/8+...的前n项和

程序分析:抓住分子与分母的变化规律:分子a:1,2,3,5,8,13,21,34,55,89,144...分母b:2,3,5,8,13,21,34,55,89,144,233...分母b把数赋给了分子 ...

- make工具简介

在Linux C/C++的开发过程中,当源代码文件较少时,我们可以手动使用gcc或g++进行编译链接,但是当源代码文件较多且依赖变得复杂时,我们就需要一种简单好用的工具来帮助我们管理.于是,make应 ...

- 「HNOI2012」永无乡

传送门 Luogu 解题思路 很容易想到平衡树,然后还可以顺便维护一下连通性,但是如何合并两棵平衡树? 我们采用一种类似于启发式合并的思想,将根节点siz较小的那颗平衡树暴力的合并到另一颗上去. 那么 ...

- html5的元素拖拽

今天学习了妙味课堂的课程: 在html5中有支持元素拖拽的一些属性和方法: 一些实例代码如下: <div id="div1"></div> <ul&g ...

- mybatis用mybatis-generator-core-1.3.5.jar自动生成实体类

原文出处:https://blog.csdn.net/shuoshuo_12345/article/details/80626241,本文只是个人总结而已! 方法1:在pom文件中添加依赖 只需在搭建 ...

- 进程的用户ID

进程创建时,系统会在进程上设置几个用户相关的ID 实际用户ID,实际用户组ID,系统根据当前会话登陆的用户信息设置 有效用户ID,有效用户组ID,系统根据所打开的执行文件的模式位,进行设置.set_u ...

- DHCP原理及报文格式

DHCP原理及报文格式 DHCP(Dynamic Host Configuration Protocol,动态主机配置协议)是IETF为实现IP的自动配置而设计的协议,它可以为客户机自动分配IP地址. ...