爬虫之requestsku

想用selenium实现B站自动登录以及点赞等功能,便查阅如何解决滑动解锁,然而是有关爬虫的内容,便开始学习爬虫,没过多久又想把记录自己生活的网站做起来,朋友便推荐了layui框架倒腾了一晚上自我觉得是做给后端程序员入门的框架,Vue又感觉太难,便开始搞bootstrap,没搞出个所以然来。因为闲着心情烦躁便开始重新学习爬虫。每次写点文章总是碎碎念一段,有人在评论去区说我矫情,是真的。

安装:pip install requests

http请求返回response对象属性

编码问题

import requests

r=requests.get('http://www.baidu.com/')

r.encoding='gbk' 或 r.encoding=r.apparent_encoding

#百度返回的页面内容为ISO-8859-1编码的,如果不设置成gbk则乱码

print(response.text)

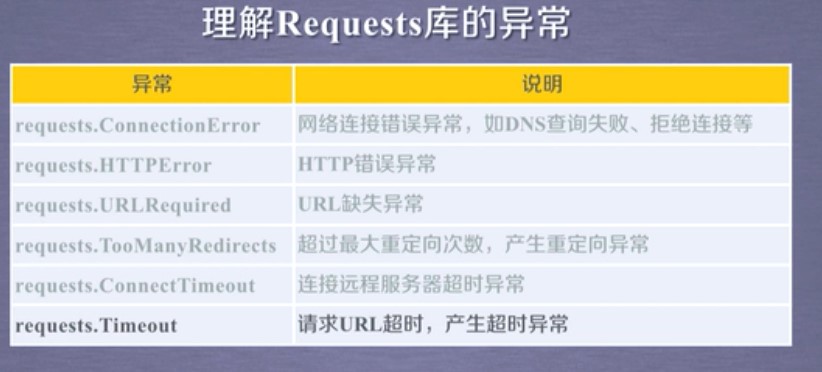

requests的库异常处理

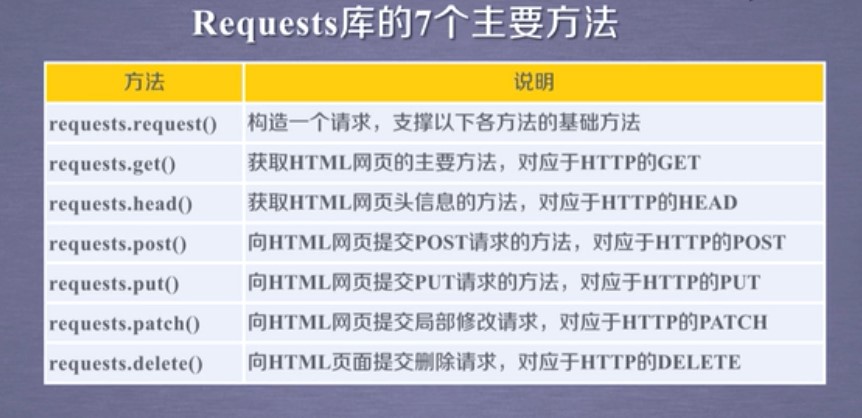

requests库的主要方法

import requests

r = requests.get('https://www.cnblogs.com/')

r = requests.head('http://httpbin.org/get')

r = requests.post('http://httpbin.org/post',key='value')

r = requests.put('http://httpbin.org/put',key='value')

r = requests.patch('http://httpbin.org/patch',key='value')

r = requests.options('http://httpbin.org/get')

r = requests.delete('http://httpbin.org/delete')

爬取网页通用框架

import requests

def get_Html(url):

try:

r = requests.get(url,timeout=30)

r.raise_for_status()

r.encoding=r.apparent_encoding

return r.text

except:

return "产生异常" if __name__=="__main__":

url = "http://www.baidu.com"

print(get_Html(url))

几个小案例

案例一 京东商品爬取

import requests

url = 'https://item.jd.com/100010131982.html'

try:

r = requests.get(url)

r.raise_for_status()

r.encoding=r.apparent_encoding

print(r.text[:1000]) #1000代表截取前1000个字符

except:

print("爬取失败")

案例二 亚马逊

import requests

url = 'https://www.amazon.cn/dp/B08531C6PV/ref=s9_acsd_hps_bw_c2_x_1_i?pf_rd_m=A1U5RCOVU0NYF2&pf_rd_s=merchandised-search-top-3&pf_rd_r=XXHRT6R61ZYZA5FGMPKJ&pf_rd_t=101&pf_rd_p=b2e55b79-7940-4444-967a-6dbe6d7cb574&pf_rd_i=1935403071'

try:

kv = {'user-agent':'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/79.0.3945.117 Safari/537.36'} #模拟浏览器

r= requests.get(url,headers = kv)

r.raise_for_status()

r.encoding=r.apparent_encoding

print(r.text[1000:2000])

except:

print("爬取失败")

案例三 百度

import requests

kv = {'wd':'python'}

r = requests.get('http://www.baidu.com/s',params=kv)

print(r.requests.url)

print(len(r.text))

等学到新的就来更新,我记得刚学的时候我就开始爬贴吧了,现在老老实实看基础了

未完待续!

爬虫之requestsku的更多相关文章

- 设计爬虫Hawk背后的故事

本文写于圣诞节北京下午慵懒的午后.本文偏技术向,不过应该大部分人能看懂. 五年之痒 2016年,能记入个人年终总结的事情没几件,其中一个便是开源了Hawk.我花不少时间优化和推广它,得到的评价还算比较 ...

- Scrapy框架爬虫初探——中关村在线手机参数数据爬取

关于Scrapy如何安装部署的文章已经相当多了,但是网上实战的例子还不是很多,近来正好在学习该爬虫框架,就简单写了个Spider Demo来实践.作为硬件数码控,我选择了经常光顾的中关村在线的手机页面 ...

- Python 爬虫模拟登陆知乎

在之前写过一篇使用python爬虫爬取电影天堂资源的博客,重点是如何解析页面和提高爬虫的效率.由于电影天堂上的资源获取权限是所有人都一样的,所以不需要进行登录验证操作,写完那篇文章后又花了些时间研究了 ...

- scrapy爬虫docker部署

spider_docker 接我上篇博客,为爬虫引用创建container,包括的模块:scrapy, mongo, celery, rabbitmq,连接https://github.com/Liu ...

- scrapy 知乎用户信息爬虫

zhihu_spider 此项目的功能是爬取知乎用户信息以及人际拓扑关系,爬虫框架使用scrapy,数据存储使用mongo,下载这些数据感觉也没什么用,就当为大家学习scrapy提供一个例子吧.代码地 ...

- 120项改进:开源超级爬虫Hawk 2.0 重磅发布!

沙漠君在历时半年,修改无数bug,更新一票新功能后,在今天隆重推出最新改进的超级爬虫Hawk 2.0! 啥?你不知道Hawk干吗用的? 这是采集数据的挖掘机,网络猎杀的重狙!半年多以前,沙漠君写了一篇 ...

- Python爬虫小白入门(四)PhatomJS+Selenium第一篇

一.前言 在上一篇博文中,我们的爬虫面临着一个问题,在爬取Unsplash网站的时候,由于网站是下拉刷新,并没有分页.所以不能够通过页码获取页面的url来分别发送网络请求.我也尝试了其他方式,比如下拉 ...

- Python多线程爬虫爬取电影天堂资源

最近花些时间学习了一下Python,并写了一个多线程的爬虫程序来获取电影天堂上资源的迅雷下载地址,代码已经上传到GitHub上了,需要的同学可以自行下载.刚开始学习python希望可以获得宝贵的意见. ...

- QQ空间动态爬虫

作者:虚静 链接:https://zhuanlan.zhihu.com/p/24656161 来源:知乎 著作权归作者所有.商业转载请联系作者获得授权,非商业转载请注明出处. 先说明几件事: 题目的意 ...

随机推荐

- 收集到的技术相关网址——delphi

1.DLL封装登录框架实现代码复用 https://www.cnblogs.com/wenwencao/articles/1333659.html

- django项目导航页_20191128

django项目导航页_20191128 第一步:python-django电商项目-需求分析架构设计数据库设计_20191115 python-django-linux上mysql的安装和配置_20 ...

- python学习笔记(0)python基础概念

一.字符集 说字符集之前,先说下2进制的故事,计算机比较傻只认识2进制,什么是2进制,就是0,1,计算机只认识这俩数字,其他的都不认识,这样的0或1为一"位",规定8位为一个字节, ...

- Java IO: 字符流的Piped和CharArray

作者: Jakob Jenkov 译者: 李璟(jlee381344197@gmail.com) 本章节将简要介绍管道与字符数组相关的reader和writer,主要涉及PipedReader.Pip ...

- JQ主页图片划动切换效果

.wrapper { width: 726px; float: left; } #jiao_dian { width: 980px; *height: 292px; margin-top: 10px; ...

- com.spotify:docker-maven-plugin 报localhost:2375 Connection refused 错误

当用maven build项目时出现了如下错误: Failed to execute goal com.spotify:docker-maven-plugin:0.4.13:build (defaul ...

- 一次面试留下的实际应用问题。关于HttpModule,IIS集成模式。

资料来自<IIS7开发与管理完全手册> 周五面试时有点紧张,没能静下心思考,当时隐约想到这个解决方案,但因面试环境和心态确未能明确的表述. 回家的地铁上已经找到解决办法. 要点:1基于IH ...

- Web of science|SCIE|影响因子|SSCI|高被引论文|领域中热点论文|

信息检索: 数据库 Web of science 影响因子只是针对期刊打分,并不是对文章打分.所以对文章评价可以看引用次数. SCIE (Science Citation Index Expanded ...

- UML 类图介绍

UML 类图介绍 一. UML 简介 UML ( Unified Modeling Language )即统一建模语言,是 OMG ( Object Management Group )发表的图标式软 ...

- python 组件

组件:JQueryUI.EasyUI.BootStrap 每一个框架都要学习它们的规则.