再谈汤普森采样(Thompson Sampling)

相关:

python语言绘图:绘制一组以beta分布为先验,以二项分布为似然的贝叶斯后验分布图

在线学习(MAB)与强化学习(RL)[2]:IID Bandit的一些算法

外网教程:

https://web.stanford.edu/~bvr/pubs/TS_Tutorial.pdf

国内教程:

=====================================

之前已经share了多篇相关的post,最近看到了一个新的这方面的东西,就想着再谈下这个问题。汤普森采样(Thompson Sampling)是MAB(Multi arm bandit)问题中经常被讨论的一种均衡exploit和explore的方法,之前已经解释了很多相关的资料,最近看到了些不一样的东西,之前share的汤普森采样(Thompson Sampling)都是使用beta分布做先验和后验的,不过发现最近发现也有使用正态分布做先验和后验的。

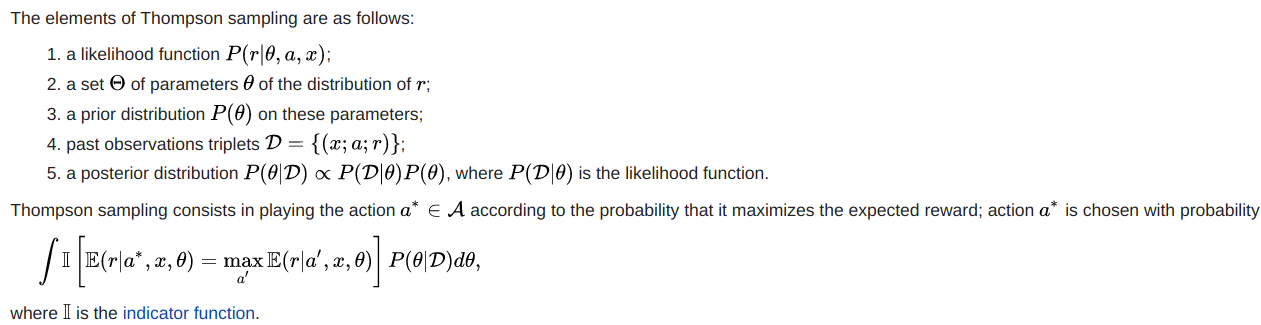

根据维基百科上的Thompson sampling的定义:

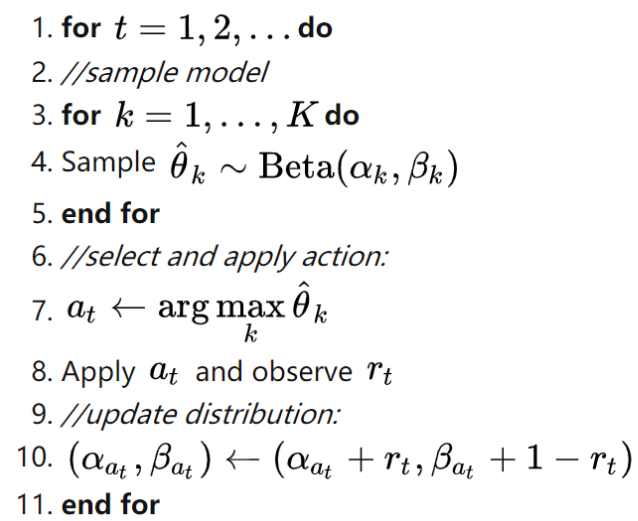

可以看到,汤普森采样(Thompson Sampling)并不是一定要用beta分布的,汤普森采样(Thompson Sampling)其实核心就是利用贝叶斯公式在抽样时评估哪个抽样的最优可能性更高。我们在使用汤普森采样(Thompson Sampling)时需要先设置先验概率分布和似然概率分布,而且我们还需要保证获得的后验概率分布和先验概率分布是共轭的,这样就可以不断的根据抽样的次数来进行迭代评估。我们最常用的汤普森采样(Thompson Sampling)就是伯努利-汤普森采样(Bernoulli Thompson Sampling),也就是使用beta分布作为先验分布和后验分布,使用二项分布作为似然函数的方法,大致形式的伪代码如下:

伯努利-汤普森采样(Bernoulli Thompson Sampling)

其中的核心代码为: (参考:https://zhuanlan.zhihu.com/p/36199435)

import numpy as np import pymc # wins 和 trials 都是一个 N 维向量,N 是臂的个数 # wins 表示所有臂的 α 参数,loses 表示所有臂的 β 参数 choice = np.argmax(pymc.rbeta(1 + wins, 1 + loses, len(wins)))

可以看到,伯努利-汤普森采样(Bernoulli Thompson Sampling)很大的一个局限性就是使用二项分布作为似然函数,因为这样我们每次抽样的结果都只能是0或1,也就是发生或没发生,而在MAB(Multi arm bandit)问题中我们采样的reward的形式有的时候是0或1,但是也存在多个离散值,甚至是连续值的reward,这样就不适用伯努利-汤普森采样(Bernoulli Thompson Sampling),该种情况下我们可以使用高斯-汤普森采样(Gaussian Thompson Sampling)。

高斯-汤普森采样(Gaussian Thompson Sampling)

这里不给出具体的数学推导公式及证明了,原有有两点:1.是没有那么多精力写这些旁支内容;2.是本人也确实不会这东西的推导和证明。

直接给出Python代码:(https://github.com/mimoralea/gdrl)

def thompson_sampling(env,

alpha=1,

beta=0,

n_episodes=1000):

Q = np.zeros((env.action_space.n), dtype=np.float64)

N = np.zeros((env.action_space.n), dtype=np.int) Qe = np.empty((n_episodes, env.action_space.n), dtype=np.float64)

returns = np.empty(n_episodes, dtype=np.float64)

actions = np.empty(n_episodes, dtype=np.int)

name = 'Thompson Sampling {}, {}'.format(alpha, beta)

for e in tqdm(range(n_episodes),

desc='Episodes for: ' + name,

leave=False):

samples = np.random.normal(

loc=Q, scale=alpha/(np.sqrt(N) + beta))

action = np.argmax(samples) _, reward, _, _ = env.step(action)

N[action] += 1

Q[action] = Q[action] + (reward - Q[action])/N[action] Qe[e] = Q

returns[e] = reward

actions[e] = action

return name, returns, Qe, actions

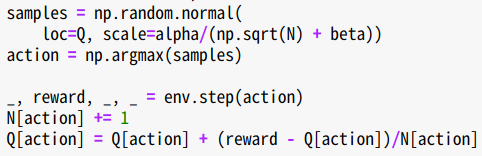

核心代码部分:

也就是说,高斯-汤普森采样(Gaussian Thompson Sampling)是使用正态分布作为先验和后验的,每次抽样后我都只需要更新对应arm的正态分布中的均值和方差即可。需要注意的是高斯分布也是共轭分布。

--------------------------------------------------

在外网找到了些关于汤普森采样(Thompson Sampling)不错的资料:

https://towardsdatascience.com/thompson-sampling-fc28817eacb8

https://web.stanford.edu/~bvr/pubs/TS_Tutorial.pdf

====================================

同时也给出其他的采样方法:

softmax采样:

def softmax(env,

init_temp=float('inf'),

min_temp=0.0,

decay_ratio=0.04,

n_episodes=1000):

Q = np.zeros((env.action_space.n), dtype=np.float64)

N = np.zeros((env.action_space.n), dtype=np.int) Qe = np.empty((n_episodes, env.action_space.n), dtype=np.float64)

returns = np.empty(n_episodes, dtype=np.float64)

actions = np.empty(n_episodes, dtype=np.int)

name = 'Lin SoftMax {}, {}, {}'.format(init_temp,

min_temp,

decay_ratio)

# can't really use infinity

init_temp = min(init_temp,

sys.float_info.max)

# can't really use zero

min_temp = max(min_temp,

np.nextafter(np.float32(0),

np.float32(1)))

for e in tqdm(range(n_episodes),

desc='Episodes for: ' + name,

leave=False):

decay_episodes = n_episodes * decay_ratio

temp = 1 - e / decay_episodes

temp *= init_temp - min_temp

temp += min_temp

temp = np.clip(temp, min_temp, init_temp) scaled_Q = Q / temp

norm_Q = scaled_Q - np.max(scaled_Q)

exp_Q = np.exp(norm_Q)

probs = exp_Q / np.sum(exp_Q)

assert np.isclose(probs.sum(), 1.0) action = np.random.choice(np.arange(len(probs)),

size=1,

p=probs)[0] _, reward, _, _ = env.step(action)

N[action] += 1

Q[action] = Q[action] + (reward - Q[action])/N[action] Qe[e] = Q

returns[e] = reward

actions[e] = action

return name, returns, Qe, actions

上置信采样Upper confidence bound(UCB):

def upper_confidence_bound(env,

c=2,

n_episodes=1000):

Q = np.zeros((env.action_space.n), dtype=np.float64)

N = np.zeros((env.action_space.n), dtype=np.int) Qe = np.empty((n_episodes, env.action_space.n), dtype=np.float64)

returns = np.empty(n_episodes, dtype=np.float64)

actions = np.empty(n_episodes, dtype=np.int)

name = 'UCB {}'.format(c)

for e in tqdm(range(n_episodes),

desc='Episodes for: ' + name,

leave=False):

action = e

if e >= len(Q):

U = c * np.sqrt(np.log(e)/N)

action = np.argmax(Q + U) _, reward, _, _ = env.step(action)

N[action] += 1

Q[action] = Q[action] + (reward - Q[action])/N[action] Qe[e] = Q

returns[e] = reward

actions[e] = action

return name, returns, Qe, actions

注意本文中定义的Python函数块内代码内容遵守BSD 3-Clause License协议,协议内容:

BSD 3-Clause License Copyright (c) 2018, Miguel Morales

All rights reserved. Redistribution and use in source and binary forms, with or without

modification, are permitted provided that the following conditions are met: * Redistributions of source code must retain the above copyright notice, this

list of conditions and the following disclaimer. * Redistributions in binary form must reproduce the above copyright notice,

this list of conditions and the following disclaimer in the documentation

and/or other materials provided with the distribution. * Neither the name of the copyright holder nor the names of its

contributors may be used to endorse or promote products derived from

this software without specific prior written permission. THIS SOFTWARE IS PROVIDED BY THE COPYRIGHT HOLDERS AND CONTRIBUTORS "AS IS"

AND ANY EXPRESS OR IMPLIED WARRANTIES, INCLUDING, BUT NOT LIMITED TO, THE

IMPLIED WARRANTIES OF MERCHANTABILITY AND FITNESS FOR A PARTICULAR PURPOSE ARE

DISCLAIMED. IN NO EVENT SHALL THE COPYRIGHT HOLDER OR CONTRIBUTORS BE LIABLE

FOR ANY DIRECT, INDIRECT, INCIDENTAL, SPECIAL, EXEMPLARY, OR CONSEQUENTIAL

DAMAGES (INCLUDING, BUT NOT LIMITED TO, PROCUREMENT OF SUBSTITUTE GOODS OR

SERVICES; LOSS OF USE, DATA, OR PROFITS; OR BUSINESS INTERRUPTION) HOWEVER

CAUSED AND ON ANY THEORY OF LIABILITY, WHETHER IN CONTRACT, STRICT LIABILITY,

OR TORT (INCLUDING NEGLIGENCE OR OTHERWISE) ARISING IN ANY WAY OUT OF THE USE

OF THIS SOFTWARE, EVEN IF ADVISED OF THE POSSIBILITY OF SUCH DAMAGE.

再谈汤普森采样(Thompson Sampling)的更多相关文章

- 推荐算法之Thompson(汤普森)采样

如果想理解汤普森采样算法,就必须先熟悉了解贝塔分布. 一.Beta(贝塔)分布 Beta分布是一个定义在[0,1]区间上的连续概率分布族,它有两个正值参数,称为形状参数,一般用α和β表示,Beta分布 ...

- 随机采样和随机模拟:吉布斯采样Gibbs Sampling

http://blog.csdn.net/pipisorry/article/details/51373090 吉布斯采样算法详解 为什么要用吉布斯采样 通俗解释一下什么是sampling. samp ...

- 470. Implement Rand10() Using Rand7() (拒绝采样Reject Sampling)

1. 问题 已提供一个Rand7()的API可以随机生成1到7的数字,使用Rand7实现Rand10,Rand10可以随机生成1到10的数字. 2. 思路 简单说: (1)通过(Rand N - 1) ...

- [DeeplearningAI笔记]序列模型2.7负采样Negative sampling

5.2自然语言处理 觉得有用的话,欢迎一起讨论相互学习~Follow Me 2.7 负采样 Negative sampling Mikolov T, Sutskever I, Chen K, et a ...

- [转载]再谈百度:KPI、无人机,以及一个必须给父母看的案例

[转载]再谈百度:KPI.无人机,以及一个必须给父母看的案例 发表于 2016-03-15 | 0 Comments | 阅读次数 33 原文: 再谈百度:KPI.无人机,以及一个必须 ...

- Support Vector Machine (3) : 再谈泛化误差(Generalization Error)

目录 Support Vector Machine (1) : 简单SVM原理 Support Vector Machine (2) : Sequential Minimal Optimization ...

- 【转载】Recommendations with Thompson Sampling (Part II)

[原文链接:http://engineering.richrelevance.com/recommendations-thompson-sampling/.] [本文链接:http://www.cnb ...

- Unity教程之再谈Unity中的优化技术

这是从 Unity教程之再谈Unity中的优化技术 这篇文章里提取出来的一部分,这篇文章让我学到了挺多可能我应该知道却还没知道的知识,写的挺好的 优化几何体 这一步主要是为了针对性能瓶颈中的”顶点 ...

- 浅谈HTTP中Get与Post的区别/HTTP协议与HTML表单(再谈GET与POST的区别)

HTTP协议与HTML表单(再谈GET与POST的区别) GET方式在request-line中传送数据:POST方式在request-line及request-body中均可以传送数据. http: ...

- Another Look at Events(再谈Events)

转载:http://www.qtcn.org/bbs/simple/?t31383.html Another Look at Events(再谈Events) 最近在学习Qt事件处理的时候发现一篇很不 ...

随机推荐

- BC6-牛牛的第二个整数

题目描述 牛牛从键盘上输入三个整数,并尝试在屏幕上显示第二个整数. 输入描述 一行输入 3 个整数,用空格隔开. 输出描述 请输出第二个整数的值. 示例 1 输入:1 2 3 输出:2 解题思路 方案 ...

- MySql 中 select 使用

MySql select 多种查询方式 前言 在数据库使用过程中,使用最多的场景就是查询数据,所以今天我们总结一下常用用的查询 简单查询 带条件查询 多条件查询 输出指定字段查询 分组查询 查询结果排 ...

- mybatis sqlmap sql in 查询

<select id="selectBlogs" parameterType="map"> SELECT * FROM blog WHERE use ...

- WPF/C#:如何将数据分组显示

WPF Samples中的示例 在WPF Samples中有一个关于Grouping的Demo. 该Demo结构如下: MainWindow.xaml如下: <Window x:Class=&q ...

- 结构型模式(Structural Pattern)

模式介绍 结构型模式(Structural Pattern)的主要目的就是将不同的类和对象组合在一起,形成更大或者更复杂的结构体.该模式并不是简单地将这些类或对象摆放在一起,而是要提供它们之间的关联方 ...

- 17-Docker镜像和容器操作

镜像 拉取镜像(下载镜像) 镜像是层次型的,拉取的时候会按照各层分别拉取. 每一个镜像都有自己的散列值,用来唯一标记一层镜像,可以用来判断本地是否已经拉取过此镜像层,如果已经拉取,则直接使用. doc ...

- dotnet 融合 Avalonia 和 UNO 框架

现在在 .NET 系列里面,势头比较猛的 UI 框架中,就包括了 Avalonia 和 UNO 框架.本文将告诉大家如何尝试在一个解决方案里面融合 Avalonia 和 UNO 两个框架,即在一个进程 ...

- mtr和traceroute的区别,以及为什么traceroute不显示路径mtr却可以显示路径

最近工作主要都是网络策略的开通和网络测试,在测试的过程当中发现当网络不通时,用traceroute来看路由路径的时候总是无法显示出来,于是就换了个工具-mtr,发现mtr可以正常显示出路由路径,帮助我 ...

- OPC 数据采集 解决方案

笔者计划从此篇博客开始,详细介绍OPC数据采集采集过程.包括常用组态软件介绍,数据接入,OPC接入过程,常用OPC数据接入与处理全流程范例,分享相关案例Demo. 因为分享的都是个人实际工作经验中的 ...

- .Net Core 2.2 Areas 路由,第一个MapAreaRoute 设置匹配多个Controller

.h2 { background-color: rgba(78, 110, 242, 1); color: rgba(255, 255, 255, 1); padding: 10px } 在.Net ...