循环神经网络-极其详细的推导BPTT

首先明确一下,本文需要对RNN有一定的了解,而且本文只针对标准的网络结构,旨在彻底搞清楚反向传播和BPTT。

反向传播形象描述

什么是反向传播?传播的是什么?传播的是误差,根据误差进行调整。

举个例子:你去买苹果,你说,老板,来20块钱苹果(目标,真实值),老板开始往袋子里装苹果,感觉差不多了(预测),放称上一称,还差点(误差),又装了一个,还差点(调整一次之后的误差),又装了一个...迭代,直到20块钱。

注意每次都是根据误差来进行调整,这点谨记。

BPTT 剖析

RNN网络结构比较复杂,BPTT在梯度计算时也不同于常规。

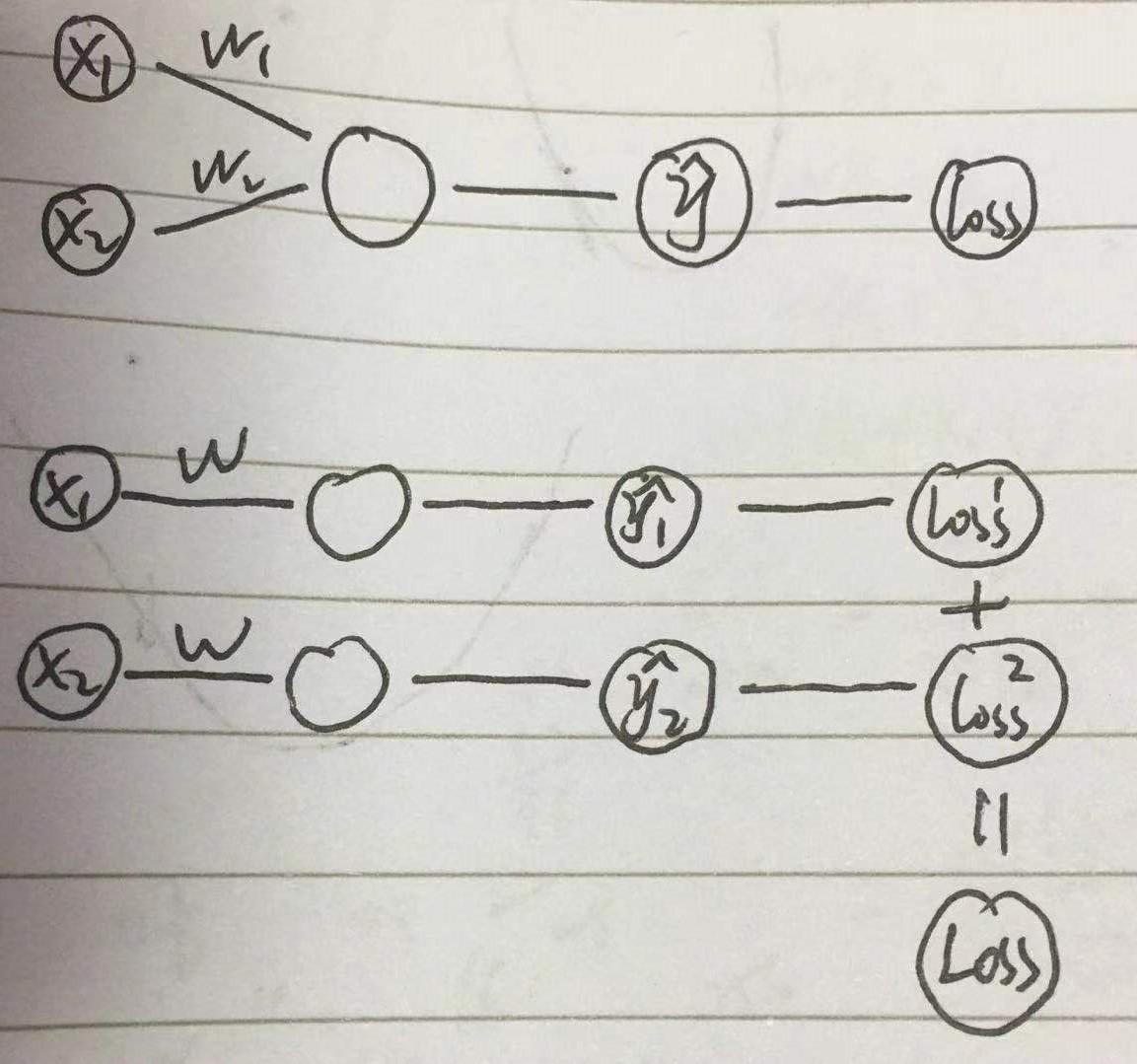

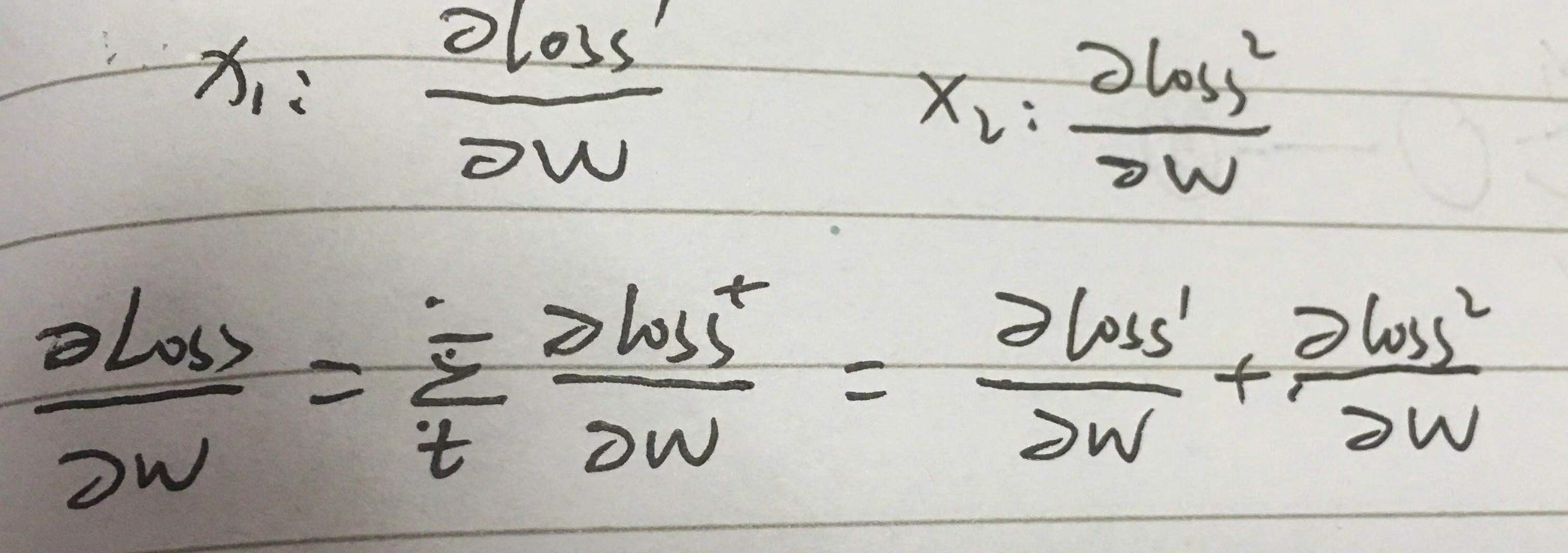

不同1:权重共享,多个误差

常规是误差分两条路传递,然后每条路分别算w,很容易理解

而权重共享时,一个权重,生成了2个误差,还有个总误差,到底用哪个?怎么反向?假设能反向回去,2个w,怎么处理?咋一想,好乱,

其实是这样的

1. 总误差,分误差,其实是一样的

2. 2个w,需要求和。

一个权重,多个误差,求和

不同2:权重共享,链式传递

也是2个w,咋一看,不知道咋算。

其实是这样的

链式法则

一个权重,多次传递,其梯度中含有w,且容易看出,传递次数越多,w的指数越大

其实rnn比这些不同点更复杂

图不解释了,直接上干货。

首先对网上各种坑爹教程进行补充和完善,总结,当然虽然坑爹,但是对我们理解也是有帮助的。

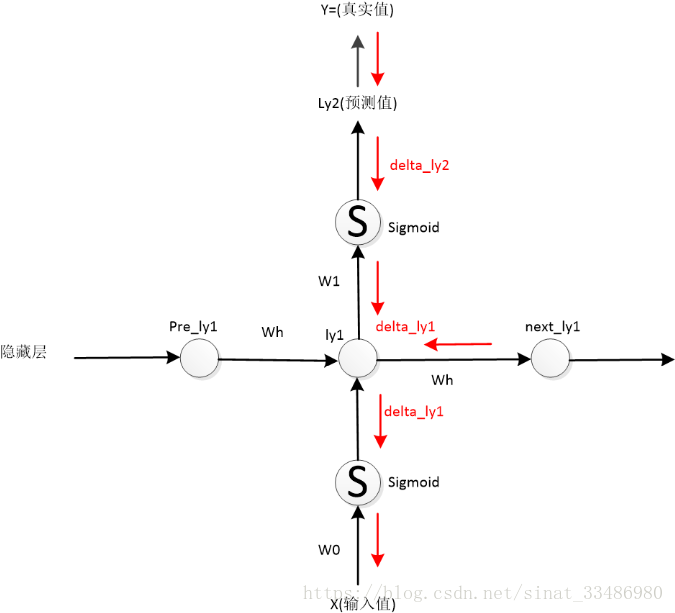

教程1:教程描述ly1的误差来自ly2 和 next_ly1两个方向(下图),其实说法不错,只是不完整。

补充:

1. ly1的误差来自两个方向,ly2和next_ly1,这两条路都要从各自的误差开始算起。(这里体现了我上面例子里提醒谨记的话)

2. 这里计算的是“单层”的梯度,即单个w的梯度,实际计算BPTT梯度时并不是这样。

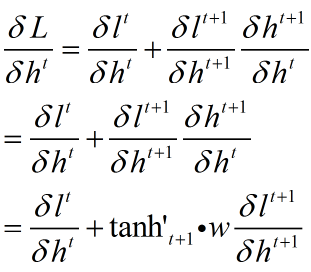

这里的公式应该是这样子

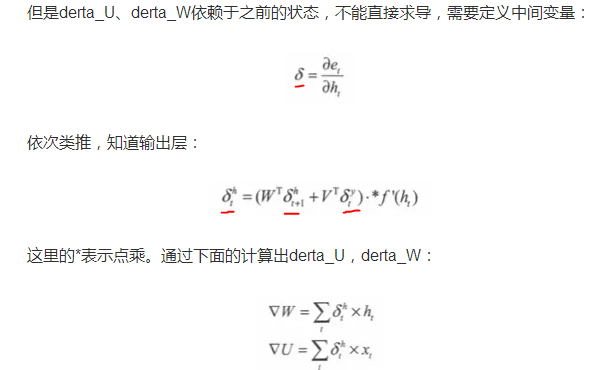

教程2:教程定义了中间变量,并用中间变量来表示梯度

各种δ,完全搞不清,公式也没有推导过程。

补充:这里针对单个节点自定义了变量,然后把每个节点直接相加得到总梯度。

总结:这里定义了中间变量δ,之所以定义这个,是因为这个计算比较麻烦,而且要经常用到,这样会很好地简化运算。

这里的公式应该是这样子

这些教程加上我的补充,其实已经可以算出梯度了。

下面我再系统的讲一遍BPTT

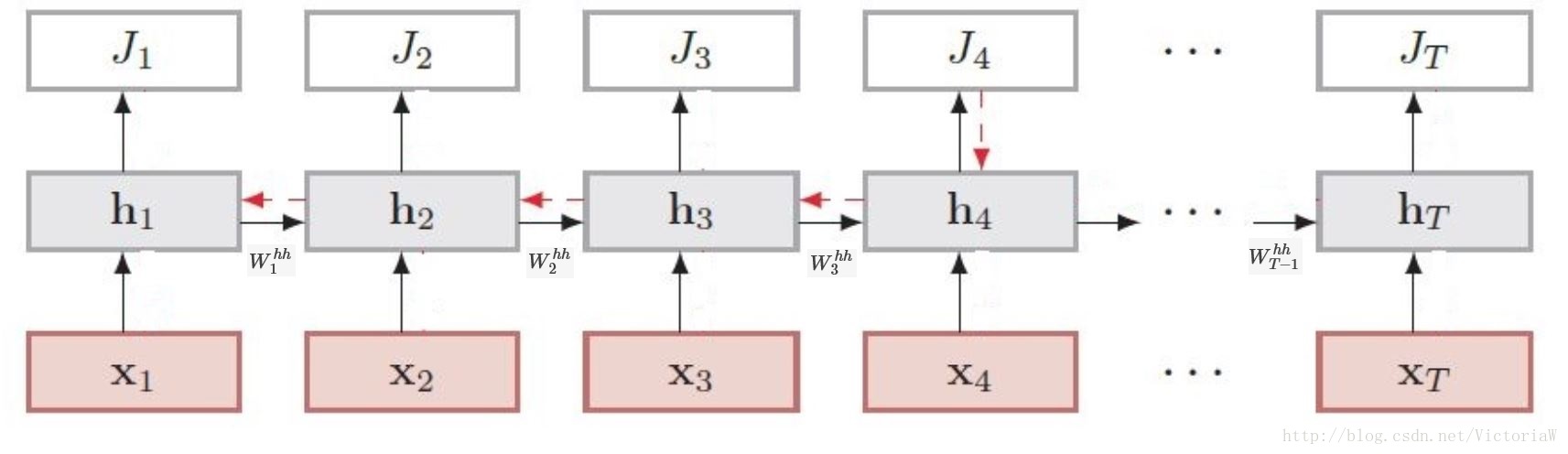

还是用这张图,这张图在整个网络架构上比较完整,但是缺乏完整的cell,我在前向传播中标记一下。

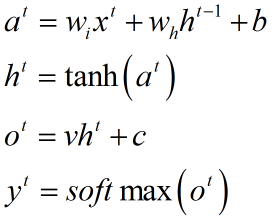

前向传播

wi 表示输入权重,wh表示隐层权重

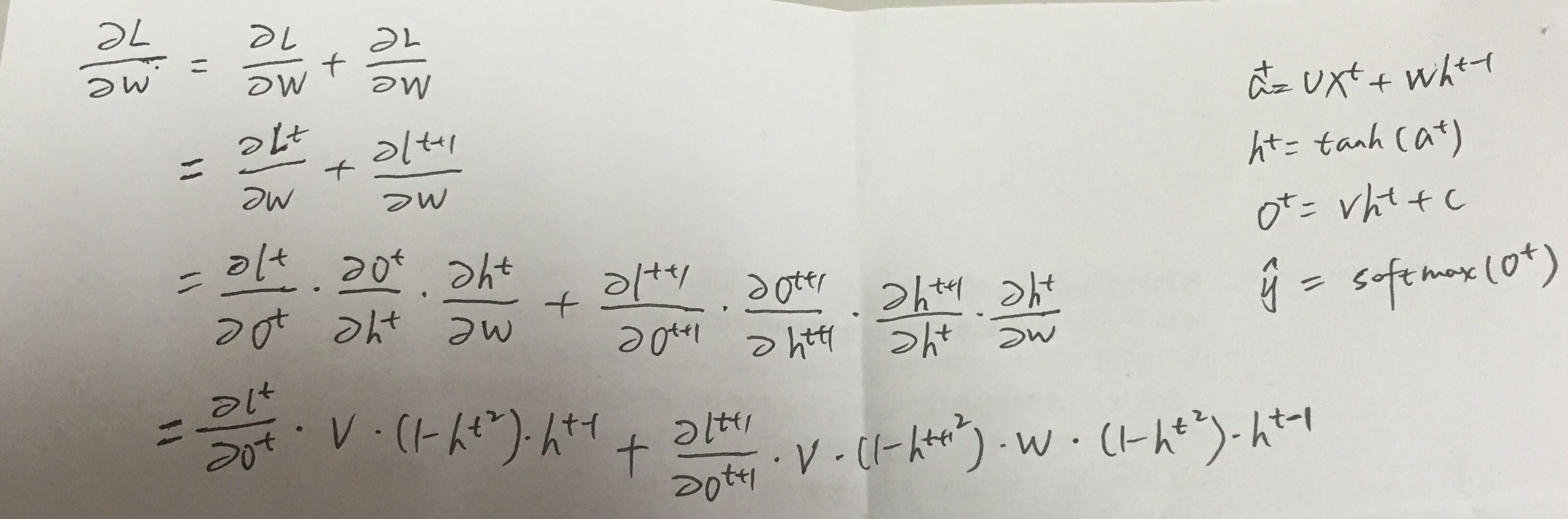

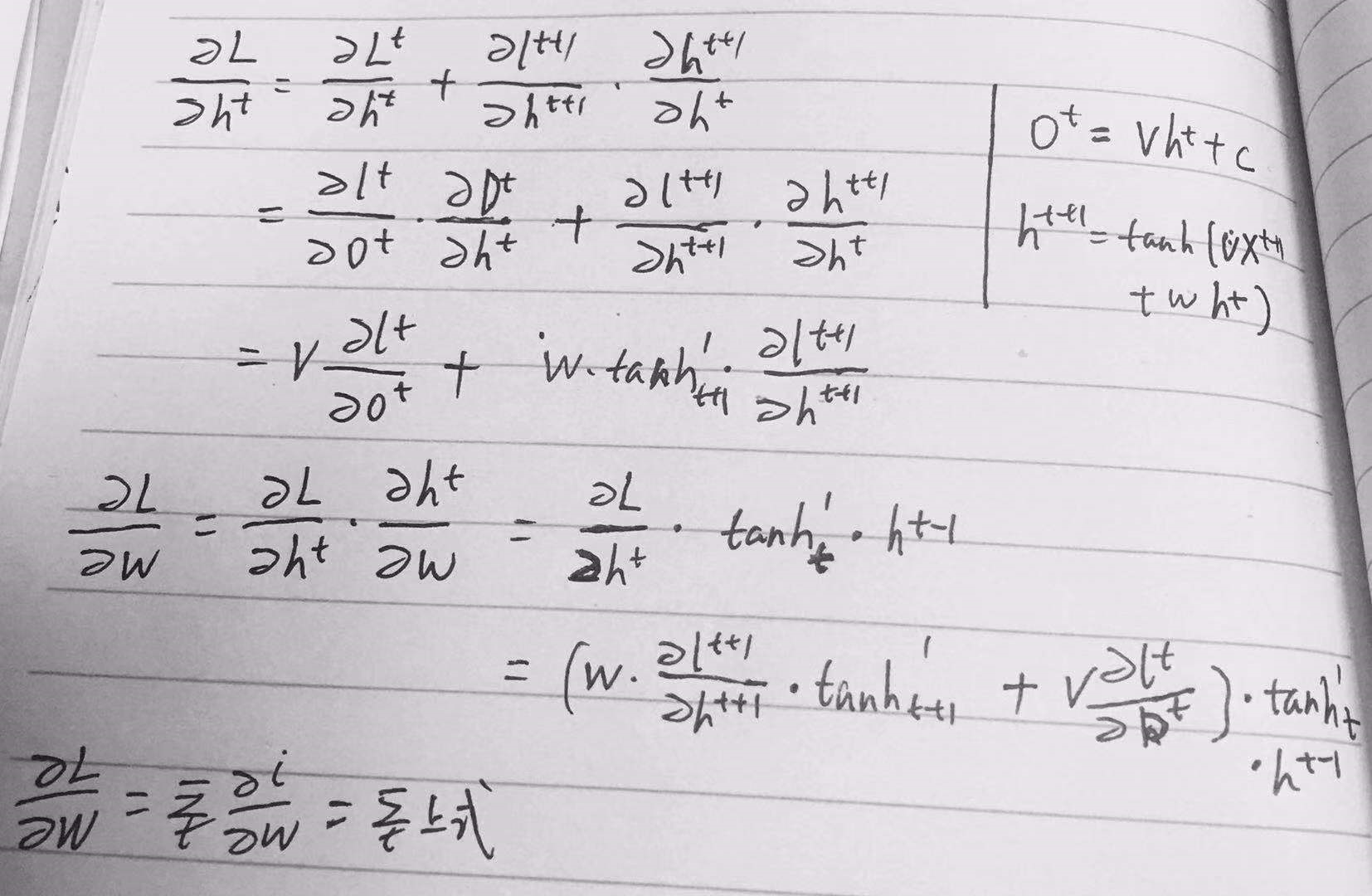

反向传播

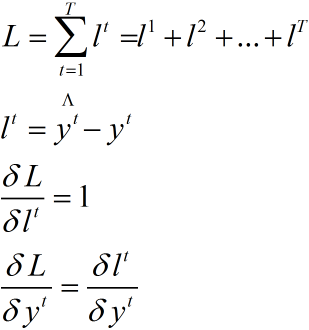

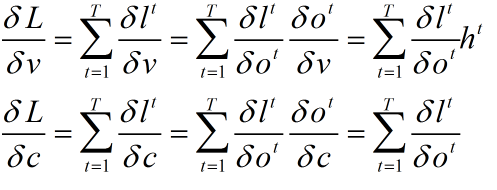

首先理解如下公式

1. v 和 c并没有多路传递误差,和普通的梯度计算无差别

2. wi wh b都有多路传播

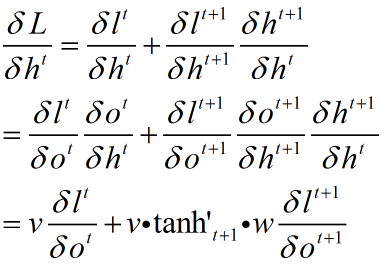

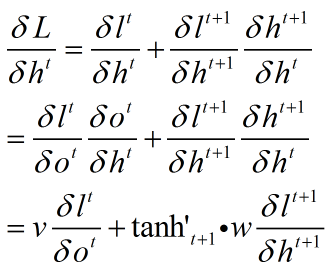

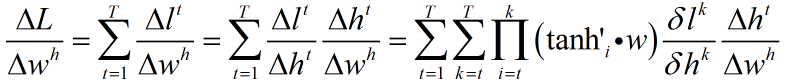

同样设定中间变量,注意这个变量最好是个递推公式,能够大大简化运算,且容易得到规律

初步设定

优化

再优化

这样貌似好多了,递推下去

注意到这里还是传递误差,从上式大概可以看出

1. 这是t时刻隐层cell的误差 ,当然要乘以总误差

2. t时刻的误差是t时刻到T的一个和,也就是说是从终点一步一步传过来的

3. 每步传递都是从t时刻到传递时刻的连乘,w指数。

4. 大概是这样 w * losst1 + ww * losst2 + www * losst3 + wwww * losst4 + wwwww * losst5 ,越往前传这个式子越长,损失也越传越小

5. 加上激活函数的搅和,其导数经常小于1

wi同理

循环神经网络-极其详细的推导BPTT的更多相关文章

- 循环神经网络-RNN进阶

这部分许多内容要类比CNN来进行理解和解释,所以需要对CNN比较熟悉. RNN的特点 1. 权值共享 CNN权值共享,RNN也有权值共享,在入门篇可以看到RNN结构图中,权重使用的是同样的字母 为什么 ...

- 详解循环神经网络(Recurrent Neural Network)

本文结构: 模型 训练算法 基于 RNN 的语言模型例子 代码实现 1. 模型 和全连接网络的区别 更细致到向量级的连接图 为什么循环神经网络可以往前看任意多个输入值 循环神经网络种类繁多,今天只看最 ...

- Recurrent Neural Network系列1--RNN(循环神经网络)概述

作者:zhbzz2007 出处:http://www.cnblogs.com/zhbzz2007 欢迎转载,也请保留这段声明.谢谢! 本文翻译自 RECURRENT NEURAL NETWORKS T ...

- Recurrent Neural Network(循环神经网络)

Reference: Alex Graves的[Supervised Sequence Labelling with RecurrentNeural Networks] Alex是RNN最著名变种 ...

- 循环神经网络(RNN, Recurrent Neural Networks)介绍(转载)

循环神经网络(RNN, Recurrent Neural Networks)介绍 这篇文章很多内容是参考:http://www.wildml.com/2015/09/recurrent-neur ...

- CNN(卷积神经网络)、RNN(循环神经网络)、DNN(深度神经网络)的内部网络结构有什么区别?

https://www.zhihu.com/question/34681168 CNN(卷积神经网络).RNN(循环神经网络).DNN(深度神经网络)的内部网络结构有什么区别?修改 CNN(卷积神经网 ...

- 循环神经网络(RNN)模型与前向反向传播算法

在前面我们讲到了DNN,以及DNN的特例CNN的模型和前向反向传播算法,这些算法都是前向反馈的,模型的输出和模型本身没有关联关系.今天我们就讨论另一类输出和模型间有反馈的神经网络:循环神经网络(Rec ...

- 深度学习之循环神经网络(RNN)

循环神经网络(Recurrent Neural Network,RNN)是一类具有短期记忆能力的神经网络,适合用于处理视频.语音.文本等与时序相关的问题.在循环神经网络中,神经元不但可以接收其他神经元 ...

- Recurrent Neural Networks(RNN) 循环神经网络初探

1. 针对机器学习/深度神经网络“记忆能力”的讨论 0x1:数据规律的本质是能代表此类数据的通用模式 - 数据挖掘的本质是在进行模式提取 数据的本质是存储信息的介质,而模式(pattern)是信息的一 ...

随机推荐

- 纯CSS方块转化梯形动画

http://jasonning92.github.io/JasonsBlog/pages/%E7%BA%AFCSS%E6%96%B9%E5%9D%97%E8%BD%AC%E5%8C%96%E6%A2 ...

- yii框架中获取添加数据后的id值

Yii::$app->db->createCommand()->insert('month4_user',['openid'=>$openid,'integ'=>0])- ...

- ActiveMQ的学习整理(代码实现PTP,以及Pub/Sub)

(一)由于在实习过程中需要用到ActiveMQ,在网上看了很多文章,现在整理出来以防忘记. (二)这篇文章比较适合之前没有接触过的同学,在看下面文章的过程中,建议先学习参考链接中的知识点,然后自己再参 ...

- 多线程总结2之volatile和synchronized(转)

本文转自 http://www.jasongj.com/java/thread_safe/ 一.多线程编程中的三个核心概念 本篇文章将从这三个问题出发,结合实例详解volatile如何保证可见性及一定 ...

- 微信公众号使用LocalStorage解决返回缓存问题

在开发微信公众号上应用程序时,遇到了一个普遍的问题,从A页跳转到B页后,再由B页跳转回A页,A要要保持跟跳转前一致,通过LocalStorage可以解决. LocalStorage,很好的解决了返回的 ...

- 集成学习二: Boosting

目录 集成学习二: Boosting 引言 Adaboost Adaboost 算法 前向分步算法 前向分步算法 Boosting Tree 回归树 提升回归树 Gradient Boosting 参 ...

- 【转】JavaScript => TypeScript 入门

几个月前把 ES6 的特性都过了一遍,收获颇丰.现在继续来看看 TypesScript(下文简称为 “TS”).限于经验,本文一些总结如有不当,欢迎指正. 官网有这样一段描述: TypeScript ...

- python3- __slots__

Python允许在定义class的时候,定义一个特殊的__slots__变量,来限制该class实例能添加的属性: class Student(object): __slots__ = ('name' ...

- swiper添加了自动滚动效果,然后用手指划过页面,发现自动滚动效果不生效了

我给swiper添加了自动滚动效果,然后用手指划过页面,发现自动滚动效果不生效了,哪里出了问题呢? 添加参数 autoplayDisableOnInteraction : false,

- eclipse安装springboot插件

1.工具栏->Help->Eclise Marketplace打开应用市场 2.在应用市场中搜索sts,选择Spring Tools 4紧张安装 3.按提示进行安装