scikit-learn中机器学习模型比较(逻辑回归与KNN)

本文源自于Kevin Markham 的模型评估:https://github.com/justmarkham/scikit-learn-videos/blob/master/05_model_evaluation.ipynb

- 我的监督学习应该使用哪一个模型

- 我的模型中应该选择那些调整参数

- 如何估计模型在样本数据外的表现

- 分类任务:预测未知鸢尾花的种类

- 用三个分类模型:KNN(K=1),KNN(K=5),逻辑回归

- 需要一个选择模型的方法:模型评估

1. 训练测试整个数据集

在整个数集上进行训练,然后用同一个数集进行测试,评估准确度。

1 from sklearn.datasets import load_iris

2 from sklearn.linear_model import LogisticRegression

3

4 # 1.read in the iris data

5 iris=load_iris()

6 X=iris.data

7 Y=iris.target

8 # print(X)

9 # print(Y)

10

11 # 2.logistic regression

12 logreg=LogisticRegression()

13 logreg.fit(X,Y)

14 y_pred=logreg.predict(X)

15 print(len(y_pred))

from sklearn.datasets import load_iris

from sklearn.linear_model import LogisticRegression

from sklearn import metrics

from sklearn.neighbors import KNeighborsClassifier # 1.read in the iris data

iris=load_iris()

X=iris.data

Y=iris.target

# print(X)

# print(Y) # 2.logistic regression

logreg=LogisticRegression(solver='liblinear',multi_class='ovr')

logreg.fit(X,Y)

y_logreg_pred=logreg.predict(X)

print(len(y_logreg_pred))

print(metrics.accuracy_score(Y,y_logreg_pred)) # 3.KNN=5

knn=KNeighborsClassifier(n_neighbors=5)

knn.fit(X,Y)

y_knn5_pred=knn.predict(X)

print(len(y_knn5_pred))

print(metrics.accuracy_score(Y,y_knn5_pred)) # 4.KNN=1

knn=KNeighborsClassifier(n_neighbors=1)

knn.fit(X,Y)

y_knn1_pred=knn.predict(X)

print(len(y_knn1_pred))

print(metrics.accuracy_score(Y,y_knn1_pred))

问题:

问题:- 目标是评测模型样本以外的数据表现

- 但是,最大化培训精度奖励过于复杂的模型,模型不能泛化

- 不必要的复杂模型过度拟合

2. 分开训练和测试集

将数据集一分为二,一部分用于训练,另一部分用于测试。

from sklearn.datasets import load_iris

from sklearn.linear_model import LogisticRegression

from sklearn import metrics

from sklearn.neighbors import KNeighborsClassifier

from sklearn.model_selection import train_test_split # 1.read in the iris data

iris=load_iris()

X=iris.data

Y=iris.target # 2.split X,Y

x_train,x_test,y_train,y_test=train_test_split(X,Y,test_size=0.4,random_state=4)

print(x_train.shape)

print(x_test.shape)

print(y_train.shape)

print(y_test.shape) # 3.logistic regression

logreg=LogisticRegression(solver='liblinear',multi_class='ovr')

logreg.fit(x_train,y_train)

y_logreg_pred=logreg.predict(x_test)

print(metrics.accuracy_score(y_test,y_logreg_pred)) # 3.KNN=5

knn=KNeighborsClassifier(n_neighbors=5)

knn.fit(x_train,y_train)

y_knn5_pred=knn.predict(x_test)

print(metrics.accuracy_score(y_test,y_knn5_pred)) # 4.KNN=1

knn=KNeighborsClassifier(n_neighbors=1)

knn.fit(x_train,y_train)

y_knn1_pred=knn.predict(x_test)

print(metrics.accuracy_score(y_test,y_knn1_pred))

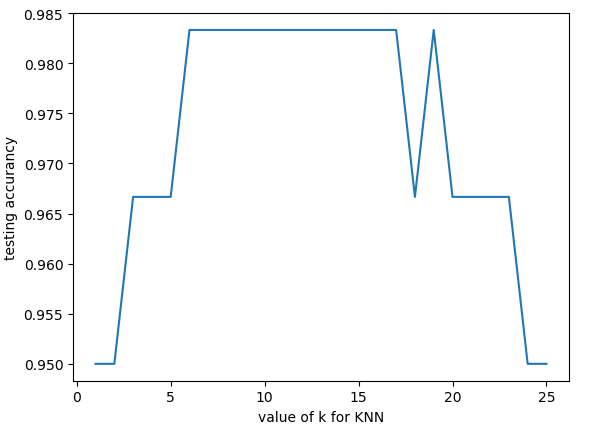

import matplotlib.pyplot as plt

# print(k_range)

scores=[]

for k in k_range:

knn=KNeighborsClassifier(n_neighbors=k)

knn.fit(x_train,y_train)

y_knnk_pred=knn.predict(x_test)

scores.append(metrics.accuracy_score(y_test,y_knnk_pred))

plt.plot(k_range,scores)

plt.xlabel('value of k for KNN')

plt.ylabel('testing accurancy')

plt.show()

输出结果:

从上可以观察出k的取值对准确度的影响,k太小或太大都不是最佳值。

3. 预测

取k=11(7~16)。

# 6.predict

knn=KNeighborsClassifier(n_neighbors=11)

knn.fit(x_train,y_train)

y_pred=knn.predict([[3,5,4,2]])

print(y_pred)

输出结果:

4. 附注:

KNN算法:https://www.jianshu.com/p/48d391dab189

scikit-learn中机器学习模型比较(逻辑回归与KNN)的更多相关文章

- (原创)(三)机器学习笔记之Scikit Learn的线性回归模型初探

一.Scikit Learn中使用estimator三部曲 1. 构造estimator 2. 训练模型:fit 3. 利用模型进行预测:predict 二.模型评价 模型训练好后,度量模型拟合效果的 ...

- 机器学习总结之逻辑回归Logistic Regression

机器学习总结之逻辑回归Logistic Regression 逻辑回归logistic regression,虽然名字是回归,但是实际上它是处理分类问题的算法.简单的说回归问题和分类问题如下: 回归问 ...

- 机器学习入门11 - 逻辑回归 (Logistic Regression)

原文链接:https://developers.google.com/machine-learning/crash-course/logistic-regression/ 逻辑回归会生成一个介于 0 ...

- 【机器学习基础】逻辑回归——LogisticRegression

LR算法作为一种比较经典的分类算法,在实际应用和面试中经常受到青睐,虽然在理论方面不是特别复杂,但LR所牵涉的知识点还是比较多的,同时与概率生成模型.神经网络都有着一定的联系,本节就针对这一算法及其所 ...

- PRML读书会第四章 Linear Models for Classification(贝叶斯marginalization、Fisher线性判别、感知机、概率生成和判别模型、逻辑回归)

主讲人 planktonli planktonli(1027753147) 19:52:28 现在我们就开始讲第四章,第四章的内容是关于 线性分类模型,主要内容有四点:1) Fisher准则的分类,以 ...

- Stanford机器学习---第三讲. 逻辑回归和过拟合问题的解决 logistic Regression & Regularization

原文:http://blog.csdn.net/abcjennifer/article/details/7716281 本栏目(Machine learning)包括单参数的线性回归.多参数的线性回归 ...

- Spark机器学习(2):逻辑回归算法

逻辑回归本质上也是一种线性回归,和普通线性回归不同的是,普通线性回归特征到结果输出的是连续值,而逻辑回归增加了一个函数g(z),能够把连续值映射到0或者1. MLLib的逻辑回归类有两个:Logist ...

- 使用SKlearn(Sci-Kit Learn)进行SVR模型学习

今天了解到sklearn这个库,简直太酷炫,一行代码完成机器学习. 贴一个自动生成数据,SVR进行数据拟合的代码,附带网格搜索(GridSearch, 帮助你选择合适的参数)以及模型保存.读取以及结果 ...

- 【Todo】用python进行机器学习数据模拟及逻辑回归实验

参考了这个网页:http://blog.csdn.net/han_xiaoyang/article/details/49123419 数据用了 https://pan.baidu.com/s/1pKx ...

随机推荐

- Java 多线程加锁的方式总结及对比(转载)

转自https://blog.csdn.net/u010842515/article/details/67634813 参考博文:http://www.cnblogs.com/handsomeye/p ...

- JQ倒计时,正计时

<p class="lastP">距离二维码过期还剩<strong></strong>秒,过期后自动刷新页面.</p><scr ...

- java关键字保留字

Here is a list of keywords in the Java programming language. You cannot use any of the following as ...

- BUGKU Misc 普通的二维码

下载的文件是一个bmp文件,在我的印象中bmp好像没有什么隐写技巧,有些慌张. 既然是二维码,那不妨先扫一下试一试 哈哈!就不告诉你flag在这里! 嗯,意料之中 1首先我把它放到了stegosolv ...

- [LOJ3087][GXOI/GZOI2019]旅行者——堆优化dijkstra

题目链接: [GXOI/GZOI2019]旅行者 我们考虑每条边的贡献,对每个点求出能到达它的最近的感兴趣的城市(设为$f[i]$,最短距离设为$a[i]$)和它能到达的离它最近的感兴趣的城市(设为$ ...

- 怎么用MATLAB产生FPGA所需的hamming窗系数

需求 在FPGA处理中如果需要对待处理数据加窗,则需要窗系数存储在ROM中以供使用. 前言 MATLAB窗函数说明 流程 比如加个hamming窗,8192点,16bit放大,最终系数18bit位宽. ...

- bzoj1814 Ural 1519 Formula 1(插头DP)

对插头DP的理解还不是很透彻. 先说一下肤浅的理解吧. 插头DP使用范围:指数级复杂度,且适用于解决网格图连通性问题,如哈密顿回路等问题.插头一般指每相邻2个网格的接口. 题目难度:一般不可做. 使用 ...

- Django框架基础之Form组件

服务端假设所有用户提交的数据都是不可信任的,所以Django框架内置了form组件来验证用户提交的信息 form组件的2大功能: 1 验证(显示错误信息) 2 保留用户上次输入 ...

- npm install 时出现的 EACCES: permission denied 错误的可能有效的解决方案

最近我开始接触手机 app 的编写,公司用到了 Nativescript.当我下载了公司的项目后,在配置时出现了不少的问题,其中出现概率最高的就是 EACCES: permission denied ...

- [源码分析]StringBuilder

[源码分析]StringBuilder StringBuilder是继承自AbstractStringBuilder的. 这里附上另外两篇文章的连接: AbstractStringBuilder : ...